실세계 의사결정을 위한 새로운 언어, 비디오

이 논문은 비디오 생성이 디지털 세계의 언어 모델처럼 물리적 세계에서 중요한 역할을 할 수 있다고 주장합니다. 비디오는 인터넷 규모의 지식을 흡수하고 다양한 실제 과업을 표현하는 통일된 인터페이스(unified interface)로 기능할 수 있습니다. 논문은 비디오 생성 모델이 in-context learning, planning, reinforcement learning과 같은 기술을 통해 로보틱스, 자율 주행, 과학과 같은 분야에서 planner, agent, 그리고 환경 simulator로 활용될 수 있는 가능성을 제시합니다. 이를 통해 비디오는 물리 세계에서의 복잡한 의사결정을 위한 새로운 언어가 될 수 있습니다. 논문 제목: Video as the New Language for Real-World Decision Making

Yang, Sherry, et al. "Video as the new language for real-world decision making." arXiv preprint arXiv:2402.17139 (2024).

Video as the New Language for Real-World Decision Making

Sherry Yang Jacob Walker Jack Parker-Holder Yilun Du Jake Bruce Andre Barreto Pieter Abbeel Dale Schuurmans

Abstract

텍스트 데이터와 비디오 데이터는 모두 인터넷에 풍부하며, **다음 토큰 또는 프레임 예측(next token or frame prediction)**을 통해 대규모 self-supervised learning을 지원한다. 그러나 이들은 동등하게 활용되지 못했다: 언어 모델은 실제 세계에 상당한 영향을 미쳤지만, 비디오 생성은 주로 미디어 엔터테인먼트에 국한되어 왔다. 하지만 비디오 데이터는 언어로 표현하기 어려운 물리적 세계에 대한 중요한 정보를 담고 있다.

이러한 격차를 해소하기 위해, 우리는 비디오 생성을 실제 세계의 task 해결로 확장할 수 있는, 저평가된 기회에 대해 논의한다. 우리는 언어와 유사하게 비디오가 인터넷 지식을 흡수하고 다양한 task를 표현할 수 있는 통합 인터페이스 역할을 할 수 있음을 관찰한다. 더욱이, 우리는 언어 모델과 마찬가지로 비디오 생성이 in-context learning, planning, reinforcement learning과 같은 기술을 통해 planner, agent, compute engine, 그리고 환경 시뮬레이터 역할을 할 수 있음을 보여준다.

우리는 로봇 공학, 자율 주행, 과학과 같은 분야에서 주요 영향 기회를 식별하며, 이는 비디오 생성의 이러한 고급 기능이 실현 가능성이 있음을 보여주는 최근 연구들에 의해 뒷받침된다. 마지막으로, 우리는 비디오 생성의 발전을 저해하는 주요 과제들을 식별한다. 이러한 과제들을 해결하면 비디오 생성 모델이 더 넓은 범위의 AI 애플리케이션에서 언어 모델과 함께 독특한 가치를 입증할 수 있을 것이다.

1 Introduction

지난 몇 년간 인터넷 텍스트 데이터셋을 활용한 대규모 언어 모델(LLM) 학습에서 엄청난 발전이 있었다 (Team et al., 2023; Achiam et al., 2023). LLM이 다양한 task에서 보여주는 인상적인 성능은 인공지능 의제를 이러한 시스템의 스케일업으로 축소시키고 싶은 유혹을 느끼게 한다. 그러나 이것만으로는 충분하지 않다. 첫째, 공개적으로 사용 가능한 텍스트 데이터의 양이

더 이상의 스케일링에 병목 현상을 일으키고 있다 (Villalobos et al., 2022). 둘째, 그리고 아마도 더 중요한 것은, 자연어만으로는 모든 지능적인 행동을 설명하거나 (Searle, 1980; Dennett, 1993; Minsky, 1988) 우리가 살고 있는 물리적 세계에 대한 모든 정보를 포착하기에 충분하지 않을 수 있다 (예: 말로만 매듭 묶는 법을 가르치는 것을 상상해 보라). 언어는 고수준의 추상화를 설명하는 강력한 도구이지만, 물리적 세계의 모든 세부적인 풍부함을 포착하기에는 항상 충분하지 않다.

다행히도 인터넷에는 풍부한 비디오 데이터가 존재하며 (예: YouTube만 해도 1만 년 이상의 연속 시청 비디오), 이는 세상에 대한 지식으로 가득 찬 풍부한 정보를 담고 있다. 그럼에도 불구하고, 오늘날 인터넷 텍스트 또는 비디오 데이터로 학습된 머신러닝 모델들은 현저히 다른 능력을 보여주었다. LLM은 정교한 추론 (Huang & Chang, 2022), 도구 사용 (Mialon et al., 2023), 의사 결정 (Yang et al., 2023c)을 요구하는 복잡한 task를 해결하는 수준으로 발전했다. 대조적으로, 비디오 생성 모델은 주로 인간 소비를 위한 엔터테인먼트 비디오 제작에 초점을 맞추어 덜 탐구되었다 (Ho et al., 2022a; Singer et al., 2022; Bar-Tal et al., 2024). 언어 모델링에서 일어나고 있는 패러다임 전환을 고려할 때, 로봇 공학, 자율 주행, 과학과 같은 시각 양식을 요구하는 응용 분야가 인터넷 시각 지식과 사전학습된 비디오 모델로부터 더 직접적인 혜택을 받을 수 있도록, 비디오 생성 모델을 언어 모델과 유사한 자율 에이전트, 시뮬레이션 환경, 계산 엔진 수준으로 끌어올릴 수 있는지 묻는 것이 중요하다.

본 논문에서 우리는 비디오 생성이 물리적 세계에 대해 언어 모델링이 디지털 세계에 대해 가지는 것과 같은 위상을 가질 것이라는 입장을 취한다. 이러한 입장에 도달하기 위해, 우리는 먼저 언어 모델이 많은 실제 task를 해결할 수 있도록 한 핵심 구성 요소를 식별한다: (1) 인터넷의 광범위한 정보를 흡수할 수 있는 통합된 표현 (즉, 텍스트), (2) 다양한 task를 생성 모델링으로 표현할 수 있는 통합된 인터페이스 (즉, 텍스트 생성), (3) 인간 피드백으로부터의 강화 학습 (Ouyang et al., 2022), 계획 (Huang et al., 2022), 탐색 (Yao et al., 2023), 최적화 (Rafailov et al., 2023)와 같은 기술을 통해 외부 피드백을 기반으로 행동을 취하고 의사 결정을 최적화함으로써 외부 환경 (예: 인간, 도구 및 기타 모델)과 상호 작용하는 언어 모델의 능력.

언어 모델의 이러한 세 가지 측면에 동기를 부여받아, 우리는 다음과 같이 관찰한다: (1) 비디오는 물리적 세계에 대한 광범위한 정보를 흡수하는 통합된 표현으로 기능할 수 있으며, (2) 컴퓨터 비전, embodied AI, 과학 분야의 다양한 task는 비디오 생성 모델에 의해 표현되거나 지원될 수 있고, (3) 사전학습 목표로서의 비디오 생성은 대규모 비전 모델, 행동 모델, 세계 모델에 인터넷 규모의 supervision을 도입하며, 이는 결과적으로 행동을 추출하고, 환경 상호 작용을 시뮬레이션하며, 의사 결정을 최적화할 수 있게 한다.

비디오 생성이 실제 응용 분야에 얼마나 큰 영향을 미칠 수 있는지 더 자세히 설명하기 위해, 우리는 비디오 생성을 task 해결사, 질문에 대한 답변, 정책/에이전트, 환경 시뮬레이터로 활용하는 최근 연구에 대한 심층 분석을 제공한다. 이는 **instruction tuning, in-context learning, 계획, 강화 학습 (RL)**과 같은 기술을 통해 게임, 로봇 공학, 자율 주행, 과학과 같은 환경에서 이루어진다. 마지막으로, 우리는 비디오 생성과 관련된 주요 어려움을 식별하고, 실제 세계에서 비디오 생성의 잠재력을 최대한 발휘하기 위해 이러한 과제를 해결할 수 있는 그럴듯한 해결책을 제안한다.

2 Preliminaries

우리는 비디오 생성 모델과 조건부 생성(conditional generation)을 통해 도메인별 설정에서 어떻게 사용되었는지에 대한 간략한 개요를 제공한다.

2.1 Conditional Video Generation

비디오 클립은 이미지 프레임 시퀀스 로 표기한다. 이미지는 단일 프레임 을 가진 특수한 비디오로 간주될 수 있다. Conditional video generation은 조건 변수 가 주어졌을 때의 조건부 확률 를 모델링한다. 조건부 확률 는 일반적으로 autoregressive model (Razavi et al., 2019), diffusion model (Ho et al., 2022a), 또는 masked Transformer model (Chang et al., 2022)에 의해 factorize되어 왔다. 이러한 factorization 방식에 따라, 로부터 샘플링하는 것은 이미지를 (패치 단위로) 순차적으로 예측하거나, 모든 프레임 을 함께 반복적으로 예측하는 것에 해당한다.

2.2 Task-Specific Specialization

컨디셔닝 변수 에 무엇이 포함되느냐에 따라, 조건부 비디오 생성은 다양한 목적에 활용될 수 있다. 아래에서는 의 일반적인 예시와 그 활용 사례를 열거한다.

- text . 이는 생성형 미디어에 흔히 사용되는 text-to-video 모델에 해당한다 (Kondratyuk et al., 2023; Blattmann et al., 2023b). 여기서 텍스트는 종종 원하는 비디오에 대한 창의적인 설명이다 (예: Singer et al. (2022)의 "A teddy bear painting a portrait"). Text-to-video는 주로 영화 생성 (Zhu et al., 2023) 및 애니메이션 생성 (He et al., 2023; Guo et al., 2023)에 적용되어 왔다.

- , text . 이는 주어진 이미지 에서 시작하여 텍스트 설명을 통합한 비디오 롤아웃을 생성하는 것에 해당한다. 이러한 유형의 컨디셔닝은 장면별 시각적 상호작용 생성 (Yang et al., 2023b) 및 로봇 실행을 위한 시각적 계획 생성 (Du et al., 2023b)에 적용되었다. 가 미래 이미지 만을 포함할 때, , text 는 로봇 조작을 위한 시각적 목표를 예측할 수 있다 (Black et al., 2023; Yu et al., 2023). 이러한 목표 합성 접근 방식은 스타일화된 이미지 생성 및 인페인팅에 대한 방대한 문헌 (Efros & Freeman, 2023; Wang et al., 2023a)에서 크게 영감을 받았다.

- , text . 와 가 동일한 기본 콘텐츠를 가질 때, 이는 텍스트 기반 비디오 편집 및 스타일화 (Loeschcke et al., 2022; Yang et al., 2023a)에 해당하며, 다양한 기상 조건에서 자율주행 비디오를 생성하는 데 적용되었다 (Hu et al., 2023). 는 와 완전히 다를 수도 있으며, 이 경우 는 출력 비디오에서 특정 패턴을 유도하는 시각적 prompt 역할을 할 수 있다 (Bai et al., 2023).

- , action . 이는 시각적 역학 모델(visual dynamics model)을 학습하는 것에 해당하며, 여기서 action은 로봇 제어 (Yang et al., 2023b), 키보드 입력 (Hafner et al., 2020), 또는 시각 공간의 변화를 유발하는 기타 모션 정보 (Li et al., 2023)일 수 있다. 만약 을 인 로 대체하면, 시간적으로 추상화된 역학 모델(temporally-abstract dynamics model) (Sutton et al., 1999)을 얻게 된다. 이 경우 를 의 어떤 하위 시퀀스로 대체할 수도 있다.

이러한 조건부 비디오 생성의 특수화는 광범위한 비디오 데이터를 흡수하고 비디오 생성을 사용하여 다양한 task를 표현할 수 있는 일반적인 프레임워크가 존재할 수 있음을 시사한다.

3 Unified Representation and Task Interface

이 섹션에서는 먼저 비디오가 인터넷의 다양한 정보를 포착하여 광범위한 지식을 형성할 수 있는 통합된 표현 방식임을 설명한다. 이어서 컴퓨터 비전 및 embodied AI의 다양한 task들이 조건부 비디오 생성 문제로 어떻게 공식화될 수 있는지 논의하며, 이는 비디오 생성을 통한 실제 의사 결정의 기반을 제공한다. 예시 생성에 사용된 모델에 대한 자세한 내용은 Appendix A에서 확인할 수 있다. 추가 생성 비디오는 Appendix B에서 확인할 수 있다.

3.1 Video as a Unified Representation of Information

인터넷 텍스트 데이터는 대규모 언어 모델을 통해 디지털/지적 세계에 많은 가치를 제공했지만, 텍스트는 물리적 세계의 저수준(low-level) 세부 사항보다는 고수준(high-level) 추상화를 포착하는 데 더 적합하다. 아래에서는 텍스트로 표현하기 어렵지만 비디오로 쉽게 포착할 수 있는 몇 가지 정보 유형을 나열한다.

- 시각 및 공간 정보 (Visual and Spatial Information): 여기에는 색상, 모양, 질감, 조명 효과와 같은 시각적 세부 사항과, 객체가 공간에 어떻게 배열되어 있는지, 상대적 위치, 거리, 방향, 3D 정보와 같은 공간적 세부 사항이 포함된다. 이러한 정보는 텍스트 형식보다는 이미지/비디오 형식으로 자연스럽게 존재한다.

- 물리 및 역학 (Physics and Dynamics): 여기에는 충돌, 조작, 물리 법칙의 영향을 받는 기타 움직임과 같이 객체와 환경이 물리적으로 상호작용하는 방식에 대한 세부 정보가 포함된다. 텍스트는 움직임을 고수준으로 설명할 수 있지만(예: "자동차가 길을 따라 운전하고 있다"), 차량에 가해지는 토크나 마찰과 같은 저수준 세부 사항을 포착하기에는 종종 불충분하다. 비디오는 이러한 정보를 암묵적으로 포착할 수 있다.

- 행동 및 동작 정보 (Behavior and Action Information): 여기에는 인간의 행동 및 에이전트의 동작과 같은 정보가 포함되며, 가구를 조립하는 방법과 같은 task를 수행하는 저수준 세부 사항을 특징짓는다. 텍스트는 다시 말해, 정확한 움직임이나 동작과 같은 상세 정보보다는 task 수행 방법에 대한 고수준 설명을 주로 포착할 수 있다.

왜 비디오인가?

텍스트가 위 정보를 포착하기에 불충분하다 하더라도, 왜 굳이 비디오여야 하는지 의문을 가질 수 있다. 이 질문에 답하기 위해 우리는 비디오가 인터넷 규모로 존재할 뿐만 아니라, 인간에게 해석 가능하여(텍스트와 유사하게) 디버깅, 상호작용, 안전성 추측 등을 쉽게 수행할 수 있다는 점에 주목한다. 더욱이 비디오는 다양한 공간적 및 시간적 해상도로 정보를 특징지을 수 있는 유연한 표현 방식이다. 예를 들어, 옹스트롬(angstrom) 스케일()로 움직이는 원자(Kashin et al., 2021)나 초당 1조 프레임으로 이동하는 빛(Faccio & Velten, 2018)과 같은 정보를 담을 수 있다.

3.2 Video Generation as a Unified Task Interface

광범위한 정보를 흡수할 수 있는 통합된 표현(unified representation) 외에도, 우리는 언어 모델링에서 단일 objective(예: 다음 토큰 예측)를 사용하여 다양한 task를 표현할 수 있는 통합된 task interface가 필요하다는 것을 확인했다. 또한, **정보 표현(예: 텍스트)과 task interface(예: 텍스트 생성) 간의 정렬(alignment)**이 광범위한 지식을 task-specific 결정으로 이전하는 것을 가능하게 한다. 이 섹션에서는 다양한 vision task뿐만 아니라 더 넓은 범위의 질문 응답, 추론, 문제 해결 task들이 모두 비디오 생성 task로 어떻게 표현될 수 있는지를 보여준다.

고전적인 컴퓨터 비전 Task (Classical Computer Vision Tasks)

자연어 처리 분야에서는 기계 번역, 텍스트 요약, 질문 응답, 감성 분석, 개체명 인식, 품사 태깅, 텍스트 분류, 대화 시스템 등 많은 task들이 전통적으로 서로 다른 task로 간주되었지만, 이제는 모두 언어 모델링이라는 큰 틀 아래 통합되었다. 이는 task 전반에 걸쳐 더 큰 일반화와 지식 공유를 가능하게 했다.

마찬가지로, 컴퓨터 비전 분야 또한 semantic segmentation, depth estimation, surface normal estimation, pose estimation, edge detection, object tracking 등 광범위한 task들을 포함한다. 최근 연구들은 Figure 1 (Bai et al., 2023; Bar et al., 2022; Wang et al., 2023b)에서 보여주듯이, 다양한 vision task를 비디오 생성 task로 변환하는 것이 가능하며, 이러한 vision task 해결을 위한 통합된 접근 방식이 모델 크기, 데이터 크기, context 길이와 함께 유리하게 확장된다는 것을 보여주었다 (Bai et al., 2023).

Figure 1: Vision Tasks as Video Generation. Bai et al. (2023)의 Figure 8 (부분적인 prompt를 보여주기 위해 단순화됨)은 joint/edge detection, depth estimation, segmentation과 같은 다양한 컴퓨터 비전 task가 단일 next-frame prediction task로 변환될 수 있음을 보여준다.

Figure 1: Vision Tasks as Video Generation. Bai et al. (2023)의 Figure 8 (부분적인 prompt를 보여주기 위해 단순화됨)은 joint/edge detection, depth estimation, segmentation과 같은 다양한 컴퓨터 비전 task가 단일 next-frame prediction task로 변환될 수 있음을 보여준다.

vision task를 비디오 생성 task로 변환하는 과정은 일반적으로 다음 단계를 포함한다: (1) task의 입력과 출력(예: segmentation map, depth map)을 통합된 이미지/비디오 공간으로 구조화한다. (2) 이미지 프레임을 재정렬하여 입력 이미지 뒤에 특정 task의 예상 출력 이미지가 오도록 한다 (예: 일반 입력 이미지 뒤에 depth map). (3) 조건부 비디오 생성 모델에 예시 입력-출력 쌍을 제공하여 원하는 task를 지정하는 in-context learning을 활용한다.

답변으로서의 비디오 (Video as Answers)

전통적인 Visual Question Answering (VQA) [Antol et al., 2015]에서는 예상되는 답변이 텍스트 형태이다. 비디오 생성 기술의 발전과 함께, 비디오를 답변으로 취급하는 새로운 task가 등장할 수 있다. 예를 들어, "종이비행기를 만드는 방법"이라는 질문에 대한 응답으로 비디오가 생성되는 것이다 [Souček et al., 2023; Yang et al., 2023b]. 언어 모델이 인간의 텍스트 질문에 맞춤형 응답을 생성할 수 있는 것과 유사하게, 비디오 모델 또한 how-to 질문에 대해 매우 상세한 저수준(low-level) 정보를 담은 맞춤형 답변을 생성할 수 있다. 이러한 비디오 응답은 텍스트 응답보다 인간에게 더 선호될 수 있다 [Yadav et al., 2011]. Figure 2에서는 how-to 질문에 대한 텍스트-투-비디오 모델이 생성한 비디오를 보여준다. 또한, 사용자는 초기 프레임을 조건으로 하여 사용자 특정 장면에서 비디오 답변을 합성하는 것도 고려할 수 있다. 이러한 큰 가능성에도 불구하고, 오늘날의 텍스트-투-비디오 모델이 합성하는 비디오는 일반적으로 너무 짧거나 단순하여 사용자의 질문에 완전히 답할 만큼 충분한 정보를 포함하지 못한다.

Figure 2: Generated How-to Videos. 비디오 생성 모델은 인간의 손이 복잡한 task를 수행하는 데 해당하는 주요 프레임을 합성할 수 있다. 그러나 생성된 프레임은 너무 일반적이며 사용자의 질문에 완전히 답할 만큼 충분한 세부 정보를 담고 있지 않다.

Figure 2: Generated How-to Videos. 비디오 생성 모델은 인간의 손이 복잡한 task를 수행하는 데 해당하는 주요 프레임을 합성할 수 있다. 그러나 생성된 프레임은 너무 일반적이며 사용자의 질문에 완전히 답할 만큼 충분한 세부 정보를 담고 있지 않다.

사용자의 질문에 답하기 위해 비디오 프레임을 합성하는 문제는 언어 모델을 이용한 계획(planning) 문제 [Valmeekam et al., 2023]와 유사하지만, 상태(state)와 저수준(low-level) 액션 공간이 이제 텍스트가 아닌 픽셀이라는 차이가 있다. 언어 모델 또는 vision language model을 활용하여 고수준 목표(예: "스시 만드는 방법")를 특정 하위 목표(예: "먼저 밥을 김발 위에 놓는다")로 분해하고, 각 하위 목표에 대한 계획을 합성하며 합성된 계획의 타당성을 검증할 수 있다 [Du et al., 2023c].

시각적 추론과 Chain-of-Thought (Visual Reasoning and Chain-of-Thought)

정보의 통합된 표현과 통합된 task interface를 통해, 언어 모델링에서는 모델이 더 복잡한 문제를 해결하기 위한 중간 단계로 관련 정보를 이끌어내는 추론 능력이 나타났다 [Wei et al., 2022]. 유사하게, 비디오를 통합된 표현 및 task interface로 사용함으로써, 비디오 생성 또한 Figure 3 [Bai et al., 2023]에서 보여주듯이 이미지의 마스킹된 영역을 예측함으로써 시각적 추론의 초기 징후를 보였다. Trinh et al. [2024]와 유사하게 올바른 보조선(auxiliary lines)을 포함하는 비디오를 생성함으로써 next-frame prediction이 더 복잡한 기하학 문제를 해결하는 데 사용될 수 있는지를 확인하는 것은 흥미로울 것이다.

시각적 추론 및 기하학 문제 해결을 위해 next-frame prediction을 활용하는 아이디어를 바탕으로, 우리는 추론 과정 [Himakunthala et al., 2023]과 알고리즘 [Yang et al., 2022b]을 더욱 특징화할 수 있다.

Figure 3: Visual Reasoning as Next-Frame Generation. Bai et al. (2023)의 Figure 13은 next-frame prediction이 IQ 테스트와 같은 시각적 추론 task를 해결할 수 있음을 보여준다.

Figure 3: Visual Reasoning as Next-Frame Generation. Bai et al. (2023)의 Figure 13은 next-frame prediction이 IQ 테스트와 같은 시각적 추론 task를 해결할 수 있음을 보여준다.

五平 -アプ(দন্ট

五平 -アプ(দন্ট

Figure 4: BFS as Video Generation. Yang et al. (2022b)의 Figure 14는 BFS(Breadth First Search) 탐색 절차를 모방하여 비디오 모델이 생성한 두 세트의 중간 프레임을 보여준다. 빨간색과 녹색 셀은 각각 시작(start) 및 목표(goal) 위치를 나타낸다. 흰색과 검은색 셀은 빈 공간과 장애물을 나타낸다. 파란색 셀은 BFS 알고리즘을 실행했을 때 방문했을 셀을 나타낸다.

비디오를 생성하는 task를 통해 알고리즘적 추론(algorithmic reasoning) 능력을 학습할 수 있다. 구체적으로, Yang et al. (2022b)는 BFS(Breadth First Search) 알고리즘의 실행 상태를 비디오를 사용하여 특성화하였다. 이러한 맥락에서, 비디오를 생성하는 것을 학습하는 것은 탐색(search)하는 것을 학습하는 것과 동일하며, 이는 Figure 4에 잘 나타나 있다 (Silver et al. (2017)도 참조). Figure 3과 Figure 4의 예시들이 다소 인위적으로 보일 수 있지만, 이들은 비디오 생성을 사전학습(pretraining) task로 활용하는 것이 언어 모델과 유사한 추론(reasoning)과 같은 행동을 유도할 수 있다는 초기 지표가 된다. 이는 비디오 생성을 활용하여 복잡한 추론 및 알고리즘 task를 해결할 수 있는 가능성을 보여준다.

3.3 Video as a Unified State-Action Space

우리는 비디오 생성(video generation)이 광범위한 지식을 흡수하고 다양한 vision task를 특징화할 수 있음을 확인했다. 이 섹션에서는 embodied AI 분야에서 비디오를 통합된 표현(unified representation) 및 task 인터페이스로 활용하는 구체적인 예시를 제공함으로써 이러한 관찰을 더욱 뒷받침한다.

Embodied AI의 오랜 과제 중 하나는 **데이터 파편화(data fragmentation)**였다. 이는 한 로봇이 특정 task 세트를 수행하여 수집한 데이터가 다른 로봇이나 다른 task 세트 학습에는 거의 유용하지 않다는 문제를 의미한다 (Padalkar et al., 2023). 로봇과 task 간의 지식 공유에 있어 주요 어려움은 각 로봇 유형과 task가 고유한 state-action space를 가진다는 점에 있다. 이러한 어려움을 해결하기 위해 Du et al. (2023b)은 픽셀 공간(pixel space)을 task 및 환경 전반에 걸쳐 통합된 state-action space로 사용할 것을 제안한다. 이 프레임워크 하에서 embodied planning은 조건부 비디오 생성(conditional video generation) 문제로 간주될 수 있으며, 이를 통해 인터넷에서 사전학습된 비디오 생성 모델의 이점을 얻을 수 있다. 이후 inverse dynamics model (Du et al., 2023b), goal-conditioned policy (Black et al., 2023; Kang et al., 2023; Du et al., 2023c), optical flow network (Ko et al., 2023), 또는 dense grid point (Wen et al., 2023)와 같은 추가 모듈을 사용하여 고수준 비디오 계획(high-level video plans)으로부터 저수준 로봇 제어(low-level robot controls)를 복구할 수 있다. 우리는 Figure 5 (상단)에서 이전 연구들이 생성한 비디오 계획을 보여준다. 대부분의 기존 연구는 로봇당 하나의 비디오 생성 모델을 학습시키는데, 이는 비디오를 embodied learning을 위한 통합된 state-action space로 사용하는 잠재적 이점을 감소시킨다. 우리는 Figure 5 (하단)에서 다양한 로봇과 task를 포함하는 Open X-Embodiment 데이터셋 (Padalkar et al., 2023)으로 단일 비디오 생성 모델을 학습시켜 생성된 추가 비디오 계획을 제공한다. 이전 및 새로 생성된 비디오 계획 모두 매우 사실적으로 보이며 지정된 task를 성공적으로 완료한다.

Figure 5: 로봇을 위한 생성된 비디오 계획. [상단] 기존 연구에서 생성된 비디오 계획 (Du et al. (2023b)의 Figure 3, Black et al. (2023)의 Figure 3, Du et al. (2023c)의 Figure 3, Ko et al. (2023)의 Figure 5, Yang et al. (2023b)의 Figure 14, Kang et al. (2023)의 Figure 7). [하단] Open X-Embodiment (Padalkar et al., 2023) 데이터셋으로 학습된 단일 비디오 생성 모델에 의해 생성된 비디오 계획.

Figure 5: 로봇을 위한 생성된 비디오 계획. [상단] 기존 연구에서 생성된 비디오 계획 (Du et al. (2023b)의 Figure 3, Black et al. (2023)의 Figure 3, Du et al. (2023c)의 Figure 3, Ko et al. (2023)의 Figure 5, Yang et al. (2023b)의 Figure 14, Kang et al. (2023)의 Figure 7). [하단] Open X-Embodiment (Padalkar et al., 2023) 데이터셋으로 학습된 단일 비디오 생성 모델에 의해 생성된 비디오 계획.

4 Video Generation as Simulation

비디오 생성 자체만으로도 이전 섹션에서 설명한 많은 task를 해결할 수 있지만, 비디오 생성의 또 다른 중요한 기회는 다양한 시스템 및 프로세스의 시각적 관찰을 시뮬레이션하여, 시스템에 대한 제어 입력(control input)을 시뮬레이션 결과에 따라 최적화하는 것이다. 이는 **풍부한 비디오 데이터를 수집할 수 있지만, 근본적인 동역학(underlying dynamics)을 명시적으로 표현하기 어려운 애플리케이션(예: 구름 움직임, 부드러운 물체와의 상호작용)**에 특히 유용하다.

이 섹션에서는 먼저 게임 환경에서 이러한 시각적 생성 시뮬레이터(visual generative simulator)를 연구한다. 게임 환경에서는 학습된 시뮬레이터의 품질을 검증하고 새로운 경험의 효과적인 생성을 반복적으로 개선할 수 있는 ground truth 게임 엔진을 사용할 수 있다. 그런 다음 로봇 상호작용, 자율 주행, 원자 수준 상호작용과 같은 실제 프로세스를 시뮬레이션하는 예시를 제공한다. 예시를 생성하는 데 사용된 생성 모델에 대한 자세한 내용은 Appendix A에서 찾을 수 있다. 추가적인 생성 시뮬레이션 결과는 Appendix B에서 찾을 수 있다.

4.1 Generative Game Environments

게임은 수십 년 동안 AI 알고리즘의 테스트베드로 사용되어 왔다 (Yannakakis & Togelius, 2018). 예를 들어, Arcade Learning Environment (Bellemare et al., 2013)는 Atari 게임에서 인간 수준에 도달한 최초의 AI 에이전트인 deep Q-learning의 개발을 가능하게 했다 (Mnih et al., 2015). 이와 유사하게, 우리는 게임 엔진의 ground truth 시뮬레이션과 비교함으로써 생성형 시뮬레이터의 품질을 테스트하는 수단으로 게임을 고려할 수 있다.

Figure 6: Minecraft에서 생성된 게임 궤적. 행동(actions)과 관찰(observations) 모두 Minecraft 데이터로 학습된 autoregressive 모델을 사용하여 생성된다. 맨 위 행은 인벤토리가 열린 것을 보여준다. 중간 행은 곡괭이를 사용하여 돌 블록을 부수는 것을 보여준다. 맨 아래 행은 환경 전체의 움직임을 예측한다.

Figure 6: Minecraft에서 생성된 게임 궤적. 행동(actions)과 관찰(observations) 모두 Minecraft 데이터로 학습된 autoregressive 모델을 사용하여 생성된다. 맨 위 행은 인벤토리가 열린 것을 보여준다. 중간 행은 곡괭이를 사용하여 돌 블록을 부수는 것을 보여준다. 맨 아래 행은 환경 전체의 움직임을 예측한다.

미래에는 생성형 모델을 사용하여 기존의 인간이 설계한 시뮬레이션 환경에서 가능한 것을 뛰어넘을 수 있을 것이다. 이 섹션에서는 단일 복잡 환경 시뮬레이션부터 완전히 새로운 환경 생성에 이르는 이러한 가능성들을 논의한다.

복잡한 게임 시뮬레이션. Action-conditioned video generation은 Minecraft와 같은 복잡한 컴퓨터 게임의 환경 역학을 시뮬레이션할 수 있다. 개념 증명(proof of concept)으로, 우리는 에피소드 기록에 따라 미래 에이전트의 행동과 관찰을 예측하는 Transformer 기반의 autoregressive 아키텍처를 학습시켰다. 우리는 Baker et al. (2022)의 "contractor data"를 사용했는데, 이는 인간이 게임과 상호작용하는 동안 수집된 궤적으로 구성된다. **관찰과 행동 모두 양자화된 토큰(quantized tokens)**이며, 이는 모델 기반 rollout을 다음 토큰 예측으로 축소시킨다. 이 경우 모델은 world model과 policy의 역할을 모두 수행한다: 행동으로 끝나는 교차 관찰 및 행동 시퀀스가 주어지면 모델은 다음 관찰을 추론할 수 있고(world model), 관찰로 끝나는 유사한 시퀀스가 주어지면 모델은 취할 다음 행동을 추론할 수 있다(policy). Figure 6은 이 모델에서 생성된 몇 가지 궤적을 보여준다. 이 모델은 정교한 전략(예: 곡괭이를 사용하여 돌 블록을 부수는 것)에 해당하는 행동과 전환을 생성할 수 있다.

이러한 policy 및 dynamics backbone을 통해 Dyna (Sutton, 1991), Dreamer (Hafner et al., 2020), MuZero (Schrittwieser et al., 2019; Antonoglou et al., 2022)와 같은 모델 기반 강화 학습 알고리즘을 사용하여 policy를 개선할 수 있다. 이는 dynamics model로부터 광범위한 샘플링을 필요로 하며, 이는 다시 생성형 모델이 계산적으로 효율적이어야 함을 의미한다. 비디오 생성 모델은 매우 일반적이지만, 계획(planning)에 있어서 world model은 비디오 모델일 필요가 없으며, latent state space model이 종종 선호되어 왔다 (Ichter & Pavone, 2019; Hafner et al., 2020).

새로운 게임 환경 생성. 새로운 게임 콘텐츠와 레벨을 절차적으로 생성하는 것은 게임 AI 커뮤니티에서 활발한 연구 분야이며 (Summerville et al., 2018), RL 에이전트의 훈련 및 평가 모두에 유용함이 입증되었다 (Risi & Togelius, 2020; Justesen et al., 2018; Cobbe et al., 2020). 프레임을 직접 예측하거나 (Bamford & Lucas, 2020) 배경을 수정하여 새로운 게임 레벨을 생성함으로써 (Kim et al., 2020) 게임 디자인에 생성형 모델을 활용하려는 시도가 있었다. 그러나 이러한 연구들은 privileged simulation data에 의존하며, 소규모로만 시도되어 완전히 새로운 게임 환경을 생성할 잠재력을 제한했다.

최근 연구에서는 레이블이 없는 인터넷 규모의 게임 플레이 데이터를 활용하여 latent action을 학습하고, 이어서 action-controllable video model을 훈련하는 것이 가능함을 보여주었다 (Bruce et al., 2024). 이를 통해 프롬프트 이미지로부터 무한한 가능성의 다양한 대화형 환경을 생성할 수 있다. Figure 7은 두 개의 새로운 시작 프레임이 주어졌을 때 인간 플레이어가 latent action을 선택하여 제어하는 생성된 게임 궤적을 보여준다. 이 연구는 아직 탐색 단계에 있지만, 학습된 reward model (Chan et al., 2023; Du et al., 2023a; Escontrela et al., 2023)을 통합하여 완전히 생성형 게임 환경에서 RL 에이전트를 훈련하는 미래를 상상할 수 있다.

4.2 Robotics and Self-Driving.

SE(3) Action Space 시뮬레이션

로봇 학습에서 오랫동안 해결되지 않은 과제 중 하나는 sim-to-real transfer이다 (Rusu et al., 2017). 이는 시뮬레이터에서 학습된 policy가 실제 로봇에서 실행될 때 제대로 전이되지 않는 현상을 말한다. Yang et al. (2023b)은 Language Table 환경 (Lynch et al., 2023)에서 간단한 Cartesian action space를 가진 실제 로봇 비디오 데이터를 사용하여 action-conditioned next-frame prediction model을 학습하는 것이 가능함을 입증했다. Figure 8에서는 next-frame prediction이 SE(3) 공간에서 더 일반적인 end-effector action의 시각적 효과를 예측할 수 있음을 보여준다 (Blanco-Claraco, 2021).

Figure 7: 생성된 인터랙티브 게임 환경: (Bruce et al., 2024)에서 모델에 전달된 두 개의 합성 이미지 prompt가 인터랙티브 환경으로 변환된다. 여기에서 Player 1과 Player 2로 표시된 다양한 latent action을 취하여 다양한 궤적을 생성할 수 있다.

Figure 7: 생성된 인터랙티브 게임 환경: (Bruce et al., 2024)에서 모델에 전달된 두 개의 합성 이미지 prompt가 인터랙티브 환경으로 변환된다. 여기에서 Player 1과 Player 2로 표시된 다양한 latent action을 취하여 다양한 궤적을 생성할 수 있다.

Figure 8: SE(3) 로봇 Action의 생성적 시뮬레이션. 로봇 policy의 실제 실행 (상단), 동일한 policy의 시뮬레이션 실행 (중간), 동일한 action을 반복하는 시뮬레이션 실행 (하단). 시뮬레이션 롤아웃은 일반적으로 ground truth 롤아웃과 일치하지만, 병이 사라지는 경우 (하단 행)와 같이 hallucination이 발생할 수 있다.

Figure 8: SE(3) 로봇 Action의 생성적 시뮬레이션. 로봇 policy의 실제 실행 (상단), 동일한 policy의 시뮬레이션 실행 (중간), 동일한 action을 반복하는 시뮬레이션 실행 (하단). 시뮬레이션 롤아웃은 일반적으로 ground truth 롤아웃과 일치하지만, 병이 사라지는 경우 (하단 행)와 같이 hallucination이 발생할 수 있다.

generative SE(3) simulator의 즉각적인 활용 사례 중 하나는 로봇 policy를 평가하는 것이다. 이는 실제 로봇 평가와 관련된 안전 문제를 고려할 때 특히 유용하다. 평가 외에도 Yang et al. (2023b)은 Language Table 환경에서 generative simulator의 롤아웃을 사용하여 RL policy를 학습했다. 흥미로운 다음 단계는 Dyna-style algorithm (Sutton, 1991)을 사용하여 시뮬레이션 롤아웃과 실제 환경 모두에서 policy를 학습하는 것이다. 이 설정에서는 policy가 실행되는 동안 실제 비디오가 수집되어 generative simulator에 대한 추가적인 demonstration 및 feedback으로 사용될 것이다. 마지막으로, generative simulator는 다양한 환경에서의 비디오 롤아웃을 통해 multi-task 및 multi-environment policy의 효과적인 학습을 가능하게 한다. 이는 이전에는 불가능했는데, 일반적으로 policy는 한 번에 하나의 실제 환경에만 접근할 수 있었기 때문이다.

Domain Randomization.

generative simulator의 또 다른 이점은 로봇 공학, 내비게이션, 자율 주행에 광범위하게 적용 가능하며, 훈련 환경에 자연스러운 무작위성을 도입하여 시뮬레이션에서 훈련된 policy의 실제 세계 전이를 개선하는 능력이다. generative model이 없을 때는 domain randomization을 통해 렌더링 규칙을 하드코딩하여 이를 달성하는데 (Tobin et al., 2017), 이는 번거롭고 제한적인 환경 변화와 비현실적인 렌더링 효과를 초래한다. generative simulator를 사용하면, 최근 연구에서 다양한 운전 조건 (예: 맑음, 안개, 눈, 비, 야간)을 시뮬레이터에 도입할 수 있음이 밝혀졌다 (Hu et al., 2023). 또한, 인터넷 규모의 지식과 결합하여, Figure 9에 표시된 것처럼 금문교에서 비가 오는 상황에서의 운전 시뮬레이션과 같은 특정 위치에서의 운전 조건을 시뮬레이션할 수 있으며, 이는 다양한 위치와 날씨 조건에서 자율 주행 policy를 훈련하는 것을 가능하게 한다.

Figure 9: 자율 주행을 위한 생성적 시뮬레이션. 인터넷 지식을 활용하여 "금문교의 비" (상단), "요세미티의 새벽" (중간), "요세미티로 가는 길의 눈" (하단)과 같이 특정 위치에서 다양한 운전 조건을 시뮬레이션할 수 있다.

Figure 9: 자율 주행을 위한 생성적 시뮬레이션. 인터넷 지식을 활용하여 "금문교의 비" (상단), "요세미티의 새벽" (중간), "요세미티로 가는 길의 눈" (하단)과 같이 특정 위치에서 다양한 운전 조건을 시뮬레이션할 수 있다.

4.3 Science and Engineering

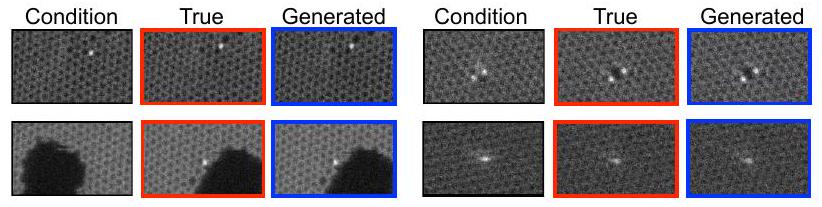

비디오는 의료 영상, 컴퓨터 이미지 처리, 전산 유체 역학(Steinman, 2002)과 같은 광범위한 과학 및 공학 분야에서 통합적인 표현 수단으로 활용될 수 있다. 시각 정보는 카메라로 쉽게 캡처할 수 있지만, 근본적인 동적 시스템을 식별하기 어려운 상황(예: 구름 움직임, 전자 현미경 아래 원자 움직임)에서 제어 입력(control input)에 조건화된 비디오 생성 모델은 효과적인 **시각 시뮬레이터(visual simulator)**가 될 수 있으며, 이는 다시 더 나은 제어 입력을 도출하는 데 사용될 수 있다. Figure 10에서는 Schwarzer et al. (2023)에서 수집된 STEM 데이터를 사용하여 **주사 투과 전자 현미경(STEM)의 전자빔에 의해 자극될 때 단일 탄소 원자층 위의 실리콘 원자의 전이 동역학(transition dynamics)**을 보여준다. 우리는 생성 시뮬레이터(generative simulator)가 픽셀 공간에서 실리콘 원자의 움직임을 특성화할 수 있음을 확인할 수 있다.

Figure 10: 원자 수준 다음 프레임 예측 (Atomic-Level Next-Frame Prediction). 전자 현미경의 전자빔에 의해 자극된 그래핀 시트 위의 실리콘 원자의 시각적 동역학을 반영하는 조건부 프레임, 실제 다음 프레임, 그리고 생성된 다음 프레임. 생성 모델은 높은 충실도로 시각적 동역학을 모델링할 수 있다.

제어 입력에 반응하여 고도로 사실적인 시각 시뮬레이터를 활용하는 것은 전자 현미경과 같은 특수 장비 작동을 요구하는 과학 연구 노력에서 제한된 하드웨어 접근성 문제를 완화할 수 있다. 그러나 제어 입력 최적화를 위해 시각 생성 시뮬레이터를 활용하는 것은 그 유효성과 효과성을 보장하기 위해 추가적인 연구가 필요하다.

과학적 프로세스 시뮬레이션에서 sim-to-real gap을 줄이는 것 외에도, 생성 시뮬레이터의 또 다른 이점은 고정된 계산 오버헤드를 가진다는 점이다. 이는 전통적인 계산 방법이 다루기 어려울 때 유용할 수 있다. 예를 들어, 열량계 샤워(calorimeter showers)를 시뮬레이션하려면 전자들 간의 쌍별 상호작용을 계산해야 하는데, 전자의 수가 많아지면 그 복잡성이 빠르게 비실용적이 된다(Mikuni & Nachman, 2022). 반면에 전자 샤워 비디오는 샤워가 모델링되는 해상도에 비례하여 고정된 계산 오버헤드를 가진다.

5 Challenges

비디오 생성은 큰 잠재력을 가지고 있지만, 그 적용에 있어 몇 가지 주요 과제가 여전히 남아 있다. 이 섹션에서는 이러한 과제와 잠재적인 해결책을 설명한다.

5.1 Dataset Limitations

제한된 커버리지 (Limited Coverage)

언어 모델링에서는 특정 다운스트림 task를 해결하기 위한 언어 데이터 분포가 일반적으로 인터넷 텍스트 데이터 분포 내에 존재한다. 그러나 비디오의 경우에는 그렇지 않다. 인터넷에 게시된 비디오는 인간의 흥미를 유발하는 방향으로 제작되는데, 이는 다운스트림 task에 유용한 비디오 데이터와는 반드시 일치하지 않는다. 예를 들어, 전산 유체 역학(computational fluid dynamics) 모델은 물과 같은 유체의 움직임에 초점을 맞춘 길고 많은 비디오를 필요로 할 것이다. 몇 시간 동안 지속되는 이러한 비디오는 인간에게는 그다지 흥미롭지 않으므로 인터넷에서 찾기 어렵다. 마찬가지로, 특정 유형의 로봇(예: Franka Emika Panda 로봇)이 특정 task(예: 옷 접기)를 수행하는 비디오를 인터넷에서 찾는 것은 드문 일이다. 이는 도메인별 비디오 데이터를 수집하고 배포하는 더 나은 방법이 필요함을 시사한다. 로봇 공학을 위한 Open-X Embodiment 데이터셋 (Padalkar et al., 2023)이 그러한 예시 중 하나이다.

제한된 레이블 (Limited Labels)

비디오 모델링의 또 다른 과제는 주석(annotated)된 비디오의 부족이다. 예를 들어, MineDojo 데이터셋 (Fan et al., 2022)은 인간이 마인크래프트 게임을 플레이하는 30만 시간 이상의 비디오를 포함하지만, 이 데이터셋에는 언어 전사(language transcriptions)만 있고 게임 액션 레이블은 없어, 이 데이터셋을 사용하여 policy나 환경 모델을 학습하기 어렵다. 마찬가지로, 가장 큰 오픈 소스 로봇 공학 데이터셋 (Padalkar et al., 2023)에서도 많은 로봇 궤적(trajectory)에 수행되는 task에 대한 언어 주석이 없거나, "어떤 물체와 상호작용하기"와 같은 일반적인 레이블만 존재한다.

더 많은 비디오 데이터에 레이블을 지정하기 위해, 이전 연구에서는 이미지/비디오 캡셔닝 모델을 활용하여 추가 텍스트 레이블을 제공했으며, 이는 다시 text-to-image/video 모델을 학습하는 데 사용될 수 있다 (Betker et al., 2023; Blattmann et al., 2023a). 이는 VPT (video pretraining) (Baker et al., 2022)와 유사하지만, VPT는 텍스트 데이터가 아닌 액션 데이터로 비디오에 레이블을 지정한다는 점에서 차이가 있다. 또 다른 가능성은 비디오에서 추론된 잠재 액션/스킬(latent actions/skills)을 활용하는 것이다 (Edwards et al., 2019; Rybkin et al., 2018; Ye et al., 2022). 이 중 가장 큰 규모의 예시는 Bruce et al. (2024)이다. Appendix B의 Figure 13에서 잠재 액션의 예시를 보여준다. 학습된 잠재 액션의 일관성에도 불구하고, 이 접근 방식이 더 복잡하고 다양한 동역학(dynamics)에 확장될 수 있는지 여부는 여전히 미해결 과제로 남아 있다.

5.2 Model Heterogeneity

언어 모델이 autoregressive 아키텍처로 수렴된 것과 달리, 비디오 생성 분야는 아직 최적의 접근 방식이 정립되지 않았다. Autoregressive 모델, diffusion 모델, masked 모델은 각각 고유한 장단점을 가지고 있다.

Diffusion Models. Diffusion 모델 (Sohl-Dickstein et al., 2015; Ho et al., 2022a) (Section 3.3에서 사용된 모델과 같은)은 두 가지 주요 장점을 가진다. 첫째, tokenization 없이도 연속적인 출력 공간을 쉽게 모델링할 수 있어 더 나은 생성 품질을 얻을 수 있다. 둘째, 여러 프레임을 병렬로 샘플링할 수 있다. 그러나 diffusion 모델의 샘플링 속도는 여전히 상당히 느려 실시간 시뮬레이션 적용에 한계가 있다. 또한, diffusion 모델로 긴 비디오 시퀀스를 생성하는 방법은 아직 명확하지 않다. Diffusion 모델은 noise schedule과 같은 하이퍼파라미터에 민감한 것으로 알려져 있어 (Croitoru et al., 2023), 학습 및 확장이 어렵다.

Autoregressive Models. Tokenized 출력 공간을 가진 autoregressive 모델 (Section 4.1에서 언급된 모델과 같은)은 diffusion 모델보다 상대적으로 학습하기 쉽다. Tokenization은 또한 비디오 생성을 텍스트 또는 이산(discrete) 액션 생성과 통합할 수 있게 하여, 멀티모달 생성이 필요한 더 많은 애플리케이션을 가능하게 한다 (Team et al., 2023). 또한, autoregressive 모델은 context length에 따라 잘 확장되어 (Dai et al., 2019; Yan et al., 2023; Bai et al., 2023), 잠재적으로 매우 긴 프레임 시퀀스를 모델링할 수 있다. 그러나 autoregressive decoding은 각 토큰을 순차적으로 예측해야 하므로 계산 비용이 많이 든다. 더욱이, autoregressive 방식으로 생성된 비디오는 드리프팅 효과(drifting effect) (Weng et al., 2023)로 인해 품질 저하를 겪을 수 있다.

Masked Models. Masked reconstruction 기반 모델 (Section 4.1에서 새로운 게임 환경을 생성하는 데 사용된 모델과 같은)은 diffusion 모델의 일부 장점을 활용하고, 이미지 토큰 배치를 병렬로 샘플링함으로써 (Chang et al., 2022) token-autoregressive 모델링의 일부 문제를 완화할 수 있다. 이를 통해 Bruce et al. (2024)에서처럼 수천 개의 토큰으로 구성된 이미지를 수십 번의 모델 호출만으로 샘플링할 수 있다. 그러나 이 접근 방식은 개별 샘플링 단계 내의 독립성 가정으로 인해 발생하는 샘플링 편향(sampling bias)과 같은 문제를 야기한다.

더 나은 미래 모델 (Better Future Models). 모델 이질성(heterogeneity)에 대한 잠재적인 해결책은 autoregressive 모델과 masked 모델을 결합하거나 (Yan et al., 2023), autoregressive 모델과 diffusion 모델을 결합하는 (Weng et al., 2023) 등 다양한 모델의 장점을 결합하는 것을 필요로 할 수 있다. 또한, 비디오 데이터는 공간적, 시간적으로 중복된 정보를 포함할 수 있다. 미래 모델은 이러한 중복성을 줄이기 위해 latent space 학습을 고려할 수 있다. 더 나은 비디오 생성 모델은 또한 기존 모델들의 생성 속도 및 장기적인 일관성(long-term consistency)에 대한 현재의 도전 과제를 해결해야 한다.

5.3 Hallucination

비디오 생성 모델에서 환각(hallucination) 현상은 다양한 유형의 모델에서 흔히 발생한다. 예를 들어, 객체가 무작위로 나타나거나 사라질 수 있다 (Figure 8 하단 행 및 Appendix B.5 참조). 이는 객체가 종종 작기 때문에, 객체에 대한 loss weight가 배경에 대한 loss weight만큼 높지 않기 때문일 수 있다.

또 다른 흔한 환각 유형은 **비현실적인 역학(implausible dynamics)**과 관련이 있다. 예를 들어, 로봇이 컵을 잡는 대신 컵이 로봇 손으로 "점프"하는 현상이다. 이는 거친 시간적 빈도(coarse temporal frequency)를 가진 비디오가 정확한 동작에 중요한 프레임을 포착하지 못하기 때문일 수 있다. 또한, 행동과 역학을 동시에 모델링하는 생성 모델은 행동이나 역학으로 인한 시각적 변화를 구별하지 못할 수 있다 (Yang et al., 2022a).

환각은 특정 장면에 대해 사용자 입력이 비현실적일 때도 발생할 수 있다. 예를 들어, 탁상 로봇에게 "손 씻기" 명령이 주어지는 경우이다. 그럼에도 불구하고, 우리는 Figure 11에서 보여주듯이, 비디오 생성 모델이 비현실적인 사용자 입력을 충족시키기 위해 egocentric motion을 활용하여 현실적인 비디오를 생성하려고 시도하는 것을 확인했다. **외부 피드백을 통한 강화 학습(reinforcement learning with external feedback)**과 같은 방법들을 적용하여 비디오 생성 모델의 환각 현상을 더욱 줄일 수 있다.

Figure 11: 비현실적인 지시로부터의 생성. 비디오 생성 모델에 대한 입력 이미지는 로봇 손이 있는 탁상이다. 언어 지시는 "손 씻기"이다. 비디오 모델은 언어 지시를 현실적으로 이행하기 위해 탁상에서 주방 싱크대로 멀어지는 egocentric motion을 생성할 수 있다.

Figure 11: 비현실적인 지시로부터의 생성. 비디오 생성 모델에 대한 입력 이미지는 로봇 손이 있는 탁상이다. 언어 지시는 "손 씻기"이다. 비디오 모델은 언어 지시를 현실적으로 이행하기 위해 탁상에서 주방 싱크대로 멀어지는 egocentric motion을 생성할 수 있다.

5.4 Limited Generalization

임의의 이미지 및 텍스트 입력으로부터 비디오를 생성하는 것은 어려운 일이었다. 특히, 학습 데이터에 잘 표현되지 않는 도메인의 경우 더욱 그러한데, Section 5.1에서 논의된 제한된 데이터 커버리지 문제로 인해 이는 실제 상황에서 매우 흔하다. Diffusion model을 예로 들면, 과적합(overfitting)을 방지하기 위해 저해상도 비디오로 학습한 후 공간적 초해상도(spatial super-resolution)를 적용하는 것이 일반적이다 (Ho et al., 2022a; Bar-Tal et al., 2024; Xing et al., 2023). 우리는 고해상도 이미지/비디오가 인간의 눈에는 보이지 않는 너무 많은 고주파 정보(high-frequency information)를 포함하고 있으며, 여기에 초점을 맞추는 것이 일반화 능력 부족으로 이어진다고 가정한다.

6 Conclusion

우리는 비디오 생성(video generation)이 물리적 세계(physical world)에 대해 언어 모델링(language modeling)이 디지털 세계(digital world)에 대해 가지는 위상과 같다는 입장을 취해왔다. 이러한 입장을 뒷받침하기 위해, 언어 모델과 유사하게 비디오가 광범위한 정보와 task를 표현할 수 있음을 보여주었다. 나아가, 비디오 생성과 reasoning, in-context learning, search, planning, reinforcement learning을 결합하여 실제 세계의 task를 해결하는 응용 분야에 대한 기존 연구와 새로운 관점들을 설명하였다. 환각(hallucination) 및 일반화(generalization)와 같은 도전 과제에도 불구하고, 비디오 생성 모델은 자율 에이전트(autonomous agents), 플래너(planners), 환경 시뮬레이터(environment simulators), 컴퓨팅 엔진(compute engines)이 될 잠재력을 가지고 있으며, 궁극적으로 물리적 세계에서 사고하고 행동하는 인공 두뇌(artificial brain) 역할을 할 수 있을 것이다.

Appendix

A Details of Models Used to Generate Examples in the Main Text

A. 1 Autoregressive Model

Section 4.1의 모델은 시간적으로는 autoregressive하지만, TECO (Yan et al., 2023)와 유사하게 각 프레임에 대해 masked model (Chang et al., 2022)을 사용한다. 주어진 픽셀 관측치 와 해당 action 의 궤적(trajectory)에 대해, 우리는 interleaved sequence 를 모델링한다. 여기서 픽셀 관측치 는 VQVAE (Van Den Oord et al., 2017)와 vision transformer (Dosovitskiy et al., 2021)를 결합하여 token 로 인코딩된다. Action은 VPT (Baker et al., 2022)에 따라 토큰화된다. 우리는 Transformer-XL (Dai et al., 2019)을 활용하여 temporal trajectory 를 인코딩하며, 이때 **시간적으로 정렬된 출력 **를 얻는다. 마지막 입력이 관측치, 즉 였던 단계에서는 context 를 conditioning 입력으로 사용하여 autoregressive transformer head가 를 예측하도록 한다. 만약 마지막 입력이 action이었다면, context 는 masked transformer head에 conditioning되어 를 모델링한다. 우리의 MaskGIT 구현은 cosine masking schedule을 사용하여 8단계로 진행된다. interleaved transformer의 성능을 더욱 향상시키기 위해, 우리는 과거 encoder를 사용하여 memory를 초기화한다. 이 과거 encoder는 discretization 없이 입력 를 활용하여 interleaved sequence에 대해 별도로 학습된 동일한 Transformer이다.

A. 2 Diffusion Model

Figure 2, Figure 5, Figure 8, Figure 9, Figure 10에서 예시를 생성하는 데 사용된 diffusion model은 Ho et al. (2022b;a)와 동일한 3D U-Net 아키텍처를 사용한다. 이 아키텍처는 공간적 downsampling pass와 upsampling pass에 3D attention 및 convolution layer가 교차(interleaved)되어 배치되어 있다. Skip connection은 downsampling pass의 activation에 적용된다. 이 모델은 latent-space diffusion이 아닌 pixel-space diffusion을 사용한다.

Section 5에서 설명된 비디오 diffusion의 관례에 따라, 저해상도 비디오 생성 모델은 [24, 40] 해상도에서 작동하며, 그 뒤에 [48, 80] 및 [192, 320] 해상도를 목표로 하는 두 개의 공간적 super-resolution 모델이 이어진다. Classifier-free guidance (Ho & Salimans, 2022)는 텍스트 또는 action conditioning을 위해 적용되었다. 프레임 conditioning의 경우, conditioning 프레임을 classifier-free guidance에 사용되는 조건부(conditional) 및 비조건부(unconditional) 모델 모두에 입력한다. Figure 8에 나타난 SE(3) dynamics를 시뮬레이션하기 위해, 우리는 Yang et al. (2023b) 및 Padalkar et al. (2023)과 유사한 action discretization을 사용한다.

A. 3 Masked Model

Section 4.1에서 새로운 게임 환경을 생성한 (Bruce et al., 2024)의 masked dynamics model은 제어 가능한 비디오 연속(continuation) 모델이다. 이 모델은 전환(transition)을 나타내는 비지도 잠재 변수(unsupervised latent variables)에 조건화되어 프레임 수준에서 autoregressive하게 출력을 생성한다.

잠재 변수는 VQ-VAE 코드 (Van Den Oord et al., 2017) 의 이산 집합으로 구성되며, 이 코드들은 프레임 에 조건화되고 causal Transformer를 사용하여 를 예측하는 데 도움이 되도록 최적화된다.

dynamics model은 interleaved temporal 및 spatial attention (Gupta et al., 2022)을 가진 Transformer이며, (Chang et al., 2022)에 따라 masked reconstruction objective를 사용하여 학습된다.

비디오 토큰은 평균 75%의 비율로 독립적인 무작위 Bernoulli mask로 마스킹되며, dynamics model은 cross-entropy objective를 최소화하여 누락된 토큰을 예측하도록 학습된다.

추론 시에는 MaskGIT (Chang et al., 2022)에 따라 토큰이 병렬로 생성된다.

프레임 에 대한 unmasked context 토큰과 완전히 마스킹된 프레임 로 시작하여, 일련의 반복적인 단계가 수행된다. 각 단계에서는 와 에 조건화된 모든 토큰에 대한 logits를 계산하고, 남아있는 각 마스킹된 위치에 대해 후보 토큰을 샘플링하며, 가장 높은 확률의 샘플이 향후 단계를 위해 고정된다.

(Bruce et al., 2024)에서는 각 이미지가 920개의 토큰으로 구성되며, 이들은 25단계의 MaskGIT 과정을 통해 모두 샘플링된다.

이 모델은 대규모 비디오 데이터셋에서 완전히 비지도 학습된다. 10.7B 파라미터 모델의 예시 궤적은 13에서 확인할 수 있으며, 이는 비지도 잠재 액션(latent action) objective가 다양한 시각적 prompt에 걸쳐 일관된 제어 변수를 생성함을 보여준다.

B Additional Generated Videos

B. 1 Additional Game Simulations

Figure 12: Minecraft에서 추가로 생성된 게임 궤적.

Figure 12: Minecraft에서 추가로 생성된 게임 궤적.

Section 4.1의 모델을 사용하여 추가적인 모델 롤아웃을 시연한다. 모델이 ego-centric motion을 상당히 잘 처리할 수 있음을 확인했다. 그러나 세 번째 행에서 볼 수 있듯이 시간적 일관성(temporal consistency)이 때때로 문제가 될 수 있다. 에이전트가 클립 중간에 인벤토리를 열고, 그 다음 앞에 있던 상자가 사라진다.

Figure 13: 추가 시뮬레이션된 게임 다이내믹스.

Figure 13: 추가 시뮬레이션된 게임 다이내믹스.

(Bruce et al., 2024)에서 생성된 프레임. 각 프레임은 **text-to-image 모델의 초기 합성 prompt 이미지와 비지도 잠재 액션(unsupervised latent action)**으로부터 생성된다. 잠재 액션의 비지도 특성에도 불구하고, 그 의미는 초기 프레임 전반에 걸쳐 상대적으로 일관적이다. 모델의 한계 중 하나는 초기 이미지 경계를 벗어나는 부분에서 상대적으로 평범한 연속(continuation)을 생성하는 경향이 있다는 점이며, 이는 맨 아래 행의 'jump' 열에서 가장 명확하게 나타난다.

B. 2 Additional Generation for How-to Videos

Figure 14: 추가 생성된 How-to 비디오.

일부 생성된 프레임은 사용자의 질문에 대한 핵심 프레임을 합성할 수 있지만(첫 번째 및 마지막 행), 다른 일부 생성된 프레임은 너무 일반적이어서 사용자의 질문에 완전히 답할 만큼 충분한 세부 정보를 담지 못한다.

Figure 14: 추가 생성된 How-to 비디오.

일부 생성된 프레임은 사용자의 질문에 대한 핵심 프레임을 합성할 수 있지만(첫 번째 및 마지막 행), 다른 일부 생성된 프레임은 너무 일반적이어서 사용자의 질문에 완전히 답할 만큼 충분한 세부 정보를 담지 못한다.

B. 3 Additional Self-Driving Simulations

Figure 15: 운전을 위한 추가적인 Generative Simulation.

Generative simulator는 맑음, 비, 눈, 밤, 새벽 등 다양한 날씨 조건과 시간대의 운전 상황을 생성할 수 있다.

Figure 15: 운전을 위한 추가적인 Generative Simulation.

Generative simulator는 맑음, 비, 눈, 밤, 새벽 등 다양한 날씨 조건과 시간대의 운전 상황을 생성할 수 있다.

B. 4 Additional Robot SE(3) Simulations

Figure 16: SE(3) 로봇 동작의 추가적인 생성 시뮬레이션.

로봇 정책의 실제 실행(빨간색)과 동일한 정책의 시뮬레이션 실행(파란색). 시뮬레이션된 rollout은 일반적으로 ground truth rollout과 일치한다.

Figure 16: SE(3) 로봇 동작의 추가적인 생성 시뮬레이션.

로봇 정책의 실제 실행(빨간색)과 동일한 정책의 시뮬레이션 실행(파란색). 시뮬레이션된 rollout은 일반적으로 ground truth rollout과 일치한다.

B. 5 Examples of Hallucination

Figure 17: 세 가지 유형의 모델에서 나타난 Hallucination 예시.

Hallucination 문제는 다양한 유형의 비디오 생성 모델 전반에 걸쳐 지속적으로 발생한다.

첫 번째 행에서 autoregressive model이 생성한 비디오는 인벤토리가 닫힌 후 상자가 사라지는 것을 보여준다.

두 번째 행에서 diffusion model이 생성한 비디오는 서랍에 넣은 오렌지가 사라지는 것을 보여준다.

가장 아래 행에서 masked model이 생성한 비디오는 구름이 경계에서 갑자기 멈추는 것을 보여준다.

Figure 17: 세 가지 유형의 모델에서 나타난 Hallucination 예시.

Hallucination 문제는 다양한 유형의 비디오 생성 모델 전반에 걸쳐 지속적으로 발생한다.

첫 번째 행에서 autoregressive model이 생성한 비디오는 인벤토리가 닫힌 후 상자가 사라지는 것을 보여준다.

두 번째 행에서 diffusion model이 생성한 비디오는 서랍에 넣은 오렌지가 사라지는 것을 보여준다.

가장 아래 행에서 masked model이 생성한 비디오는 구름이 경계에서 갑자기 멈추는 것을 보여준다.