PLOT: Slot Attention을 활용한 텍스트 기반 인물 검색

PLOT은 텍스트 쿼리를 사용하여 특정 인물을 검색하는 텍스트 기반 인물 검색(Text-based person search)을 위한 새로운 프레임워크입니다. 이 방법은 slot attention 기반의 part discovery module을 활용하여 별도의 파트 수준 감독(supervision) 없이 이미지와 텍스트에서 신체 부위를 자율적으로 식별하고 정렬합니다. 또한, 텍스트 기반 동적 파트 어텐션(text-based dynamic part attention, TDPA)을 통해 각 파트의 중요도를 조절하여 검색 정확도를 높이며, 기존 방법들보다 뛰어난 성능과 해석 가능한 검색 결과를 제공합니다. 논문 제목: PLOT: Text-based Person Search with Part Slot Attention for Corresponding Part Discovery

Park, Jicheol, et al. "Plot: Text-based person search with part slot attention for corresponding part discovery." European Conference on Computer Vision. Cham: Springer Nature Switzerland, 2024.

PLOT: Text-based Person Search with Part Slot Attention for Corresponding Part Discovery

Abstract

**텍스트 기반 인물 검색(Text-based person search)**은 자유 형식의 텍스트 쿼리를 사용하여 방대한 이미지 컬렉션에서 인물을 식별하는 task로, 특히 인체 부위(human part) 수준에서 시각적 표현과 텍스트 표현을 정렬(align)하는 데 독특한 도전 과제를 제시한다. 기존 방법들은 직접적인 part-level supervision의 부족과 휴리스틱(heuristic) feature에 대한 의존으로 인해 part feature 추출 및 정렬에 어려움을 겪는 경우가 많다.

우리는 이러한 문제를 해결하기 위해 slot attention 기반의 part discovery module을 활용하는 새로운 프레임워크를 제안한다. 이 모듈은 명시적인 part-level correspondence supervision 없이도 다양한 양식(modality)에 걸쳐 특징적인 부위를 자율적으로 식별하고 정렬하여 해석 가능성(interpretability)과 검색 정확도(retrieval accuracy)를 향상시킨다. 또한, 텍스트 기반의 dynamic part attention은 각 부위의 중요도를 동적으로 조절하여 검색 결과를 더욱 개선한다.

우리의 방법은 세 가지 공개 벤치마크에서 평가되었으며, 기존 방법들을 크게 능가하는 성능을 보여주었다.

키워드: Text-Based Person Search, Multi-Modal Retrieval

1 Introduction

**텍스트 기반 인물 검색(Text-based person search)**은 자유 형식의 텍스트 쿼리를 사용하여 방대한 이미지 컬렉션에서 대상 인물을 식별하는 task이다. 이 task는 개인 간의 미묘한 차이를 포착하기 위해 텍스트 및 시각적 양쪽 modality에서 **인물 부분(human parts)**과 같은 식별 가능한 feature를 추출해야 한다. 따라서 정확한 텍스트 기반 인물 검색을 위해서는 **이미지 및 텍스트 modality 간에 추출된 인물 부분 feature의 대응 관계(correspondence)**를 설정하는 것이 필수적이다. 그러나 부분 수준의 supervision 없이 이러한 부분 feature를 추출하고 두 modality 간의 대응 관계를 설정하는 것은 쉽지 않다.

이러한 어려움을 해결하기 위해 이전 연구 [3,24]는 전체 이미지를 수평으로 균등하게 자르는 방식으로 얻은 **휴리스틱 부분 feature(heuristic part features)**에 의존한다. 이러한 feature는 인물 검색을 위해 자유 형식 텍스트 쿼리와 매칭된다. 그러나 이 접근 방식에서 사용되는 휴리스틱 부분 feature는 가려짐(occlusion) 및 자세 변화(pose variation)로 인한 변형에 취약하다. 한편, 초기 연구 [9,22,26]는 부분 feature 추출을 위한 **학습 기반 접근 방식(learning-based approach)**을 제안했다. 그럼에도 불구하고, 이러한 방법들은 분리(disentanglement)가 부족한 중복된 부분 feature를 생성하는 경향이 있거나 [22], 추가적인 부분 수준 supervision에 대한 접근을 요구한다 [9,26].

Fig. 1: PLOT의 전체 아키텍처.

Fig. 1: PLOT의 전체 아키텍처.

위의 문제들을 해결하기 위해, 우리는 두 modality에서 특징적인 부분(distinctive parts)을 발견하고, 어떠한 대응 관계 supervision 없이 두 modality 간에 이들을 매칭하는 새로운 프레임워크를 소개한다. 전체 아키텍처는 Fig. 1에 나와 있다. 두 modality에서 특징적인 부분을 발견하고 그 feature를 추출하기 위해, 우리는 sLOT attention 메커니즘 [17]에 기반한 부분 발견 모듈(Part discovery module)인 PLOT을 제안한다. Slot attention은 **객체 중심 학습(object-centric learning)**을 위해 설계된 attention 메커니즘으로, 객체 수준의 supervision 없이 입력 데이터를 개별 엔티티를 나타내는 일련의 slot으로 분할한다. PLOT에서 우리는 먼저 두 modality 간에 공유되는 인체 부분과 관련된 원시 정보(primitive information)를 포함하는 학습 가능한 임베딩 벡터 집합을 정의하는데, 이를 part slot이라고 부른다. 그런 다음, 이 part slot들은 여러 반복적인 attention 프로세스를 통해 정제되며, 이 과정에서 입력 데이터와 결합하기 위해 서로 경쟁한다. 궁극적으로 part slot들은 입력 데이터에서 특징적인 부분을 나타내는 부분 feature(part features)인 part embedding으로 변환된다.

서로 다른 modality에서 얻은 part embedding 간의 대응 관계를 보장하기 위해, part slot은 시각 및 텍스트 modality 간에 공유된다. 동일한 part slot에서 파생된 part embedding은 서로 다른 modality에서 계산되었음에도 불구하고 동일한 부분을 나타내도록 학습된다. 이 메커니즘은 PLOT이 대응 관계에 대한 supervision 없이 두 modality에서 발견된 부분을 매칭할 수 있게 하며, 동시에 두 modality에서 부분 수준의 세분화된 외형 feature(fine-grained appearance features)를 포착할 수 있게 한다. 따라서 PLOT은 풍부하고 세분화된 part feature를 통해 텍스트 기반 인물 검색의 성능을 향상시키고, 동시에 쿼리 텍스트와 검색된 이미지 간의 부분 수준 대응 관계를 제공함으로써 해석 가능한 검색(interpretable retrieval)을 보장한다.

또한 PLOT은 텍스트 쿼리에 기반하여 part embedding의 가중치를 동적으로 조정하는 새로운 유사도 집계 방법인 **텍스트 기반 동적 부분 attention (TDPA) 풀링(text-based dynamic part attention (TDPA) pooling)**을 도입한다. 텍스트 쿼리를 입력으로 받으면, TDPA는 검색을 위한 각 slot의 중요도 가중치를 예측하고, 예측된 중요도 가중치를 적용하여 두 modality 간의 part embedding 유사도를 집계한다. TDPA는 전체 검색 시스템이 각 쿼리에 대해 최적화된 검색을 수행하도록 하여 성능 향상으로 이어진다.

우리의 방법은 세 가지 공개 벤치마크 [5,13,35]에서 이전 연구와 비교 및 평가되었으며, part embedding 기반의 풍부한 표현 덕분에 모든 기존 방법을 명확하게 능가했다. 우리 연구의 주요 기여는 네 가지이다:

- 우리는 PLOT을 소개한다. PLOT은 텍스트 기반 인물 검색을 위한 새로운 프레임워크로, 구별되는 인체 부분을 발견하고, 그 임베딩을 추출하며, 어떠한 사람의 개입 없이 두 modality 간에 그 대응 관계를 설정한다.

- PLOT이 제공하는 part embedding은 부분 수준의 대응 관계 덕분에 해석 가능한 텍스트 기반 인물 검색을 가능하게 한다.

- 우리는 각 텍스트 쿼리에 기반하여 발견된 각 부분의 중요도를 적응적으로 결정하고, 결과적으로 쿼리별로 최적화된 검색을 가능하게 하는 새로운 유사도 집계 방법을 소개한다.

- PLOT을 적용한 우리 모델은 텍스트 기반 인물 검색을 위한 모든 공개 벤치마크에서 최고의 성능을 달성했다.

2 Related Work

2.1 Text-Based Person Search

최근 몇 년간 텍스트 기반 인물 검색(text-based person search) task는 컴퓨터 비전 커뮤니티에서 상당한 주목을 받아왔다. Li et al. [13]은 텍스트 설명과 이미지 간의 유사도(affinity)를 학습하기 위한 **gated neural attention-based recurrent neural network (GNA-RNN)**을 제안했으며, 모델 평가를 위한 벤치마크 데이터셋인 CUHK-PEDES를 제공했다. Zhang et al. [33]은 cross-modal projection matching and classification (CMPM+CMPC) loss를 제안하여, 깊이 있는 판별적 이미지-텍스트 전역 임베딩(global embedding)을 학습했다. 그러나 이러한 방법들은 주로 입력 데이터의 전역 표현(global representation)에 초점을 맞추고 있어, 인물의 특징적인 부분(part) 디테일을 포착하는 데 한계가 있었고, 이는 텍스트 기반 인물 검색 성능의 제약으로 이어졌다.

위 문제를 해결하기 위해, 일련의 연구들은 세분화된(fine-grained) 표현 추출에 집중했다. fine-grained 정보를 활용하는 대표적인 예시 중 하나는 인물 이미지를 수평으로 잘라(equi-horizontal cropping) 인물 부분(human parts)으로 사용하는 것이다 [3, 5, 6, 18, 24, 25]. Chen et al. [3]은 전체 이미지를 동일한 수평으로 잘라 이미지 부분 임베딩을 추출하고, 추가 네트워크를 정렬하여 텍스트의 전역 정보를 해당 부분으로 변환한다. 그러나 이러한 휴리스틱한 부분 feature들은 배경 요소와 같이 정보가 없는(no-informative) 정보를 필연적으로 포함하게 된다. 이러한 한계를 피하기 위해 Suo et al. [24]는 휴리스틱한 부분 feature에서 전경(foreground) feature를 추출하기 위한 간단하고 견고한 상관 필터링(correlation filtering) 방법을 제안했다. 하지만 휴리스틱하게 분할된 부분 feature들은 복잡한 인물 부분을 포착하는 데 근본적인 한계가 있으며, 이는 표현 능력의 중요한 제약을 강조한다. 이러한 휴리스틱한 부분 구조를 넘어서기 위해 Shao et al. [3]은 부분 feature 추출을 위한 학습 기반 접근 방식을 제안한다. 그러나 이 방법은 충분한 disentanglement가 부족하여 중복된 부분 정보를 추출하기 때문에, 특징적인 부분 임베딩을 추출하는 데 어려움을 겪는다. 정교한 인물 부분을 추출하기 위해 몇몇 연구들은 외부 도구(예: 인물 속성 및 인물 키포인트)를 활용하여 유용한 정보를 사용하려고 시도했다 [1, 9, 26]. Wang et al. [26]은 **보조 속성 분할(auxiliary attribute segmentation)**을 도입하여 시각적 부분 feature를 텍스트 설명에서 파싱된 텍스트 속성과 정렬했다. Jing et al. [9]은 **인물 자세 추정(human pose estimation)**을 통해 시각과 텍스트 간의 부분 feature 정렬을 학습하기 위한 새로운 multi-granularity attention network를 제안했다. 그러나 이러한 접근 방식들은 높은 계산 비용과 지역 feature 추출을 위한 외부 도구의 성능에 대한 의존성이라는 피할 수 없는 한계를 가지고 있다.

가장 최근 연구인 Jiang et al. [8]은 사전학습된 CLIP [20] 모델을 활용하여, 방대한 데이터로 학습된 모델의 풍부한 지식을 텍스트-이미지 매칭에 활용함으로써 텍스트 기반 인물 검색에서 뛰어난 성능을 보였다. 그러나 이 방법은 주로 전역 feature에 초점을 맞추고 있으며, 인물 부분 feature 추출을 위해 특별히 설계된 것은 아니다. 우리는 사전학습된 지식을 활용할 뿐만 아니라, 외부 도구나 부분 수준의 supervision 없이도 정교한 인물 부분을 추출하기 위해 휴리스틱한 인물 부분 방법론을 뛰어넘는 접근 방식을 제안한다.

2.2 Slot Attention

Slot attention [17]은 이미지 내에서 구성 시각 개체(constituent visual entities)를 발견하는 데 중점을 둔 문제인 object-centric learning을 위해 최근 제안된 attention mechanism이다. slot attention의 독특한 특징은 입력 이미지를 slot들의 집합으로 표현할 수 있다는 점이다. 여기서 slot들은 학습 중 어떠한 object-level supervision 없이도 개별 시각 개체에 해당하는 표현이 된다. slot attention 내에서 slot들은 입력 데이터를 집계하기 위해 반복적으로 경쟁하며, 이는 개별 시각 개체에 초점을 맞춘 고유한 표현을 보장한다.

slot attention을 통합함으로써, 제안된 프레임워크는 이미지 및 텍스트 쿼리 이면에 있는 구조를 비지도 방식으로 식별하는 것을 용이하게 하며, 명시적인 supervision 없이도 개별 인체 부위를 식별하고 표현할 수 있게 한다. 이러한 능력은 미묘한 차이를 인식하고 다른 modality 간의 인체 부위 대응 관계를 이해하는 것이 중요한 person search 데이터셋에서 특히 유용하다.

3 Proposed Method

다음 하위 섹션에서는 각 모달리티의 backbone을 이용한 전역(global) 및 부분(part) 임베딩 추출에 대한 세부 정보를 제공한다 (Sec 3.1). 이어서, 부분 발견 모듈(part discovery module) (Sec. 3.2)과 부분 임베딩 간의 유사도 집계(similarity aggregation) (Sec. 3.3)를 포함하는 새로운 프레임워크인 PLOT을 제시한다. 마지막으로, 제안된 프레임워크를 최적화하기 위해 설계된 학습 목표(learning objective) (Sec. 3.4)와 프레임워크의 추론(inference) (Sec. 3.5)에 대한 논의로 마무리한다.

3.1 Global and Part Embeddings

우리의 프레임워크에서, 단일 입력 데이터는 두 가지 다른 유형의 표현: **전역 임베딩(global embedding)**과 **다중 부분 임베딩(multiple part embeddings)**으로 설명된다. 전역 임베딩은 입력 데이터를 전체적으로(holistically) 표현하는 데 사용되며, 각 부분 임베딩은 고유한 인체 부위(예: 팔, 다리, 몸통 등)의 외형(appearance)을 설명한다. 아래에서는 시각 및 텍스트 양식에 대한 전역 및 부분 임베딩 계산의 세부 사항을 제공한다. 이전 연구 [8]에 따라, 사전학습된 **CLIP [20]**이 시각 및 텍스트 양식의 **백본 네트워크(backbone networks)**로 사용된다.

시각 양식 (Visual Modality): 우리는 **CLIP B/16 [20] 아키텍처의 vision transformer (ViT)**를 시각 백본 네트워크로 활용한다. 처음에, 사람의 입력 이미지는 개의 고유하고 겹치지 않는 패치(patch)로 분할되며, 이 패치들은 선형 투영(linear projection)을 통해 패치 토큰(patch tokens)으로 변환된다. 이 패치 토큰들과 추가적인 [cls] 토큰은 시각 백본 네트워크에 입력된다. 토큰 시퀀스는 여러 self-attention 블록을 통해 처리되며, 마지막 블록의 [cls] 토큰은 **전역 임베딩 **으로 사용된다. **부분 임베딩 **을 얻기 위해, 마지막 블록의 나머지 **패치 토큰 **은 **부분 발견 모듈(part discovery module)**로 전달된다. 부분 발견 모듈은 **일관된 인체 부위를 설명하는 패치 feature들을 동일한 부분 임베딩으로 집계(aggregate)**한다. 부분 발견 모듈에 대한 더 자세한 정보는 Sec. 3.2에서 제공한다.

텍스트 양식 (Textual Modality): 텍스트 백본 네트워크의 경우, 우리는 CLIP-Xformer [20] 텍스트 인코더의 Transformer 아키텍처를 활용한다. 이 인코더는 BPE(byte pair encoding) 시퀀스로 변환된 텍스트 입력을 처리한다. 처음에, 텍스트 쿼리는 BPE를 통해 **토큰화(tokenization)**되고, 이어서 [SOS] 및 [EOS] 토큰으로 둘러싸인다. 결과로 생성된 토큰 시퀀스는 텍스트 백본 네트워크에 입력된다. 여기서, 최종 블록의 [EOS] 토큰은 **전역 임베딩 **으로 사용된다. 시각 양식에 대한 접근 방식과 유사하게, 우리는 **나머지 텍스트 토큰 **을 **부분 발견 모듈을 활용하여 부분 임베딩 **으로 처리한다.

3.2 Part Discovery Module

각 모달리티에서 part embedding을 추출하기 위해, part discovery module은 **patch token **와 **text token **를 각각 **visual part embedding **와 **textual part embedding **로 집계한다. 각 모달리티에 대한 part discovery module은 동일한 모델 아키텍처를 가지며 동등하게 기능한다는 점에 주목할 필요가 있다. 따라서 간결함을 위해 시각 모달리티에 대한 part discovery module만 설명한다.

Part discovery module은 **초기 part slot **와 번의 part slot attention block (PSA block) 반복으로 구성된다. Part embedding을 추출하기 위해, 먼저 **학습 가능한 embedding part slot **를 초기화한다. 여기서 는 part slot의 개수를 나타낸다. 그런 다음, PSA block의 번 반복을 통해 초기 는 정제된 로 진화하며, 각 slot은 입력 데이터 내에서 고유한 part를 포착한다. **정제된 part slot **는 **visual part embedding **로 사용된다. Part discovery module은 다음과 같이 공식화할 수 있다:

\mathbf{P}^{\mathcal{V}}:=\mathbf{S}^{T}, \text { where } \mathbf{S}^{t}=\text { PSA_Block }{ }^{\mathcal{V}}\left(\mathbf{x}^{\mathcal{V}} ; \mathbf{S}^{t-1}\right) .PSA block은 먼저 입력 과 를 layer normalization과 **linear projection layer **로 변환하여 차원의 embedding을 얻는다. 그런 다음 과 사이의 **attention map **는 다음과 같이 계산된다:

Attention map은 part slot에 걸쳐 정규화를 통해 얻어진다. 이 정규화는 각 slot에 고유한 patch token 집합을 바인딩하기 위해 slot들 간의 경쟁을 유도한다. 우리는 **attention map **로 얻은 patch token의 가중 평균으로 part slot을 업데이트한 다음, 을 hidden state로 사용하여 **gated recurrent unit (GRU)**에 다음과 같이 입력한다:

그런 다음, 을 layer normalization, ReLU activation, residual connection이 있는 **multi-layer perceptron (MLP)**에 입력하여 -번째 part slot을 얻는다:

\mathbf{S}^{t}=\text { PSA_Block }{ }^{\mathcal{V}}\left(\mathbf{x}^{\mathcal{V}} ; \mathbf{S}^{t-1}\right)=\operatorname{MLP}\left(\overline{\mathbf{S}}^{t-1}\right)+\overline{\mathbf{S}}^{t-1}마지막으로, PSA block의 -번째 반복의 출력인 **visual part embedding **를 얻을 수 있다: . Slot 공유를 통한 Part Correspondence: 또한, 우리는 두 part discovery module 간에 학습 가능한 part slot 를 공유하여 각 모달리티에서 추출된 part embedding 간의 correspondence를 설정한다. 이는 동일한 part slot에서 추출된 part embedding이 모달리티 간에 상응하는 part라고 간주하여, 모달리티 간의 보다 명확한 비교에 기여한다.

3.3 Measuring Similarity between Embeddings

우리의 검색 모델을 학습하고 적용하는 맥락에서, 임베딩 간의 적절한 유사도 함수를 선택하는 것은 매우 중요하다. 여기서의 도전 과제는 전역 임베딩(global embeddings)과 부분 임베딩(part embeddings)이라는 두 가지 상이한 유형의 임베딩을 다루는 것이다. 전역 임베딩의 경우, 코사인 유사도(cosine similarity)는 유사도를 측정하는 간단하고 효과적인 수단을 제공한다.

그러나 부분 임베딩을 고려할 때 상황은 더욱 복잡해진다. 이러한 복잡성을 해결하기 위한 직접적인 방법은 모든 부분 임베딩 쌍에 걸쳐 평균 코사인 유사도를 계산하는 것이다. 이 접근 방식은 간단하지만, 모든 부분별 유사도를 동일하게 중요하게 취급한다는 단점이 있다. 실제로는 데이터 인스턴스 간의 실제 유사도에 대한 특정 부분 임베딩의 관련성은 텍스트 쿼리의 맥락에 따라 크게 달라질 수 있다. 예를 들어, 텍스트 쿼리가 인물 형상의 특정 특징에만 초점을 맞춘다면, 다른 관련 없는 부분 임베딩으로부터의 유사도 기여는 덜 중요해야 한다. 이러한 도전 과제는 쿼리에서 제공하는 맥락을 기반으로 부분 임베딩의 관련성을 동적으로 평가하고 우선순위를 지정할 수 있는 접근 방식의 필요성을 강조한다.

이러한 도전 과제를 해결하기 위해, 우리는 **부분 임베딩 간의 유사도를 집계하기 위해 텍스트 기반 동적 부분 어텐션(text-based dynamic part attention, TDPA)**을 도입한다. 첫째, 텍스트 전역 임베딩 는 MLP와 softmax 함수를 사용하여 TDPA 로 변환된다. TDPA를 사용하여 부분 임베딩 간의 집계된 유사도는 다음과 같이 계산된다:

여기서 는 두 임베딩 간의 코사인 유사도를 나타내고, 는 의 -번째 값이며, 는 softmax 함수이다. 주어진 텍스트 전역 임베딩 가 있다면, TDPA는 MLP에 의해 계산되며, 이 MLP는 Sec 3.4에서 소개될 우리의 partNCE loss를 최소화하는 방식으로 end-to-end로 학습된다. 이 동적 어텐션은 각 부분 임베딩에 중요도를 적응적으로 할당할 수 있게 하여, 정보성이 낮은 부분 임베딩의 영향을 줄이고 각 텍스트 쿼리의 중요한 의미론적 유사도를 반영하는 보다 정보성 높은 유사도 측정을 촉진한다.

3.4 Learning Objective

우리 모델은 전역(global) 및 부분(part) 수준을 모두 고려하여 cross-modal alignment를 구축함으로써 학습된다. 전역 수준(global-level)에서의 alignment는 각 모달리티의 포괄적인 정보를 담고 있는 global embedding 와 를 정렬함으로써 달성된다. 부분 수준(part-level) alignment를 위해서는, slot attention으로 인해 각 모달리티 내에서 국소적으로 배타적인(locally exclusive) 특징을 갖는 part embedding 와 를 활용한다. 더 나아가, 텍스트 global embedding 에 기반하여 특정 part slot의 가중치를 동적으로 조절함으로써, 더욱 정보가 풍부한 alignment 학습을 촉진한다.

Global Alignment Loss: 각 모달리티 backbone에서 추출된 global embedding 와 를 정렬하기 위해, 먼저 global embedding의 배치 를 정의한다. 여기서 는 배치 크기이다. 그 다음, **InfoNCE loss [19]**를 채택하는데, 이는 배치 내에서 positive 쌍의 embedding 유사도를 최대화하고 negative 쌍의 유사도를 최소화하는 contrastive learning objective이다. 결과적으로, cosine 유사도 함수 를 사용한 우리의 global NCE loss는 다음과 같이 공식화된다:

여기서 는 temperature 항이다. 추가적으로, 동일한 identity에서 추출된 embedding들이 유사해지도록 보장하기 위해 **identity classification loss **를 사용한다. 는 다음과 같이 표현된다:

여기서 는 해당 global embedding 의 identity ground truth를 나타내는 one-hot 벡터이며, 는 identity의 개수이다. 는 두 모달리티 간에 공유되는 classifier이다. 최종적으로, global alignment loss는 다음과 같이 정의된다:

Part Alignment Loss: global embedding의 alignment와 유사하게, 먼저 part embedding의 배치 를 정의한다 (배치 크기 ). 그리고 두 모달리티에서 추출된 part embedding을 정렬하기 위해 InfoNCE loss를 채택한다. 모달리티 간 텍스트 쿼리 기반의 정보성 part embedding alignment 학습을 위해, InfoNCE loss 계산 시 Eq. 6의 텍스트 쿼리 기반 유사도 집계 함수 를 사용한다. 를 사용한 이 InfoNCE를 PartNCE loss라고 부르며, 다음과 같이 공식화된다:

global alignment loss와 유사하게, part alignment를 위해 두 모달리티 간에 classifier 가중치를 공유하는 identity loss를 사용한다. 그러나 차이점은 part embedding들이 embedding 차원을 따라 연결(concatenate)된다는 점이다. part alignment를 위한 identity loss는 다음과 같이 공식화된다:

여기서 는 embedding 차원을 따라 part embedding 를 연결한 것이며, 는 두 모달리티 간에 공유되는 classifier이다. 최종적으로, part alignment loss는 다음과 같이 계산된다:

Cross-Modal Masked Language Modeling Loss: 기존 방법들 [8, 23]에서 Transformer 기반 backbone을 사용하는 관행을 따라, 우리는 모달리티 간의 상호작용 학습을 촉진하기 위한 보조 손실(auxiliary loss)인 cross-modal masked language modeling (CMLM) loss를 채택한다.

Cross-Modal Masked Language Model (CMLM)

Cross-Modal Masked Language Model (CMLM)

Fig. 2: CMLM의 도식.

BERT [4]와 유사하게, 텍스트 설명이 주어지면 15% 확률로 텍스트 토큰을 무작위로 선택하여 학습 가능한 [MASK] 토큰으로 대체한다. 마스킹된 텍스트 설명은 텍스트 backbone을 통해 처리되어 마스킹된 텍스트 토큰을 얻는다. 마스킹된 텍스트 토큰을 얻은 후, 이를 **이미지 backbone을 통해 추출된 visual token과 연결(concatenate)**한다. 연결된 토큰들은 Transformer에 입력되어 cross-modal fused token을 얻는다. fused token 중에서 텍스트 토큰의 인덱스에 해당하는 토큰들은 로 구성되며, 여기서 fused token 이고 은 입력 텍스트 설명의 최대 길이를 나타낸다. 궁극적으로, 이 토큰들은 CMLM classifier 에 입력되어 vocabulary ID의 확률을 예측한다. CMLM의 전체 절차는 Fig. 2에 도식화되어 있으며, 이 절차를 통해 loss는 다음과 같이 계산된다:

여기서 이고 는 -번째 텍스트 토큰의 vocabulary ground truth를 나타내는 one-hot 벡터이며, 는 vocabulary의 크기이다. 마지막으로, 학습을 위한 우리의 전체 목적 함수는 다음과 같이 표현된다:

3.5 Inference

테스트 시, 각 모달리티 입력의 global embedding과 part embedding은 이미지-텍스트 쌍 간의 유사도를 계산하기 위해 완전히 활용된다. 특히, 시각적 part embedding과 그에 상응하는 텍스트 part embedding 간의 유사도는 attention weight 와 선형적으로 결합되어 집계된다. 이미지-텍스트 쌍 유사도는 이미지-텍스트 쌍의 global embedding 간 유사도와 part embedding 간 유사도의 합으로 정의되며, 이는 로 계산할 수 있다. 마지막으로, 텍스트 쿼리가 주어지면, 갤러리 내의 이미지들은 추론을 위해 이미지와 텍스트 간의 유사도 점수에 따라 순위가 매겨진다.

4 Experiments

이 섹션에서는 실험 설정(Sec. 4.1) 에 대해 자세히 설명하고, 텍스트 기반 인물 검색을 위한 세 가지 벤치마크 데이터셋에서 우리 방법론을 평가하며, state-of-the-art 방법들과 비교(Sec. 4.2) 한다. 또한, 정성적인 검색 결과를 제시하고, 시각화 결과와 함께 part discovery 모듈 및 TDPA의 효과를 분석(Sec. 4.3) 한다. 모델 학습에 사용된 loss, part discovery 방법론, part 유사도 통합 전략에 대한 ablation study도 수행(Sec. 4.4) 한다.

4.1 Experimental Setup

데이터셋 (Datasets)

우리는 세 가지 벤치마크 데이터셋인 **CUHK-PEDES [13], ICFG-PEDES [5], RSTPReid [35]**에서 우리 방법의 성능을 이전 방법들과 비교 평가한다.

CUHK-PEDES는 기존의 5개 person re-identification 데이터셋 [7, 14, 15, 31, 34]에서 수집되었으며, 13,003개의 개별 ID에 해당하는 40,206개의 이미지를 포함한다. 각 이미지에는 약 2개의 주석된 텍스트 설명이 매칭되어 있다. 우리는 [13]의 데이터 분할 방식을 따르며, 11,003개 ID의 34,054개 이미지와 68,126개 텍스트 설명을 학습용으로, 1,000개 ID의 3,078개 이미지와 6,158개 텍스트 설명을 검증용으로, 그리고 1,000개 ID의 3,074개 이미지와 6,156개 텍스트 설명을 테스트용으로 사용한다.

나머지 두 데이터셋은 MSMT17 [29]에서 수집되었다.

ICFG-PEDES는 4,102개 개별 ID의 54,522개 이미지-텍스트 쌍으로 구성되며, 학습용으로 34,674개, 테스트용으로 19,848개로 분할된다.

RSTPReid는 4,101개 개별 ID의 20,505개 이미지를 포함하며, 각 ID는 5개의 이미지를 가지고 각 이미지에는 2개의 주석된 텍스트 설명이 연결되어 있다. 우리는 [35]의 데이터 분할 방식을 따르며, 3,701개 ID의 18,505개 이미지와 37,010개 텍스트 설명을 학습용으로, 200개 ID의 1,000개 이미지와 2,000개 텍스트 설명을 검증용으로, 그리고 200개 ID의 1,000개 이미지와 2,000개 텍스트 설명을 테스트용으로 사용한다.

평가 프로토콜 (Evaluation Protocol)

모든 검색(retrieval) 실험에서 우리는 rank at K (R@K = 1, 5, 10)의 표준 metric을 사용한다. 구체적으로, 쿼리 텍스트가 주어지면, 이미지들은 쿼리 텍스트와의 유사도를 기반으로 정렬된다. 검색은 랭킹의 상위 K 위치에 관련 이미지가 하나 이상 나타나면 올바른 것으로 간주된다.

네트워크 아키텍처 (Network Architecture)

우리는 이미지 및 텍스트 인코더 모두에 OpenAI [20]의 사전학습된 CLIP 모델을 채택했으며, 이미지 인코더의 크기는 ViT-B/16이다. 입력 이미지는 384x128 크기로 조정된다. 학습 시 데이터 증강을 위해 **무작위 수평 뒤집기(random horizontal flipping), 무작위 자르기(random cropping), 무작위 지우기(random erasing)**가 적용된다. 최대 텍스트 길이는 77로 설정된다.

네트워크 최적화 (Network Optimization)

우리 모델은 모든 실험에서 Adam optimizer를 사용하여 60 epoch 동안 batch size 128로 학습된다. CLIP 인코더의 경우, 초기 학습률은 5e-6으로 설정되며, 처음 5 epoch 동안 warm-up 전략을 포함한 cosine schedule을 사용한다. 나머지 파라미터에 대해서는 20배 스케일링하여 높은 학습률을 사용한다.

하이퍼파라미터 (Hyperparameters)

part slot의 개수는 8개로 설정된다. part slot attention block의 반복 횟수는 5회로 설정된다. 온도(temperature) 파라미터 는 0.015로 설정된다.

4.2 Quantitative Results

우리는 CUHK-PEDES [13], ICFG-PEDES [5], RSTPReid [35] 데이터셋에서 기존의 텍스트 기반 person search 방법들과 우리의 방법을 비교한다. 각 방법이 사용한 modality별 backbone과 성능 비교는 Table 1에 제시되어 있다. 특히, 우리의 방법은 CUHK-PEDES, ICFG-PEDES, RSTPReid 데이터셋에서 각각 75.28%, 65.76%, 61.80%의 뛰어난 R@1 성능을 달성하며, 우리와 다른 backbone을 활용하는 기존 방법들을 능가한다. 또한, 우리의 방법은 기존의

Table 1: 세 가지 데이터셋에서 텍스트 기반 person search 방법들의 성능. **굵은 글씨(Bold)**는 최고 성능을, **밑줄(underline)**은 두 번째 최고 성능을 나타낸다.

| Methods | Backbone | CUHK-PEDES | ICFG-PEDES | RSTPReid | |||||||

|---|---|---|---|---|---|---|---|---|---|---|---|

| Image | Text | R@1 | R@5 | R@10 | R@1 | R@5 | R@10 | R@1 | R@5 | R@10 | |

| GNA-RNN [13] | RN50 | LSTM | 19.05 | - | 53.64 | - | - | - | - | - | - |

| CMPM/C [33] | RN50 | LSTM | 49.37 | 71.69 | 79.27 | 43.51 | 65.44 | 74.26 | - | - | - |

| PMA [9] | RN50 | BERT | 53.81 | 73.54 | 81.23 | - | - | - | - | - | - |

| TIMAM [21] | RN101 | BERT | 54.51 | 77.56 | 84.78 | - | - | - | - | - | - |

| SCAN [10] | RN50 | BERT | 55.86 | 75.97 | 83.69 | 50.05 | 69.65 | 77.21 | - | - | - |

| ViTAA [26] | RN50 | LSTM | 55.97 | 75.84 | 83.52 | 50.98 | 68.79 | 75.78 | - | - | - |

| NAFS [6] | RN50 | BERT | 59.94 | 79.86 | 86.70 | - | - | - | - | - | - |

| DSSL [35] | RN50 | BERT | 59.98 | 80.41 | 87.56 | - | - | - | 32.43 | 55.08 | 63.19 |

| MGEL [25] | RN50 | LSTM | 60.27 | 80.01 | 86.74 | - | - | - | - | - | - |

| SSAN [5] | RN50 | LSTM | 61.37 | 80.15 | 86.73 | 54.23 | 72.63 | 79.53 | 43.50 | 67.80 | 77.15 |

| LapsCore [30] | RN50 | BERT | 63.40 | - | 87.80 | - | - | - | - | - | - |

| SRCF [24] | RN50 | BERT | 64.04 | 82.99 | 88.81 | 57.18 | 75.01 | 81.49 | - | - | - |

| LGUR [22] | RN50 | BERT | 64.21 | 81.94 | 87.93 | 57.42 | 74.97 | 81.45 | - | - | - |

| TIPCB [3] | RN50 | BERT | 64.26 | 83.19 | 89.10 | - | - | - | - | - | - |

| CAIBC [27] | RN50 | BERT | 64.43 | 82.87 | 88.37 | - | - | - | 47.35 | 69.55 | 79.00 |

| SAF [12] | ViT-B/16 | BERT | 64.13 | 82.62 | 88.40 | - | - | - | - | - | - |

| IVT [23] | ViT-B/16 | BERT | 65.59 | 83.11 | 89.21 | 56.04 | 73.60 | 80.22 | 46.70 | 70.00 | 78.80 |

| CFine [32] | CLIP-ViT-B/16 | BERT | 69.57 | 85.93 | 91.15 | 60.83 | 75.55 | 82.42 | 50.55 | 72.50 | 81.60 |

| IRRA [8] | CLIP-ViT-B/16 | CLIP-Xformer | 73.38 | 89.93 | 93.71 | 63.46 | 80.24 | 85.82 | 60.20 | 81.30 | 88.20 |

| Ours | CLIP-ViT-B/16 | CLIP-Xformer | 75.28 | 90.42 | 94.12 | 65.76 | 81.39 | 86.73 | 61.80 | 82.85 | 89.45 |

state of the art인 IRRA [8]의 R@1 성능을 각각 1.9%p, 2.3%p, 1.6%p라는 큰 폭으로 향상시킨다. IRRA는 각 modality의 global embedding을 정렬하는 데에만 초점을 맞추기 때문에, fine-grained한 차이를 포착하기 어렵다. 이와 대조적으로, 우리의 방법은 global embedding뿐만 아니라 각 modality에서 discriminative한 part embedding을 발견하고 정렬하는 것을 목표로 한다. 이는 모델이 대상 인물을 효과적으로 찾아낼 수 있도록 돕는다.

4.3 Qualitative Results

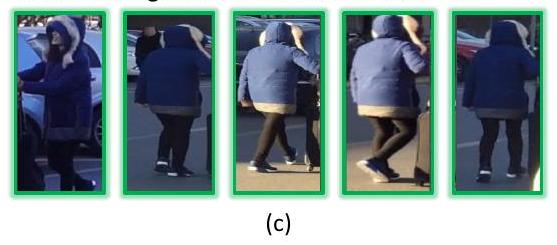

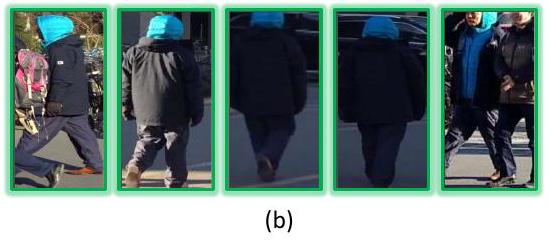

검색 결과: CUHK-PEDES 데이터셋에 대한 우리 방법의 Top-5 검색 결과는 Fig. 3에 나타나 있다. 전반적으로 만족스러운 검색 결과를 보여준다. 특히, 우리 모델은 작거나 다양한 위치에 있는 특징적인 신체 부위에 대해서도 대상을 잘 검색함을 확인할 수 있다. 예를 들어, Fig. 3(a)의 "ponytails"와 "high skirts", Fig. 3(b)의 "black shoes", Fig. 3(c)의 "blue plaid shorts"와 같은 작고 특징적인 신체 부위뿐만 아니라, Fig. 3(a)의 "yellow shoulder bags", Fig. 3(b)의 "floaty dresses", Fig. 3(d)의 "red backpacks"와 같이 다양한 시점에서 나타날 수 있는 신체 부위에 대해서도 잘 검색한다. CUHK-PEDES 데이터셋은 일반적으로 검색 공간에 평균 3개의 대상 이미지를 포함하므로, 그림에서 관찰되는 대부분의 오탐(false matches)은 추가 대상의 부족으로 인해 발생한다. 데이터셋의 한계로 인한 오탐에도 불구하고, 검색된 오탐이 쿼리 설명에 의해 묘사된 특징적인 신체 부위를 포함한다는 점에서 검색 결과는 합리적이다.

PSABlock 내 Attention Map 시각화: 우리의 part discovery module의 효과를 입증하기 위해, 시각 및 텍스트 양식(modality) 모두에 대해 PSA block의 -번째 iteration에서 attention map (Eq. (2) 참조)를 시각화하였다. 시각화 결과는 Fig. 4에 나타나 있다. 이는 우리 part discovery module에 의해 추출된 part embedding이 특징적인 신체 부위를 포착할 뿐만 아니라, 동일한 part slot에서 추출된 part embedding이 양식에 관계없이 의미적으로 동일한 신체 부위에 attend함을 보여준다. 예를 들어, 1번째 part slot은 일반적으로 하의에, 4번째는 신발에, 5번째는 들고 있는 물건에, 7번째는 상의에, 8번째는 사람의 머리에 초점을 맞춘다. 또한, Fig. 4의 시각 양식 (a)와 (b)를 비교하면, 우리 part discovery module은 포즈 변화 및 시점 변화에 강건하면서도 특징적인 신체 부위를 포착할 수 있음을 알 수 있다.

Fig. 3: CUHK-PEDES 데이터셋에 대한 우리 방법의 Top-5 검색 결과. 이미지는 각 텍스트 쿼리 아래에 있는 순위에 따라 왼쪽에서 오른쪽으로 정렬되어 있다. 녹색 상자는 정탐(true matches)을, 빨간색 상자는 오탐(false matches)을 나타낸다.

Fig. 3: CUHK-PEDES 데이터셋에 대한 우리 방법의 Top-5 검색 결과. 이미지는 각 텍스트 쿼리 아래에 있는 순위에 따라 왼쪽에서 오른쪽으로 정렬되어 있다. 녹색 상자는 정탐(true matches)을, 빨간색 상자는 오탐(false matches)을 나타낸다.

TDPA 시각화: TDPA를 사용한 두 양식의 part embedding 간 유사도 집계의 효과를 입증하기 위해 Eq. (6)의 TDPA 가중치 를 시각화하였다. 시각화 결과는 Fig. 4(a, b)의 왼쪽 하단에 각각 제시되어 있다. 예시 (a)와 (b)를 비교하면, 5번째 part slot은 일반적으로 가방과 같이 들고 있는 물건과 관련된 신체 부위에 초점을 맞추는데, (b)의 쿼리 설명에는 그러한 특징적인 정보가 없으므로 이 part slot에 대한 TDPA 가중치가 낮게 예측된다. 그러나 (b)의 쿼리 설명에 "hat"이 존재하기 때문에, 일반적으로 사람의 머리 부분에 초점을 맞추는 8번째 part slot에 대해 높은 TDPA 가중치를 갖게 된다. 이와 대조적으로, (a)의 쿼리 설명에는 이와 관련된 사람의 머리 부분 정보가 제공되지 않으므로, (a)의 8번째 part slot에 대한 TDPA 가중치는 낮은 값으로 예측된다. 이러한 관찰은 텍스트 쿼리의 내용에 따라 part 기반 검색을 적응적으로 개선하는 TDPA의 능력을 강조한다.

4.4 Ablation Studies

CUHK-PEDES 데이터셋에서 수행된 ablation study에서는 텍스트 기반 인물 검색 성능 향상에 기여하는 제안된 구성 요소 및 그 조합의 효과를 평가한다.

Fig. 4: CUHK-PEDES 데이터셋에서 PSA 블록의 -번째 iteration에서의 각 modality의 attention map 와 TDPA 가중치 의 시각화.

Fig. 4: CUHK-PEDES 데이터셋에서 PSA 블록의 -번째 iteration에서의 각 modality의 attention map 와 TDPA 가중치 의 시각화.

Table 2에서 여러 구성을 비교한다: Baseline 방법은 InfoNCE () loss로 학습된 global embedding g만을 사용한다. cross-modal masked language modeling ()을 통합하면 모든 지표에서 약간의 개선이 나타난다. 없이 part embedding 를 추가하는 것만으로도 R@1과 R@5에서 각각 3.46%p와 2.64%p의 상당한 향상을 보인다. 특히, 를 포함한 전체 구성이 가장 좋은 성능을 달성하며, 이는 정확한 텍스트 기반 인물 검색을 위한 part embedding의 중요성을 강조한다. 이는 우리의 part embedding이 텍스트 기반 인물 검색에 중요한 미세한(fine-grained) 세부 정보를 구별하는 데 크게 기여함을 시사한다. 또한, TDPA의 효과와 다른 ablation study 결과는 더 포괄적인 분석을 위해 보충 자료의 Table B에 제시되어 있다.

Table 2: CUHK-PEDES 데이터셋에 대한 Ablation study.

| Method | Loss | CUHK-PEDES | ||||||

|---|---|---|---|---|---|---|---|---|

| R@1 | R@5 | R@10 | ||||||

| Global Only | 71.39 (+0.0) | 92.74 (+0.0) | ||||||

| 71.83 (+0.44) | 92.58 (-0.16) | |||||||

| + CMLM | 72.65 (+1.26) | |||||||

| + Part Embeddings | 74.85 (+3.46) | |||||||

| 75.28 (+3.89) | 90.42 (+2.77) | 94.12 (+1.38) |

Part Discovery 방법에 대한 Ablation Study: 제안된 part discovery 모듈의 효과를 검증하기 위해, 우리의 part discovery 모듈을 TIPCB [3] 및 PAT [16]와 같은 다른 방법으로 대체하여 실험을 수행한다. TIPCB는 전체 이미지를 동일한 수평으로 잘라 이미지 part embedding을 추출하고, 각 이미지 part에 대해 추가적인 학습 가능한 MLP를 사용하여 텍스트 modality의 global embedding을 해당 part로 변환하는 간단하면서도 효과적인 휴리스틱 part discovery 방법이다. PAT는 학습 가능한 query와 기존의 cross-attention을 활용하여 querying Transformer 접근 방식으로 part discovery를 수행한다. 우리의 방법과 PAT의 주요 차이점은, 우리의 방법은 part slot들이 입력 데이터를 집계하기 위해 서로 경쟁하므로, 발견된 part들이 공간적으로 분리되도록 명시적으로 장려한다는 점이다. 반면, 기존 cross-attention 기반의 PAT가 찾는 part들은 종종 salient region을 과도하게 포착하여 미세한 세부 정보를 놓칠 가능성이 있다. 이러한 한계를 보여주기 위해, 보충 자료의 Fig. E에서 PAT를 우리 모델에 적용한 part attention 시각화를 제시한다. Table 3에서 알 수 있듯이, 우리의 part discovery 방법은 이러한 휴리스틱 및 기존 cross-attention 기반 part discovery 방법들보다 모든 지표에서 우수한 성능을 보이며, 특히 인간 part의 정밀한 식별이 요구되는 R@1 지표에서 가장 큰 차이를 보인다.

Table 3: CUHK-PEDES에서 다양한 part discovery 방법에 대한 Ablation study.

| Methods | R@1 | R@5 | R@10 |

|---|---|---|---|

| Ours + TIPCB [3] | 73.23 | 89.10 | 94.04 |

| Ours + PAT [16] | 72.76 | 89.23 | 93.42 |

| Ours |

5 Conclusion

우리는 part-level supervision 없이 part discovery module을 통해 시각 및 텍스트 모달리티 전반에 걸쳐 특징적인 인간 신체 부위를 추출하는 새로운 프레임워크를 제안했다. 도입된 TDPA는 텍스트 쿼리 내용에 따라 각 part slot의 중요도를 조절함으로써 검색 프로세스를 더욱 정교하게 만들고, 결과적으로 더욱 정확하고 관련성 높은 검색을 가능하게 한다.

한계점 (Limitation): slot들이 전체 이미지와 텍스트를 차지하도록 학습되기 때문에, 일부 slot은 입력의 관련 없는 부분을 나타낼 수 있다. TDPA가 이 문제를 어느 정도 해결하지만, 더 명시적인 해결책은 우리 시스템을 더욱 향상시킬 것이다.

감사의 글 (Acknowledgement): 본 연구는 대한민국 과학기술정보통신부의 IITP 과제 및 NRF 과제(No.RS-2019-II191906 AI Graduate School Program (POSTECH); No.RS-2022-II220906)의 지원을 받아 수행되었다.

PLOT: Text-based Person Search with Part Slot Attention for Corresponding Part Discovery - Supplementary Materials -

이 보충 자료는 본 논문의 지면 제약으로 인해 생략되었던 보조 feature 재구성 손실 함수와 실험 결과를 제시한다. 먼저, Sec. A에서는 part discovery module을 위한 보조 feature 재구성 손실에 대해 설명한다. Sec. B에서는 reranking 기반의 텍스트 기반 인물 검색 방법인 Rasa [2]와의 비교 결과를 제공한다. Rasa는 텍스트 쿼리와 이미지 간의 유사도 점수를 계산하기 위해 classifier를 활용한다. 이후 Sec. C에서는 다른 유사도 집계 방법, PSA block에서의 GRU update 사용, part slot 개수 변화 등 우리 방법의 다양한 변형에 대한 추가 ablation study를 다룬다. 마지막으로 Sec. D에서는 추가적인 정성적 결과를 제시한다. 또한, 우리는 우리 방법과 실험 평가에 관련된 모든 코드를 공개할 것을 약속한다.

A Feature Reconstruction for Part Discovery

우리의 part discovery module을 학습시키기 위해, **object-centric learning 방법 [17]에서 영감을 받아 재구성(reconstruction)을 위한 보조 손실(auxiliary loss)**을 활용한다. 일련의 part slot들이 원본 입력 데이터를 재구성할 수 있다면, 이는 각 slot이 입력 내의 고유한 부분 개체(part entities)와 연관되어 있음을 시사한다. 효율적인 재구성을 위해, 우리는 원시 입력 데이터를 직접 재구성하는 대신 feature space에서 재구성을 수행한다. 즉, 각 입력 모달리티에 대한 backbone의 출력, 즉 patch token 와 text token 를 재구성한다. 이를 위해 다음과 같이 공식화된 **재구성 손실 **을 활용한다:

여기서 는 각 모달리티에 대한 part discovery module의 출력인 part embedding을 나타내며, 는 각 모달리티에서 재구성을 위해 사용되는 decoder이다. decoder 는 slot attention [17]에서 사용된 spatial broadcast decoder [28]의 구조를 따른다. 이 decoder는 part embedding을 입력으로 받아, 재구성 대상 token 수에 해당하는 만큼 각 part embedding을 복제한다. 그 다음, 복제된 part embedding에 학습 가능한 positional embedding이 추가된다. 마지막으로, 이렇게 강화된 part embedding들은 ReLU 활성화 함수를 가진 multi-layer perceptron (MLP)에 입력되어, 복제된 위치에서 각 part embedding에 대한 target token과 aggregation weight를 예측함으로써 part embedding 전반에 걸쳐 집계된 재구성 feature를 얻는다.

Table A: CUHK-PEDES 및 ICFG-PEDES 데이터셋에 대한 RaSa [2]와의 비교.

| Methods | CUHK-PEDES | ICFG-PEDES | RSTPReid | |||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| R@1 | R@5 | R@10 | Time(s) | R@1 | R@5 | R@10 | Time(s) | R@1 | R@5 | R@10 | Time(s) | |

| RaSa [2] | 76.51 | 90.29 | 94.25 | 1168 | 65.28 | 80.40 | 85.12 | 3871 | 66.90 | 86.50 | 91.35 | 388 |

| Ours | 75.28 | 90.42 | 94.12 | 16 | 65.76 | 81.39 | 86.73 | 91 | 61.80 | 82.85 | 89.45 | 5 |

B Comparison to Recent Work

RaSa [2]는 가장 최근의 텍스트 기반 인물 검색(person search) 방법 중 하나로, 사전학습된 ALBEF [11] 모델을 backbone으로 채택한다. 추론 시 RaSa는 먼저 쿼리 텍스트와 이미지 간의 global embedding을 사용하여 코사인 유사도를 계산한 다음, **쿼리당 상위 k개의 이미지를 재순위화(re-rank)**한다. 재순위화 과정에서는 추가적인 Transformer 기반 모델을 사용하여 각 쿼리 텍스트와 해당 상위 k개 이미지 간의 cross-attention을 계산한다. 그런 다음, Transformer의 출력인 cross-attention을 통해 얻은 cross-attended feature는 쿼리와 이미지 쌍의 매칭 점수를 예측하는 classifier에 입력된다. 재순위화 과정이 검색 정확도를 향상시키지만, 추가적인 Transformer feedforward pass의 필요성은 추론 시 상당한 계산 부하를 추가한다. Table A에서 우리는 제안된 방법과 RaSa를 Recall@K 및 추론 지연 시간(latency) 측면에서 비교한다. 결과는 우리 방법이 Recall@K 지표에서 RaSa의 성능을 유지하거나 능가하면서도 추론 시간이 최소 40배 더 빠르다는 것을 보여준다.

C More Ablation Studies

Part Similarity Aggregations에 대한 Ablation Study: part embedding의 유사도 aggregation을 위한 우리의 TDPA의 효과를 입증하기 위해, 우리는 대체 aggregation 접근 방식과 비교 실험을 수행한다. Table B(a)에서 보여주듯이, Cumulative Sum은 모든 part embedding에 걸쳐 유사도를 단순히 합산하는 유사도 aggregation 접근 방식이다. 이 접근 방식은 특히 R@1 metric에 영향을 미치며, 비정보적인 요소의 포함으로 인해 필연적으로 성능 저하를 초래한다. 따라서 우리의 TDPA 방법은 각 텍스트 쿼리에 대해 중요한 part slot을 동적으로 조정함으로써 검색 성능 향상에 크게 기여한다.

PSA 블록에 GRU 채택의 이점: PSA 블록 내에서 GRU는 각 업데이트에 대해 이전 part slot의 정보 사용에 대한 학습 기반 결정을 용이하게 한다. Table B(b)의 ablation study는 GRU가 성능에 기여함을 경험적으로 보여준다.

part slot 수의 영향: Table B(c)는 입력 데이터를 고유한 부분으로 분할하기에 충분한 part slot이 있을 때 성능이 향상됨을 보여준다. 그러나 입력 데이터의 고유한 부분보다 더 많은 part slot이 제공되면, 이는 상당한 이점을 제공하지 않는다.

Table B: CUHK-PEDES 데이터셋에 대한 Ablation study.

| Methods | |||

|---|---|---|---|

| (a) Cumulative Sum | 73.96 | 89.73 | 93.84 |

| (b) Ours w/o GRU | 74.33 | 89.49 | 93.52 |

| Ours w/ 4 part slots | 73.79 | 89.88 | 93.22 |

| (c) Ours w/ 6 part slots | 75.02 | 89.93 | 94.23 |

| Ours w/ 10 part slots | 74.51 | 90.21 | 94.56 |

| Ours | 75.28 | 90.42 | 94.12 |

D More Qualitative Results

Fig. A는 CUHK-PEDES 데이터셋에서 PSA block의 -번째 iteration에서 **두 modality에 대한 attention map **와 **TDPA 가중치 **의 시각화를 보여준다.

제시된 대부분의 결과는 우리의 part discovery module이 추출한 part embedding이 사람의 특징적인 부분들을 잘 포착하고 있음을 입증한다.

더 나아가, 동일한 part slot에서 추출된 part embedding이 서로 다른 modality에서 계산되었음에도 불구하고 동일한 부분을 나타냄을 보여준다.

또한, TDPA의 효과를 확인할 수 있는데, 이는 쿼리 텍스트에 제시된 특징적인 사람 부분에 더 집중함으로써 적응형 part-based retrieval을 가능하게 한다 (Fig. A(a,b,c,e)).

이 외에도 TDPA는 slot attention의 한계점을 해결한다. slot attention의 상호 배타적인(mutually exclusive) 특성 때문에, 해당 part가 존재하지 않을 경우 slot이 관련 없는 영역에 attention을 집중할 수 있다. 예를 들어, Part 4는 의미론적으로 신발 영역에 해당하지만, Fig. A(b)와 Fig. A(h)에는 신발이 없으므로, 해당 slot은 대신 관련 없는 영역에 attention을 집중한다. 그러나 이러한 한계를 해결하기 위해 TDPA는 신발이 제시되지 않은 경우 Part 4에 낮은 가중치를 할당한다.

또한, Fig. B, Fig. C, Fig. D에는 각각 세 가지 데이터셋에 대한 우리 방법의 top-5 retrieval 결과가 제시되어 있다.

제시된 대부분의 결과는 우리 방법이 목표 인물을 성공적으로 검색함을 보여준다. 우리는 장애물이나 사람 자세의 변화가 있는 경우에도 일관된 retrieval 결과를 관찰한다.

오류 매칭(false matches)의 retrieval 결과에서는, 검색된 이미지가 다른 true match와 매우 유사하거나 (Fig. B(e) 및 Fig. D(h)), 또는 텍스트 쿼리에 설명된 특징적인 사람 부분을 포함하고 있다 (Fig. C(g) 및 Fig. D(f)).

Fig. A: CUHK-PEDES 데이터셋에서 PSA block의 -번째 iteration에서 **각 modality의 attention map **와 **TDPA 가중치 **의 시각화.

Fig. A: CUHK-PEDES 데이터셋에서 PSA block의 -번째 iteration에서 **각 modality의 attention map **와 **TDPA 가중치 **의 시각화.

Query: a woman has a ponytail swinging to the left held with a white hairband while she holds a white document in her left hand. she wears a gray jacket with wide hood curved over her back, a blouse hem covering her hips, deep-blue pants ending below the knees and white shoes with black trim.

(a)

(a)

Query: the woman is wearing a white tee shirt and patterned capri pants. she is wearing black and white shoes, and had dark hair. she appears to be carrying a red object in her left hand.

(c)

(c)

Query: this women is wearing a red coat with white trim at the wrists and neck. she appears to be wearing black tights or skinny jeans and black flat shoes. she has her black hair in a ponytail and is talking on the phone that she holds in her left hand.

(e)

(e)

Query: she is wearing short, blue jean shorts, a vnecked halter top, and a dark jacket. she is holding a wine glass in both hands.

(g)

(g)

Query: a woman with a ponytail looks slightly to her right, has her right arm at her side, carries a black shoulder bag over her left shoulder and behind her hand, and steps forward with her right foot. she wears a white t - shirt with black lines drawn over the front, a denim miniskirt and white running shoes.

(b)

(b)

Query: person wearing a dark brown sweater, denim cropped pants that go just below the knees, and white sneakers. they are wearing a red backpack over both

(d)

(d)

Query: the lady is wearing a black short sleeve tshirt with a colorful print on the front in the shape of a square. she is wearing dark capri pants and light colored shoes.

(f)

(f)

Query: too blurry to describe but it looks like a white female wearing a black jacket (open) with a white top and dark colored skirt or dark capri pants and black shoes.

(h)

(h)

Fig. B: CUHK-PEDES 데이터셋에 대한 우리 방법의 Top-5 retrieval 결과. 이미지는 각 텍스트 쿼리 아래에 랭크에 따라 왼쪽에서 오른쪽으로 정렬되어 있다. 녹색 상자는 true match를, 빨간색 상자는 false match를 나타낸다.

Query: a young man wearing a dark grey color jacket with hood and light grey color pant with red color strips with sky blue color sneakers. he is carrying a red, brown and grey color backpack on his back.

(a)

(a)

Query: a young woman is wearing a long blue and grey insulated jacket with white fur on the hood and black leggings. she is also wearing black running shoes which have white soles.

Query: a woman with straight shoulder length brown hair is wearing a long black puffer jacket. she is wearing black tights and ankle-length yellow boots. she is carrying a pink bag on her shoulder.

(e)

(e)

Query: a man in his mid 30's having short hair with receding hairline and wearing spectacles. he is wearing an army color puffer jacket and black formal pants.

(g)

(g)

Query: a man in his forties with short black hair is wearing a royal blue hooded jacket with white trousers. he is wearing off white running shoes with grey soles. he has a grey and black bag around his shoulder. he has his hands in his jacket's pocket.

(b)

(b)

Query: a lady in her late twenties with long black kurta over yellow hoodie jacket and black jeans. she is wearing white sneakers shoes and holding white handbag.

Query: a young boy us wearing a black insulated vest over a full-sleeved green and blue t-shirt with gray sweatpants. he is wearing black shoes with blue laces and is carrying a brown backpack.

(f)

(f)

Query: a middle-aged man with medium length black hair parted sideways is wearing a dark grey fleece coat with black buttons over blue-white striped polo. he has a black bag strap around his shoulders .

(h)

(h)

Fig. C: ICFG-PEDES 데이터셋에 대한 우리 방법의 Top-5 retrieval 결과. 이미지는 각 텍스트 쿼리 아래에 랭크에 따라 왼쪽에서 오른쪽으로 정렬되어 있다. 녹색 상자는 true match를, 빨간색 상자는 false match를 나타낸다.

Query: this female walker is wearing a long grey coat with fur collar and some white writing on it. she also wears a hat with zebra pattern and black pants. she carries a hand bag and something in her hand.

(a)

(a)

Query: the focus is on this man 's back and he wear a black and red jacket and loose grey pants with a bag over his shoulder.

(c)

(c)

Query: the focus is on this woman's back and she is covering her hair with jacket's hat as she wears a blue coat with grey edging and black tight pants with a luggage.

(e)

(e)

Query: the man is wearing a dark overcoat with the hood, a pair of black trousers and a pair of black shoes. and he is holding a black cellphone.

Fig. D: RSTPReid 데이터셋에 대한 우리 방법의 Top-5 retrieval 결과. 이미지는 각 텍스트 쿼리 아래에 랭크에 따라 왼쪽에서 오른쪽으로 정렬되어 있다. 녹색 상자는 true match를, 빨간색 상자는 false match를 나타낸다.

Fig. D: RSTPReid 데이터셋에 대한 우리 방법의 Top-5 retrieval 결과. 이미지는 각 텍스트 쿼리 아래에 랭크에 따라 왼쪽에서 오른쪽으로 정렬되어 있다. 녹색 상자는 true match를, 빨간색 상자는 false match를 나타낸다.

Query: the man with the bright blue hood is wearing a black overcoat and a piece of blue clothing inside. his pants are black while shoes are brown. and he is wearing a pair of dark gloves.

Query: the woman had a ponytail, a grey down jacket, beige trousers and black boots. she was carrying a light blue backpack. she's buttoning herself.

(d)

(d)

Query: the man was wearing a brown coat, black trousers and grey shoes. he was walking with a green backpack on his back.

(f)

(f)

Query: back of a female walker covering her head with her pink down jacket's hat. she is facing forward and seems like very cold.

Fig. E: PAT가 적용된 우리 방법의 part attention 시각화.

Fig. E: PAT가 적용된 우리 방법의 part attention 시각화.