LLaVA-OneVision: 이미지와 비디오를 넘나드는 손쉬운 시각 과제 전이

LLaVA-OneVision은 단일 모델로 단일 이미지, 다중 이미지, 비디오라는 세 가지 주요 컴퓨터 비전 시나리오에서 동시에 최고의 성능을 보이는 오픈소스 대규모 멀티모달 모델(LMM)입니다. 이 모델의 핵심은 서로 다른 양식(modality)과 시나리오 간의 강력한 transfer learning을 가능하게 하는 설계에 있으며, 특히 이미지에서 비디오로의 과제 전이(task transfer)를 통해 뛰어난 비디오 이해 능력과 같은 새로운 창발적 능력(emerging capabilities)을 보여줍니다. 논문 제목: LLaVA-OneVision: Easy Visual Task Transfer

Li, Bo, et al. "Llava-onevision: Easy visual task transfer." arXiv preprint arXiv:2408.03326 (2024).

LLaVA-OneVision: Easy Visual Task Transfer

Abstract

우리는 LLaVA-NeXT 블로그 시리즈에서 얻은 데이터, 모델, 시각 표현에 대한 통찰력을 통합하여 개발된 오픈 대규모 멀티모달 모델(LMM) 계열인 LLaVA-OneVision을 소개한다. 우리의 실험 결과는 LLaVA-OneVision이 단일 모델로서 세 가지 중요한 컴퓨터 비전 시나리오(단일 이미지, 다중 이미지, 비디오 시나리오)에서 오픈 LMM의 성능 한계를 동시에 확장할 수 있는 최초의 모델임을 입증한다. 중요하게도, LLaVA-OneVision의 설계는 서로 다른 모달리티/시나리오 간에 강력한 전이 학습(transfer learning)을 가능하게 하여 새로운 emergent capability를 이끌어낸다. 특히, 이미지에서 비디오로의 task transfer를 통해 강력한 비디오 이해 능력과 cross-scenario capability가 입증되었다.

1 Introduction

AI의 핵심적인 열망 중 하나는 Large Multimodal Models (LMM) [67]을 활용하여 범용 어시스턴트를 구축하는 것이다. LLaVA-OneVision은 오픈 모델로서, 다양한 지시를 따르고 실제 환경에서 다양한 컴퓨터 비전 task를 완료할 수 있는 대규모 vision-and-language assistant (LLaVA) [83]를 구축하는 연구 라인을 계속해서 발전시키고 있다. 비용 효율적인 방법으로, LLaVA는 일반적으로 vision encoder와 large language model (LLM)을 간단한 연결 모듈을 사용하여 연결함으로써 개발된다.

최초의 LLaVA 모델 [83]은 인상적인 멀티모달 채팅 능력을 보여주었으며, 때로는 이전에 보지 못한 이미지와 지시에 대해 GPT-4V와 유사한 행동을 처음으로 보이기도 했다. LLaVA-1.5 [81]는 더 많은 학술 관련 instruction 데이터를 통합하여 기능을 크게 확장하고 개선했으며, 데이터 효율적인 방식으로 수십 개의 벤치마크에서 SoTA 성능을 달성했다. LLaVA-NeXT [82]는 이러한 특성을 계승하여, 세 가지 핵심 기술을 통해 성능 한계를 더욱 확장했다: 고해상도 이미지를 처리하는 AnyRes, 고품질 instruction 데이터 확장, 그리고 당시 사용 가능한 최고의 오픈 LLM 활용.

LLaVA-NeXT는 확장 가능하고 확장성 있는 프로토타입을 제공하며, 이는 LLaVA-NeXT 블로그 시리즈 [82, 169, 65, 64, 68]에 보고된 여러 병렬 탐색을 용이하게 한다: https://llava-vl.github.io/blog/

- Video 블로그 [169]는 이미지로만 학습된 LLaVA-NeXT 모델이 AnyRes의 설계 덕분에 어떤 시각 신호든 이미지 시퀀스로 소화할 수 있어, zero-shot modality transfer를 통해 비디오 task에서 놀랍도록 강력한 성능을 보인다는 것을 보여준다.

- Stronger 블로그 [65]는 이 비용 효율적인 전략의 LLM 모델 스케일링 성공을 입증한다. 단순히 LLM을 확장함으로써, 선택된 벤치마크에서 GPT-4V에 필적하는 성능을 달성한다.

- Ablation 블로그 [64]는 시각적 instruction 데이터 자체를 제외한 우리의 경험적 탐색을 요약한다. 여기에는 아키텍처 선택 (LLM 및 vision encoder의 스케일링), 시각적 표현 (해상도 및 토큰 수), 그리고 데이터 스케일링 성공을 위한 학습 전략 (학습 가능한 모듈 및 고품질 데이터) 등이 포함된다.

- Interleave 블로그 [68]는 단일 이미지 성능을 유지하면서 멀티 이미지, 멀티 프레임 (비디오), 멀티 뷰 (3D)를 포함한 새로운 시나리오에서 기능을 확장하고 개선하는 전략을 설명한다.

이러한 탐색은 고정된 연산 예산 내에서 수행되었으며, 성능 한계를 뛰어넘기보다는 프로젝트를 진행하면서 유용한 통찰력을 제공하는 것을 목표로 했다. 이 과정에서 우리는 1월부터 6월까지 대규모 고품질 데이터셋을 축적하고 큐레이션해왔다. 이러한 통찰력을 통합하고 새로 축적된 대규모 데이터셋에 대해 "yolo run"으로 실험을 실행함으로써, 우리는 LLaVA-OneVision을 소개한다. 우리는 개별 구성 요소의 위험을 광범위하게 줄이지 않고 사용 가능한 연산 자원으로 새 모델을 구현했다. 이는 우리의 방식을 따라 추가 데이터 및 모델 스케일링을 통해 기능 개선의 여지를 남긴다. 자세한 개발 타임라인은 Section A를 참조하라. 특히, 본 논문은 다음과 같은 기여를 한다:

- Large multimodal models. 우리는 LLaVA-OneVision을 개발했다. 이는 단일 이미지, 멀티 이미지, 비디오 시나리오를 포함한 세 가지 중요한 비전 설정에서 오픈 LMM의 성능 한계를 개선하는 오픈 대규모 멀티모달 모델(LMM) 계열이다.

- Task Transfer를 통한 새로운 기능. 모델링 및 데이터 표현에 대한 우리의 설계는 다양한 시나리오 간의 task transfer를 허용하여, 새로운 emergent capability를 생성하는 간단한 접근 방식을 제시한다. 특히, LLaVA-OneVision은 이미지로부터의 task transfer를 통해 강력한 비디오 이해 능력을 보여준다.

- 오픈 소스. 범용 시각 어시스턴트 구축을 위한 길을 열기 위해, 우리는 다음 자산들을 공개한다: 생성된 멀티모달 instruction 데이터, 코드베이스, 모델 체크포인트, 그리고 시각 채팅 데모.

2 Related Work

GPT-4V [109], GPT-4o [110], Gemini [131], Claude-3.5 [3]와 같은 SoTA proprietary LMM들은 단일 이미지, 다중 이미지, 비디오 설정 등 다양한 비전 시나리오에서 뛰어난 성능을 보여준다. 반면, 오픈 연구 커뮤니티에서는 기존 연구들이 일반적으로 각 개별 시나리오에 맞춰 모델을 따로 개발하는 경향이 있다. 특히, 대부분의 연구는 단일 이미지 시나리오에서 성능 한계를 높이는 데 집중하며 [26, 83, 173, 73, 164, 35], 최근에야 소수의 논문들이 다중 이미지 시나리오를 탐구하기 시작했다 [70, 47]. 비디오 LMM은 비디오 이해에서 탁월한 성능을 보이지만, 종종 이미지 성능을 희생하는 대가로 이루어지는 경우가 많다 [72, 76]. 이 세 가지 시나리오 모두에서 뛰어난 성능을 보고하는 단일 오픈 모델은 드물다. LLaVA-OneVision은 이러한 격차를 해소하기 위해 광범위한 task에서 state-of-the-art 성능을 입증하고, 시나리오 간 task 전이(transfer) 및 조합을 통해 흥미로운 새로운 기능들을 선보이는 것을 목표로 한다.

우리가 아는 한, LLaVA-NeXT-Interleave [68]는 이 세 가지 시나리오 모두에서 좋은 성능을 보고하려는 첫 시도였으며, LLaVA-OneVision은 향상된 성능을 위해 해당 모델의 학습 방식과 데이터를 계승한다. 뛰어난 성능을 보일 잠재력이 있는 다른 다재다능한 오픈 LMM으로는 VILA [77], InternLM-XComposer-2.5 [162] 등이 있다. 아쉽게도 이들의 결과는 완전히 평가 및 보고되지 않았으며, 우리는 실험에서 이들과 비교한다. LLaVA-OneVision은 다재다능한 기능을 갖춘 시스템을 구축하는 것 외에도, 모델이 합성한 지식(model-synthesized knowledge)과 새롭게 수집된 다양한 instruction tuning 데이터를 포함한 대규모 고품질 데이터 학습의 이점을 얻는다. 전자의 경우, 우리는 [64]의 모든 지식 학습 데이터를 계승한다. 후자의 경우, 우리는 FLAN [136, 88, 145]에서 영감을 받았다. 데이터 수집 과정은 Idefics2 [63] 및 Cambrian-1 [133]과 동시에 진행되었지만, 우리는 더 작지만 더 신중하게 선별된 데이터셋 컬렉션에 집중한다. 유사한 결론이 관찰되었다: 대량의 visual instruction tuning 데이터는 성능을 크게 향상시킬 수 있다. LMM의 설계 선택에 대한 포괄적인 조사를 위해서는 최근의 여러 연구들 [51, 63, 64, 104, 133, 10]을 참조한다.

Figure 1: LLaVA-OneVision 네트워크 아키텍처.

왼쪽: 현재 모델 구현;

오른쪽: [83]의 LLaVA 아키텍처의 일반적인 형태이지만, 더 많은 시각 신호를 지원하도록 확장되었다.

Figure 1: LLaVA-OneVision 네트워크 아키텍처.

왼쪽: 현재 모델 구현;

오른쪽: [83]의 LLaVA 아키텍처의 일반적인 형태이지만, 더 많은 시각 신호를 지원하도록 확장되었다.

3 Modeling

3.1 Network Architecture

모델 아키텍처는 LLaVA 시리즈의 미니멀리즘 디자인을 계승하며, 주요 목표는 (i) LLM과 visual model의 사전학습된 능력을 효과적으로 활용하고, (ii) 데이터와 모델 측면에서 강력한 스케일링 동작을 촉진하는 것이다. 네트워크 아키텍처는 Figure 1에 설명되어 있다.

- LLM: 우리는 파라미터 로 표현되는 LLM 으로 Qwen-2 [148]를 선택했다. Qwen-2는 다양한 모델 크기를 제공하며, 현재 공개된 체크포인트 중 강력한 언어 능력을 보여준다.

- Vision Encoder: 우리는 파라미터 로 표현되는 visual encoder 로 SigLIP [158]을 고려한다. 이는 입력 이미지 를 시각 feature 로 인코딩한다. 실험에서는 마지막 Transformer layer 이전과 이후의 grid feature를 모두 고려한다.

- Projector: 우리는 파라미터 로 표현되는 2-layer MLP [81] 를 고려한다. 이는 이미지 feature를 단어 임베딩 공간으로 투영하여 시각 토큰 시퀀스 를 생성한다.

이러한 모델 선택은 더 강력한 LLM이 일반적으로 더 강력한 멀티모달 능력을 이끌어내며, SigLIP이 공개된 vision encoder 중 더 높은 LMM 성능을 제공한다는 우리의 경험적 통찰 [65, 64]에 기반한다.

길이 의 시퀀스에 대해, 우리는 타겟 답변 의 확률을 다음과 같이 계산한다:

여기서 와 는 현재 예측 토큰 이전의 모든 턴(turn)에 대한 instruction 및 답변 토큰을 각각 나타낸다. (1)의 조건부 확률에서 를 명시적으로 추가한 것은 시각 신호가 모든 답변에 대해 grounding된다는 사실을 강조하기 위함이다. Section 3.2에서 설명했듯이, 시각 신호 의 형태는 일반적이다. vision encoder에 입력되는 시각 입력은 해당 시나리오에 따라 달라진다: 단일 이미지 시퀀스에서는 개별 이미지 crop, 다중 이미지 시퀀스에서는 개별 이미지, 비디오 시퀀스에서는 개별 프레임이 각각 입력된다.

3.2 Visual Representations

시각 신호의 표현은 시각 인코딩(visual encoding)의 성공에 핵심적인 요소이다. 이는 **원시 픽셀 공간에서의 해상도(resolution)**와 **feature 공간에서의 토큰 수(#token)**라는 두 가지 요소와 관련되며, 이는 **시각 입력 표현 구성(resolution, #token)**으로 이어진다. 두 요소 모두를 확장하면, 특히 시각적 세부 사항을 요구하는 task에서 성능이 향상된다. 성능과 비용의 균형을 맞추기 위해, 우리는 해상도 확장이 토큰 수 확장보다 더 효과적이라는 것을 관찰했으며, pooling을 포함한 AnyRes 전략을 권장한다. 이러한 비교는 Figure 2에 설명되어 있다.

Figure 2: 시각적 표현. 상단: 고해상도 이미지를 처리하기 위한 Bilinear Interpolation을 사용한 새로운 Higher AnyRes 방식; 하단: [82]의 오리지널 AnyRes.

Figure 2: 시각적 표현. 상단: 고해상도 이미지를 처리하기 위한 Bilinear Interpolation을 사용한 새로운 Higher AnyRes 방식; 하단: [82]의 오리지널 AnyRes.

Figure 3: LLaVA-OneVision에서 각 시나리오에 토큰을 할당하는 시각적 표현 전략. 다양한 시나리오에 걸쳐 최대 visual token 수는 유사하게 설계되어, 시나리오 간의 능력 전이(capability transfer)를 수용하기 위한 균형 잡힌 시각적 표현을 보장한다. 729는 SigLIP이 해상도의 시각 입력을 인코딩하는 데 필요한 #tokens이다.

Figure 3: LLaVA-OneVision에서 각 시나리오에 토큰을 할당하는 시각적 표현 전략. 다양한 시나리오에 걸쳐 최대 visual token 수는 유사하게 설계되어, 시나리오 간의 능력 전이(capability transfer)를 수용하기 위한 균형 잡힌 시각적 표현을 보장한다. 729는 SigLIP이 해상도의 시각 입력을 인코딩하는 데 필요한 #tokens이다.

너비 , 높이 의 구성을 가진 AnyRes는 이미지를 개의 crop으로 나누며, 각 crop은 형태를 가진다. 각 crop은 vision encoder에 적합한 동일한 해상도를 갖는다. crop당 개의 토큰이 있다고 가정하면, 총 visual token 수는 이며, 여기서 기본 이미지는 vision encoder에 입력되기 전에 크기가 조정된다. 우리는 임계값 를 고려하고, 필요한 경우 bilinear interpolation을 사용하여 crop당 #token을 줄인다:

다양한 이미지 자르기(cropping) 방법을 지정하여 다양한 해상도와 종횡비의 이미지를 수용하기 위해 공간 구성 세트가 정의된다. 이 중에서 최소한의 crop 수를 요구하는 구성이 선택된다. 시각적 표현에 대한 자세한 ablation은 [64]를 참조하라.

제안된 Higher AnyRes 전략은 다중 이미지 및 비디오 표현에 적합한 유연한 시각적 표현 프레임워크로 활용될 수 있다. 성능과 비용에 대한 최적의 구성은 그에 따라 조정될 수 있다. 우리는 Figure 3에서 구성을 설명하고, Section C.1에서 자세한 내용을 기술하며, 아래와 같이 높은 수준의 인코딩 전략을 제공한다:

- 단일 이미지(Single-image). 우리는 **단일 이미지 표현을 위해 큰 최대 공간 구성 **를 고려하여 이미지 크기 조정 없이 원본 해상도를 유지한다. 또한, 이미지당 많은 수의 visual token을 의도적으로 할당하여, 시각 신호를 효과적으로 표현하기 위한 긴 시퀀스를 생성한다. 이는 비디오에 비해 이미지에 대한 고품질 학습 샘플이 더 많고 다양한 지시를 포함한다는 관찰에 기반한다. 비디오 표현을 모방하는 긴 시퀀스로 이미지를 표현함으로써, 이미지에서 비디오 이해로의 능력 전이(capability transfer)를 더욱 원활하게 한다 [169, 64].

- 다중 이미지(Multi-image). 기본 이미지 해상도만 고려하여 vision encoder에 입력되어 feature map을 얻으며, 고해상도 이미지의 multi-crop이 필요 없어 계산 자원을 절약한다 [68].

- 비디오(Video). 비디오의 각 프레임은 기본 이미지 해상도로 크기가 조정되고 vision encoder에 의해 처리되어 feature map을 생성한다. Bilinear interpolation을 사용하여 토큰 수를 줄임으로써 프레임당 토큰 수를 줄여 더 많은 프레임을 고려할 수 있게 한다. 경험적 증거에 따르면 이는 성능과 계산 비용 사이에서 더 나은 trade-off를 제공한다 [169].

이러한 표현 구성은 우리 실험에서 고정된 계산 예산 내에서 능력 전이(capability transfer)를 위해 설계되었다. 계산 자원이 증가하면, 학습 및 추론 단계 모두에서 이미지 또는 프레임당 토큰 수를 늘려 성능을 향상시킬 수 있다.

4 Data

LLM 기반 멀티모달 학습 영역에서는 "양보다 질"이라는 원칙이 특히 중요하다. 이 원칙은 사전학습된 LLM과 Vision Transformer (ViT) 내에 저장된 방대한 지식 때문에 더욱 중요하게 작용한다. LMM의 학습 수명 주기(training lifecycle)가 끝날 때까지 균형 잡히고, 다양하며, 고품질의 instruction data를 축적하는 것이 필수적이지만, 종종 간과되는 측면은 모델이 새로운 고품질 데이터에 지속적으로 노출되어 추가적인 지식을 습득하도록 하는 것이다. 이 섹션에서는 고품질 지식 학습 및 visual instruction tuning을 위한 데이터 소스와 전략에 대해 논의한다.

4.1 High-Quality Knowledge

웹 규모의 공개 이미지-텍스트 데이터는 종종 품질이 낮아, 멀티모달 사전학습의 데이터 스케일링 효율성을 떨어뜨린다. 대신, 우리는 제한된 연산 예산 내에서 고품질 지식 학습(high-quality knowledge learning)에 집중할 것을 권장한다. 이 접근 방식은 사전학습된 LLM과 ViT가 이미 상당한 지식 기반을 가지고 있음을 인정하며, 목표는 신중하게 선별된 데이터로 이 지식을 정제하고 향상시키는 것이다. 데이터 품질을 우선시함으로써 연산 효율성을 극대화할 수 있다.

우리는 고품질 지식 학습을 위해 세 가지 주요 범주의 데이터를 고려한다:

- Re-Captioned Detailed Description Data: LLaVA-NeXT-34B [82]는 오픈소스 LMM 중에서도 강력한 상세 캡션 생성 능력으로 알려져 있다. 우리는 이 모델을 사용하여 COCO118K, BLIP558K, CC3M 데이터셋의 이미지에 대한 새로운 캡션을 생성했다. 이들을 결합하여 총 350만 개의 샘플로 구성된 Re-Captioned Detailed Description Data를 만들었다. 이는 초기 버전의 모델 자체가 학습 데이터를 생성하는 간단한 자기 개선(self-improvement) AI 시도로 볼 수 있다.

- Document / OCR Data: 우리는 UReader 데이터셋의 Text Reading 서브셋(총 10만 개)을 활용했는데, 이는 PDF 렌더링을 통해 쉽게 접근할 수 있다. 이 텍스트 읽기 데이터와 SynDOG EN/CN을 함께 사용하여 총 110만 개의 샘플로 구성된 Document / OCR Data를 만들었다.

- Chinese and Language Data: 우리는 원본 ShareGPT4V [20] 이미지를 사용하고, Azure API에서 제공하는 GPT-4V를 활용하여 9만 2천 개의 상세 중국어 캡션 데이터를 생성했다. 이는 모델의 중국어 능력 향상을 목표로 한다. 상세 캡션 데이터의 상당 부분을 사용했기 때문에, 모델의 언어 이해 능력 균형도 맞추고자 했다. 우리는 Evo-Instruct 데이터셋 [16]에서 14만 3천 개의 샘플을 수집했다.

흥미롭게도, 고품질 지식 데이터의 거의 전부(99.8%에 해당)가 **합성 데이터(synthetic data)**라는 점이다. 이는 대규모의 고품질 데이터를 실제 환경에서 수집하는 데 드는 높은 비용과 저작권 제약 때문이다. 반면, 합성 데이터는 쉽게 확장할 수 있다. 우리는 AI 모델이 계속해서 강력해짐에 따라 대규모 합성 데이터로부터 학습하는 것이 하나의 트렌드가 될 것이라고 믿는다.

4.2 Visual Instruction Tuning Data

Visual instruction tuning [83]은 LMM이 시각적 지시를 이해하고 그에 따라 행동하는 능력을 의미한다. 이러한 지시는 언어와 이미지, 비디오와 같은 시각 매체가 결합된 형태일 수 있으며, LMM은 이를 처리하고 따라 task를 수행하거나 응답을 제공한다. 이는 시각적 이해와 자연어 처리의 통합을 통해 지시를 해석하고 필요한 응답을 실행하는 과정을 포함한다.

데이터 수집 및 큐레이션 (Data Collection and Curation)

이전 연구들 [81, 133, 63]에서 입증되었듯이, visual instruction tuning 데이터는 LMM의 능력에 매우 중요하다. 따라서 고품질 데이터셋을 수집하고 유지하는 것은 커뮤니티에 필수적이며 유익하다. 우리는 다양한 원본 소스에서 대규모 instruction tuning 데이터셋 풀을 수집하기 시작했으며, 카테고리별로 데이터 비율이 불균형하게 분포되어 있었다. 또한, Cauldron [63] 및 Cambrian [133] 데이터셋 컬렉션에서 몇 가지 새로운 subset을 활용하였다.

우리는 데이터를 vision, instruction, response의 세 가지 계층 구조를 기반으로 분류한다.

- Vision Input: 멀티모달 시퀀스에서 어떤 시각 입력이 고려되는지에 따라 **단일 이미지(single-image), 다중 이미지(multi-image), 비디오(video)**를 포함한 세 가지 시각 시나리오를 고려한다.

- Language Instruction: 종종 질문 형태로 나타나는 instruction은 시각 입력을 처리하기 위해 수행해야 할 task를 정의한다. 우리는 데이터를 General QA, General OCR, Doc/Chart/Screen, Math Reasoning, Language의 다섯 가지 주요 카테고리로 분류한다. 이러한 instruction은 학습된 LMM이 다룰 수 있는 기술 세트를 정의한다. 우리는 task 분류를 사용하여 기술 분포를 유지하고 균형을 맞추는 데 도움을 받는다.

- Language Response: 답변은 사용자 요청에 응답할 뿐만 아니라 모델의 행동을 명시한다. 이는 크게 **자유 형식(free-form)과 고정 형식(fixed-form)**으로 분류할 수 있다.

자유 형식 데이터는 일반적으로 GPT-4V/o 및 Gemini와 같은 고급 모델에 의해 주석되며, 고정 형식 데이터는 VQAv2, GQA, Visual Genome과 같은 학술 데이터셋에서 파생된다. 자유 형식 데이터의 경우 원본 답변을 유지한다. 그러나 고정 형식 데이터의 경우 내용을 수동으로 검토하고 질문 및 답변 형식에 필요한 수정을 가한다. 우리는 객관식 데이터, 짧은 답변 데이터, 특정 task 데이터(예: OCR)에 대해 LLaVA-1.5 prompting 전략을 준수한다. 이 단계는 모델의 행동을 안내하여 QA 성능, 대화 능력, 그리고 더 복잡한 task에서의 추론 기술 간의 균형을 올바르게 맞추고, 다른 데이터 소스에서 발생할 수 있는 잠재적 충돌을 방지하는 데 중요하다. 우리는 수집된 각 데이터셋에 대한 전체 세부 정보와 그 분류 및 형식화 prompt를 Appendix E.3에 나열한다.

우리는 instruction 데이터를 단일 이미지 시나리오를 위한 그룹과 모든 시각 시나리오를 위한 그룹의 두 가지 별도 그룹으로 나눈다. 이러한 구분은 이미지 및 비디오 모델 간의 관계를 강조하는 초기 연구 [68, 169]의 통찰력에 기반한다: 더 강력한 이미지 모델은 다중 이미지 및 비디오 task로 더 잘 전이될 수 있다. 또한, 단일 이미지에 사용할 수 있는 학습 데이터셋의 양과 품질은 비디오 및 다중 이미지 task에 비해 훨씬 높다.

단일 이미지 데이터 (Single-Image Data)

단일 이미지 데이터는 멀티모달 기능에 매우 중요하므로, 우리는 모델 학습을 위해 대규모 단일 이미지 데이터 컬렉션을 명시적으로 컴파일한다. 수집된 데이터 소스에서 균형 잡힌 컬렉션을 형성하도록 선택하여 총 320만 개의 샘플을 얻었다. 단일 이미지 데이터의 전체 분포는 Figure 4에 나와 있으며, 자세한 정보와 데이터 수집 로드맵은 Appendix E.1에 제시되어 있다.

OneVision 데이터 (OneVision Data)

단일 이미지 단계 학습 외에도, 우리는 비디오, 이미지, 다중 이미지 데이터의 혼합을 사용하여 모델을 추가로 fine-tune한다. 우리는 총 160만 개의 혼합 데이터 샘플을 도입하는데, 이는 [68]에서 가져온 560K개의 다중 이미지 데이터, 이 프로젝트에서 수집한 350K개의 비디오, 그리고 800K개의 단일 이미지 샘플로 구성된다. 특히, 이 단계에서는 새로운 단일 이미지 데이터를 도입하지 않고, 대신 이전 단일 이미지 데이터에서 고품질의 균형 잡힌 부분을 샘플링한다. 데이터 분포 및 세부 정보는 Figure 5에 제시되어 있으며, 추가 정보는 Appendix E.2에서 확인할 수 있다.

Figure 4: Single-Image 3.2M. 고품질 단일 이미지 데이터셋 컬렉션. 왼쪽: 각 카테고리 내 데이터 분포. 바깥쪽 원은 모든 데이터 카테고리의 분포를 보여주고 안쪽 원은 데이터 subset의 분포를 보여준다. 오른쪽: 데이터셋의 상세 수량.

Figure 4: Single-Image 3.2M. 고품질 단일 이미지 데이터셋 컬렉션. 왼쪽: 각 카테고리 내 데이터 분포. 바깥쪽 원은 모든 데이터 카테고리의 분포를 보여주고 안쪽 원은 데이터 subset의 분포를 보여준다. 오른쪽: 데이터셋의 상세 수량.

Figure 5: OneVision 1.6M. 고품질 단일 이미지, 다중 이미지 및 비디오 데이터셋 컬렉션. 왼쪽: 각 카테고리 내 데이터 분포. 바깥쪽 원은 모든 데이터 카테고리의 분포를 보여주고 안쪽 원은 데이터 subset의 분포를 보여준다. 오른쪽: 데이터셋의 상세 수량. "MI"는 DEMON [69]에서 제안한 다중 이미지 버전 데이터셋임을 의미한다.

Figure 5: OneVision 1.6M. 고품질 단일 이미지, 다중 이미지 및 비디오 데이터셋 컬렉션. 왼쪽: 각 카테고리 내 데이터 분포. 바깥쪽 원은 모든 데이터 카테고리의 분포를 보여주고 안쪽 원은 데이터 subset의 분포를 보여준다. 오른쪽: 데이터셋의 상세 수량. "MI"는 DEMON [69]에서 제안한 다중 이미지 버전 데이터셋임을 의미한다.

5 Training Strategies

LLM에 멀티모달 기능을 부여하기 위해, 우리는 세 가지 핵심 기능을 식별하고, ablation study를 목적으로 이들을 세 가지 개별적인 학습 단계로 체계적으로 나누었다. 대부분의 기존 연구와 마찬가지로, 이전 LLaVA 모델들은 주로 단일 이미지 instruction tuning을 탐구했다. 그러나 다른 부분들은 덜 자주 연구되었으므로, 이 섹션의 주요 초점이 된다. 우리는 커리큘럼 학습(curriculum learning) 원칙에 따라 모델을 학습시키는데, 이는 점점 더 어려워지는 학습 목표와 예시들을 단계별로 관찰하는 방식이다. 고정된 연산 예산 내에서 이 전략은 학습 과정을 분해하고, 더 많은 실험에 재사용될 수 있는 즉각적인 체크포인트를 생성하는 데 도움이 된다.

- Stage-1: Language-Image Alignment. 목표는 시각적 feature를 LLM의 word embedding 공간에 잘 정렬시키는 것이다.

- Stage-1.5: High-Quality Knowledge Learning. 연산 효율성과 LMM에 새로운 지식을 주입하는 것 사이의 균형을 맞추기 위해, LMM 학습을 위한 고품질 지식을 고려할 것을 권장한다. 학습 구성은 Stage-2에서 사용된 설정과 동일하여 일관성을 보장하고 모델이 새로운 정보를 원활하게 통합할 수 있도록 한다.

- Stage-2: Visual Instruction Tuning. LMM이 다양한 시각 task를 선호하는 응답으로 해결하도록 가르치기 위해, 우리는 instruction 데이터를 Section 4.2에 설명된 대로 다른 그룹으로 구성한다. 모델은 이 그룹들을 순서대로 학습하도록 스케줄링된다. 구체적으로, visual instruction tuning 과정은 두 단계로 구성된다: (i) Single-Image Training: 모델은 먼저 320만 개의 단일 이미지 instruction으로 학습되어, 단일 이미지를 사용하여 다양한 instruction을 따라 시각 task를 완료하는 데 강력한 성능을 보이는 모델을 만든다. (ii) OneVision Training: 모델은 그 다음 비디오, 단일 이미지, 다중 이미지 데이터의 혼합으로 학습된다. 이 단계에서 모델은 단일 이미지 시나리오에서 다양한 시나리오로 그 능력을 확장한다. 각 새로운 시나리오에서 task를 완료하기 위해 instruction을 따르는 방법을 배우고, 학습된 지식을 다른 시나리오 간에 전이하여 새로운 emergent capabilities를 생성한다. post-training 단계에서 제안된 OneVision training은 LMM에 다중 이미지 및 비디오 이해 능력을 부여하는 가장 간단하고 비용 효율적인 방법일 것이다.

학습 전략은 Table 1에 요약되어 있다. 우리는 긴 시퀀스 학습을 처리하기 위해 모델을 점진적으로 학습시킨다. 최대 이미지 해상도와 visual token의 수는 학습이 진행됨에 따라 점진적으로 증가한다. Stage-1에서는 729개의 token으로 기본 이미지 표현이 고려된다. Stage 1.5와 2에서는 각각 최대 5배, 10배 더 많은 visual token을 가진 AnyRes가 고려된다. 학습 가능한 모듈에 관해서는, Stage-1은 projector만 업데이트하는 반면, 후속 단계에서는 전체 모델을 업데이트한다. 또한 vision encoder의 learning rate는 LLM의 learning rate보다 5배 작다는 점도 주목할 만하다.

Table 1: LLaVA-OneVision 모델의 각 학습 단계에 대한 상세 구성. 이 표는 커리큘럼 학습 과정의 여러 단계에 걸쳐 vision parameter, 데이터셋 특성, 모델 사양, 학습 하이퍼파라미터의 진행 상황을 요약한다. 우리는 0.5B 모델에는 512의 global batch size를 사용하고, 7B 및 72B 모델에는 256을 사용한다.

Table 1: LLaVA-OneVision 모델의 각 학습 단계에 대한 상세 구성. 이 표는 커리큘럼 학습 과정의 여러 단계에 걸쳐 vision parameter, 데이터셋 특성, 모델 사양, 학습 하이퍼파라미터의 진행 상황을 요약한다. 우리는 0.5B 모델에는 512의 global batch size를 사용하고, 7B 및 72B 모델에는 256을 사용한다.

6 Experimental Results

우리는 LMMs-Eval [161]을 사용하여 모든 벤치마크에서 LLaVA-OneVision 모델에 대한 표준화되고 재현 가능한 평가를 수행한다. 다른 주요 LMM들과의 공정한 비교를 위해, 우리는 주로 원 논문의 결과를 보고한다. 결과가 없는 경우, LMMs-Eval에 모델을 온보딩하고 일관된 설정을 사용하여 평가한다. 모든 결과는 특별한 언급이 없는 한 greedy decoding 및 0-shot 설정으로 보고된다.

설계된 패러다임의 일반성과 효과를 보여주기 위해, 우리는 Table 2에서 단일 이미지, 다중 이미지, 비디오 벤치마크를 포함한 다양한 모달리티에 걸쳐 LLaVA-OneVision 모델을 종합적으로 평가한다. 각 모달리티에 대한 상세 결과는 각각 Table 3, Table 4, Table 5에 제시되어 있다. 우리는 단일 이미지 단계(single-image stage) 이후 학습된 모델 체크포인트를 **LLaVA-OV (SI)**로, one-vision 단계 이후 학습된 모델 체크포인트를 LLaVA-OV로 표기한다.

**세 가지 모델 크기(0.5B, 7B, 72B)**가 제공되어, 엣지 디바이스부터 클라우드 서비스에 이르는 다양한 성능-처리량(performance-throughput) trade-off를 가진 애플리케이션에 적합하도록 하였다. GPT-4V 및 GPT-4o 결과는 참고용으로 제시되었다. 우리의 가장 큰 모델인 LLaVA-OneVision-72B는 대부분의 벤치마크에서 GPT-4V와 GPT-4o 사이의 우수한 성능을 보인다. 이는 제안된 방식이 효과적이며, 추가적인 스케일링을 위한 유망한 경로를 제시함을 시사한다. 그러나 시각 채팅 시나리오와 같은 복잡한 task에서는 상대적으로 큰 격차가 남아 있으며, 이는 **더 강력한 LLM, 더 많은 학습 데이터, 더 나은 선호 학습(preference learning)**을 통한 미래 연구 과제로 남겨둔다.

6.1 Single-Image Benchmarks

실제 시나리오에서 단일 이미지 task의 성능을 검증하기 위해, 우리는 Table 3에 제시된 포괄적인 이미지 벤치마크 세트를 고려한다. 이 벤치마크들은 세 가지 클래스로 분류할 수 있다:

(1) 차트, 다이어그램, 문서 이해 (Chart, Diagram, and Document Understanding). 구조화된 OCR 데이터의 주요 시각 형식으로서, 우리는 AI2D [54], ChartQA [101], DocVQA [103], InfoVQA [102] 벤치마크에서 결과를 평가한다. InternVL [22] 및 Cambrian [133]과 같은 현재 오픈소스 모델들이 상용 모델과 비견할 만한 성능을 달성하고 있지만, LLaVA-OneVision은 한 단계 더 나아가 GPT-4V [109]를 능가하고 GPT-4o [110]의 성능 수준에 근접한다.

(2) 인지 및 다학제적 추론 (Perception and Multi-discipline Reasoning). 시각 인지 시나리오를 포함하여, 우리는 더 복잡하고 도전적인 추론 task에 대한 우리 모델의 잠재력을 보여준다. 구체적으로, 우리는 MME [151], MMBench [86], MMVet [154]를 포함한 인지 벤치마크와 MathVerse [165], MathVista [90], MMMU [157]와 같은 추론 벤치마크를 채택한다. LLaVA-OneVision의 결과는 다양한 벤치마크에서 GPT-4V를 크게 능가하며, MathVista에서는 GPT-4o와 비견할 만한 성능을 보인다. 이는 시각 인지 및 추론 task에서 우리 프레임워크의 우수성을 더욱 확증한다.

(3) 실세계 이해 및 시각 채팅 (Real-world Understanding and Visual Chat). 우리는 실험실 환경을 넘어, 실제 환경에서 LMM이 범용 비서로서 기능하는 능력을 가장 중요한 지표로 간주한다. 실세계 시나리오에서의 역량을 검증하기 위해, 우리는 RealworldQA [141], Vibe-Eval [111], MM-LiveBench [161], LLaVA-Bench-Wilder [65]를 포함한 여러 널리 채택된 벤치마크를 활용한다. 우리 모델은 GPT-4V 및 GPT-4o에 비해 여전히 개선의 여지가 있지만, 유사한 파라미터 크기의 오픈소스 모델들과 경쟁력 있는 성능을 달성한다. 특히, 우리 모델은 실시간으로 콘텐츠가 업데이트되는 실세계 인터넷 콘텐츠 벤치마크인 MM-LiveBench [161]에서 좋은 성능을 보여주며, 이는 모델의 광범위한 세계 지식과 강력한 일반화 능력을 입증한다.

6.2 Multi-Image Benchmarks

우리는 LLaVA-OneVision을 사용자가 여러 이미지 사이에서 질문을 할 수 있는 multi-image interleaved 설정에서도 추가적으로 평가한다. 특히, LLaVA-Interleave Bench [68]의 다양한 하위 task에 대해 포괄적인 평가를 수행한다. 여기에는 Spot the Difference [45], Image Edit Instruction (IEI) [68], Visual Storytelling (VST) [40], Text-rich VQA (TR-VQA) [85], Multi-image VQA (MI-VQA) [117], Raven Puzzle [24], Q-Bench (QB) [139], NLVR2 [125] 등이 포함된다.

또한, 여러 시점에서 3D 환경을 묘사하는 multi-view 벤치마크도 평가에 활용한다. 여기에는 3D-LLM [38]의 3D Dialogue (3D-Chat) 및 Task Decomposition (3D-TD), ScanQA [5], ALFRED [122], nuScenes VQA [9] 등이 있다.

이러한 데이터셋들은 우리의 학습 데이터에 해당 데이터셋의 training split이 포함되어 있으므로 in-domain 평가로 간주한다.

더 나아가, 우리는 out-domain task에 대한 평가를 수행하여 우리 접근 방식의 일반화 능력을 확인한다. 여기에는 **수학 QA 벤치마크 MathVerse [165] 및 과학 QA 벤치마크 SciVerse [34]의 multi-image split, multi-image perception 벤치마크 BLINK [31], MMMU 내의 모든 multi-image QA를 포함하는 MMMU-(multi-image) [157], 그리고 12개의 다양한 multi-image task를 포함하는 MuirBench [135]**가 있다.

Table 4에서 볼 수 있듯이, LLaVA-OneVision (SI)는 모든 벤치마크에서 기존 multi-image LMM들을 일관되게 능가한다. Multi-image 및 비디오 데이터에 대한 추가 튜닝 후, LLaVA-OneVision은 특정 영역에서 GPT-4V보다 현저한 개선을 보이며, 상당한 격차를 나타낸다. 이는 multi-image reasoning, 차이점 식별, 3D 환경 이해와 같은 복잡한 task에서 LLaVA-OneVision의 강력한 성능을 강조한다. 또한, one-vision 학습 단계 이후 일관된 성능 향상이 관찰되며, 이는 single-image 데이터에는 없는 multi-view 벤치마크에서 더욱 두드러진다. 이는 LMM에 포괄적인 시각 능력을 부여하는 데 있어 우리의 one-vision 패러다임의 중요성을 입증한다.

| Capability | Benchmark | LLaVA OneVision-0.5B | LLaVA OneVision-7B | LLaVA OneVision-72B | GPT-4V (V-Preview) | GPT-4o |

|---|---|---|---|---|---|---|

| Single-Image | AI2D [53] | 57.1% | 81.4% | 85.6% | 78.2% | 94.2% |

| ChartQA [101] | 61.4% | 80.0% | 83.7% | 78.5% | 85.7% | |

| DocVQA [103] (test) | 70.0% | 87.5% | 91.3% | 88.4% | 92.8% | |

| InfoVQA [102] (test) Infographic Understanding | 41.8% | 68.8% | 74.9% | - | - | |

| MathVerse [165] (vision-mini) | 17.9% | 26.2% | 39.1% | 32.8% | 50.2% | |

| Professional Math Reasoning | ||||||

| MathVista [90] (testmini) | 34.8% | 63.2% | 67.5% | 49.9% | 63.8% | |

| General Math Understanding | ||||||

| MMBench [86] (en-dev) | 52.1% | 80.8% | 85.9% | 75.0% | - | |

| Multi-discip | ||||||

| MME [28] (cog./perp.) | 240/1238 | 418/1580 | 579/1682 | 517/1409 | - | |

| Multi-discip | ||||||

| MMStar [19] | 37.5% | 61.7% | 66.1% | 57.1% | - | |

| Multi-discip | ||||||

| MMMU [157] (val) | 31.4% | 48.8% | 56.8% | 56.8% | 69.1% | |

| College-level Multi-disp | ||||||

| MMVet [153] | 29.1% | 57.5% | 63.7% | 49.9% | 76.2% | |

| SeedBench [66] (image) | 65.5% | 75.4% | 78.0% | 49.9% | 76.2% | |

| Multi-discip; Large-scale | ||||||

| ScienceQA [93] | 67.2% | 96.0% | 90.3% | 75.7% | - | |

| ImageDC [65] | 83.3% | 88.2% | 91.2% | 91.5% | - | |

| Image Detail Description | ||||||

| RealworldQA [141] | 55.6% | 66.3% | 71.9% | 61.4% | - | |

| Realwold QA | ||||||

| Vibe-Eval [112] | 33.8% | 51.7% | 50.7% | 57.9% | 63.1% | |

| Chanllenging Cases | ||||||

| MM-LiveBench [161] (2406) | 49.9% | 77.1% | 81.5% | - | 92.4% | |

| Internet Content Understanding | ||||||

| LLaVA-Wilder [65] (small) | 55.0% | 67.8% | 72.0% | 81.0% | 85.9% | |

| Multi-Image | LLaVA-Interleave [68] | 33.3% | 64.2% | 79.9% | 60.3% | - |

| Out-domain | ||||||

| MuirBench [135] | 25.5% | 41.8% | 54.8% | 62.3% | - | |

| Mantis [47] | 39.6% | 64.2% | 77.6% | 62.7% | - | |

| Multi-image in the Wild | ||||||

| BLINK [31] | 52.1% | 48.2% | 55.4% | 51.1% | - | |

| Unusual Visual Scenarios | ||||||

| Text-rich VQA [84] | 65.0% | 80.1% | 83.7% | 54.5% | - | |

| Video | ActivityNetQA [155] | 50.5% | 56.6% | 62.3% | 57.0% | - |

| EgoSchema [98] | 26.8% | 60.1% | 62.0% | - | - | |

| Egocentric Video Understanding | ||||||

| PerceptionTest [115] | 49.2% | 57.1% | 66.9% | - | - | |

| SeedBench [66] (video) | 44.2% | 56.9% | 62.1% | 60.5% | - | |

| Multi-discip; Video | ||||||

| LongVideoBench [138] (val) | 45.8% | 56.3% | 63.2% | 60.7% | 66.7% | |

| MLVU [170] | 50.3% | 64.7% | 68.0% | 49.2% | 64.6% | |

| Long Video Understanding | ||||||

| MVBench [71] | 45.5% | 56.7% | 59.4% | 43.5% | - | |

| Multi-discip | ||||||

| VideoChatGPT [97] | 3.12 | 3.49 | 3.62 | 4.06 | - | |

| Video Conversation | ||||||

| VideoMME [29] | 44.0% | 58.2% | 66.2% | 59.9% | 71.9% |

Table 2: LLaVA-OneVision 모델(0.5B에서 72B 파라미터)과 최신 상용 모델들의 다양한 멀티모달 평가 벤치마크에서의 성능 비교.

는 학습 데이터 혼합에 해당 훈련 세트가 포함되었음을 나타낸다.

| Model | AI2D | ChartQA | DocVQA | InfoVQA | MathVerse | MathVista | MMBench | MME | MMMU |

|---|---|---|---|---|---|---|---|---|---|

| test | test | val/test | val/test | mini-vision | testmini | en-dev | test | val | |

| Qwen-VL-Max [8] | 79.3 | 79.8 | -/93.1 | - | 23.0 | 51.0 | 77.6 | 2281 | 51.4 |

| Gemini-1.5-Pro [130] | 94.4 | 87.2 | -/93.1 | -/81.0 | - | 63.9 | - | - | 62.2 |

| Claude 3.5 Sonnet [3] | 94.7 | 90.8 | -/95.2 | 49.7 | - | 67.7 | - | - | 68.3 |

| GPT-4V [109] | 78.2 | 78.5* | -/88.4 | - | 32.8 | 49.9 | 75.0 | 517/1409 | 56.8 |

| GPT-4o [110] | 94.2 | 85.7 | -/92.8 | - | 50.2 | 63.8 | - | - | 69.1 |

| Cambrian-34B [133] | 79.7 | 73.8 | -/75.5 | - | - | 53.2 | 81.4 | - | 49.7 |

| VILA-34B [77] | - | - | - | - | - | - | 82.4 | 1762 | 51.9 |

| IXC-2.5-7B [162] | 81.5 | 82.2 | -/90.9 | -/70.0 | 20.0 | 59.6 | 82.2 | 2229 | 42.9 |

| InternVL-2-8B [22] | 83.8 | 83.3 | -/91.6 | -/74.8 | 27.5 | 58.3 | 81.7 | 2210 | 49.3 |

| InternVL-2-26B [22] | 84.5 | 84.9 | -/92.9 | -/75.9 | 31.3 | 59.4 | 83.4 | 2260 | 48.3 |

| LLaVA-OV-0.5B (SI) | 54.2 | 61.0 | 75.0/71.2 | 44.8/41.3 | 17.3 | 34.6 | 43.8 | 272/1217 | 31.2 |

| LLaVA-OV-0.5B | 57.1 | 61.4 | 73.7/70.0 | 46.3/41.8 | 17.9 | 34.8 | 52.1 | 240/1238 | 31.4 |

| LLaVA-OV-7B (SI) | 81.6 | 78.8 | 89.3/86.9 | 69.9/65.3 | 26.9 | 56.1 | 81.7 | 483/1626 | 47.3 |

| LLaVA-OV-7B | 81.4 | 80.0 | 90.2/87.5 | 70.7/68.8 | 26.2 | 63.2 | 80.8 | 418/1580 | 48.8 |

| LLaVA-OV-72B (SI) | 85.1 | 84.9 | 93.5/91.8 | 77.7/74.6 | 37.7 | 66.5 | 86.6 | 563/1706 | 57.4 |

| LLaVA-OV-72B | 85.6 | 83.7 | 93.1/91.3 | 79.2/74.9 | 39.1 | 67.5 | 85.9 | 579/1682 | 56.8 |

| Model | |MMVet MMStar S-Bench S-QA ImageDC MMLBench RealWorldQA | |||||||||

|---|---|---|---|---|---|---|---|---|---|---|

| test | test | image | test | test | 2024-06 | test | test | test | small | |

| Qwen-VL-Max [8] | - | - | - | - | - | - | - | - | - | - |

| Gemini-1.5-Pro [130] | - | - | - | - | - | 85.9 | 70.4 | 60.4 | - | - |

| Claude 3.5 Sonnet [3] | 75.4 | - | - | - | - | 92.3 | 59.9 | 66.2 | 102.9 | 83.1 |

| GPT-4V [109] | 49.9 | 57.1 | 49.9 | 75.7 | 91.5 | - | 61.4 | 57.9 | 98.0 | 81.0 |

| GPT-4o [110] | 76.2 | - | 76.2 | - | 92.5 | 92.4 | 58.6 | 63.1 | 106.1 | 85.9 |

| Cambrian-34B [133] | - | - | - | 85.6 | - | - | 67.8 | - | - | - |

| VILA-34B [77] | 53.0 | - | 75.8 | - | - | - | - | 81.3 | - | - |

| IXC-2.5-7B [162] | 51.7 | 59.9 | 75.4 | - | 87.5 | - | 67.8 | 45.2 | 78.1 | 61.4 |

| InternVL-2-8B [22] | 60.0 | 59.4 | 76.0 | 97.0 | 87.1 | 73.4 | 64.4 | 46.7 | 84.5 | 62.5 |

| InternVL-2-26B [22] | 65.4 | 60.4 | 76.8 | 97.5 | 91.0 | 77.2 | 66.8 | 51.5 | 99.6 | 70.2 |

| LLaVA-OV-0.5B (SI) | 26.9 | 36.3 | 63.4 | 67.8 | 83.0 | 43.2 | 53.7 | 34.9 | 71.2 | 51.5 |

| LLaVA-OV-0.5B | 29.1 | 37.5 | 65.5 | 67.2 | 83.3 | 49.9 | 55.6 | 33.8 | 74.2 | 55.0 |

| LLaVA-OV-7B (SI) | 58.8 | 60.9 | 74.8 | 96.6 | 85.7 | 75.8 | 65.5 | 47.2 | 86.9 | 69.1 |

| LLaVA-OV-7B | 57.5 | 61.7 | 75.4 | 96.0 | 88.9 | 77.1 | 66.3 | 51.7 | 90.7 | 67.8 |

| LLaVA-OV-72B (SI) | 60.0 | 65.2 | 77.6 | 91.3 | 91.5 | 84.4 | 73.8 | 46.7 | 93.7 | 72.9 |

| LLaVA-OV-72B | 63.7 | 66.1 | 78.0 | 90.3 | 91.2 | 81.5 | 71.9 | 50.7 | 93.5 | 72.0 |

Table 3: Single-image 벤치마크에서 LLaVA-OneVision의 성능.

*GPT-4V는 ChartQA에서 4-shot 결과를 보고한다. 모든 결과는 0-shot 정확도로 보고된다.

6.3 Video Benchmarks

비디오 또한 세계 모델(world model)을 구축하는 데 흔히 사용되는 modality이며, 시간에 따른 실제 세계의 동적인 특성을 포착한다. 우리는 여러 open-ended 및 multi-choice 비디오 벤치마크에서 실험을 수행한다. 여기에는 다음 벤치마크들이 포함된다:

- ActivityNet-QA [155]: ActivityNet 데이터셋에서 파생된 사람이 주석한 행동 관련 QA 쌍을 포함한다.

- EgoSchema [98] 및 MLVU [170]: 긴 비디오 이해에 중점을 둔다.

- PerceptionTest [115]: 인지 능력 평가를 위해 설계되었다.

- VideoMME [29] 및 NeXTQA [142]: **다양한 비디오 도메인과 길이(수분에서 수시간까지)**를 포함한다.

- VideoDetailCaption [87] 및 Video-ChatGPT [96]: 각각 비디오 상세 설명 및 시각적 대화를 위한 벤치마크이다.

Table 5에서 볼 수 있듯이, LLaVA-OneVision은 훨씬 더 큰 LLM을 사용하는 이전 오픈 소스 모델들과 비교하여 동등하거나 더 나은 결과를 달성한다. LLaVA-OneVision의 우수성은 특히 EgoSchema 및 VideoMME와 같은 복잡한 벤치마크에서 두드러진다. 심지어 고급 상용 모델인 GPT-4V와 비교해도, LLaVA-OneVision은 ActivityNet-QA, MLVU, VideoMME 벤치마크에서 경쟁력 있는 성능을 보인다.

| Model | IEI | MI-VQA | NLVR2 | Puzzle | Q-Bench | Spot-Diff | TR-VQA | VST | 3D-Chat | 3D-TD | ScanQA | ALFRED | nuScenes | BLINK | Mantis | MathVerse | MuirBench | SciVerse |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| in-domain multi-image | in-domain multi-view | out-domain | ||||||||||||||||

| GPT-4V [109] | 11.0 | 52.0 | 88.8 | 17.1 | 76.5 | 12.5 | 54.5 | 10.9 | 31.2 | 35.4 | 32.6 | 10.3 | 63.7 | 51.1 | 62.7 | 60.3 | 62.3 | 66.9 |

| LLaVA-N-Image-7B [82] | 13.2 | 39.4 | 68.0 | 9.0 | 51.0 | 12.9 | 59.6 | 10.1 | - | - | - | - | - | 41.8 | 46.1 | 13.5 | - | 12.2 |

| VPG-C-7B [70] | 15.2 | 46.8 | 73.2 | 2.4 | 57.6 | 27.8 | 38.9 | 21.5 | - | - | - | - | - | 43.1 | 52.4 | 24.3 | - | 23.1 |

| Mantis-7B [47] | 11.2 | 52.5 | 87.4 | 25.7 | 69.9 | 17.6 | 45.2 | 12.5 | 2.60 | 14.7 | 16.1 | 14.0 | 46.2 | 46.4 | 59.5 | 27.2 | 36.1 | 29.3 |

| LLaVA-N-Inter-7B [68] | 24.3 | 87.5 | 88.8 | 48.7 | 74.2 | 37.1 | 76.1 | 33.1 | - | - | - | - | - | 52.6 | 62.7 | 32.8 | 38.9 | 31.6 |

| LLaVA-N-Inter-14B [68] | 24.5 | 95.0 | 91.1 | 59.9 | 76.7 | 40.5 | 78.6 | 33.3 | 70.6 | 52.2 | 34.5 | 62.0 | 76.7 | 52.1 | 66.4 | 33.4 | 40.7 | 32.7 |

| LLaVA-OV-0.5B (SI) | 15.6 | 44.8 | 56.1 | 30.0 | 45.8 | 8.5 | 36.7 | 7.6 | 22.1 | 22.1 | 16.9 | 25.5 | 8.2 | 37.9 | 38.2 | 20.9 | 22.7 | 26.7 |

| LLaVA-OV-0.5B | 17.1 | 48.7 | 63.4 | 35.4 | 48.8 | 36.4 | 65.0 | 29.8 | 60.0 | 48.0 | 29.4 | 62.2 | 70.5 | 52.1 | 39.6 | 60.0 | 25.5 | 29.1 |

| LLaVA-OV-7B (SI) | 20.5 | 60.3 | 75.9 | 24.6 | 56.0 | 7.9 | 52.8 | 8.4 | 24.5 | 29.9 | 22.1 | 32.0 | 70.8 | 45.6 | 54.2 | 26.3 | 32.7 | 30.0 |

| LLaVA-OV-7B | 22.2 | 90.2 | 89.4 | 53.3 | 74.5 | 39.2 | 80.1 | 31.7 | 62.8 | 52.6 | 30.1 | 61.0 | 79.8 | 48.2 | 64.2 | 67.6 | 41.8 | 79.1 |

| LLaVA-OV-72B (SI) | 22.1 | 61.2 | 78.9 | 44.2 | 61.5 | 15.6 | 67.9 | 12.1 | 30.8 | 25.4 | 21.9 | 43.5 | 75.5 | 46.0 | 56.8 | 58.6 | 33.2 | 65.8 |

| LLaVA-OV-72B | 22.5 | 95.3 | 93.8 | 63.4 | 83.2 | 43.3 | 83.7 | 34.5 | 63.2 | 53.3 | 35.8 | 66.3 | 78.8 | 55.4 | 77.6 | 91.6 | 54.8 | 94.9 |

Table 4: LLaVA-OneVision의 multi-image 벤치마크 성능 (모든 결과는 정확도로 보고됨)

는 LLaVA-NeXT-Vicuna-7B (2024-01)를 나타낸다.

IEI는 Image Edit Instruction, MI-VQA는 Multi-image VQA, NLVR2는 Natural Language for Visual Reasoning, SDiff는 Spot the Difference, VST는 Visual Story Telling, TR-VQA는 Text-rich VQA를 의미한다.

MathVerse와 SciVerse의 경우, multi-image split에서의 정확도를 보고한다.

| Model | ActNet-QA | EgoSchema | MLVU | MVBench | NextQA | PercepTest | SeedBench | VideoChatGPT | VideoDC | VideoMME | L-VideoBench |

|---|---|---|---|---|---|---|---|---|---|---|---|

| test | test | m-avg | test | mc | val | video | test | test | wo/w-subs | val | |

| GPT-4V [109] | 57.0 | - | 49.2 | 43.5 | - | - | 60.5 | 4.06 | 4.00 | 59.9/63.3 | 61.3 |

| GPT-4o [110] | - | - | 64.6 | - | - | - | - | - | - | 71.9/77.2 | 66.7 |

| Gemini-1.5-Flash [131] | 55.3 | 65.7 | - | - | - | - | - | - | - | 70.3/75.0 | 61.6 |

| Gemini-1.5-Pro [131] | 57.5 | 72.2 | - | - | - | - | - | - | - | 75.0/81.3 | 64.0 |

| VILA-40B [77] | 58.0 | 58.0 | - | - | 67.9 | 54.0 | - | 3.36 | 3.37 | 60.1/61.1 | - |

| PLLaVA-34B [143] | 60.9 | - | - | 58.1 | - | - | - | 3.48 | - | - | - |

| LLaVA-N-Video-34B [169] | 58.8 | 49.3 | - | - | 70.2 | 51.6 | - | 3.34 | 3.48 | 52.0/54.9 | 50.5 |

| LongVA-7B [163] | 50.0 | - | 56.3 | - | 68.3 | - | - | 3.20 | 3.14 | 52.6/54.3 | - |

| IXC-2.5-7B [162] | 52.8 | - | 37.3 | 69.1 | 71.0 | 34.4 | - | 3.46 | 3.73 | 55.8/58.8 | - |

| LLaVA-N-Video-32B [169] | 54.3 | 60.9 | 65.5 | - | 77.3 | 59.4 | - | 3.59 | 3.84 | 60.2/63.0 | - |

| LLaVA-OV-0.5B (SI) | 49.0 | 33.1 | 47.9 | 43.3 | 53.6 | 48.6 | 43.4 | 3.08 | 3.51 | 41.7/40.4 | 41.9 |

| LLaVA-OV-0.5B | 50.5 | 26.8 | 50.3 | 45.5 | 57.2 | 49.2 | 44.2 | 3.12 | 3.55 | 44.0/43.5 | 45.8 |

| LLaVA-OV-7B (SI) | 55.1 | 52.9 | 60.2 | 51.2 | 61.6 | 54.9 | 51.1 | 3.54 | 3.51 | 55.0/59.1 | 54.3 |

| LLaVA-OV-7B | 56.6 | 60.1 | 64.7 | 56.7 | 79.4 | 57.1 | 56.9 | 3.51 | 3.75 | 58.2/61.5 | 56.4 |

| LLaVA-OV-72B (SI) | 62.1 | 58.6 | 60.9 | 57.1 | 67.2 | 62.3 | 60.9 | 3.55 | 3.66 | 64.8/66.9 | 58.3 |

| LLaVA-OV-72B | 62.3 | 62.0 | 68.0 | 59.4 | 80.2 | 66.9 | 62.1 | 3.62 | 3.60 | 66.2/69.5 | 61.3 |

Table 5: LLaVA-OneVision의 비디오 벤치마크 성능

VideoDC, VideoChatGPT의 점수는 5점 만점으로 보고되며, 다른 결과는 정확도로 보고된다. 모든 결과는 0-shot 정확도로 보고된다.

LLaVA-OV split 내에서 가장 작은 성능 차이는 PerceptionTest에서 발생하며, LLM을 0.5B에서 7B로 확장했을 때 0.5점의 최소 개선을 보인다. 이는 다른 데이터셋에서 최소 5점 이상의 개선이 있었던 것과 대조적이다. PerceptionTest에서의 미미한 성능 향상은 LLaVA-OV의 인지 능력(perception capabilities)이 주로 vision module에 의존할 수 있음을 시사하며, 이는 Qiao et al. [116]과 같은 최근 연구들의 발견을 뒷받침한다. 이 연구들은 이미지 인코더와 LLM의 역할을 인지 및 추론 task에서 분리하여 설명한다. 특히, 상당한 추론 능력을 요구하는 EgoSchema와 같은 데이터셋에서는 더 큰 LLM이 성능을 크게 향상시킨다.

또한, LLaVA-OV-7B (SI)와 LLaVA-OV-7B를 비교했을 때, 가장 작은 개선은 ActivityNet-QA에서 나타난다. 이는 이미지로만 학습된 LLaVA-OV-7B (SI)가 이 데이터셋에서 이미 좋은 성능을 낼 수 있음을 시사한다. ActivityNet-QA를 자세히 살펴보면, 많은 질문들이 비디오의 단일 프레임만 관찰해도 답변될 수 있음이 분명해진다. 예를 들어, "공의 색깔은 무엇인가요?"와 같은 질문은 공이 처음부터 끝까지 보이는 비디오 전체에서 답변될 수 있다. 이러한 시나리오는 모델이 비디오 시퀀스를 이해할 필요가 없으므로 LLaVA-OV-7B (SI)가 좋은 성능을 발휘할 수 있게 한다.

7 Emerging Capabilities with Task Transfer

LLaVA-OneVision의 다양한 벤치마크에서의 성능을 보고하는 것 외에도, 우리는 **task transfer 및 composition을 통해 제안된 모델에서 나타나는 새로운 행동(emerging behaviors)**을 관찰했으며, 이는 실제 컴퓨터 비전 task에 일반화하여 적용할 수 있는 유망한 길을 열어준다. 아래 예시들을 통해 몇 가지 새로운 능력들을 설명한다.

S1: 다이어그램과 차트의 공동 이해 (단일 이미지에서 다중 이미지로의 전이)

테이블과 차트를 이해하는 능력은 단일 이미지 다이어그램 이해 데이터와 단일 이미지 차트 이해 데이터로부터 각각 학습되었으며, 테이블과 차트의 공동 이해 task는 다중 이미지 데이터에 나타나지 않는다. Table 6에서 보여주듯이, LLaVA-OneVision은 다이어그램과 차트의 결합을 이해하고 추론할 수 있다.

S2: 멀티모달 에이전트를 위한 GUI (단일 이미지 및 다중 이미지에서 전이)

GUI를 이해하고 멀티모달 모델을 에이전트 task에 적용하는 것은 매우 중요하다. Table 7에서 LLaVA-OneVision은 iPhone의 GUI(Graphical User Interface) 스크린샷을 인식하고, TikTok 앱을 검색하고 여는 데 필요한 조작 지침을 제공한다. 이 task는 단일 이미지 시나리오에서 학습된 강력한 OCR 능력과 다중 이미지 시나리오에서 개발된 관계형 추론(relational reasoning) 기술을 필요로 한다. 이 예시는 LLaVA-OneVision의 GUI 이해 및 task 실행 능력을 강조한다.

S3: Set-of-mark Prompting (단일 이미지 task composition에서 전이)

기존의 open LLM들과 달리, LLaVA-OneVision은 Table 8에서 보여지는 새로운 능력인 뛰어난 set-of-marks (SoM) 추론 능력을 보여준다 [149]. 우리가 아는 한, open LMM이 좋은 SoM 능력을 보고한 것은 이번이 처음이며, LLaVA-OneVision이 [149]의 많은 예시에서 SoM 추론을 생성할 수 있음을 관찰했다. 이 task는 우리의 학습 데이터에 명시적으로 포함되어 있지 않으며, 이 능력은 visual referring과 OCR의 조합으로 구성된 것으로 가정된다.

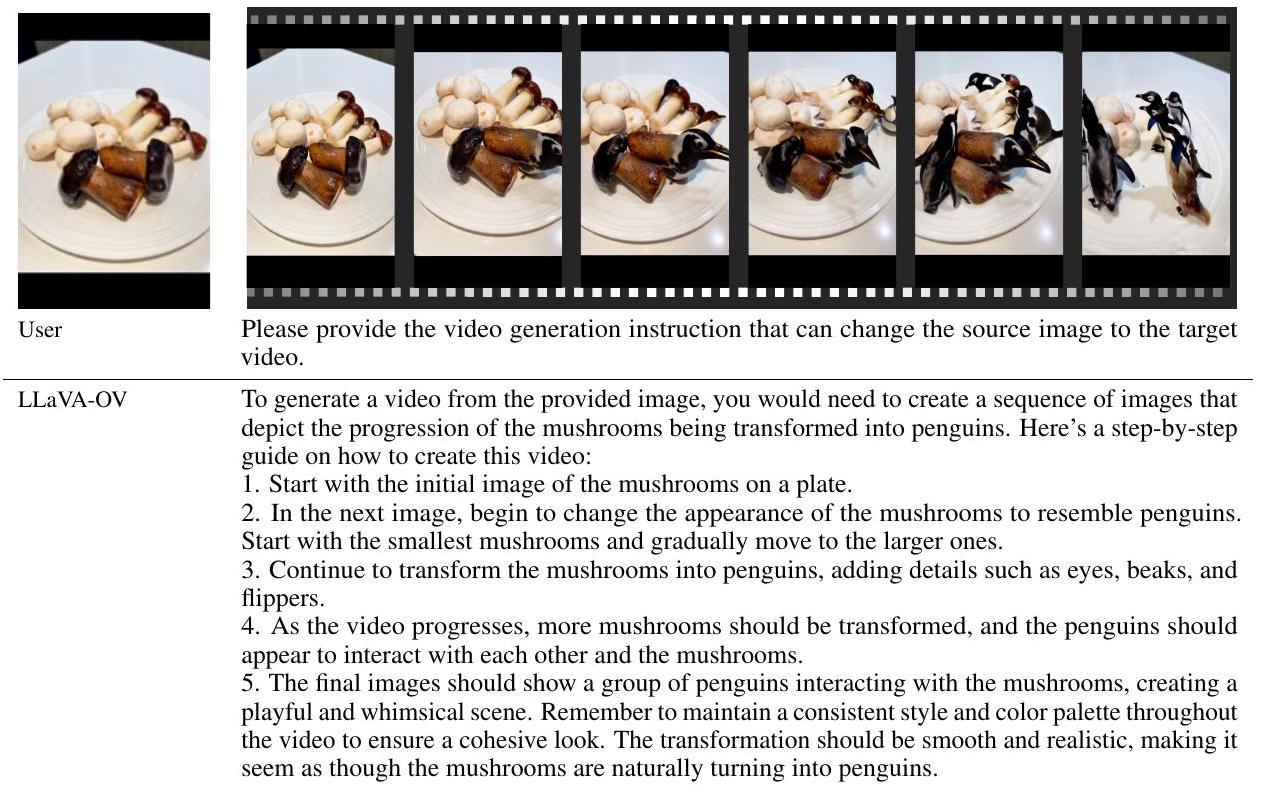

S4: 이미지-비디오 편집 지침 (단일 이미지 및 비디오에서 전이)

LLaVA-OneVision은 Table 9에서 정지 이미지 기반으로 상세한 비디오 생성 prompt를 생성할 수 있다. 이미지와 대상 비디오가 주어지면, 모델은 비디오에 대한 일관되고 생생한 내러티브를 구성하며, 캐릭터, 행동, 배경 설정, 장면 세부 사항과 같은 요소를 상세히 설명한다. 이 task는 단일 이미지 분석과 비디오 이해를 모두 활용한다. 이 능력은 단일 이미지 편집 지침 task와 비디오 상세 설명 task의 조합으로부터 일반화된 것으로 가정된다.

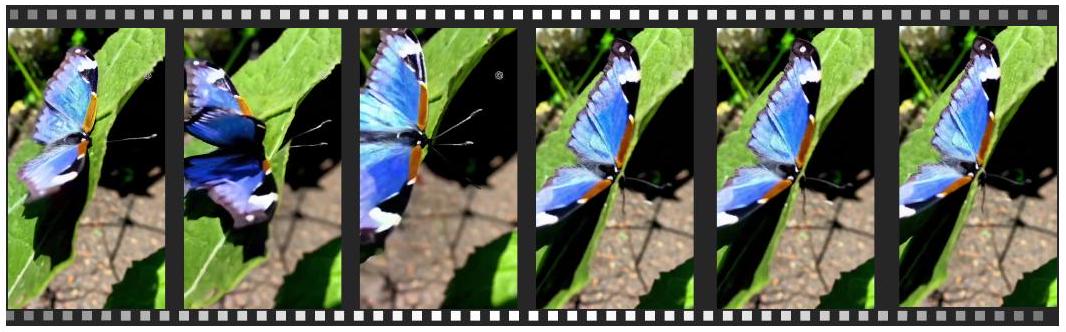

S5: 비디오-비디오 차이점 (다중 이미지 및 비디오에서 전이)

이미지 간의 차이점을 이해하는 것은 최근 대규모 멀티모달 모델(LMM)의 일반적인 능력이지만, 우리 모델은 이 능력을 비디오로 확장한다. Table 10은 LLaVA-OneVision이 동일한 시작 프레임으로 시작하지만 다른 결말을 가진 두 비디오 시퀀스 간의 차이점을 분석하는 능력을 보여준다. 모델은 캐릭터, 행동, 장면 변화를 설명하는 상세한 비교를 제공한다. Table 11에서 LLaVA-OneVision은 유사한 배경을 가지지만 전경의 주요 객체가 다른 비디오들 간의 차이점을 하나씩 설명한다. 이 task는 다중 이미지 분석에서 "spot the difference" 능력을 활용하여 비디오 시나리오로 일반화한다.

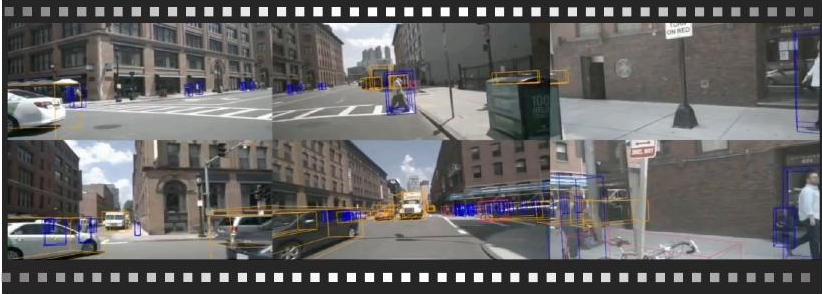

S6: 자율 주행에서의 다중 카메라 비디오 이해 (단일 이미지 및 다중 이미지에서 비디오로 전이)

일반적인 종횡비의 비디오를 이해하는 것은 간단하지만, 다중 뷰 비디오는 어떨까? Table 12에서 우리는 LLaVA-OneVision이 자율 주행 차량의 다중 카메라 비디오 영상을 분석하고 해석할 수 있음을 관찰한다. 네 가지 카메라 뷰를 보여주는 비디오가 주어지면, 모델은 각 뷰를 상세히 설명하고 자율 주행 차량의 다음 움직임을 계획한다. 이 task는 다중 패널 이해, 비디오 상세 설명, 공간-시간 추론을 결합한다.

S7: 복합 서브 비디오 이해 (다중 이미지에서 비디오로 전이)

다중 뷰 비디오 외에도, 우리 모델은 두 개의 서브 장면을 가진 세로 비디오로 일반화된다. Table 13은 LLaVA-OneVision이 복합 서브 비디오의 내용과 레이아웃을 이해하고 설명하는 능력을 보여준다. 일관된 배경과 전경의 인물을 특징으로 하는 일련의 프레임을 가진 세로 비디오가 주어지면, 모델은 시각적 요소, 그 배열, 그리고 내러티브 맥락에 대한 상세한 분석을 제공한다. 이 task는 단일 이미지 분석, 다중 이미지 시퀀스 이해, 그리고 맥락적 추론을 필요로 한다.

S8: 비디오 내 시각적 prompting (단일 이미지에서 비디오로의 task 전이)

Table 14에서 LLaVA-OneVision은 비디오 내에서 반투명 원으로 강조된 영역을 이해하고, 선수 등 뒤의 숫자 "10"을 명확하게 인식할 수 있다. 시각적 prompt와 OCR을 이해하는 능력은 단일 이미지 LMM의 능력이다. 우리 모델은 시각적 prompt가 포함된 비디오 데이터로 학습하지 않았음에도 불구하고, 비디오 내에서 시각적 prompt를 이해하는 능력을 보여준다.

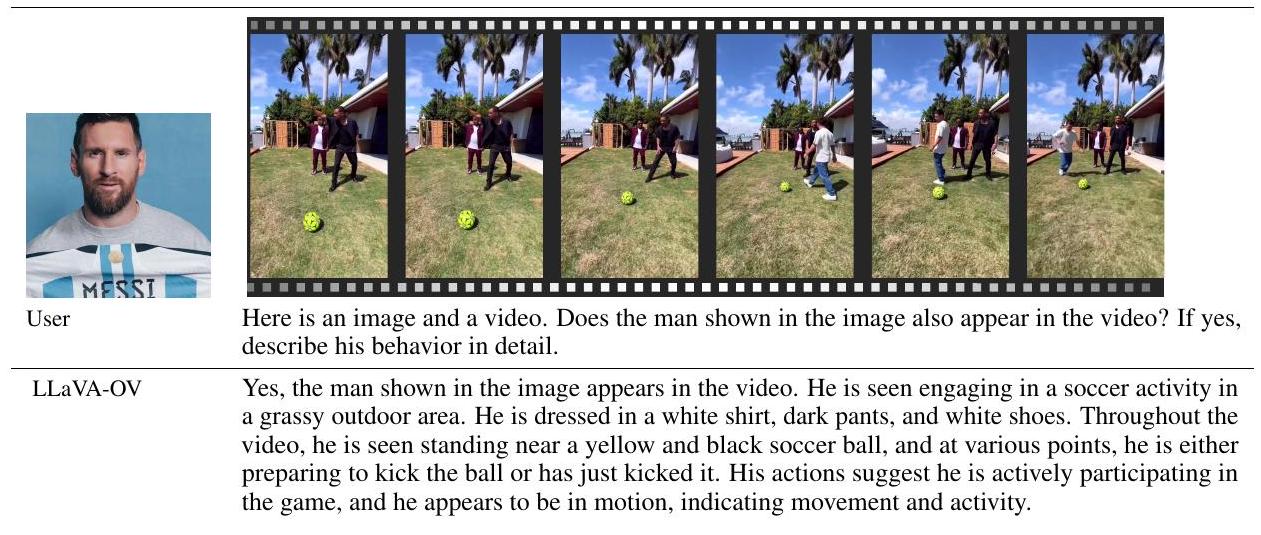

S9: 비디오 이해에서 이미지 내 시각적 참조 (Visual Referring in Image in Video Understanding)

Table 15에서 보여주듯이, 비디오에 대한 질문에 답할 때 이미지 쿼리를 참조하는 능력이다. 이 능력은 LLaVA-NeXT나 LLaVA-Interleave에서는 볼 수 없었는데, 이는 아마도 이러한 능력이 나타나기 위해서는 강력한 기본 단일 이미지 학습이 필요하기 때문일 것이다.

8 Conclusions

LLaVA-OneVision은 단일 이미지, 다중 이미지, 비디오 시나리오에서 광범위한 task로 전이될 때 뛰어난 성능을 발휘하는 새로운 오픈 LMM이다. 이 모델은 LLaVA-NeXT 블로그 시리즈의 통찰력을 통합하여 개발되었으며, 더 큰 데이터셋과 강력한 LLM을 사용하여 레시피를 확장함으로써 학습되었다.

우리의 설계는 여러 시나리오를 함께 학습하고 task 전이를 통해 새로운 기능이 나타나도록 한다. 예를 들어, 이미지에서 비디오로의 강력한 시각 이해 능력이 그 예시이다. 우리의 결과는 이러한 오픈 레시피와 리소스로 학습된 LMM이 다양한 벤치마크에서 state-of-the-art 성능을 달성함을 보여준다.

우리는 또한 LLaVA-OneVision이 커뮤니티가 특정 애플리케이션을 구축하고, 추가적인 스케일링을 통해 다양한 비전 시나리오를 위한 더 강력한 LMM을 개발하는 데 귀중한 출발점이 되기를 희망한다.

S1: Joint Understanding of Diagram and Chart from Multi-Image

| 11 | Insurance Company | Price |

|---|---|---|

| State Farm | 68 | |

| 63 | ||

| Liberty Mutual | 59 | |

| USAA | 90 |

Table 6: LLaVA-OneVision은 다이어그램 및 테이블 이해 능력을 다중 이미지 시나리오로 전이하여, 여러 이미지를 일관성 있게 해석한다.

S2: Multi-image GUI Understanding for Agents

Table 7: LLaVA-OneVision은 agent 역할을 수행한다. iPhone의 여러 스크린샷을 인식하고 iPhone과 상호작용하여 작업 자동화를 위한 조작 지침을 제공한다.

Table 7: LLaVA-OneVision은 agent 역할을 수행한다. iPhone의 여러 스크린샷을 인식하고 iPhone과 상호작용하여 작업 자동화를 위한 조작 지침을 제공한다.

S3: Set-of-mark Prompting

Table 8: LLaVA-OneVision은 뛰어난 set-of-mark prompting 능력, 즉 질문에 답변할 때 마크(mark)를 참조하는 능력을 보여준다. 이 예시는 이미지 내의 숫자 라벨을 기반으로 특정 객체를 설명하는 능력이 세밀한 시각 콘텐츠를 처리하는 모델의 이해력을 잘 보여주고 있다.

Table 8: LLaVA-OneVision은 뛰어난 set-of-mark prompting 능력, 즉 질문에 답변할 때 마크(mark)를 참조하는 능력을 보여준다. 이 예시는 이미지 내의 숫자 라벨을 기반으로 특정 객체를 설명하는 능력이 세밀한 시각 콘텐츠를 처리하는 모델의 이해력을 잘 보여주고 있다.

User: 여기에 숫자로 라벨링된 객체들이 있는 이미지가 있습니다. 4, 5, 7로 표시된 객체들을 설명해 주세요.

LLaVA-OV

이 이미지는 여러 항목이 숫자로 표시된 방을 보여준다. 숫자 4, 5, 7로 표시된 항목에 대한 설명은 다음과 같다: 숫자 4로 표시된 항목은 벽에 걸린 액자 그림이다. 씨앗이 날아가는 민들레의 흑백 일러스트레이션이 특징이며, 움직임의 느낌을 준다. 숫자 5로 표시된 항목은 여러 개의 선반이 있는 흰색 책장이다. 방 가구의 일부인 수납장으로 보인다. 두 개의 책상 사이에 위치해 있다. 숫자 7로 표시된 항목은 현대적인 디자인의 검은색 의자이다. 금속 프레임과 엮인 좌석이 있어 현대적인 스타일을 암시한다. 이 의자는 책상 중 하나 앞에 놓여 있다.

S4: Image-to-Video Editing Instruction

Table 8: LLaVA-OneVision은 set-of-mark prompting 능력, 즉 질문에 답할 때 마크를 참조하는 능력이 탁월하다. 이 예시는 이미지 내 숫자 레이블을 기반으로 특정 객체를 설명하는 능력이 세밀한 시각 콘텐츠를 처리하는 LLaVA-OneVision의 이해력을 잘 보여준다.

Table 9: LLaVA-OneVision은 정지 이미지 기반으로 상세한 비디오 생성 prompt를 학습한다. 이 능력은 image-to-image language editing generation으로부터 비디오로 일반화된다.

S5: Video-to-Video Difference

Table 10: LLaVA-OneVision은 시작 프레임은 같지만 끝이 다른 비디오 간의 차이점을 분석하는 능력을 학습한다.

Table 10: LLaVA-OneVision은 시작 프레임은 같지만 끝이 다른 비디오 간의 차이점을 분석하는 능력을 학습한다.

S5: Video-to-Video Difference

User What are the differences between the two videos?

LLaVA-OV 첫 번째 비디오는 몸에 녹색과 검은색 줄무늬가 있는 애벌레가 나뭇잎 위에 쉬고 있는 모습을 담고 있습니다. 애벌레의 등에는 흰색의 뻣뻣한 털 같은 구조물이 있습니다. 배경은 흐릿하지만, 녹색 나뭇잎과 햇빛이 비치는 정원 또는 자연 환경으로 보입니다. 두 번째 비디오는 파란색과 검은색 날개를 가진 나비가 나뭇잎 위에 쉬고 있는 모습을 보여줍니다. 나비의 날개에는 흰색 점들이 있고, 날개 밑부분 근처에는 주황색 반점이 있습니다. 배경 또한 흐릿하지만, 녹색 식물이 있는 유사한 정원 또는 자연 환경을 암시합니다. 두 비디오의 차이점은 다음과 같습니다:

1. 첫 번째 비디오는 애벌레를 보여주는 반면, 두 번째 비디오는 나비를 보여줍니다.

2. 애벌레는 녹색과 검은색 줄무늬를 가지고 있는 반면, 나비는 흰색 점이 있는 파란색과 검은색 날개를 가지고 있습니다.

3. 애벌레는 등 부분에 흰색의 뻣뻣한 털 같은 구조물을 가지고 있지만, 나비에게는 이러한 구조물이 없습니다.

4. 나비는 애벌레의 털이 많은 질감에 비해 더 섬세하고 투명한 모습을 가지고 있습니다.

5. 나비의 날개는 펼쳐져 있는 반면, 애벌레는 웅크린 자세를 취하고 있습니다.

6. 나비는 긴 더듬이를 가지고 있지만, 애벌레의 프레임에서는 보이지 않습니다.

Table 11: LLaVA-OneVision은 배경은 유사하지만 전경 객체가 다른 비디오 간의 차이점을 분석하는 방법을 학습한다.

S6: Multi-camera Video Understanding in Self-driving

User 여기에 주행 중인 차량의 네 가지 카메라 뷰를 보여주는 비디오가 있습니다. 위쪽 두 개는 전방 뷰를, 아래쪽 두 개는 후방 뷰를 보여줍니다. 먼저 각 뷰의 비디오를 자세히 설명한 다음, 자율주행 차량(ego car)의 다음 움직임을 계획하십시오.

LLaVA-OV 이 비디오는 주행 중인 차량의 여섯 가지 다른 카메라 뷰로 구성되어 있으며, 세 개의 행과 두 개의 열로 배열되어 있다. 각 뷰는 차량을 다른 각도에서 포착하여 전방 및 후방 시점을 모두 보여준다.

전방 뷰(Front views):

- 첫 번째 이미지는 차량이 보행자 횡단보도가 있는 교차로에 접근하는 모습을 보여준다. 앞에 차량들이 있고, 보행자가 인도에 보인다.

- 두 번째 이미지는 차량이 교차로에 있으며, 보행자가 횡단보도를 건너고 앞에 차량들이 있다. 보행자가 이제 차량에 더 가까이 있다.

- 세 번째 이미지는 보행자가 인도에 보이는 모습을 보여준다.

후방 뷰(Back views):

- 첫 번째 이미지는 차량이 보행자들이 횡단보도를 건너고 옆에 검은색 차량이 있는 교차로에 접근하는 모습을 보여준다.

- 두 번째 이미지는 차량이 교차로에 있으며, 뒤에 여러 대의 차량이 있다.

- 세 번째 이미지는 차량이 교차로를 통과하는 모습을 보여주며, 보행자가 인도에 보인다.

자율주행 차량(ego car)의 다음 움직임은 도로 및 교통 규칙을 준수하며 계속해서 직진하고, 보행자가 길을 건널 때 안전을 확보하는 것이다. 자율주행 차량(ego car)의 다음 움직임은 도로 및 교통 규칙을 준수하며 계속해서 직진하고, 보행자가 길을 건널 때 안전을 확보하는 것이다.

Table 12: LLaVA-OneVision은 자율주행 환경에서 다중 카메라 비디오 영상을 분석하고 해석한다.

S7: Composed Sub-video Understanding

Table 13: LLaVA-OneVision은 구성된 하위 비디오를 자세히 이해하고 설명하는 방법을 학습한다.

Table 13: LLaVA-OneVision은 구성된 하위 비디오를 자세히 이해하고 설명하는 방법을 학습한다.

User LLaVA-OV

비디오의 내용과 레이아웃을 자세히 설명해 주세요. 이 비디오는 방의 중앙에 가려진 전경을 특징으로 하는 일련의 프레임을 보여주며, 이 방은 아마도 게임룸이나 사무실 공간으로 추정된다. 방 벽에는 여러 포스터가 붙어 있고, 갑옷을 입은 휴머노이드 피규어 모델, 그리고 취미나 게임 전용 공간임을 암시하는 다양한 물건들이 놓여 있다. 전경에는 **헤드폰을 착용한 한 사람(아마도 여성)**이 있으며, 무표정하거나 약간 놀란 표정을 짓고 있어 화면 밖의 무언가에 반응하고 있음을 나타낸다.

비디오 전체의 배경은 텔레비전 쇼 "Game of Thrones"의 "House of the Dragon" 시리즈에서 가져온 역동적인 디지털 일러스트레이션이다. 이 시리즈는 "Game of Thrones"의 프리퀄로, 쇼의 가상 세계에서 중요한 가문인 House Targaryen을 중심으로 전개된다. 해당 이미지들은 House Targaryen 구성원을 포함한 시리즈의 등장인물들을 특징으로 한다. 일부 등장인물은 전투 복장을 하고 용을 타고 전투 시나리오에 참여하는 모습이 보인다. 장면들은 White Walkers와 용들의 전투와 같은 쇼의 강렬한 순간들을 묘사하며 세밀하고 생생하다.

비디오는 전경의 인물이 헤드폰을 착용하고 검은 셔츠를 입은 모습으로 시작한다. 그녀 뒤로는 "House of the Dragon"의 일관된 배경이 펼쳐지며, 시리즈의 등장인물들에 초점을 맞춘다. 시리즈의 요소들은 "House of the Dragon" 내러티브의 핵심인 드라마와 긴장감을 불러일으키기 위한 것임이 분명하다.

비디오가 진행됨에 따라, 장면들은 시리즈의 다양한 순간들을 통해 전환된다. 등장인물들은 용을 타거나, 전투에 참여하거나, 강렬한 순간들을 경험하는 등 다양한 시나리오에서 보여진다. 시각 자료는 풍부한 색상과 디테일로 가득하며, 시리즈의 웅장한 스케일과 극적인 분위기를 강조한다. 전경의 게임룸 설정은 비디오 전체에 걸쳐 연속성을 제공한다.

이 비디오는 시리즈의 극적이고 액션으로 가득 찬 장면들을 사용하여 "House of the Dragon"의 본질을 포착한다. 전경의 인물은 일관되게 유지되며, 배경에 제시된 강렬한 순간들에 대한 개인적인 반응 요소를 더한다.

요약하자면, 이 비디오는 게임룸 설정에 있는 차분하고 아마도 놀란 개인과 "House of the Dragon"의 역동적이고 강렬한 장면을 병치시켜, 평화로운 전경과 극적인 배경 사이의 대비를 만들어낸다.

S8: Visual Prompting in Video

Table 14: LLaVA-OneVision은 비디오 콘텐츠에서 강조된(highlighted) 대상에 대한 상세한 설명을 학습한다.

Table 14: LLaVA-OneVision은 비디오 콘텐츠에서 강조된(highlighted) 대상에 대한 상세한 설명을 학습한다.

S9: Referring Image in Video Understanding

Table 15: LLaVA-OneVision의 이미지 및 비디오 참조 이해 능력.

첫 번째 예시에서는 두 이미지에서 동일한 인물을 정확하게 식별한다.

두 번째 예시에서는 이미지와 비디오 모두에서 동일한 인물을 식별하고,

세 번째 예시에서는 해당 인물이 없음을 정확하게 결론 내린다.

이는 이미지 및 비디오 이해 모두에서 시각적 쿼리를 연결하는 LLaVA-OneVision의 이해 능력을 보여준다.

Table 15: LLaVA-OneVision의 이미지 및 비디오 참조 이해 능력.

첫 번째 예시에서는 두 이미지에서 동일한 인물을 정확하게 식별한다.

두 번째 예시에서는 이미지와 비디오 모두에서 동일한 인물을 식별하고,

세 번째 예시에서는 해당 인물이 없음을 정확하게 결론 내린다.

이는 이미지 및 비디오 이해 모두에서 시각적 쿼리를 연결하는 LLaVA-OneVision의 이해 능력을 보여준다.

A Development Roadmap from LLaVA-NeXT to LLaVA-OneVision

LLaVA-OneVision은 2024년 1월부터 6월까지 LLaVA-NeXT 블로그 시리즈 [82, 169, 65, 64, 68]에서 개발된 기술들을 기반으로 구축되었다. 초기 LLaVA-NeXT는 확장 가능하고 확장성 있는 프로토타입을 제공하여 여러 병렬 탐색을 용이하게 했다. 이러한 탐색은 고정된 연산 예산 내에서 수행되었으며, 성능 한계를 뛰어넘기보다는 그 과정에서 유용한 통찰력을 제공하는 것을 목표로 했다. LLaVA-OneVision은 이러한 통찰력을 통합하고 "yolo run" 방식으로 실행한다. 즉, 개별 구성 요소의 위험을 광범위하게 줄이지 않고, 사용 가능한 연산 자원으로 새로운 모델을 구현한다.

Figure 6: LLaVA-NeXT에서 LLaVA-OneVision으로의 개발 타임라인.

Figure 6: LLaVA-NeXT에서 LLaVA-OneVision으로의 개발 타임라인.

1. LLaVA-NeXT:

향상된 추론, OCR, 그리고 세계 지식 [82]

- 블로그: https://llava-vl.github.io/blog/2024-01-30-llava-next/

- 강력한 성능을 가진 LMM을 위한 비용 효율적인 학습 레시피

2. LLaVA-NeXT (Video):

강력한 Zero-shot 비디오 이해 모델 [169]

- 블로그: https://llava-vl.github.io/blog/2024-04-30-llava-next-video/

- AnyRes 디자인 덕분에 시각 신호를 처리할 수 있게 된 이미지 전용으로 학습된 LLaVA-NeXT 모델은 zero-shot modality transfer를 통해 비디오 task에서 놀랍도록 강력한 성능을 보여준다. 비디오에 대한 AI 피드백을 활용한 DPO 학습은 추가적으로 상당한 성능 향상을 가져올 수 있다.

3. LLaVA-NeXT (Stronger):

더 강력한 LLM이 실제 환경에서의 멀티모달 능력을 강화한다 [65]

- 블로그: https://llava-vl.github.io/blog/2024-05-10-llava-next-stronger-llms/

- LLaMA3 (8B) 및 Qwen (72B & 110B)을 지원하는 동일한 비용 효율적인 레시피를 사용한다. LLM을 단순히 확장하는 것만으로도 특정 벤치마크에서 GPT-4V의 성능에 근접한다. 일상생활 시각 채팅을 위한 평가 벤치마크인 **LLaVA-Bench (Wilder)**를 개발했다.

4. LLaVA-NeXT (Ablation):

데이터 외에 Visual Instruction Tuning에 영향을 미치는 요소는 무엇인가? [64]

- 블로그: https://llava-vl.github.io/blog/2024-05-25-1lava-next-ablations/

- **아키텍처 선택(LLM 및 Vision Encoder 스케일링), 시각적 표현(해상도 및 토큰 수), 학습 전략(학습 가능한 모듈 및 고품질 데이터)**에 대한 ablation 연구를 수행하였다.

5. LLaVA-NeXT (Interleave):

Tackling Multi-image, Video, 3D in Large Multimodal Models [68]

- 블로그: https://llava-vl.github.io/blog/2024-06-16-llava-next-interleave/

- **새로운 학습 데이터(M4-Instruct)와 벤치마크(LLaVA-Interleave Bench)**를 통해 **multi-image, multi-frame (비디오), multi-view (3D)**를 포함한 새로운 시나리오로 기능을 확장한다.

B Author Contributions

- Bo Li는 LLaVA-OneVision 코드베이스 유지보수에 기여했으며, 이전 LLaVA-NeXT 시리즈를 기반으로 LLaVA-OneVision 모델의 모든 단계(단일 이미지, 다중 이미지, 비디오 데이터를 포함한 단계)에 대한 대규모 학습을 수행했습니다. 그는 LLaVA-NeXT-Ablations [64]와 같은 단일 이미지 개발, 고품질 recpationing, 그리고 단일 이미지 데이터 혼합의 수집 및 큐레이션에 크게 기여했습니다.

- Yuanhan Zhang은 LLaVA-NeXT-Video [169]의 일련의 작업에 기여했으며, 여기에는 비디오 학습 및 추론 코드베이스, 고품질 비디오 데이터 생성을 위한 효과적인 파이프라인, 그리고 모든 비디오 학습 데이터가 포함됩니다.

- Dong Guo는 단일 이미지 데이터 혼합의 수집 및 큐레이션에 기여했으며, 프로젝트 전반에 걸쳐 지속적으로 기술 지원을 제공했습니다.

- Feng Li, Renrui Zhang, Hao Zhang은 LLaVA-NeXT-Interleave [68]에 기여했으며, 여기에는 **다중 이미지 지시 데이터 혼합, 다중 이미지 평가 벤치마크, 그리고 LLaVA-OneVision의 초기 프로토타입(즉, 단일 이미지, 다중 이미지, 비디오를 사용한 공동 학습 단계)**이 포함됩니다. 그들은 또한 단일 이미지 데이터 혼합의 수집 및 큐레이션에도 기여했습니다.

- Kaichen Zhang은 학습 코드베이스를 유지보수하고 LLaVA-OneVision 모델을 LMMs-Eval의 평가 파이프라인에 통합하는 데 기여했습니다.

- Yanwei Li는 논문 수정에 기여했습니다.

- Ziwei Liu는 프로젝트 전반에 걸쳐 가치 있는 제안을 했습니다.

- Chunyuan Li는 일련의 프로젝트를 시작하고 이끌었으며, 로드맵과 마일스톤을 설계하고 실행을 주도했으며, 논문 작성을 이끌었습니다.

C Implmenetation Details

C. 1 Token Strategy for Mixed-Modality Data

우리는 Figure 3에 나타난 LLaVA-OneVision 아키텍처 내에서 혼합 모달리티(mixed-modality) 데이터를 처리하기 위한 토큰 전략을 상세히 설명한다.

**단일 이미지 데이터(single-image data)**의 경우, 이전에 블로그 [64]에서 설명된 AnyResMax-9 전략을 사용한다. SO400M [158]을 Vision Encoder로 활용하여, 각 입력 이미지(또는 그리드)는 729개의 visual token으로 처리된다. 결과적으로, 단일 이미지에 대한 최대 visual token 수는 이며, 여기서 는 기본 토큰을 나타내고 는 그리드 토큰을 나타낸다.

**다중 이미지 데이터(multi-image data)**의 경우, 간단한 패딩 전략을 사용한다. 각 이미지는 SO400M의 요구사항에 따라 종횡비를 유지하면서 zero-padding을 통해 프레임에 맞게 크기가 조정된다. vision encoder를 통해 처리된 후, 토큰에서 zero-padding은 제거된다. 우리의 학습 데이터는 인스턴스당 최대 12개의 이미지를 포함하며, 이는 최대 개의 다중 이미지 토큰을 생성한다.

**비디오 데이터(video data)**의 경우, LLaVA-NeXT-Video [169]와 유사한 전략을 채택한다. 각 프레임은 vision encoder를 통해 처리된 다음, bilinear interpolation을 거쳐 프레임당 196개의 토큰을 생성한다. 우리는 비디오당 최대 32프레임을 샘플링하며, 이는 최대 개의 비디오 토큰으로 이어진다.

Figure 3에서 볼 수 있듯이, 서로 다른 모달리티 간의 최대 토큰 수는 대략적으로 동일하다. 이러한 설계 전략은 다양한 모달리티의 데이터 균형을 맞추어, language model의 관점에서 전이 가능한 보다 공평한 표현을 보장하는 것을 목표로 한다. 예를 들어, 고해상도 이미지는 여러 이미지의 구성으로 해석될 수 있으며, 여러 이미지는 더 짧은 비디오로 이해될 수 있다.

C. 2 Language Templates and Special Tokens

우리는 Qwen-2 시리즈 [148] language model을 OpenAI의 ChatML 템플릿을 사용하여 활용한다. 학습 시, 이전 LLaVA 모델들을 따라 <image>를 이미지 토큰의 마커로 채택한다. 이 이미지 특수 토큰은 토큰화 후 입력 인덱스에서 -200으로 표현된다. 다중 이미지 시나리오에서는 여러 개의 <image>를 텍스트와 함께 interleave하여 이미지의 위치를 나타낸다. 비디오 시나리오에서는 비디오 포함을 나타내기 위해 시작 부분에 단일 <image>를 배치한다.

이미지 토큰 처리와 관련된 또 다른 측면은 데이터에 불필요한 <image>가 없도록 하는 것이다. 예를 들어, 일부 코드 작성 task에서는 HTML 코드와 관련된 <image>...</image>가 있을 수 있다. 잠재적인 오해를 피하기 위해, 우리는 Magpie [144] 및 Screen2Words [134] 데이터셋에서 이러한 샘플 약 10개를 수동으로 제거했다.

D Evaluation Steers Development

D. 1 Post-Evaluation as a Development Tool

우리는 포괄적인 평가 툴킷인 **LMMs-Eval [161]**을 활용하여, 각 학습 실험이 완료된 후 **선별된 벤치마크 세트에 대한 사후 평가(post-evaluation)**를 수행한다. 벤치마크 선택 기준은 대상 시나리오가 충분히 중요하고 구체적인지 여부에 기반한다. 이러한 평가는 너무 많은 자원을 소모해서는 안 된다. 즉, 벤치마크는 너무 많은 항목을 포함하거나, 평가에 너무 오랜 시간이 걸리거나, (판단 모델로 GPT-4V를 사용할 경우) 많은 수의 GPT-4V 토큰을 소비해서는 안 된다. 모델 개발 과정에서 우리는 **AI2D [54], ChartQA [101], DocVQA [103], InfoVQA [102]**를 통해 테이블, 차트, 다이어그램에 대한 모델의 세밀한 이해도를 평가한다. 또한, **MME [28]**는 Yes 또는 No 답변만을 요구하므로 포맷팅 제어 능력을 평가하는 데 사용한다. 이 외에도 **MMBench-Dev [86]와 MMMU-Val [157]**을 포함하여 다학제적 평가를 수행한다. 이러한 벤치마크에서 빠르게 평가 결과를 얻는 것은 모델 개발 및 데이터 큐레이션의 다음 단계를 안내하는 데 중요한 역할을 한다.

D. 2 Improving Model Performance on Key Scenarios

개발 과정에서 우리는 정적 평가 벤치마크를 성능 지표로 활용하는 것의 중요성을 점차 인식하게 되었다. 이 단계에서 우리의 주된 목표는 특정 데이터셋에 모델을 과적합시켜 예외적으로 높은 성능을 달성하는 것이 아니다. 대신, 우리는 GPT-4V의 성능을 기준으로 목표 임계값(예: 초기 80%에서 점진적으로 95%~100%로 증가)을 설정하여 모델을 벤치마킹한다. 모델이 정적 평가에서 점수 요구 사항을 충족하면, 이는 선택된 시나리오에서 모델이 충분한 능력을 갖추고 있음을 나타낸다. 또한, AI2D의 테스트 데이터조차 특정 문제가 있을 수 있으므로 벤치마크 결과만을 맹목적으로 추구할 수는 없다.

궁극적으로 우리의 초점은 모델의 시각적 채팅 및 추론 능력을 최적화하는 데 있다. 이 단계에서 우리는 **MathVista [90], LLaVA-Wilder [65], MM-LiveBench [171], Vibe-Eval [112]**와 같은 벤치마크에서 모델의 성능을 모니터링했다. 이러한 벤치마크는 모델이 도전적인 질문으로 시각적 대화에 참여하고, 광범위한 세계 지식을 바탕으로 다양한 기술 세트를 요구한다. 이는 실제 시나리오에서 강력한 일반화 능력을 가진 모델을 만드는 데 도움이 된다.

D. 3 Evaluation Task Information

이 섹션에서는 평가에 사용된 모든 task에 대한 정보를 제공한다. 특히, 우리는 **LMMs-Eval 프레임워크의 기본 post_prompt 및 pre_prompt**를 사용한다. 이 prompt들은 우리의 이전 연구인 LLaVA-NeXT [65, 169, 68]의 평가와 일관성을 유지한다. 아래 표는 LMMs-Eval에서 사용된 특정 task와 해당 task 이름을 자세히 보여준다.

Tasks Information

- Single-image:

- ai2d, chartqa, docvqa_val, infovqa_val, mme, realworldqa, mathvista_testmini, llava_in_the_wild, mmvet, mmbench_en_dev, ocrbench, mmmu, llava_wilder_small, vibe_eval, wildvision_0617, live_bench_2406, mathverse_testmini_vision, seedbench, scienceqa_img, mmstar, dc100_en

- Videos:

- activitynetqa, videochatgpt, nextqa_mc_test, egoschema, video_dc499, videmme, videomme_w_subtitle, perceptiontest_val_mc, mlvu, mvbench

- Multi-image:

- llava_interleave_bench, muirbench

여기에 나열된 task 이름을 참조하여, 독자들은 **생성 인자(generation arguments)**와 특정 prompt 정보를 직접 확인할 수 있다. 예를 들어, tasks=ai2d에 대한 세부 정보는 lmmseval/ai2d에서 확인할 수 있다. 이러한 설정을 따르면 연구자들은 우리의 결과를 쉽게 재현할 수 있다.

E Data Curation Roadmap of LLaVA-NeXT Series

이 섹션에서는 LLaVA-NeXT 시리즈의 데이터 큐레이션에 대한 심층적인 경험과 로드맵을 제공한다. 강력한 멀티모달 성능을 달성하기 위해서는 다양한 소스에서 고품질 데이터를 수집하고 큐레이션하는 것이 필수적이며, 이는 모델의 일반화 능력에 결정적인 역할을 한다.

E. 1 Single-Image Data Curation

주요 데이터 소스로서, 단일 이미지 데이터에 대한 우리의 원칙은 항상 품질이 양보다 우선한다는 것이었다. 제한된 자원 내에서 우리는 고품질 데이터를 사용하여 성능을 극대화하고자 노력한다.

LLaVA-NeXT 모델(LLaVA-NeXT-Vicuna-7B/13B, Mistral-7B, Hermes-Yi-34B)의 첫 번째 버전은 약 760K개의 데이터 샘플 [82]로 구성되며, 여기에는 LLaVA-1.5 [81]에서 665K개, AI2D [53]에서 3,247개, ChartQA [101]에서 18,317개, DocVQA [103]에서 10,194개, DVQA [49]에서 20,000개, SynthDOG-EN [58]에서 40,093개, 그리고 LLaVA 데모의 사용자 요청에서 GPT-4V로 재주석된 15,131개 샘플이 포함된다. 다음 반복에서는 COCO Caption [78]에서 20,000개 샘플을 추가하여 새로운 790K 버전을 만들었다. 이 790K 데이터셋은 LLaVA-NeXT 모델의 두 번째 릴리스(LLaVA-NeXT-LLaMA3-8B, LLaVA-NeXT-Qwen-72B, LLaVA-NeXT-Qwen-110B)를 지원했다.

이후 데이터 수집 과정에서는 인터넷에서 공개된 데이터셋을 축적하고, Qwen-VL [8], DeepSeek-VL [89], Intern-VL [22], Vision-Flan [146], UReader [150], Idefics-2 (Cauldron) [63], Cambrian과 같은 다른 고급 LMM들의 데이터 수집 프로세스를 참고했다. 데이터 반복 과정에서 우리는 초기 LLaVA-1.5 전략을 엄격히 준수했다. 각 데이터셋에 대해 수동으로 품질과 QA 형식을 검사하고 확인했다. 또한, 서로 다른 소스의 데이터가 충돌 없이 호환되도록 특정 형식화 프롬프트(formatting prompt)를 설계했다.

AI2D 및 ChartQA와 같은 일부 데이터 소스는 다른 데이터셋 컬렉션에도 나타나 중복될 수 있다. Cauldron은 특별한 형식화 프롬프트를 포함하므로, 해당 데이터를 재형식화하는 것이 쉽지 않다. 따라서 우리는 원시 형식에 더 가까운 다른 컬렉션의 데이터를 우선적으로 사용했다. Cambrian 데이터셋의 경우, GPT-4o로 재주석된 데이터의 일부만 선택했다. 또한 MathV 및 MAVIS 데이터셋에서 수학 관련 데이터를 수집했다.

순수 언어 데이터의 경우, LLaVA 1.5 버전부터 사용해오던 ShareGPT [121] 텍스트 데이터를 교체했다. 우리의 가장 큰 Qwen2-72B 모델이 언어 task에서 최신 GPT-4 모델에 근접한 성능 수준을 달성했음을 고려할 때, 언어 능력을 유지하거나 더욱 향상시키기 위해 더 높은 품질의 언어 데이터를 사용해야 했다. 이를 위해 우리는 사용 가능한 최고 품질의 언어 SFT 데이터인 Magpie-Pro 데이터셋 [144]을 확보했다.

위에서 언급된 과정을 거쳐, 우리는 약 4백만 개의 원시 SFT 데이터 샘플을 확보했으며, 이들의 품질과 정확성을 보장했다. 또한, Azure의 OpenAI GPT-4V 및 GPT-4o 서비스를 활용하여 원래 데이터에서 충분히 다루지 않았지만 중요한 시나리오에 초점을 맞춰 데이터를 재주석했다. 이러한 시나리오는 다음과 같다:

(1) 차트 및 다이어그램에 대한 상세 설명: 이 시나리오를 위해 AI2D 및 InfoVQA 훈련 세트의 이미지를 사용하고 GPT-4V를 활용하여 이미지에 대한 상세 설명을 제공했다. 그 결과 AI2D에 대해 4,874개, InfoVQA에 대해 1,992개의 상세 설명 샘플을 얻었다.

(2) 중국어: LLaVA-158K 데이터셋의 이미지를 사용하고 GPT-4o를 활용하여 중국어로 상세 설명을 제공했으며, 총 91,466개의 샘플을 얻었다.

(3) 다중 턴 대화: LLaVA-158K 데이터셋을 사용하여 GPT-4o로 대화당 평균 3턴 이상인 긴 대화를 생성했으며, 총 26,048개의 샘플을 얻었다.

자원이 허락하는 경우, 초기 데이터 소싱 단계에서 사용했던 데이터 검증 프로세스를 권장한다. 새로 추가된 각 데이터 소스 또는 컬렉션(선택된 데이터 소스가 컬렉션을 형성할 수 있는 경우)에서 약 100K개의 샘플을 추출하여 790K 버전의 데이터셋에 추가한다. 새로 추가된 데이터는 SO400M-Qwen-1.5-0.5B 실험 설정에서 검증한다. 새로운 데이터 추가로 인해 기준선 대비 성능이 하락하는 경우, 데이터를 추가로 수동 검사하고 그에 따라 형식화 프롬프트를 조정한다. 이 단계는 풍부한 자원이 필요하며, 일반적인 인간 주석가로는 대체할 수 없으므로 고도로 전문적인 연구원이 수행해야 한다.

수집 과정에서 우리는 데이터셋에 두 가지 태그를 수동으로 지정했다:

{General, Language, Math/Reasoning, General OCR, Doc/Chart/Screen} 및 {Fixed-form, Free-form}.

이러한 태그를 기반으로 320만 개의 단일 이미지 데이터 샘플의 최종 분포를 형성했다.

초기 분포부터 free-form (대부분 GPT-4V/o로 주석된) 데이터의 양을 점진적으로 늘리면서 다양한 벤치마크에서 모델의 성능을 관찰하고 균형을 맞추려고 노력했다. 이러한 벤치마크에는 AI2D [54], MME [28], MMMU [157], MathVista [90]와 같은 학술 데이터셋과 LLaVA-Wilder [65], VibeEval [112]와 같은 시각 대화 데이터셋이 포함된다. 궁극적으로 우리는 7B 설정에서 단일 이미지 task에 대한 최적의 데이터 분포를 점진적으로 확립했다.

E. 2 OneVision Data Curation

단일 이미지 데이터 외에도, 우리는 더 넓은 범위의 시각 시나리오를 지원하기 위해 다중 이미지 및 비디오 데이터셋을 통합한다. 우리는 LLaVA-OneVision이라는 하나의 프레임워크로 다양한 데이터 모달리티 간의 균형 잡힌 능력과 전반적으로 우수한 성능을 달성하는 것을 목표로 한다.

다중 이미지 데이터의 경우, 우리는 LLaVA-NeXT-Interleave [68]의 M4-Instruct 데이터셋 내에 있는 다양한 interleaved multimodal task를 채택한다. 이 데이터셋은 주로 다음과 같은 일반적인 다중 이미지 task로 구성된다:

- 차이점 찾기 (spotting the difference)

- 시각적 스토리텔링 (visual story telling)

- 이미지 편집 지시 생성 (image editing instruction generation)

- interleaved 다중 이미지 대화 (interleaved multi-image dialogue)

- 다중 이미지 퍼즐 (multi-image puzzle)

- 저수준 다중 이미지 평가 (low-level multi-image assessment) 등.

또한, 우리는 M4-Instruct의 multi-view 데이터셋을 활용하여 3D 세계의 공간 정보를 나타내는데, 여기에는 embodied VQA (대화 및 계획) 및 **3D scene VQA (captioning 및 grounding)**가 포함된다.

비디오 데이터의 경우, 먼저 NExT-QA [142] 및 ShareGPT4Video [21]를 포함한 M4-Instruct의 multi-frame 데이터를 통합한다. 그런 다음, 더 상세한 시간적 단서(temporal cues)를 활성화하기 위해, 최근 학술 연구에서 일반적으로 사용되는 여러 데이터셋을 선택하여 재어노테이션하였다. 여기에는 **Charades [124], ActivityNet [155], YouCook2 [172], Ego4D [33]**가 포함된다.

처음에는 caption을 어노테이션하였다. ShareGPT4o [61]를 따라, 우리는 초당 1프레임(FPS)으로 비디오 프레임을 샘플링하고, 사전 정의된 지침을 사용하여 GPT-4o에 비디오 caption 생성을 prompt하였다. 추가적으로, LLaVA-Hound [167]를 따라, 우리는 GPT-4o가 생성한 caption을 사용하여 open-ended 질문-답변 쌍과 해당 multiple-choice 버전을 개발하였다. 또한 GPT-4o를 활용하여 질문-답변 쌍을 생성함으로써, OneVision 학습을 위한 고품질 비디오 데이터를 확보하였다.

E. 3 Detailed Dataset Statistics

우리는 주로 Single-Image 및 OneVision 단계에서 활용된 모든 데이터셋의 통계 정보를 표로 제시한다. 이 정보에는 데이터셋 카테고리, 데이터셋 이름, 샘플 수, 그리고 prompt 유형이 포함된다. 데이터셋 통계는 Table 16에 요약되어 있다.

| Dataset | # Samples | Prompt ID | Dataset | # Samples | Prompt ID |

|---|---|---|---|---|---|

| General (1.14M, 36.1%) | |||||

| AOKVQA [119] | 66160 | 1 | Cambrian (filtered) [133] | 83131 | - |

| CLEVR [48] | 700 | 1 | COCO Caption [78] | 20000 | 9 |

| Hateful Memes [57] | 8500 | 1 | IconQA [95] | 2494 | 5 |

| Image Textualization [114] | 99583 | 11 | LLaVA-158K [83] | 158000 | - |

| LLaVA-Wild (train) [83] | 54517 | - | LLaVAR [168] | 20000 | - |

| OKVQA [99] | 8998 | 1 | RefCOCO [152] | 50586 | 7,8 |

| ScienceQA [93] | 4976 | 5 | ShareGPT4O [121] | 57289 | 11 |

| ShareGPT4V [121] | 92025 | 11 | ST-VQA [11] | 17247 | 1 |

| TallyQA [1] | 9868 | 1 | Vision FLAN [146] | 186070 | - |

| Visual7W [174] | 14366 | 5 | VisText [129] | 9969 | 15 |

| VizWiz [37] | 6614 | 2 | VQARAD [62] | 313 | 1 |

| VQAv2 [4] | 82783 | 1 | VSR [79] | 2157 | 3 |

| WebSight | 10000 | 18 | InterGPS [91] | 1280 | 5 |

| ALLaVA Instruct [16] | 70000 | - | |||

| Doc/Chart/Screen (20.6%, 647K) | |||||

| AI2D (GPT4V Detailed Caption) | 4874 | 12 | AI2D (InternVL [22]) | 12413 | 4 |

| AI2D (Original) [53] | 3247 | 5 | Chart2Text [108] | 26961 | 13 |

| ChartQA [101] | 18317 | 1 | Diagram Image2Text | 300 | 17 |

| DocVQA [103] | 10194 | 1 | DVQA [49] | 20000 | 1 |

| FigureQA [50] | 1000 | 3 | HiTab [23] | 2500 | 1 |

| Infographic VQA [102] | 4404 | 1 | LRV Chart [80] | 1787 | - |

| RoBUT SQA | 8514 | - | RoBUT WikiSQL | 74989 | - |

| RoBUT WTQ | 38246 | 1 | Screen2Words [134] | 15730 | 10 |

| TQA [55] | 1365 | 5 | UReader Caption [150] | 91439 | 9 |

| UReader IE [150] | 17327 | 1 | UReader KG [150] | 37550 | 14 |

| UReader QA [150] | 252954 | 1 | VisualMRC[128] | 3027 | - |

| Math/Reasoning (20.1%,632K) | |||||

| MAVIS Manual Collection [166] | 87358 | 19 | MAVIS Data Engine [166] | 100000 | 19 |

| CLEVR-Math [48] | 5290 | 2 | Geo170K Align [32] | 60252 | - |

| Geo170K QA [32] | 67833 | 19 | Geometry3K [91] | 2101 | 6 |

| GEOS [120] | 508 | 6 | Geometry3K (MathV360K) [92] | 9734 | 6 |

| GeoMVerse (MathV360K) [52] | 9303 | 20 | GeoQA+ (MathV360K) [18] | 17172 | 6 |

| MapQA (MathV360K) [14] | 5235 | 1 | MathQA [2] | 29837 | 19 |

| Super-CLEVR [75] | 8652 | 2 | TabMWP [94] | 45184 | 2 |

| UniGeo [17] | 11959 | 6 | GQA [41] | 72140 | 1 |

| LRV Normal [80] | 10500 | - | RAVEN [159] | 2100 | 3 |

| Visual Genome [59] | 86417 | 7,8 | |||

| General OCR (8.9%,281K) | |||||

| ChromeWriting [137] | 8835 | 21 | HME100K [156] | 74502 | 21 |

| IIIT5K [105] | 2000 | 22 | IAM [100] | 5663 | 22 |

| K12 Printing | 12832 | 22 | OCR-VQA [106] | 80000 | 1 |

| Rendered Text [137] | 10000 | 22 | SynthDog-EN [58] | 40093 | 16 |

| TextCaps [123] | 21952 | 9 | TextOCR-GPT4V [13] | 25114 | 11 |

| Pure Language (450K) (14.3%, 647K) | |||||

| Magpie Pro [144] (L3 MT) | 149999 | - | Magpie Pro (L3 ST) | 150000 | - |

| Magpie Pro (Qwen2 ST) | 149996 | - |

Table 16: LLaVA-OneVision에서 사용된 Single-Image 데이터셋의 상세 통계.

Prompt ID는 Table 18의 ID에 해당하는 Formatting Prompt의 ID를 나타낸다. "-"는 formatting prompt가 사용되지 않았음을 의미한다.

| Dataset | # Samples | Prompt ID | Dataset | # Samples | Prompt ID |

|---|---|---|---|---|---|

| Multi-image Scenarios | |||||

| Spot-the-Diff [46] | 10.8 K | 20 | Birds-to-Words [27] | 14.3 K | 21 |

| CLEVR-Change [113, 39] | 3.9 K | 22 | HQ-Edit-Diff [42] | 7.0 K | 3 |

| MagicBrush-Diff [160] | 6.7 K | 4 | IEdit [127] | 3.5 K | 19 |

| AESOP [118] | 6.9 K | 23 | FlintstonesSV [36] | 22.3 K | 24 |

| PororoSV [74] | 12.3 K | 25 | VIST [132] | 26 K | 4 |

| WebQA [15] | 9.3 K | 8 | TQA (MI) [56] | 8.2 K | 9 |

| OCR-VQA (MI) [107] | 1.9 K | 17 | DocVQA (MI) [103] | 1.9 K | 18 |

| RAVEN [159] | 35 K | 5 | MIT-StateCoherence [43] | 1.9 K | 11 |

| MIT-PropertyCoherence [43] | 1.9 K | 12 | RecipeQA ImageCoherence [147] | 8.7 K | 14 |

| VISION [7] | 9.9 K | 13 | Multi-VQA [69] | 5 K | - |

| IconQA [95] | 34.6 K | - | Co-Instruct [140] | 50.0 K | - |

| DreamSim [30] | 15.9 K | - | ImageCoDe [60] | 16.6 K | - |

| nuScenes [12] | 9.8 K | 10 | ScanQA [6] | 25.6 K | 7 |

| ALFRED [122] | 22.6 K | 16 | ContrastCaption [47] | 25.2 K | - |

| VizWiz (MI) [37] | 4.9 K | 6 | ScanNet [25] | 49.9 K | 7 |

| COMICS Dialogue [44] | 5.9 K | 15 | NLVR2 [126] | 86 K | 26 |

| Multi-frame (Video) Scenarios | |||||

| NExT-QA [142] | 9.5 K | 2 | ActivityNet [155] | 6.5 k | 1 |

| Ego-4D [33] | 0.8 K | 2 | Charades [124] | 23.6 K | 1 |

| YouCook2 [172] | 41.9 K | 2 | ShareGPT4Video [21] | 255 K | - |

Table 17: LLaVA-OneVision에서 사용된 Multi-Image 및 Video 데이터셋의 상세 통계.

Prompt ID는 Table 19의 ID에 해당하는 Formatting Prompt의 ID를 나타낸다. "-"는 formatting prompt가 사용되지 않았음을 의미한다. "MI"는 DEMON [69]에서 가져온 multi-image 버전 데이터셋임을 의미한다.

| ID | Type | Postion | Prompt |

|---|---|---|---|

| 1 | VQA | Tail | Answer the question with a single word (or phrase). |

| 2 | VQA | Head | Hint: Please answer the question and provide the final answer at the end. |

| 3 | VQA (Yes/No) | Tail | Answer the question with Yes or No./Yes or No?/... |

| 4 | Choice | Tail | Answer with the given letter directly |

| 5 | Choice (Option Letter) | Tail | Answer with the option letter from the given choices directly. / Please respond with only the letter of the correct answer. |

| 6 | Choice (Option Letter) | Head | Hint: Please answer the question and provide the correct option letter, e.g., A, B, C, D, at the end. |

| 7 | Region Caption | All | Provide a short description for this region. |

| 8 | Grounding | All | Provide the bounding box coordinate of the region this sentence describes. |

| 9 | Breif Caption | All | Provide a one-sentence caption for the provided image./Create a compact narrative representing the image presented./... |

| 10 | Screen Summarization | All | Summarize the main components in this picture./Provide a detailed account of this screenshot./... |

| 11 | Detailed Caption | All | Describe this image in detail./Explain the visual content of the image in great detail./... |

| 12 | Science Books | All | Here is a diagram figure extracted from some Grade 1-6 science books. InPlease first describe the content of this figure in detail, including how the knowledge visually displayed in the diagram.\nThen start with a section title "related knowledge:", briefly and concisely highlight the related domain knowledge and theories that underly this diagram. Note that you do not need to provide much detail. Simply cover the most important concepts. |

| 13 | Information Extraction | Head | Provide the requested information directly. |

| 14 | Graph Sumarization | All | Please clarify the meaning conveyed by this graph./Explain what this graph is communicating./... |

| 15 | Photo Sumarization | All | Highlight a few significant elements in this photo./Mention a couple of crucial points in this snapshot./... |

| 16 | Chart Sumarization | All | What insights can be drawn from this chart?/Explain the trends shown in this chart./... |

| 17 | OCR | Head | OCR this image section by section, from top to bottom, and left to right. Do not insert line breaks in the output text. If a word is split due to a line break in the image, use a space instead |

| 18 | Diagram Linkage | All | Dissect the diagram, highlighting the interaction between elements./Interpret the system depicted in the diagram, detailing component functions./... |

| 19 | Code Generation | All | Compose the HTML code to achieve the same design as this screenshot. |

| 20 | Choice (with Reasoning) | Head | First perform reasoning, then finally select the question from the choices in the following format: Answer: xxx. |

| 21 | Math Computing | Tail | Round computations to 2 decimal places. |

| 22 | LaTeX OCR | All | Please write out the expression of the formula in the image using LaTeX format. |

| 23 | Text Reading | All | What is written in the image? Answer this question using the text in the image directly./Read and list the text in this image. |

| 24 | Choice (Full Option) | Tail | Please provide your answer by stating the letter followed by the full option. |

Table 18: Single-Image 데이터의 formatting prompt 정보.

"Position"은 prompt 내에서 formatting prompt의 위치를 의미하며, "All"은 formatting prompt 자체가 prompt임을 의미한다. 때로는 동일한 의미를 가진 여러 prompt가 존재할 수 있으며, 이 경우 prompt 열은 "Prompt1/Prompt2/..." 형식으로 표시된다.

| ID | Type | Postion | Prompt |

|---|---|---|---|

| Video | |||

| 1 | Choice (Option Letter) | Tail | Answer with the option letter from the given choices directly. / Please respond with only the letter of the correct answer. |

| 2 | Choice (Full Option) | Tail | Please provide your answer by stating the letter followed by the full option. |

| Multi-Image | |||

| 3 | Open-Ended | Head | What's the difference between 2 images? |

| 4 | Open-Ended | Head | Given the stories paired with the first several images, can you finish the story based on the last image?/With the narratives paired with the initial images, how would you conclude the story using the last picture?/... |

| 5 | Multi-Choice | Head | Here is a Raven's Progressive Matrice in a three-by-three form. You are provided with the first eight elements in eight images, please select the last one from four choices following the structural and analogical relations. |

| 6 | Multi-Choice | All | There are ten possible explanations for the ten different answers to a VQA: ... I will give you two sets of pictures, questions, and answers to determine if they belong to the same 'Question-Answer Differences'. You must choose your answer from the Choice List. |

| 7 | Open-Ended | Head | This is a 3D scenario. |

| 8 | Open-Ended | Head | I will give you several images and a question, your job is to seek information in the slide and answer the question correctly./Based on the images, please answer the following question./... |

| 9 | Multi-Choice | Head | Provided with a series of diagrams from a textbook, your responsibility is to correctly answer the following question. You must choose your answer from the Choice List./Using a selection of textbook diagrams, your task is to provide an accurate response to the subsequent query. You must choose your answer from the Choice List./... |

| 10 | Open-Ended | Head | Given six images taken from different cameras on a street view car, your task is to answer questions about the depicted scene. You must choose your answer from the Choice List. /Upon receiving six photographs captured from various cameras on a street-view car, your responsibility is to provide accurate responses to questions about the scene. You must choose your answer from the Choice List. /... |

| 11 | Multi-Choice | Head | I will provide you with two sets of pictures, each of which shows an object in the opposite state. Can you tell me if the states of these two sets of pictures are the same? You must choose your answer from the Choice List. /I have two sets of pictures that show an object in opposite states. Can you tell me if the states of these two sets of pictures are the same? You must choose your answer from the Choice List. /... |

| 12 | Multi-Choice | Head | Are the following four images of the same class? You must choose your answer from the Choice List. /Do the following four images belong to the same category? You must choose your answer from the Choice List. /... |

| 13 | Multi-Choice | Head | Are these two workpieces the same type?/Are these two workpieces of the same kind?/... |

| 14 | Multi-Choice | Head | Presented with a textual recipe tutorial, your task is to scrutinize it carefully and select the image that is incoherent in the provided sequence of images. You must choose your answer from the Choice List. /Given a text-based recipe guide, your responsibility is to meticulously review it and identify the image that doesn't fit in the following sequence of images. You must choose your answer from the Choice List. /... |

| 15 | Multi-Choice | Head | |

| I will give you a series of comic panels. The dialogue box of the last panel is masked. Can you choose the most relevant one from the candidates? You must choose your answer from the Choice List. /Given previous full panels and one masked panel, your job is to select the most appropriate dialogue among four candidates. You must choose your answer from the Choice List. /... | |||

| 16 | Open-Ended | Head | Give you a main goal, your job is to figure out what to do now by looking at current envirments. Your past views as well as decisions are also provided./Given a primary objective and your current surroundings, use your previous decisions and perspectives to determine your next move./... |

| 17 | Multi-Choice | Head | I will give you two pictures of the book cover. Please look at the pictures and answer a question You must choose your answer from the Choice List. /I will provide you with two images of the book cover. Please examine the images and answer a question. You must choose your answer from the Choice List. /... |

| 18 | Multi-Choice | Head | I will give you some pictures, and each group of pictures will correspond to a question. Please answer it briefly. You must choose your answer from the Choice List. /For each group of pictures, there is a question. Please give a short answer to it. You must choose your answer from the Choice List. /... |

| 19 | Open-Ended | Head | Please give a editing Request to describe the transformation from the source image to the target image./What is the correct image edit instruction that can transfrom the source image to target image?/... |

| 20 | Open-Ended | Head | What's the difference between 2 images? /Identify the alterations between these two images. /... |

| 21 | Open-Ended | Head | What's the difference between 2 birds? /Identify the alterations between these two birds. /... |

| 22 | Open-Ended | Head | What's the difference between 2 images? /Identify the alterations between these two images. /... |

| 23 | Open-Ended | Head | Given the stories paired with the first several images, can you finish the story based on the last image?/With the narratives paired with the initial images, how would you conclude the story using the last picture?/... |

| 24 | Open-Ended | Head | Given the stories paired with the first several images, can you finish the story based on the last image?/With the narratives paired with the initial images, how would you conclude the story using the last picture?/... |

| 25 | Open-Ended | Head | Given the stories paired with the first several images, can you finish the story based on the last image?/With the narratives paired with the initial images, how would you conclude the story using the last picture?/... |

| 26 | Multi-Choice | All | Answer the following multiple-choice question: Here is a statement describing 2 images: ... Is it true or false? |

Table 19: One-Vision 데이터의 formatting prompt 정보.

"Position"은 prompt 내에서 formatting prompt의 위치를 의미하며, "All"은 formatting prompt 자체가 prompt임을 의미한다. 때로는 동일한 의미를 가진 여러 prompt가 존재할 수 있으며, 이 경우 prompt 열은 "Prompt1/Prompt2/..." 형식으로 표시된다.

E. 4 Policy Information and Reproducibility

우리는 사용한 대부분의 공개 데이터셋을 오픈 소스로 공개할 예정이다. 이 이미지와 데이터는 이미 학술 연구를 위해 공개적으로 사용 가능하며, 우리는 이를 통합하고 우리 사용 목적에 맞게 형식을 변환하였다. 그러나 사용자 데이터와 관련된 일부 데이터 소스 및 Azure OpenAI Service를 사용하여 얻은 데이터는 회사 정책상 직접 공개할 수 없다. 우리는 최종 재현 스크립트에서 사용된 정확한 데이터 YAML 파일을 제공할 것이며, 컴퓨팅 자원이 허용하는 한 완전히 공개된 데이터를 사용하여 재현 가능한 실험 스크립트, 학습 로그, 그리고 최종 버전의 체크포인트를 제공할 것이다.