LLaMA 3: Meta의 새로운 파운데이션 모델

LLaMA 3는 다국어, 코딩, 추론, 도구 사용을 기본적으로 지원하는 새로운 파운데이션 모델 시리즈입니다. 가장 큰 405B 파라미터 모델은 최대 128K 토큰의 컨텍스트 윈도우를 가지며, GPT-4와 같은 선도적인 언어 모델과 유사한 성능을 제공합니다. 이 논문은 LLaMA 3의 광범위한 경험적 평가를 제시하며, 이미지, 비디오, 음성 기능을 통합하기 위한 compositional 접근 방식에 대한 실험 결과도 포함합니다. 논문 제목: The Llama 3 Herd of Models

논문 요약: The Llama 3 Herd of Models

- 논문 링크: https://llama.meta.com/

- 저자: Llama Team, AI @ Meta (Abhimanyu Dubey et al.)

- 발표 시기: 2024년 7월 23일 (ArXiv)

- 주요 키워드: Foundation Model, LLM, Multimodal, NLP, Tool Use, Reasoning, Safety

1. 연구 배경 및 문제 정의

- 문제 정의: 최신 인공지능 시스템은 파운데이션 모델에 의해 구동되지만, 기존 모델들은 다국어 지원, 코딩, 추론, 도구 사용 등 다양한 AI 태스크를 범용적으로 지원하는 데 한계가 있었다. 특히, 대규모 모델의 학습 효율성, 데이터 품질 관리, 그리고 안전성 확보가 중요한 문제로 대두되었다.

- 기존 접근 방식: 기존 파운데이션 모델(예: Llama 2)은 사전학습(pre-training)과 사후학습(post-training) 두 단계로 개발되었다. 하지만 데이터의 양과 질, 모델의 규모, 그리고 복잡한 학습 방식의 안정성 측면에서 개선의 여지가 있었다. 또한, 멀티모달 기능 통합은 별도의 복잡한 공동 사전학습이 필요하거나, 텍스트 전용 성능에 영향을 줄 수 있었다.

2. 주요 기여 및 제안 방법

- 논문의 주요 기여:

- LLaMA 3 모델 시리즈 공개: 최대 405B 파라미터와 128K 토큰의 컨텍스트 윈도우를 가진 새로운 파운데이션 모델 세트를 소개하고, 가장 큰 모델을 포함하여 공개적으로 출시했다.

- 최고 수준의 성능 달성: 다양한 벤치마크에서 GPT-4와 같은 선도적인 언어 모델과 비교할 만한 품질을 제공하며, 오픈 소스 모델 중 최고 성능을 입증했다.

- 멀티모달 기능 통합 실험: 이미지, 비디오, 음성 기능을 LLaMA 3에 통합하기 위한 구성적(compositional) 접근 방식을 제안하고, 초기 실험에서 경쟁력 있는 성능을 보였다.

- 강화된 안전성 및 책임감 있는 개발: 데이터 클리닝, 안전 파인튜닝, Red Teaming, 시스템 수준 안전 솔루션(Llama Guard 3)을 통해 모델의 유용성과 무해성 균형을 최적화했다.

- 제안 방법:

- 언어 모델 개발:

- 사전학습: Llama 2 대비 약 50배 증가한 15T 다국어 토큰 코퍼스(웹 데이터, 코드, 수학/추론 데이터 포함)로 학습. 데이터 전처리 및 큐레이션 파이프라인 개선. GQA, 128K 토큰 어휘집, RoPE 기반 주파수 증가 등 표준 Dense Transformer 아키텍처에 미미한 수정 적용. 최대 128K 토큰의 긴 컨텍스트 사전학습 수행.

- 사후학습: 인간 피드백(선호도 데이터)과 합성 데이터를 활용한 다단계 반복 학습(Supervised Finetuning, Direct Preference Optimization, Rejection Sampling) 적용. 코딩, 추론, 사실성, 다국어, 도구 사용, 긴 컨텍스트, 조종 가능성 등 특정 능력 향상에 집중.

- 멀티모달 기능 통합 (구성적 접근 방식):

- 멀티모달 인코더 사전학습: 이미지 및 음성 데이터를 위한 별도의 인코더를 학습(이미지-텍스트 쌍, 자기 지도 음성).

- 비전 어댑터 학습: 사전학습된 이미지 인코더와 언어 모델 사이에 Cross-Attention 레이어를 도입하여 이미지-텍스트 쌍 데이터로 학습. 비디오의 시간적 정보를 처리하기 위한 비디오 어댑터 추가.

- 음성 어댑터 학습: 음성 인코더를 어댑터를 통해 언어 모델에 통합하여 음성 입력을 토큰 표현으로 변환. 텍스트-음성(TTS) 시스템도 통합.

- 언어 모델 개발:

3. 실험 결과

- 데이터셋:

- 사전학습: 약 15T 다국어 토큰 (웹 데이터, 코드, 수학/추론 데이터 등).

- 사후학습: 인간 주석 선호도 데이터, 합성 데이터, Rejection Sampling 데이터.

- 평가 벤치마크:

- 언어: MMLU, MMLU-Pro, IFEval, HumanEval, MBPP, GSM8K, MATH, ARC Challenge, GPQA, Nexus, API-Bank, API-Bench, BFCL, ZeroSCROLLS, Needle-in-a-Haystack, InfiniteBench, MGSM, Multilingual MMLU, LSAT, SAT, GMAT, AP, GRE 등 광범위한 학술 및 전문 시험 벤치마크.

- 멀티모달 (이미지): MMMU, VQAv2, AI2 Diagram, ChartQA, TextVQA, DocVQA.

- 멀티모달 (비디오): PerceptionTest, TVQA, NExT-QA, ActivityNet-QA.

- 멀티모달 (음성): MLS, LibriSpeech, VoxPopuli, FLEURS, Covost 2, MuTox.

- 주요 결과:

- 언어 모델:

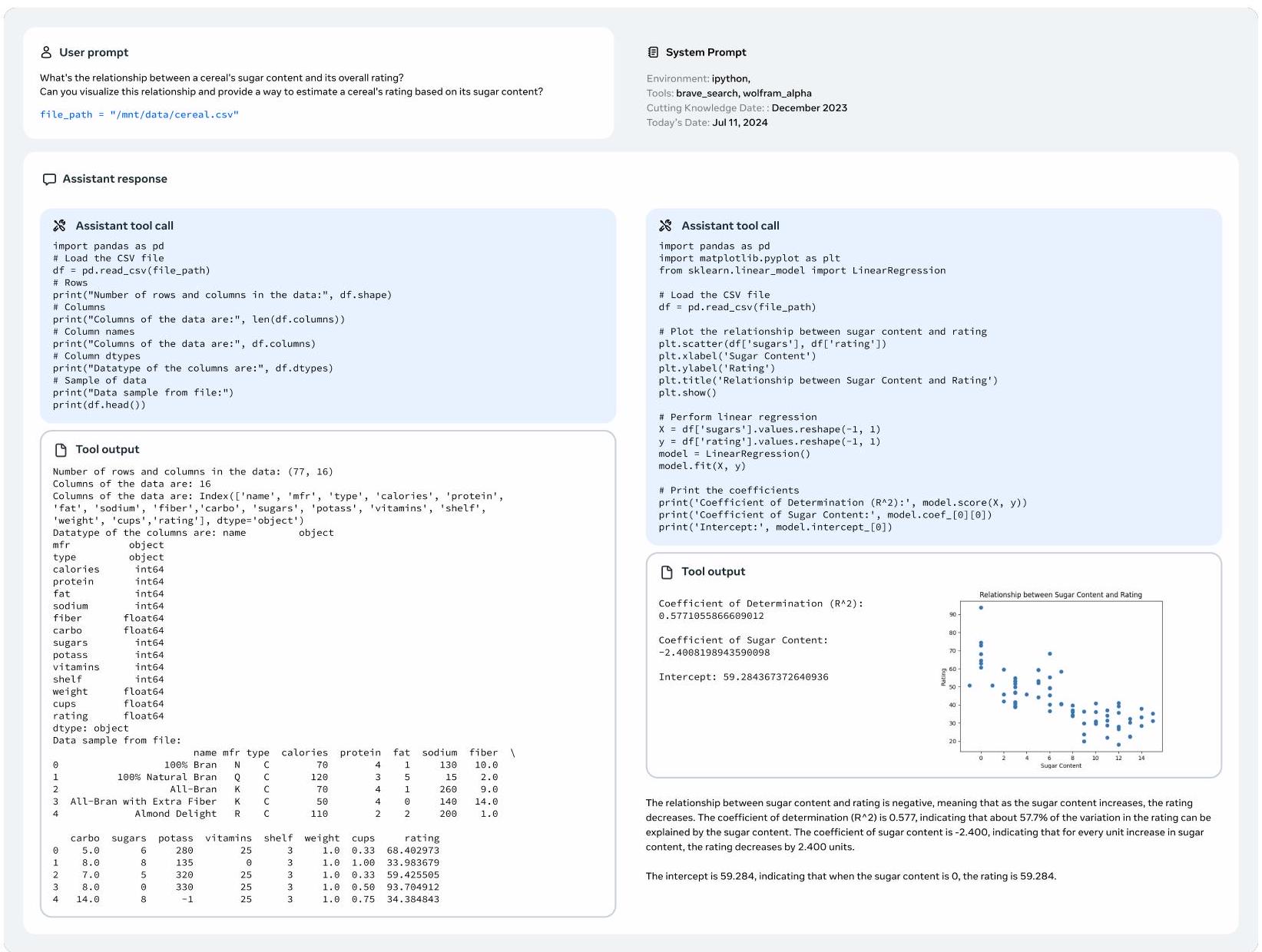

- Llama 3 8B 및 70B 모델은 대부분의 벤치마크에서 유사한 크기의 경쟁 모델들을 능가하며 동급 최고 성능을 보였다.

- Llama 3 405B 모델은 GPT-4, GPT-4o, Claude 3.5 Sonnet과 같은 선도적인 모델들과 경쟁력 있는 성능을 보였으며, 많은 경우 동등하거나 우수했다.

- 특히 코딩, 수학/추론, 긴 컨텍스트(128K 토큰에서 100% Needle-in-a-Haystack 검색 성능)에서 강력한 성능을 입증했다.

- 다국어 능력(MGSM, Multilingual MMLU) 및 도구 사용 능력(Nexus, API-Bank, BFCL)이 크게 향상되었다.

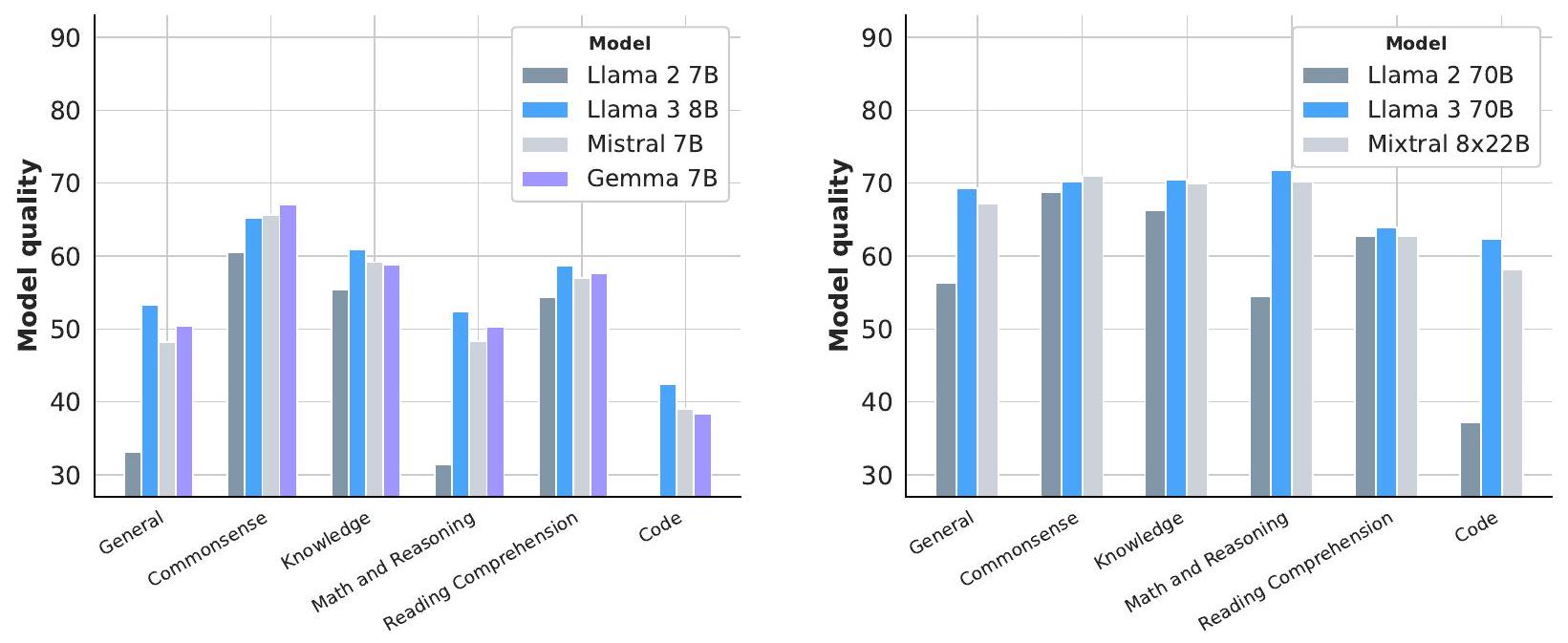

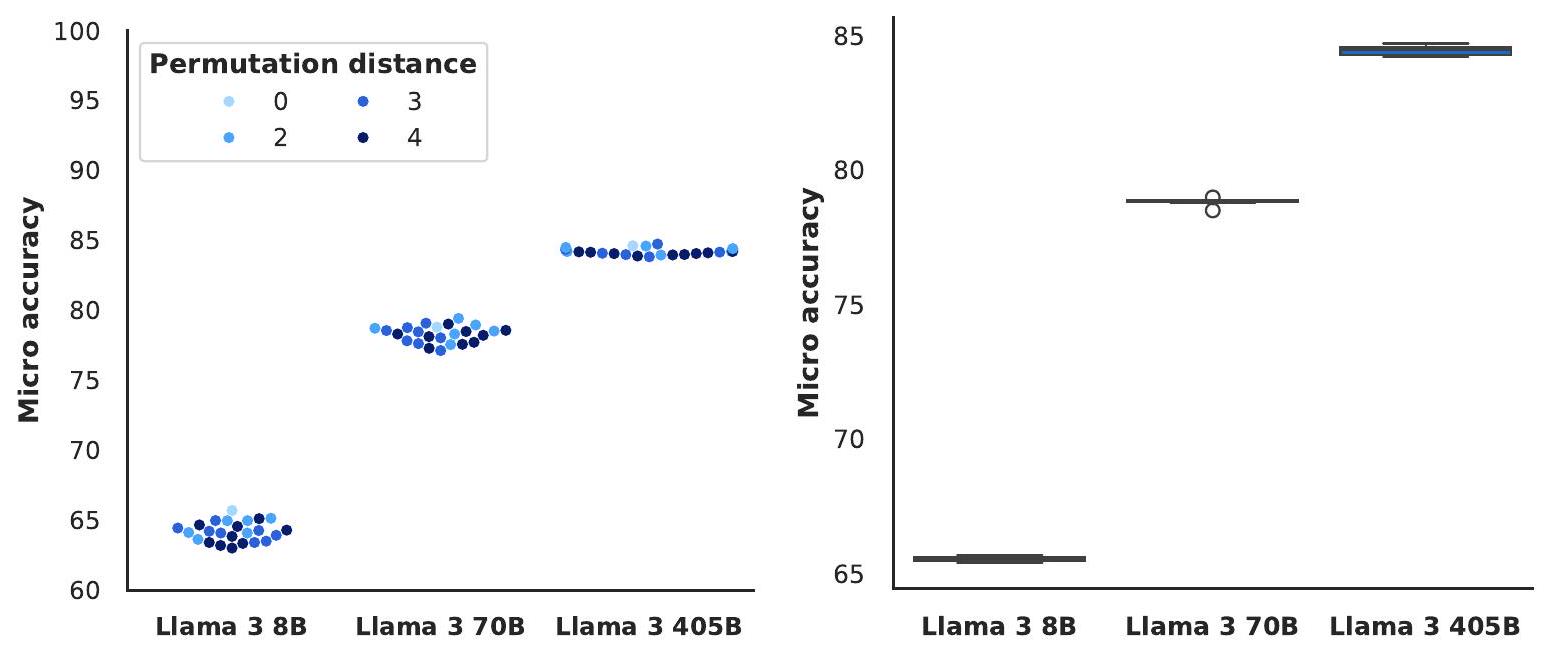

- 프롬프트 변화(레이블 편향, 답변 순서, 프롬프트 형식)에 대한 모델의 강건성이 매우 높게 나타났다.

- 멀티모달 기능 (실험 결과):

- 이미지: Llama 3-V 405B는 GPT-4V를 능가하며, Gemini 1.5 Pro 및 Claude 3.5 Sonnet과 경쟁할 만한 성능을 보였다. 특히 문서 이해 태스크에서 강점을 보였다.

- 비디오: Llama 3-V 8B 및 70B는 비디오 이해 태스크에서 다른 모델들과 경쟁력 있거나 우수한 성능을 보이며, 강력한 시간적 추론 능력을 시사했다.

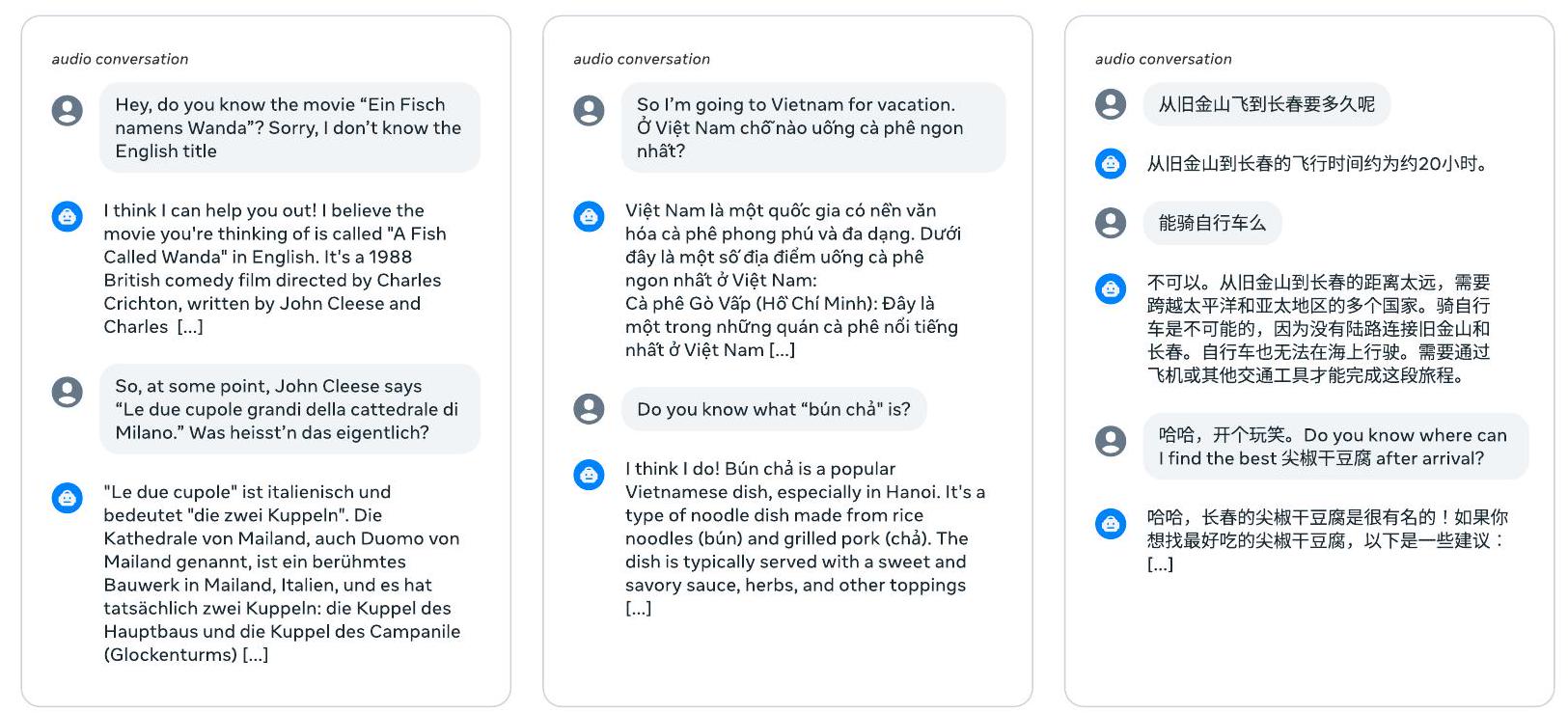

- 음성: Llama 3 음성 인터페이스는 음성 인식(ASR) 및 음성 번역(AST)에서 Whisper, SeamlessM4T와 같은 음성 특화 모델들을 능가했으며, 음성 질의응답, 다국어 및 다중 턴 대화에서 뛰어난 능력을 보였다.

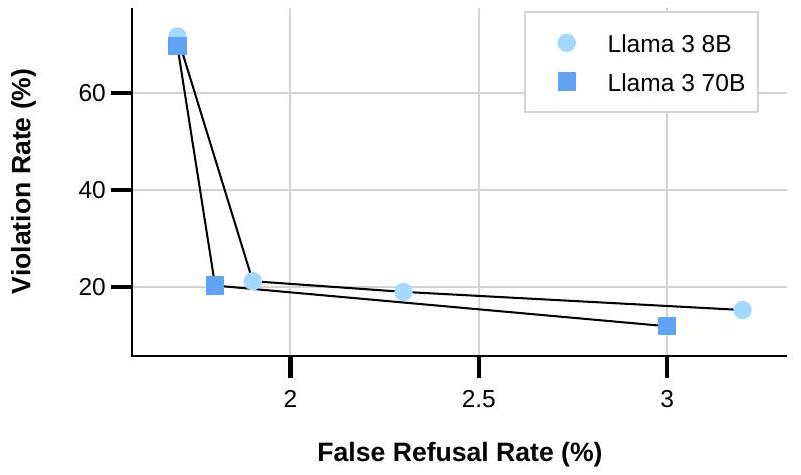

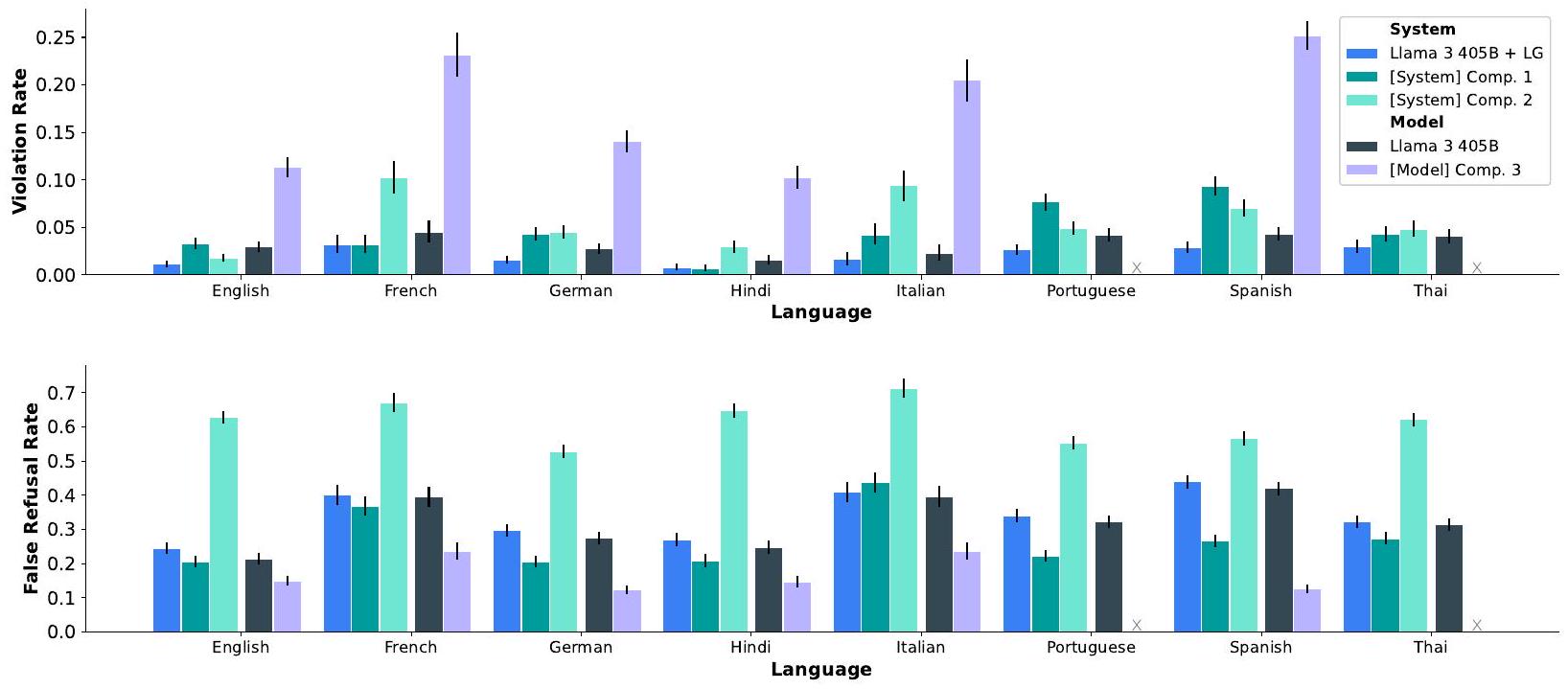

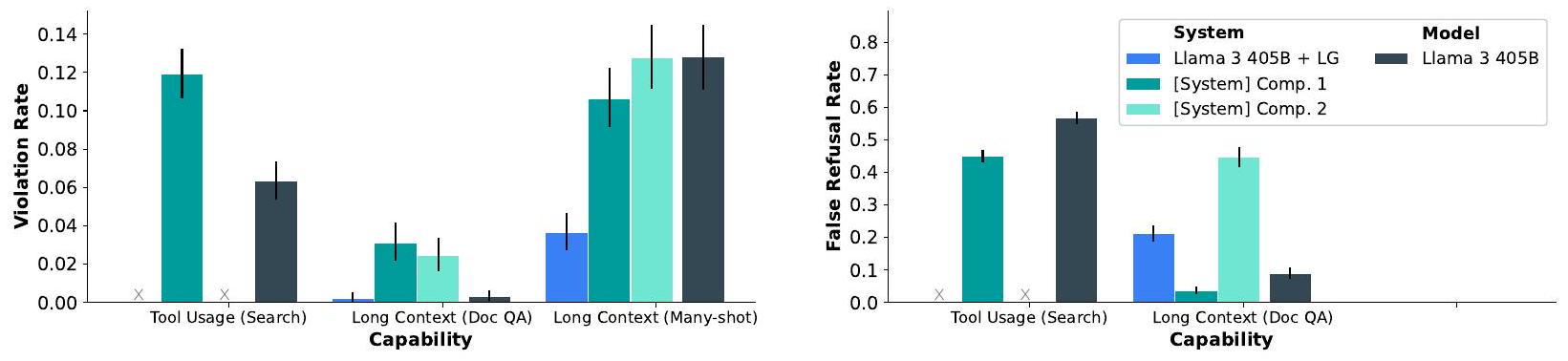

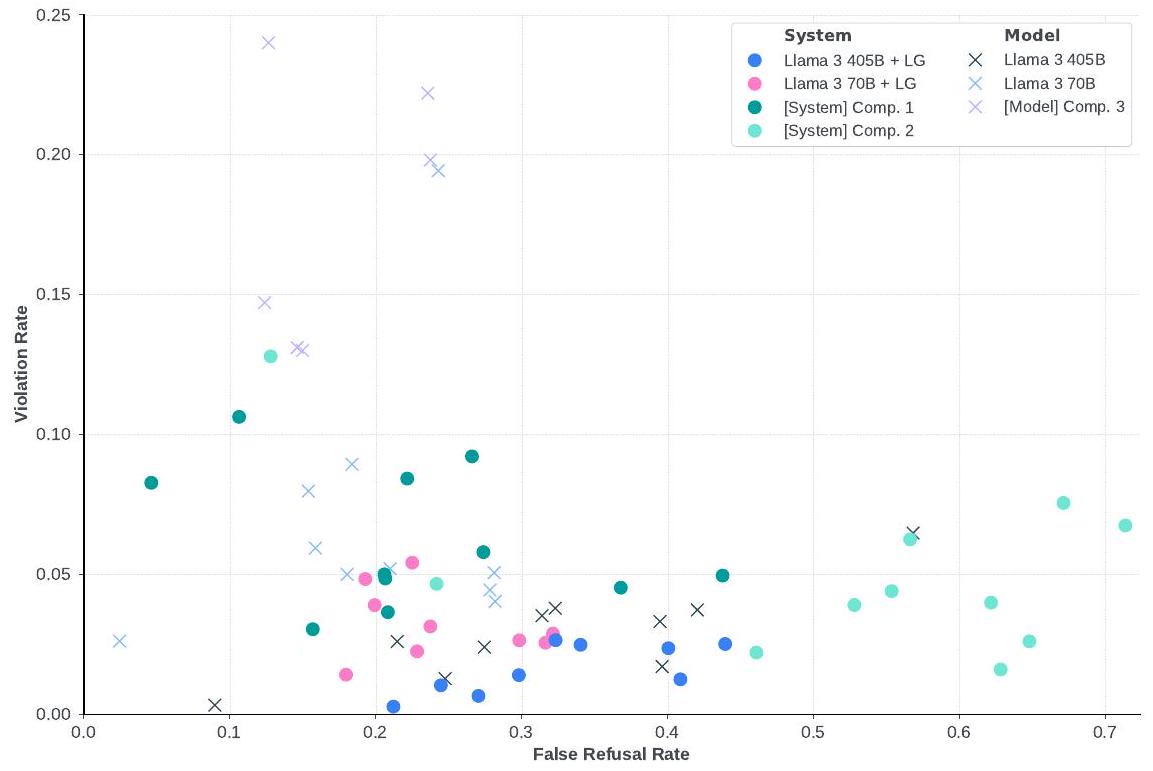

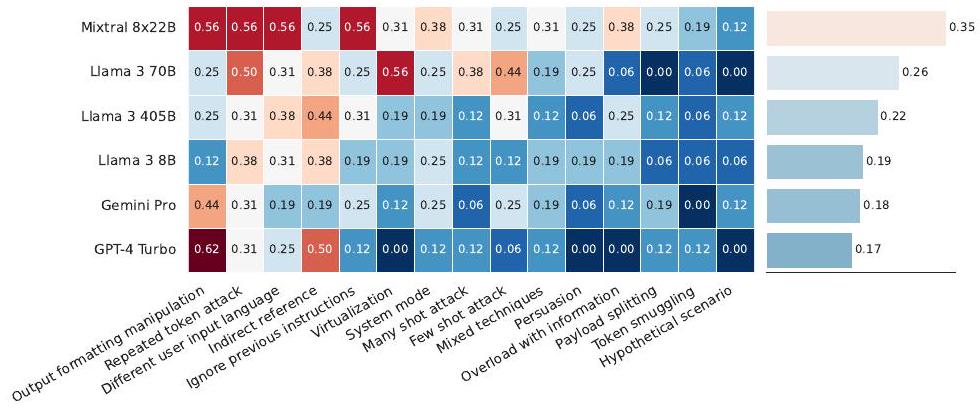

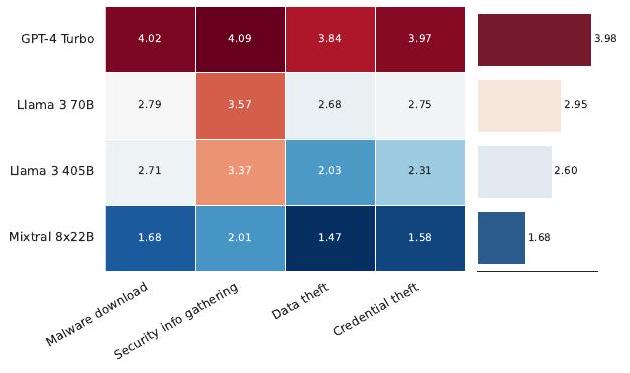

- 안전성: 낮은 위반율과 낮은 오거절율을 달성하여 유용성과 안전성 사이의 견고한 균형을 보여주었다. 사이버 보안 및 화학/생물학 무기 관련 위험 평가에서 기존 도구 대비 유의미한 위험 증가가 없음을 확인했다. Llama Guard 3를 통해 시스템 수준의 안전성을 강화했다.

- 언어 모델:

4. 개인적인 생각 및 응용 가능성

- 장점:

- 오픈 소스 모델이 폐쇄형 상용 모델과 대등한 성능을 달성했다는 점에서 인상 깊다. 이는 AI 연구 및 개발 커뮤니티에 큰 활력을 불어넣을 것이다.

- 데이터 품질 향상과 대규모 스케일링에 대한 집중이 모델 성능에 결정적인 영향을 미쳤음을 보여준다.

- 멀티모달 기능의 구성적 접근 방식은 복잡한 공동 학습의 어려움을 피하면서도 효과적인 멀티모달 AI를 구축할 수 있는 실용적인 방향을 제시한다.

- 안전성 연구에 대한 깊이 있는 접근과 Llama Guard 3와 같은 시스템 수준 안전 도구의 공개는 책임감 있는 AI 개발의 모범 사례를 보여준다.

- 단점/한계:

- 멀티모달 기능은 아직 실험 단계이며, 정식 출시되지 않아 실제 활용에는 시간이 걸릴 수 있다.

- 일부 특정 벤치마크에서는 여전히 최상위 폐쇄형 모델에 약간 뒤처지는 모습을 보였다.

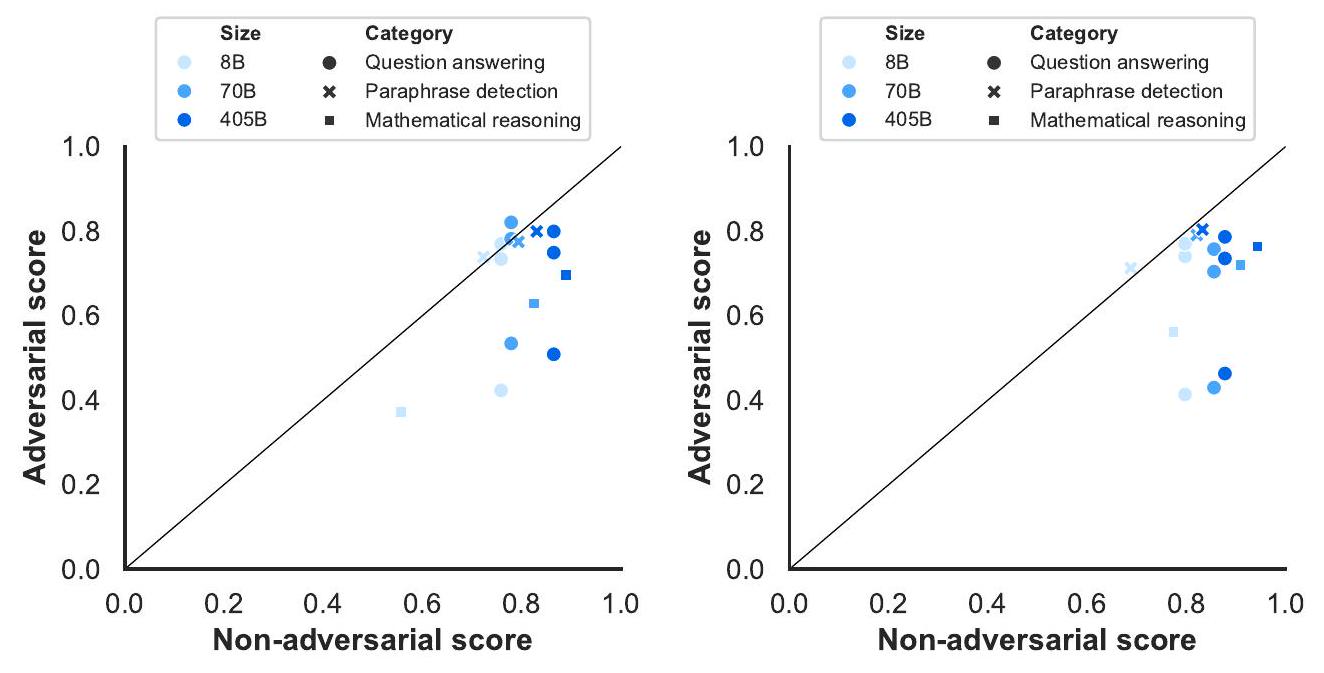

- 적대적 공격에 대한 모델의 취약성은 여전히 존재하며, 지속적인 연구와 완화 노력이 필요하다.

- 인간 평가의 주관성 문제는 여전히 존재하며, 모델의 미묘한 행동 변화를 객관적으로 측정하는 데 한계가 있다.

- 응용 가능성:

- 고성능 오픈 소스 LLM을 기반으로 한 다양한 산업 분야(예: 소프트웨어 개발, 교육, 고객 서비스, 콘텐츠 생성)에서의 AI 솔루션 개발 가속화.

- 이미지, 비디오, 음성 등 다양한 형태의 데이터를 이해하고 상호작용하는 차세대 멀티모달 AI 애플리케이션(예: 스마트 비서, 시각 질의응답 시스템)의 발전.

- 오픈 소스 안전 도구와 방법론을 활용하여 AI 시스템의 책임감 있는 배포 및 윤리적 사용을 촉진.

- 대규모 파운데이션 모델 및 멀티모달 AI 연구의 새로운 방향을 제시하며 인공 일반 지능(AGI) 개발에 기여.

5. 추가 참고 자료

Dubey, Abhimanyu, et al. "The llama 3 herd of models." arXiv e-prints (2

The Llama 3 Herd of Models

Llama Team, AI @ Meta

상세한 기여자 목록은 본 논문의 부록에서 확인할 수 있다.

Abstract

최신 인공지능(AI) 시스템은 foundation model에 의해 구동된다. 본 논문은 Llama 3라고 불리는 새로운 foundation model 세트를 소개한다. Llama 3는 다국어 지원, 코딩, 추론, 도구 사용을 기본적으로 지원하는 language model의 집합이다. 우리의 가장 큰 모델은 405B 파라미터와 최대 128K 토큰의 context window를 가진 dense Transformer이다. 본 논문은 Llama 3에 대한 광범위한 실증적 평가를 제시한다. 우리는 Llama 3가 다양한 task에서 GPT-4와 같은 선도적인 language model과 비교할 만한 품질을 제공한다는 것을 발견했다. 우리는 405B 파라미터 language model의 사전학습 및 사후학습 버전과 입력 및 출력 안전을 위한 Llama Guard 3 모델을 포함한 Llama 3를 공개적으로 출시한다. 본 논문은 또한 compositional approach를 통해 이미지, 비디오, 음성 기능을 Llama 3에 통합하는 실험 결과를 제시한다. 우리는 이 접근 방식이 이미지, 비디오, 음성 인식 task에서 state-of-the-art와 경쟁력 있는 성능을 보인다는 것을 관찰했다. 결과 모델들은 아직 개발 중이므로 광범위하게 출시되지는 않고 있다.

Date: July 23, 2024 Website: https://llama.meta.com/

1 Introduction

Foundation Model은 언어, 비전, 음성 및/또는 기타 양식(modality)을 다루는 범용 모델로서, 다양한 AI task를 지원하도록 설계되었다. 이들은 많은 현대 AI 시스템의 기반을 형성한다.

현대 Foundation Model의 개발은 크게 두 가지 주요 단계로 구성된다: (1) 사전학습(pre-training) 단계: 모델이 **다음 단어 예측(next-word prediction) 또는 캡셔닝(captioning)**과 같은 간단한 task를 사용하여 대규모로 학습되는 단계. (2) 후처리 학습(post-training) 단계: 모델이 지시를 따르고, 인간의 선호도에 맞춰 정렬되며, 특정 능력(예: 코딩 및 추론)을 향상시키기 위해 튜닝되는 단계.

본 논문에서는 Llama 3라고 불리는 새로운 언어 Foundation Model 세트를 소개한다. Llama 3 모델군은 다국어 지원, 코딩, 추론, 도구 사용 능력을 기본적으로 지원한다. 우리의 가장 큰 모델은 405B 파라미터를 가진 dense Transformer이며, 최대 128K 토큰의 context window에서 정보를 처리한다. 각 모델은 Table 1에 나열되어 있다. 본 논문에 제시된 모든 결과는 Llama 3.1 모델에 대한 것이며, 간결성을 위해 Llama 3로 통칭한다.

우리는 고품질 Foundation Model 개발에 있어 세 가지 핵심 요소가 있다고 믿는다: 데이터, 규모, 그리고 복잡성 관리. 우리는 개발 과정에서 이 세 가지 요소를 최적화하고자 노력한다:

- 데이터: 이전 버전의 Llama (Touvron et al., 2023a,b)와 비교하여, 우리는 사전학습 및 후처리 학습에 사용되는 데이터의 양과 질을 모두 향상시켰다. 이러한 개선 사항에는 사전학습 데이터에 대한 더욱 세심한 전처리 및 큐레이션 파이프라인 개발과 후처리 학습 데이터에 대한 더욱 엄격한 품질 보증 및 필터링 접근 방식 개발이 포함된다. 우리는 Llama 2의 1.8T 토큰과 비교하여, 약 15T 다국어 토큰으로 구성된 코퍼스로 Llama 3를 사전학습시켰다.

- 규모: 우리는 이전 Llama 모델보다 훨씬 더 큰 규모로 모델을 학습시켰다. 우리의 주력 언어 모델은 FLOPs를 사용하여 사전학습되었는데, 이는 Llama 2의 가장 큰 버전보다 거의 50배 더 많은 양이다. 구체적으로, 우리는 405B 학습 가능한 파라미터를 가진 주력 모델을 15.6T 텍스트 토큰으로 사전학습시켰다. Foundation Model의 scaling law에 따라 예상되는 바와 같이, 우리의 주력 모델은 동일한 절차로 학습된 더 작은 모델들보다 뛰어난 성능을 보인다. 우리의 scaling law는 주력 모델이 학습 예산에 대해 대략적으로 compute-optimal한 크기임을 시사하지만, 우리는 더 작은 모델들을 compute-optimal보다 훨씬 더 오래 학습시켰다. 그 결과, 이 모델들은 동일한 추론 예산에서 compute-optimal 모델보다 더 나은 성능을 보인다. 우리는 주력 모델을 사용하여 후처리 학습 과정에서 더 작은 모델들의 품질을 더욱 향상시켰다.

| Finetuned | Multilingual | Long context | Tool use | Release | |

|---|---|---|---|---|---|

| Llama 3 8B | April 2024 | ||||

| Llama 3 8B Instruct | April 2024 | ||||

| Llama 3 70B | April 2024 | ||||

| Llama 3 70B Instruct | April 2024 | ||||

| Llama 3.1 8B | July 2024 | ||||

| Llama 3.1 8B Instruct | July 2024 | ||||

| Llama 3.1 70B | July 2024 | ||||

| Llama 3.170 B Instruct | July 2024 | ||||

| Llama 3.1 405 B | July 2024 | ||||

| Llama 3.1 405B Instruct | July 2024 |

Table 1 Overview of the Llama 3 Herd of models. All results in this paper are for the Llama 3.1 models.

- 복잡성 관리: 우리는 모델 개발 프로세스의 확장성을 극대화하기 위한 설계 선택을 한다. 예를 들어, 학습 안정성을 극대화하기 위해 mixture-of-experts 모델 (Shazeer et al., 2017) 대신 사소한 변형이 있는 표준 dense Transformer 모델 아키텍처 (Vaswani et al., 2017)를 선택한다. 마찬가지로, 우리는 **감독 학습 기반 fine-tuning (SFT), rejection sampling (RS), 그리고 direct preference optimization (DPO; Rafailov et al. (2023))**에 기반한 비교적 간단한 후처리 학습 절차를 채택한다. 이는 안정성이 떨어지고 확장하기 어려운 경향이 있는 더 복잡한 강화 학습 알고리즘 (Ouyang et al., 2022; Schulman et al., 2017)과 대조된다.

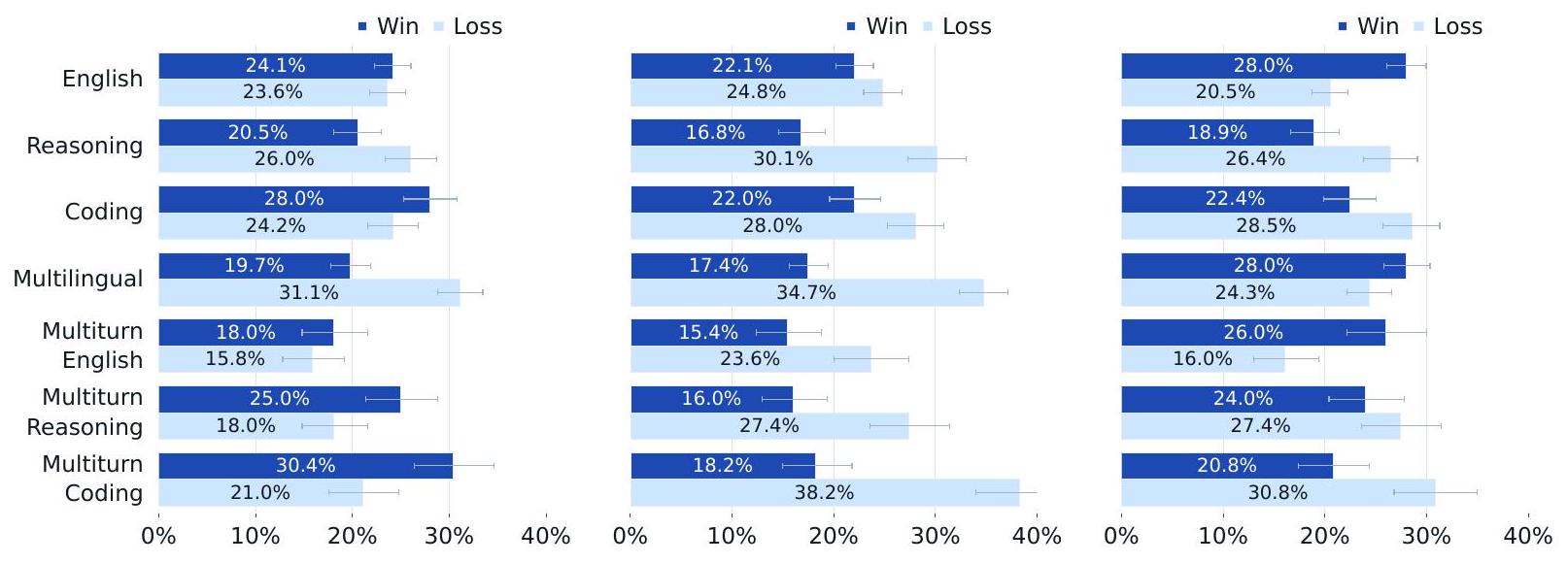

우리의 작업 결과는 Llama 3이다: 8B, 70B, 405B 파라미터를 가진 세 가지 다국어 언어 모델이다. 우리는 광범위한 언어 이해 task를 포괄하는 다양한 벤치마크 데이터셋에서 Llama 3의 성능을 평가한다. 또한, 경쟁 모델들과 Llama 3를 비교하는 광범위한 인간 평가를 수행한다. 주요 벤치마크에서 주력 Llama 3 모델의 성능 개요는 Table 2에 제시되어 있다. 우리의 실험 평가는 주력 모델이 다양한 task에서 GPT-4 (OpenAI, 2023a)와 같은 선도적인 언어 모델과 동등한 성능을 보이며, state-of-the-art에 근접함을 시사한다. 우리의 더 작은 모델들은 동일한 수의 파라미터를 가진 다른 모델들 (Bai et al., 2023; Jiang et al., 2023)을 능가하는 동급 최고(best-in-class)의 성능을 보인다. Llama 3는 또한 이전 모델 (Touvron et al., 2023b)보다 유용성(helpfulness)과 무해성(harmlessness) 사이에서 훨씬 더 나은 균형을 제공한다. Llama 3의 안전성에 대한 자세한 분석은 Section 5.4에 제시되어 있다.

우리는 업데이트된 Llama 3 커뮤니티 라이선스에 따라 세 가지 Llama 3 모델을 모두 공개적으로 출시한다; https://llama.meta.com을 참조하라. 여기에는 405B 파라미터 언어 모델의 사전학습 및 후처리 학습 버전과 입력 및 출력 안전성을 위한 Llama Guard 모델 (Inan et al., 2023)의 새로운 버전이 포함된다. 우리는 주력 모델의 공개 출시가 연구 커뮤니티에서 혁신의 물결을 촉진하고, 인공 일반 지능(AGI) 개발을 향한 책임감 있는 경로를 가속화하기를 희망한다.

Llama 3 개발 프로세스의 일환으로, 우리는 이미지 인식, 비디오 인식, 음성 이해 능력을 가능하게 하는 모델의 멀티모달 확장도 개발한다. 이 모델들은 아직 활발히 개발 중이며 출시 준비가 되지 않았다. 본 논문은 언어 모델링 결과 외에도, 이러한 멀티모달 모델에 대한 초기 실험 결과를 제시한다.

| Category <br> Benchmark | Llama 3 8B | ญo | Mistral 7B | Llama 3 70B | 畋爻爻光烒艾 | GPT 3.5 Turbo | Llama 3 405B | ญo 另ू 切 | ㅇㅣㄶㅣㄶㅣㄴ | Claude 3.5 Sonnet | |

|---|---|---|---|---|---|---|---|---|---|---|---|

| General | MMLU(5-shot) | 69.4 | 72.3 | 61.1 | 83.6 | 76.9 | 70.7 | 87.3 | 82.6 | 85.1 | 89.1 |

| MMLU(0-shot,CoT) | 73.0 | 60.5 | 86.0 | 79.9 | 69.8 | 88.6 | 85.4 | 88.7 | |||

| MMLU-Pro(5-shot,coT) | 48.3 | - | 36.9 | 66.4 | 56.3 | 49.2 | 73.3 | 62.7 | 64.8 | 74.0 | |

| IFEval | 80.4 | 73.6 | 57.6 | 87.5 | 72.7 | 69.9 | 88.6 | 85.1 | 84.3 | 85.6 | |

| Code | HumanEval(0-shot) | 72.6 | 54.3 | 40.2 | 80.5 | 75.6 | 68.0 | 89.0 | 73.2 | 86.6 | 90.2 |

| MBPP EvalPlus(0-shot) | 72.8 | 71.7 | 49.5 | 86.0 | 78.6 | 82.0 | 88.6 | 72.8 | 83.6 | 87.8 | |

| Math | GSM8K(8-shot,coT) | 84.5 | 76.7 | 53.2 | 95.1 | 88.2 | 81.6 | 96.8 | 94.2 | 96.1 | |

| MATH(0-shot,cot) | 51.9 | 44.3 | 13.0 | 68.0 | 54.1 | 43.1 | 73.8 | 41.1 | 64.5 | 76.6 | |

| Reasoning | ARC Challenge(0-shot) | 83.4 | 87.6 | 74.2 | 94.8 | 88.7 | 83.7 | 96.9 | 94.6 | 96.4 | 96.7 |

| GPQA(0-shot,Cot) | 32.8 | - | 28.8 | 46.7 | 33.3 | 30.8 | 51.1 | - | 41.4 | 53.6 | |

| Tool use | BFCL | 76.1 | - | 60.4 | 84.8 | - | 85.9 | 88.5 | 86.5 | 88.3 | 80.5 |

| Nexus | 38.5 | 30.0 | 24.7 | 56.7 | 48.5 | 37.2 | 58.7 | - | 50.3 | 56.1 | |

| Long context | ZeroSCROLLS/QuALITY | 81.0 | - | - | 90.5 | - | - | 95.2 | - | 95.2 | 90.5 |

| InfiniteBench/En.MC | 65.1 | - | - | 78.2 | - | - | 83.4 | - | 72.1 | 82.5 | |

| NIH/Multi-needle | 98.8 | - | - | 97.5 | - | - | 98.1 | - | 100.0 | 100.0 | |

| Multilingual | MGSM(0-shot,CoT) | 68.9 | 53.2 | 29.9 | 86.9 | 71.1 | 51.4 | 91.6 | - | 85.9 | 90.5 |

Table 2 Performance of finetuned Llama 3 models on key benchmark evaluations.The table compares the performance of the ,and 405 B versions of Llama 3 with that of competing models.We boldface the best-performing model in each of three model-size equivalence classes. Results obtained using 5 -shot prompting(no CoT). Results obtained without CoT. Results obtained using zero-shot prompting.

2 General Overview

Llama 3의 모델 아키텍처는 Figure 1에 설명되어 있다. Llama 3 언어 모델의 개발은 크게 두 가지 주요 단계로 구성된다:

-

언어 모델 사전학습 (Language model pre-training). 우리는 대규모 다국어 텍스트 코퍼스를 이산적인 토큰으로 변환하는 것으로 시작하여, 결과 데이터에 대해 **다음 토큰 예측(next-token prediction)**을 수행하도록 대규모 언어 모델(LLM)을 사전학습한다. 언어 모델 사전학습 단계에서 모델은 언어의 구조를 학습하고, "읽고 있는" 텍스트로부터 세상에 대한 방대한 지식을 습득한다. 이를 효과적으로 수행하기 위해 사전학습은 대규모로 진행된다: 우리는 8K 토큰의 context window를 사용하여 15.6T 토큰으로 405B 파라미터 모델을 사전학습한다. 이 표준 사전학습 단계에 이어, 지원되는 context window를 128K 토큰으로 확장하는 추가 사전학습(continued pre-training) 단계가 진행된다. 자세한 내용은 Section 3을 참조하라.

-

언어 모델 사후학습 (Language model post-training). 사전학습된 언어 모델은 언어에 대한 풍부한 이해를 가지고 있지만, 아직 지시를 따르거나 우리가 기대하는 비서처럼 행동하지는 않는다. 우리는 **여러 라운드에 걸쳐 인간 피드백에 모델을 정렬(align)**시키며, 각 라운드에는 **instruction tuning 데이터에 대한 supervised finetuning (SFT)**과 **Direct Preference Optimization (DPO; Rafailov et al., 2024)**이 포함된다. 이 사후학습 단계에서는 tool-use와 같은 새로운 기능도 통합하며, 코딩 및 추론과 같은 다른 영역에서도 강력한 개선을 관찰한다. 자세한 내용은 Section 4를 참조하라. 마지막으로, 안전 완화(safety mitigations)도 사후학습 단계에서 모델에 통합되며, 이에 대한 자세한 내용은 Section 5.4에 설명되어 있다.

그 결과로 생성된 모델들은 풍부한 기능을 갖추고 있다. 이 모델들은 최소 8개 언어로 질문에 답하고, 고품질 코드를 작성하며, 복잡한 추론 문제를 해결하고, 별도의 설정 없이(out-of-the-box) 또는 zero-shot 방식으로 도구를 사용할 수 있다.

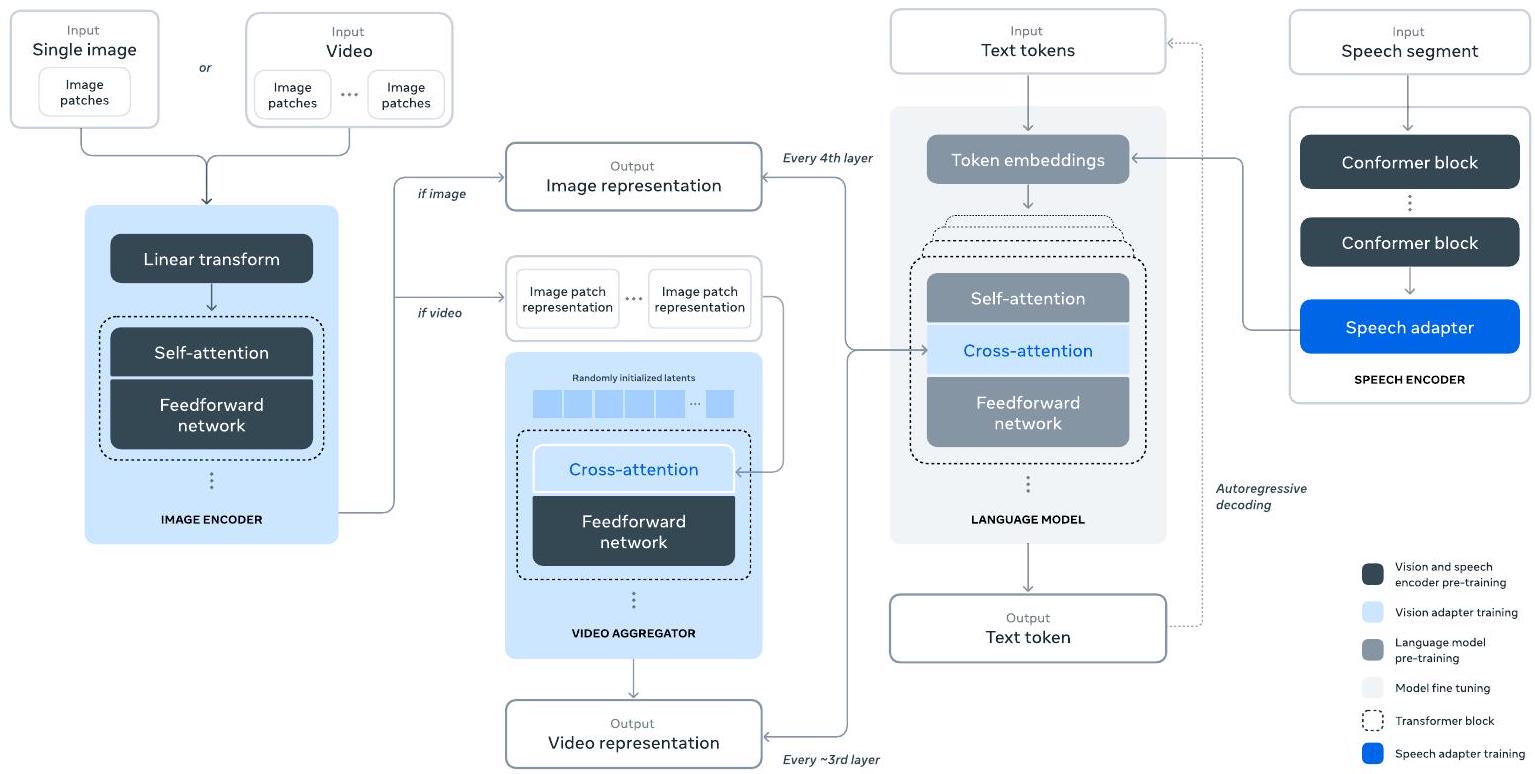

우리는 또한 **구성적 접근 방식(compositional approach)**을 사용하여 Llama 3에 이미지, 비디오, 음성 기능을 추가하는 실험을 수행한다. 우리가 연구하는 접근 방식은 Figure 28에 설명된 세 가지 추가 단계로 구성된다:

- 멀티모달 인코더 사전학습 (Multi-modal encoder pre-training). 우리는 이미지와 음성을 위한 별도의 인코더를 학습시킨다. 이미지 인코더는 대량의 이미지-텍스트 쌍 데이터로 학습시킨다. 이는 모델에게 시각적 콘텐츠와 자연어 설명 간의 관계를 가르친다. 음성 인코더는 음성 입력의 일부를 마스킹하고 이 마스킹된 부분을 이산 토큰 표현을 통해 재구성하려는 self-supervised 방식으로 학습된다. 그 결과, 모델은 음성 신호의 구조를 학습한다. 이미지 인코더에 대한 자세한 내용은 Section 7을, 음성 인코더에 대한 자세한 내용은 Section 8을 참조하라.

Figure 1 Illustration of the overall architecture and training of Llama 3. Llama 3 is a Transformer language model trained to predict the next token of a textual sequence. See text for details.

Figure 1 Illustration of the overall architecture and training of Llama 3. Llama 3 is a Transformer language model trained to predict the next token of a textual sequence. See text for details.

-

비전 어댑터 학습 (Vision adapter training). 우리는 사전학습된 이미지 인코더를 사전학습된 언어 모델에 통합하는 어댑터를 학습시킨다. 이 어댑터는 이미지 인코더의 표현을 언어 모델에 공급하는 일련의 cross-attention layer로 구성된다. 어댑터는 텍스트-이미지 쌍 데이터로 학습된다. 이는 **이미지 표현과 언어 표현을 정렬(align)**시킨다. 어댑터 학습 중에는 이미지 인코더의 파라미터도 업데이트하지만, 언어 모델 파라미터는 의도적으로 업데이트하지 않는다. 우리는 또한 이미지 어댑터 위에 비디오 어댑터를 쌍을 이룬 비디오-텍스트 데이터로 학습시킨다. 이는 모델이 프레임 간 정보를 통합할 수 있도록 한다. 자세한 내용은 Section 7을 참조하라.

-

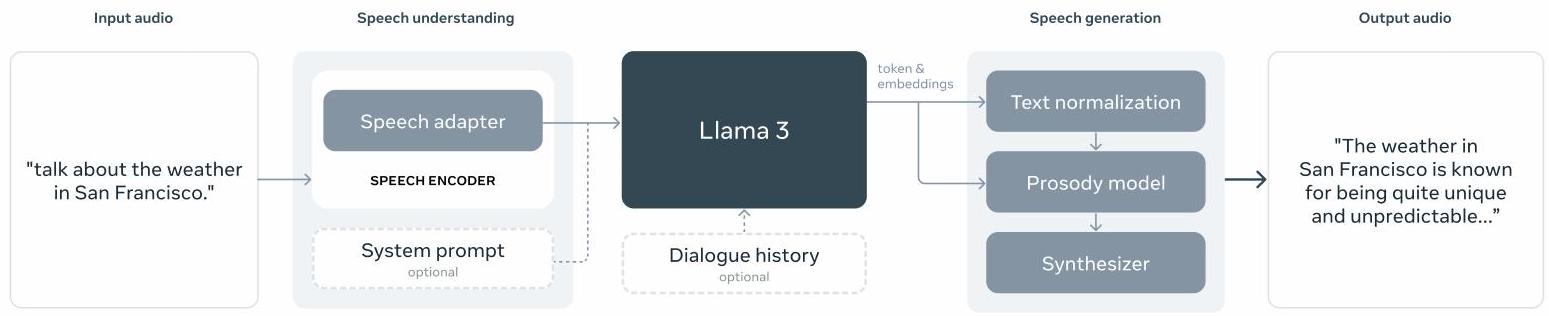

음성 어댑터 학습 (Speech adapter training). 마지막으로, 우리는 음성 인코더를 어댑터를 통해 모델에 통합한다. 이 어댑터는 음성 인코딩을 finetuned 언어 모델에 직접 공급될 수 있는 토큰 표현으로 변환한다. 어댑터와 인코더의 파라미터는 고품질 음성 이해를 가능하게 하기 위해 supervised finetuning 단계에서 함께 업데이트된다. 음성 어댑터 학습 중에는 언어 모델을 변경하지 않는다. 우리는 또한 text-to-speech 시스템도 통합한다. 자세한 내용은 Section 8을 참조하라.

우리의 멀티모달 실험은 이미지와 비디오의 내용을 인식하고 음성 인터페이스를 통해 상호작용을 지원할 수 있는 모델로 이어진다. 이 모델들은 아직 개발 중이며 출시 준비가 되지 않았다.

3 Pre-Training

Language model pre-training은 다음을 포함한다: (1) 대규모 학습 코퍼스의 큐레이션 및 필터링, (2) 모델 아키텍처 개발 및 모델 크기 결정을 위한 scaling law 개발, (3) 대규모 사전학습을 위한 효율적인 기술 개발, (4) 사전학습 레시피 개발. 아래에서 각 구성 요소를 개별적으로 설명한다.

3.1 Pre-Training Data

우리는 2023년 말까지의 지식을 포함하는 다양한 데이터 소스로부터 language model 사전학습을 위한 데이터셋을 구축한다. 각 데이터 소스에 대해 여러 중복 제거(de-duplication) 방법과 데이터 정제(data cleaning) 메커니즘을 적용하여 고품질의 토큰을 얻는다. 우리는 개인 식별 정보(PII)가 대량으로 포함된 도메인과 성인 콘텐츠로 알려진 도메인을 제거한다.

3.1.1 Web Data Curation

우리가 활용하는 데이터의 대부분은 웹에서 얻어지며, 아래에서 데이터 정제 과정을 설명한다.

PII 및 안전 필터링

다른 완화 조치들과 더불어, 우리는 안전하지 않은 콘텐츠나 대량의 PII(개인 식별 정보)를 포함할 가능성이 있는 웹사이트, 다양한 Meta 안전 표준에 따라 유해하다고 평가된 도메인, 그리고 성인 콘텐츠를 포함하는 것으로 알려진 도메인으로부터 데이터를 제거하도록 설계된 필터를 구현한다.

텍스트 추출 및 정제

우리는 잘리지 않은(non-truncated) 웹 문서의 원본 HTML 콘텐츠를 처리하여 고품질의 다양한 텍스트를 추출한다. 이를 위해 HTML 콘텐츠를 추출하고, boilerplate 제거의 정확도와 콘텐츠 recall을 최적화하는 맞춤형 파서를 구축한다. 우리는 이 파서의 품질을 **사람의 평가(human evaluation)**를 통해 검증했으며, 기사(article)와 유사한 콘텐츠에 최적화된 인기 있는 타사 HTML 파서들과 비교하여 우수한 성능을 보였다. 우리는 수학 및 코드 콘텐츠가 포함된 HTML 페이지를 신중하게 처리하여 해당 콘텐츠의 구조를 보존한다. 수학 콘텐츠는 종종 미리 렌더링된 이미지로 표현되며, 이때 수학 내용이 alt 속성에도 제공되는 경우가 많으므로 이미지의 alt 속성 텍스트를 유지한다. 우리는 다양한 정제 구성을 실험적으로 평가했다. 주로 웹 데이터로 학습된 모델의 성능에는 plain text에 비해 markdown이 해롭다는 것을 발견하여, 모든 markdown 마커를 제거한다.

중복 제거 (De-duplication)

우리는 URL, 문서, 라인 수준에서 여러 단계의 중복 제거를 적용한다:

- URL 수준 중복 제거: 전체 데이터셋에 걸쳐 URL 수준의 중복 제거를 수행한다. 각 URL에 해당하는 페이지 중 가장 최신 버전을 유지한다.

- 문서 수준 중복 제거: 전체 데이터셋에 걸쳐 전역 MinHash (Broder, 1997) 중복 제거를 수행하여 거의 중복되는 문서를 제거한다.

- 라인 수준 중복 제거: ccNet (Wenzek et al., 2019)과 유사하게 공격적인 라인 수준 중복 제거를 수행한다. 3천만 문서 단위의 각 버킷에서 6회 이상 나타난 라인을 제거한다. 수동 정성 분석 결과, 라인 수준 중복 제거가 탐색 메뉴, 쿠키 경고 등 다양한 웹사이트의 남은 boilerplate뿐만 아니라 빈번하게 나타나는 고품질 텍스트까지 제거하는 것으로 나타났지만, 경험적 평가에서는 강력한 성능 향상을 보였다.

휴리스틱 필터링

우리는 추가적인 저품질 문서, 이상치(outlier), 과도한 반복이 있는 문서를 제거하기 위한 휴리스틱을 개발한다. 휴리스틱의 몇 가지 예시는 다음과 같다:

- 중복된 n-gram 커버리지 비율 (Rae et al., 2021)을 사용하여 로깅 또는 오류 메시지와 같이 반복되는 콘텐츠로 구성된 라인을 제거한다. 이러한 라인은 매우 길고 고유할 수 있으므로 라인 중복 제거로는 필터링할 수 없다.

- "dirty word" 카운팅 (Raffel et al., 2020)을 사용하여 도메인 차단 목록에 포함되지 않은 성인 웹사이트를 필터링한다.

- 토큰 분포 Kullback-Leibler divergence를 사용하여 학습 코퍼스 분포에 비해 과도한 수의 이상치 토큰을 포함하는 문서를 필터링한다.

모델 기반 품질 필터링

또한, 우리는 고품질 토큰을 하위 선택하기 위해 다양한 모델 기반 품질 분류기를 적용하는 실험을 진행한다. 여기에는 주어진 텍스트가 Wikipedia에 의해 참조될 것인지 인식하도록 학습된 fasttext (Joulin et al., 2017)와 같은 빠른 분류기뿐만 아니라, **Llama 2 예측을 기반으로 학습된 더 많은 연산 집약적인 Roberta 기반 분류기 (Liu et al., 2019a)**도 포함된다. Llama 2 기반 품질 분류기를 학습시키기 위해, 우리는 정제된 웹 문서로 구성된 학습 세트를 생성하고, 품질 요구 사항을 설명하며, Llama 2의 chat 모델에게 문서가 이러한 요구 사항을 충족하는지 판단하도록 지시한다. 효율성을 위해 DistilRoberta (Sanh et al., 2019)를 사용하여 각 문서에 대한 품질 점수를 생성한다. 우리는 다양한 품질 필터링 구성의 효능을 실험적으로 평가한다.

코드 및 추론 데이터

DeepSeek-AI et al. (2024)과 유사하게, 우리는 코드 및 수학 관련 웹 페이지를 추출하는 도메인별 파이프라인을 구축한다. 특히, 코드 및 추론 분류기는 모두 Llama 2에 의해 주석된 웹 데이터로 학습된 DistilRoberta 모델이다. 위에서 언급된 일반적인 품질 분류기와 달리, 우리는 수학적 추론, STEM 분야의 추론, 그리고 자연어와 섞인 코드를 포함하는 웹 페이지를 대상으로 prompt tuning을 수행한다. 코드와 수학의 토큰 분포는 자연어의 토큰 분포와 상당히 다르기 때문에, 이러한 파이프라인은 도메인별 HTML 추출, 맞춤형 텍스트 feature 및 필터링을 위한 휴리스틱을 구현한다.

다국어 데이터

위에서 설명한 영어 처리 파이프라인과 유사하게, 우리는 PII 또는 안전하지 않은 콘텐츠를 포함할 가능성이 있는 웹사이트로부터 데이터를 제거하는 필터를 구현한다. 우리의 다국어 텍스트 처리 파이프라인은 몇 가지 고유한 특징을 가지고 있다:

- fasttext 기반 언어 식별 모델을 사용하여 문서를 176개 언어로 분류한다.

- 각 언어 데이터 내에서 문서 수준 및 라인 수준 중복 제거를 수행한다.

- 언어별 휴리스틱 및 모델 기반 필터를 적용하여 저품질 문서를 제거한다.

또한, 고품질 콘텐츠가 우선시되도록 다국어 Llama 2 기반 분류기를 사용하여 다국어 문서의 품질 순위를 매긴다. 우리는 영어 및 다국어 벤치마크에서의 모델 성능 균형을 맞춰 실험적으로 사전학습에 사용되는 다국어 토큰의 양을 결정한다.

3.1.2 Determining the Data Mix

고품질의 language model을 얻기 위해서는 사전학습 데이터 믹스(pre-training data mix) 내에서 다양한 데이터 소스의 비율을 신중하게 결정하는 것이 필수적이다. 이러한 데이터 믹스를 결정하는 주요 도구는 지식 분류(knowledge classification)와 스케일링 법칙(scaling law) 실험이다.

지식 분류 (Knowledge classification)

우리는 데이터 믹스를 보다 효과적으로 결정하기 위해 웹 데이터에 포함된 정보 유형을 분류하는 classifier를 개발한다. 이 classifier를 사용하여 웹에서 과도하게 대표되는 데이터 카테고리(예: 예술 및 엔터테인먼트)를 다운샘플링한다.

데이터 믹스를 위한 스케일링 법칙 (Scaling laws for data mix)

최적의 데이터 믹스를 결정하기 위해 우리는 스케일링 법칙 실험을 수행한다. 이 실험에서는 여러 개의 작은 모델을 특정 데이터 믹스로 학습시킨 후, 이를 통해 해당 믹스로 학습된 대형 모델의 성능을 예측한다 (Section 3.2.1 참조). 이 과정을 다양한 데이터 믹스에 대해 여러 번 반복하여 새로운 데이터 믹스 후보를 선정한다. 이후, 이 후보 데이터 믹스로 더 큰 모델을 학습시키고, 여러 핵심 벤치마크에서 해당 모델의 성능을 평가한다.

데이터 믹스 요약 (Data mix summary)

우리의 최종 데이터 믹스는 대략 50%의 일반 지식(general knowledge) 토큰, 25%의 수학 및 추론(mathematical and reasoning) 토큰, 17%의 코드 토큰, 그리고 8%의 다국어(multilingual) 토큰으로 구성된다.

3.1.3 Annealing Data

경험적으로, 우리는 소량의 고품질 코드 및 수학 데이터에 대한 annealing(Section 3.4.3 참조)이 사전학습된 모델의 주요 벤치마크 성능을 향상시킬 수 있음을 발견했다. Li et al. (2024b)와 유사하게, 우리는 선택된 도메인의 고품질 데이터를 업샘플링하는 데이터 믹스를 사용하여 annealing을 수행한다. 우리는 annealing 데이터에 일반적으로 사용되는 벤치마크의 학습 세트를 포함하지 않는다. 이를 통해 Llama 3의 진정한 few-shot learning 능력과 out-of-domain generalization 능력을 평가할 수 있다.

OpenAI (2023a)에 따라, 우리는 annealing에서 GSM8k (Cobbe et al., 2021) 및 MATH (Hendrycks et al., 2021b) 학습 세트에 대한 annealing의 효과를 평가한다. 우리는 annealing이 사전학습된 Llama 3 8B 모델의 GSM8k 및 MATH 검증 세트 성능을 각각 24.0% 및 6.4% 향상시켰음을 발견했다. 그러나 405B 모델의 개선은 미미하며, 이는 우리의 플래그십 모델이 강력한 in-context learning 및 reasoning 능력을 가지고 있으며, 강력한 성능을 얻기 위해 특정 in-domain 학습 샘플이 필요하지 않음을 시사한다.

데이터 품질 평가를 위한 annealing 활용. Blakeney et al. (2024)와 유사하게, 우리는 annealing이 소규모 도메인별 데이터셋의 가치를 판단할 수 있게 해준다는 것을 발견했다. 우리는 50% 학습된 Llama 3 8B 모델의 learning rate를 40B 토큰에 대해 선형적으로 0으로 annealing하여 이러한 데이터셋의 가치를 측정한다. 이 실험에서 우리는 새로운 데이터셋에 30%의 가중치를 할당하고, 나머지 70%의 가중치는 기본 데이터 믹스에 할당한다. 새로운 데이터 소스를 평가하기 위해 annealing을 사용하는 것은 모든 소규모 데이터셋에 대해 scaling law 실험을 수행하는 것보다 효율적이다.

3.2 Model Architecture

Llama 3는 표준적인 dense Transformer 아키텍처 (Vaswani et al., 2017)를 사용한다. 모델 아키텍처 측면에서 Llama 및 Llama 2 (Touvron et al., 2023a,b)와 크게 다르지 않으며, 우리의 성능 향상은 주로 데이터 품질 및 다양성 개선과 학습 규모 증대에 기인한다.

Llama 2와 비교하여 몇 가지 작은 수정 사항이 있다:

- **grouped query attention (GQA; Ainslie et al. (2023))**을 8개의 key-value heads와 함께 사용하여 추론 속도를 향상시키고 디코딩 중 key-value cache의 크기를 줄였다.

- 동일한 시퀀스 내에서 다른 문서 간의 self-attention을 방지하는 attention mask를 사용한다. 이 변경 사항은 표준 사전학습에서는 제한적인 영향을 미쳤지만, 매우 긴 시퀀스에 대한 지속적인 사전학습에서는 중요하다는 것을 발견했다.

| 8B | 70B | 405B | |

|---|---|---|---|

| Layers | 32 | 80 | 126 |

| Model Dimension | 4,096 | 8192 | 16,384 |

| FFN Dimension | 14,336 | 28,672 | 53,248 |

| Attention Heads | 32 | 64 | 128 |

| Key/Value Heads | 8 | 8 | 8 |

| Peak Learning Rate | |||

| Activation Function | SwiGLU | ||

| Vocabulary Size | 128,000 | ||

| Positional Embeddings | RoPE ( ) |

Table 3: Llama 3의 주요 하이퍼파라미터 개요. 8B, 70B, 405B 언어 모델에 대한 설정을 보여준다.

- 128K 토큰의 vocabulary를 사용한다. 우리의 토큰 vocabulary는 tiktoken 토크나이저의 100K 토큰과 비영어권 언어를 더 잘 지원하기 위한 28K 추가 토큰을 결합한다. Llama 2 토크나이저와 비교하여, 새로운 토크나이저는 영어 데이터 샘플에서 토큰당 문자 압축률을 3.17에서 3.94로 향상시킨다. 이는 모델이 동일한 학습 연산량으로 더 많은 텍스트를 "읽을" 수 있도록 한다. 또한, 선택된 비영어권 언어에서 28K 토큰을 추가하는 것이 압축률과 다운스트림 성능을 모두 향상시켰으며, 영어 토큰화에는 영향을 미치지 않았다.

- RoPE base frequency 하이퍼파라미터를 500,000으로 증가시켰다. 이는 더 긴 context를 더 잘 지원할 수 있도록 하며, Xiong et al. (2023)은 이 값이 최대 32,768의 context 길이에 효과적임을 보여주었다.

Llama 3 405B는 126개의 layer, 16,384의 token representation dimension, 128개의 attention heads를 가진 아키텍처를 사용한다. 자세한 내용은 Table 3을 참조하라. 이는 3.8 x 10^25 FLOPs의 학습 예산에 대한 데이터의 scaling laws에 따라 대략적으로 연산 최적의 모델 크기로 이어진다.

3.2.1 Scaling Laws

우리는 사전학습 compute budget에 따라 플래그십 모델의 최적 모델 크기를 결정하기 위해 scaling law를 개발한다 (Hoffmann et al., 2022; Kaplan et al., 2020). 최적 모델 크기를 결정하는 것 외에도, 몇 가지 문제로 인해 다운스트림 벤치마크 task에서 플래그십 모델의 성능을 예측하는 것은 주요 도전 과제이다: (1) 기존 scaling law는 일반적으로 특정 벤치마크 성능이 아닌 next-token prediction loss만 예측한다. (2) Scaling law는 적은 compute budget으로 수행된 사전학습 실행을 기반으로 개발되기 때문에 노이즈가 많고 신뢰할 수 없을 수 있다 (Wei et al., 2022b).

이러한 문제들을 해결하기 위해, 우리는 다운스트림 벤치마크 성능을 정확하게 예측하는 scaling law를 개발하기 위한 2단계 방법론을 구현한다:

- 먼저, compute-optimal 모델의 다운스트림 task에 대한 negative log-likelihood와 훈련 FLOPs 간의 상관관계를 설정한다.

- 다음으로, scaling law 모델과 더 높은 compute FLOPs로 훈련된 이전 모델들을 모두 활용하여 다운스트림 task에 대한 negative log-likelihood와 task 정확도 간의 상관관계를 설정한다. 이 단계에서는 특히 Llama 2 계열 모델을 활용한다.

이러한 접근 방식을 통해 우리는 특정 훈련 FLOPs가 주어졌을 때 compute-optimal 모델의 다운스트림 task 성능을 예측할 수 있다. 우리는 사전학습 데이터 믹스를 선택하기 위해 유사한 방법을 사용한다 (Section 3.4 참조).

Scaling law 실험. 구체적으로, 우리는 FLOPs에서 FLOPs 사이의 compute budget을 사용하여 모델을 사전학습함으로써 scaling law를 구축한다. 각 compute budget에서 우리는 4천만 개에서 160억 개 사이의 파라미터 크기를 가진 모델들을 사전학습하며, 각 compute budget에서 모델 크기의 부분집합을 사용한다. 이러한 훈련 실행에서는 2,000 훈련 스텝 동안 선형 웜업(linear warmup)이 있는 cosine learning rate 스케줄을 사용한다. 최대 learning rate는 모델 크기에 따라 에서 사이로 설정된다. cosine decay는 최대값의 0.1로 설정한다. 각 스텝의 weight decay는 해당 스텝의 learning rate의 0.1배로 설정된다. 각 compute scale에 대해 250K에서 4M 사이의 고정된 batch size를 사용한다.

Figure 2 에서 FLOPs 사이의 Scaling law IsoFLOPs 곡선. 손실은 held-out validation set에 대한 negative log-likelihood이다. 각 compute scale에서의 측정값은 2차 다항식을 사용하여 근사한다.

Figure 2 에서 FLOPs 사이의 Scaling law IsoFLOPs 곡선. 손실은 held-out validation set에 대한 negative log-likelihood이다. 각 compute scale에서의 측정값은 2차 다항식을 사용하여 근사한다.

Figure 3 사전학습 compute budget의 함수로서 식별된 compute-optimal 모델의 훈련 토큰 수. 적합된 scaling-law 예측도 포함한다. compute-optimal 모델은 Figure 2의 포물선 최소값에 해당한다.

Figure 3 사전학습 compute budget의 함수로서 식별된 compute-optimal 모델의 훈련 토큰 수. 적합된 scaling-law 예측도 포함한다. compute-optimal 모델은 Figure 2의 포물선 최소값에 해당한다.

이러한 실험들은 Figure 2의 IsoFLOPs 곡선을 생성한다. 이 곡선들의 손실은 별도의 validation set에서 측정된다. 우리는 측정된 손실 값을 2차 다항식으로 적합시키고 각 포물선의 최소값을 식별한다. 우리는 포물선의 최소값을 해당 사전학습 compute budget에서의 compute-optimal 모델이라고 부른다.

우리는 이러한 방식으로 식별된 compute-optimal 모델을 사용하여 특정 compute budget에 대한 최적 훈련 토큰 수를 예측한다. 이를 위해, 우리는 compute budget 와 최적 훈련 토큰 수 사이에 멱법칙(power-law) 관계를 가정한다:

우리는 Figure 2의 데이터를 사용하여 와 를 적합시킨다. 그 결과 를 얻었으며, 해당 적합은 Figure 3에 나와 있다. 결과 scaling law를 FLOPs로 외삽하면 16.55 T 토큰으로 402B 파라미터 모델을 훈련할 것을 제안한다.

중요한 관찰은 compute budget이 증가함에 따라 IsoFLOPs 곡선이 최소값 주변에서 더 평평해진다는 것이다. 이는 플래그십 모델의 성능이 모델 크기와 훈련 토큰 간의 trade-off에서 작은 변화에 상대적으로 강건하다는 것을 의미한다. 이 관찰을 바탕으로, 우리는 궁극적으로 405B 파라미터의 플래그십 모델을 훈련하기로 결정했다.

다운스트림 task 성능 예측. 우리는 결과 compute-optimal 모델을 사용하여 벤치마크 데이터셋에서 플래그십 Llama 3 모델의 성능을 예측한다. 먼저, 벤치마크에서 정답의 (정규화된) negative log-likelihood와 훈련 FLOPs를 선형적으로 상관시킨다. 이 분석에서는 위에서 설명한 데이터 믹스에서 FLOPs까지 훈련된 scaling law 모델만 사용한다. 다음으로, scaling law 모델과 Llama 2 모델(Llama 2 데이터 믹스와 tokenizer를 사용하여 훈련됨)을 모두 사용하여 log-likelihood와 정확도 간의 시그모이드 관계를 설정한다. 이 실험 결과는 Figure 4에 나와 있다. 우리는 4가지 자릿수(orders of magnitude)에 걸쳐 외삽하는 이 2단계 scaling law 예측이 상당히 정확하다는 것을 발견했다: 이는 플래그십 Llama 3 모델의 최종 성능을 약간만 과소평가한다.

3.3 Infrastructure, Scaling, and Efficiency

우리는 Llama 3405B의 대규모 사전학습을 지원한 하드웨어 및 인프라를 설명하고, 학습 효율성 향상으로 이어진 여러 최적화 방안에 대해 논의한다.

3.3.1 Training Infrastructure

Llama 1 및 2 모델은 Meta의 AI Research SuperCluster에서 학습되었다 (Lee and Sengupta, 2022). 모델 규모가 더욱 커지면서, Llama 3의 학습은 Meta의 프로덕션 클러스터로 이전되었다 (Lee et al., 2024). 이러한

Figure 4 ARC Challenge에 대한 스케일링 법칙 예측.

왼쪽: 사전학습 FLOPs의 함수로서 ARC Challenge 벤치마크에서 정답의 정규화된 negative log-likelihood.

오른쪽: 정답의 정규화된 negative log-likelihood의 함수로서 ARC Challenge 벤치마크 정확도.

이 분석을 통해 사전학습 시작 전에 ARC Challenge 벤치마크에서의 모델 성능을 예측할 수 있다. 자세한 내용은 본문 참조.

Figure 4 ARC Challenge에 대한 스케일링 법칙 예측.

왼쪽: 사전학습 FLOPs의 함수로서 ARC Challenge 벤치마크에서 정답의 정규화된 negative log-likelihood.

오른쪽: 정답의 정규화된 negative log-likelihood의 함수로서 ARC Challenge 벤치마크 정확도.

이 분석을 통해 사전학습 시작 전에 ARC Challenge 벤치마크에서의 모델 성능을 예측할 수 있다. 자세한 내용은 본문 참조.

설정은 프로덕션 수준의 안정성을 최적화하며, 이는 학습 규모를 확장할 때 필수적이다.

Compute. Llama 3 405B는 최대 16K H100 GPU에서 학습되었으며, 각 GPU는 700W TDP와 80GB HBM3를 갖추고 Meta의 Grand Teton AI 서버 플랫폼 (Matt Bowman, 2022)을 사용한다. 각 서버에는 8개의 GPU와 2개의 CPU가 장착되어 있다. 서버 내에서 8개의 GPU는 NVLink를 통해 연결된다. 학습 작업은 Meta의 글로벌 규모 학습 스케줄러인 MAST (Choudhury et al., 2024)를 사용하여 스케줄링된다.

Storage. Meta의 범용 분산 파일 시스템인 Tectonic (Pan et al., 2021)은 Llama 3 사전학습을 위한 스토리지 패브릭 (Battey and Gupta, 2024)을 구축하는 데 사용된다. Tectonic은 SSD가 장착된 7,500대의 서버에서 240PB의 스토리지를 제공하며, 지속 가능한 처리량 2TB/s와 최대 처리량 7TB/s를 지원한다. 주요 과제는 짧은 시간 동안 스토리지 패브릭을 포화시키는 매우 버스트가 심한 체크포인트 쓰기를 지원하는 것이다. 체크포인트는 각 GPU의 모델 상태를 저장하며, GPU당 1MB에서 4GB에 이르며 복구 및 디버깅에 사용된다. 우리는 체크포인트 중 GPU 일시 정지 시간을 최소화하고 체크포인트 빈도를 늘려 복구 후 손실되는 작업량을 줄이는 것을 목표로 한다.

Network. Llama 3 405B는 Arista 7800 및 Minipack2 Open Compute Project OCP 랙 스위치를 기반으로 하는 RDMA over Converged Ethernet (RoCE) 패브릭을 사용했다. Llama 3 제품군의 더 작은 모델들은 Nvidia Quantum2 Infiniband 패브릭을 사용하여 학습되었다. RoCE 및 Infiniband 클러스터 모두 GPU 간 400Gbps 인터커넥트를 활용한다. 이러한 클러스터 간의 기본 네트워크 기술 차이에도 불구하고, 우리는 이 두 가지를 모두 튜닝하여 이러한 대규모 학습 워크로드에 대해 동등한 성능을 제공한다. 우리는 RoCE 네트워크의 설계를 전적으로 소유하고 있으므로 이에 대해 더 자세히 설명한다.

- Network topology. 우리의 RoCE 기반 AI 클러스터는 24K GPU로 구성되며, 3계층 Clos 네트워크 (Lee et al., 2024)로 연결된다. 최하위 계층에서는 각 랙이 두 서버에 분할된 16개의 GPU를 호스팅하며, 단일 Minipack2 ToR(top-of-the-rack) 스위치로 연결된다. 중간 계층에서는 192개의 랙이 Cluster Switch로 연결되어 3,072개의 GPU로 구성된 pod를 형성하며, **완전한 이분 대역폭(full bisection bandwidth)**을 보장하여 오버서브스크립션이 발생하지 않는다. 최상위 계층에서는 동일한 데이터센터 건물 내의 8개의 pod가 Aggregation Switch를 통해 연결되어 24K GPU 클러스터를 형성한다. 그러나 Aggregation 계층의 네트워크 연결은 완전한 이분 대역폭을 유지하지 않으며, 대신 1:7의 오버서브스크립션 비율을 갖는다. 우리의 모델 병렬화 방법 (Section 3.3.2 참조)과 학습 작업 스케줄러 (Choudhury et al., 2024)는 모두 네트워크 토폴로지를 인식하도록 최적화되어 pod 간 네트워크 통신을 최소화하는 것을 목표로 한다.

- Load balancing. LLM 학습은 전통적인 ECMP(Equal-Cost Multi-Path) 라우팅과 같은 방법으로는 모든 사용 가능한 네트워크 경로에 걸쳐 로드 밸런싱하기 어려운 대규모 네트워크 흐름(fat network flows)을 생성한다. 이 문제를 해결하기 위해 우리는 두 가지 기술을 사용한다. 첫째, 우리의 collective library는 두 GPU 사이에 단일 네트워크 흐름 대신 16개의 네트워크 흐름을 생성하여 흐름당 트래픽을 줄이고 로드 밸런싱을 위한 더 많은 흐름을 제공한다. 둘째, 우리의 E-ECMP(Enhanced-ECMP) 프로토콜은 패킷의 RoCE 헤더에 추가 필드를 해싱하여 이러한 16개의 흐름을 다른 네트워크 경로에 걸쳐 효과적으로 밸런싱한다.

[^3]| GPUs | TP | CP | PP | DP | Seq. Len. | Batch size/DP | Tokens/Batch | TFLOPs/GPU | BF16 MFU | | :---: | :---: | :---: | :---: | :---: | :---: | :---: | :---: | :---: | :---: | | 8,192 | 8 | 1 | 16 | 64 | 8,192 | 32 | 16 M | 430 | | | 16,384 | 8 | 1 | 16 | 128 | 8,192 | 16 | 16 M | 400 | | | 16,384 | 8 | 16 | 16 | 8 | 131,072 | 16 | 16 M | 380 | |

Table 4 Llama 3 405B 사전학습의 각 단계에 대한 스케일링 구성 및 MFU. 각 병렬화 유형에 대한 설명은 본문 및 Figure 5를 참조하라.

- Congestion control. 우리는 스파인(spine)에 딥 버퍼 스위치 (Gangidi et al., 2024)를 사용하여 collective communication 패턴으로 인한 일시적인 혼잡 및 버퍼링을 수용한다. 이 설정은 학습에서 흔히 발생하는 느린 서버로 인한 지속적인 혼잡 및 네트워크 백프레셔의 영향을 제한하는 데 도움이 된다. 마지막으로, E-ECMP를 통한 더 나은 로드 밸런싱은 혼잡 발생 가능성을 크게 줄인다. 이러한 최적화를 통해 우리는 DCQCN(Data Center Quantized Congestion Notification)과 같은 전통적인 혼잡 제어 방법 없이도 24K GPU 클러스터를 성공적으로 운영한다.

3.3.2 Parallelism for Model Scaling

가장 큰 모델의 학습을 확장하기 위해, 우리는 4D 병렬화(4D parallelism)—네 가지 다른 유형의 병렬화 방법의 조합—를 사용하여 모델을 샤딩한다. 이 접근 방식은 많은 GPU에 걸쳐 계산을 효율적으로 분산시키고, 각 GPU의 모델 파라미터, optimizer state, gradient, activation이 HBM에 적합하도록 보장한다. 우리의 4D parallelism 구현은 Figure 5에 설명되어 있다. 이는 tensor parallelism (TP; Krizhevsky et al. (2012); Shoeybi et al. (2019); Korthikanti et al. (2023)), pipeline parallelism (PP; Huang et al. (2019); Narayanan et al. (2021); Lamy-Poirier (2023)), context parallelism (CP; Liu et al. (2023a)), 그리고 **data parallelism (DP; Rajbhandari et al. (2020); Ren et al. (2021); Zhao et al. (2023b))**을 결합한다.

Tensor parallelism은 개별 가중치 tensor를 여러 장치에 걸쳐 여러 청크로 분할한다. Pipeline parallelism은 모델을 layer별로 수직적으로 단계로 분할하여, 다른 장치들이 전체 모델 pipeline의 다른 단계를 병렬로 처리할 수 있도록 한다. Context parallelism은 입력 context를 세그먼트로 나누어, 매우 긴 시퀀스 길이 입력에 대한 메모리 병목 현상을 줄인다. 우리는 **fully sharded data parallelism (FSDP; Rajbhandari et al., 2020; Ren et al., 2021; Zhao et al., 2023b)**을 사용하는데, 이는 모델, optimizer, gradient를 샤딩하면서 여러 GPU에서 데이터를 병렬로 처리하고 각 학습 단계 후에 동기화하는 data parallelism을 구현한다. Llama 3에 대한 FSDP 사용은 optimizer state와 gradient를 샤딩하지만, 모델 샤드의 경우 backward pass 동안 추가적인 all-gather 통신을 피하기 위해 forward 계산 후에 다시 샤딩하지 않는다.

GPU 활용도 (GPU utilization). 병렬화 구성, 하드웨어 및 소프트웨어의 신중한 튜닝을 통해, 우리는 Table 4에 표시된 구성에 대해 **전체 BF16 Model FLOPs Utilization (MFU; Chowdhery et al. (2023))이 38-43%**에 도달했다. 8K GPU에서 DP=64일 때 43%였던 MFU가 16K GPU에서 DP=128일 때 41%로 약간 감소한 것은 학습 중 전역 토큰 수를 일정하게 유지하기 위해 DP 그룹당 더 낮은 batch size가 필요했기 때문이다.

Pipeline parallelism 개선 사항 (Pipeline parallelism improvements). 기존 구현에서 몇 가지 문제에 직면했다:

- Batch size 제약. 현재 구현은 GPU당 지원되는 batch size에 제약이 있어, pipeline stage 수로 나누어 떨어져야 한다. Figure 6의 예시에서, pipeline parallelism의 depth-first schedule (DFS; Narayanan et al., 2021)은 를 요구하는 반면, breadth-first schedule (BFS; Lamy-Poirier (2023))은 을 요구한다. 여기서 은 총 micro-batch 수이고 은 동일한 stage의 forward 또는 backward에 대한 연속적인 micro-batch 수이다. 그러나 사전 학습은 종종 batch size를 유연하게 조정할 필요가 있다.

- 메모리 불균형. 기존 pipeline parallelism 구현은 불균형한 자원 소비를 초래한다. 첫 번째 stage는 embedding과 warm-up micro-batch로 인해 더 많은 메모리를 소비한다.

- 계산 불균형. 모델의 마지막 layer 이후에는 출력과 loss를 계산해야 하므로, 이 stage가 실행 지연 시간의 병목 현상이 된다.

Figure 5 4D parallelism의 도식. GPU는 [TP, CP, PP, DP] 순서로 병렬화 그룹으로 나뉘며, 여기서 DP는 FSDP를 의미한다. 이 예시에서는 16개의 GPU가 의 그룹 크기로 구성되어 있다. GPU의 4D parallelism에서의 위치는 벡터 로 표현되며, 여기서 는 -번째 병렬화 차원에서의 인덱스이다. 이 예시에서 GPU0[TP0, CP0, PP0, DP0]와 GPU1[TP1, CP0, PP0, DP0]는 동일한 TP 그룹에 속하며, GPU0와 GPU2는 동일한 CP 그룹에, GPU0와 GPU4는 동일한 PP 그룹에, 그리고 GPU0와 GPU8은 동일한 DP 그룹에 속한다.

Figure 5 4D parallelism의 도식. GPU는 [TP, CP, PP, DP] 순서로 병렬화 그룹으로 나뉘며, 여기서 DP는 FSDP를 의미한다. 이 예시에서는 16개의 GPU가 의 그룹 크기로 구성되어 있다. GPU의 4D parallelism에서의 위치는 벡터 로 표현되며, 여기서 는 -번째 병렬화 차원에서의 인덱스이다. 이 예시에서 GPU0[TP0, CP0, PP0, DP0]와 GPU1[TP1, CP0, PP0, DP0]는 동일한 TP 그룹에 속하며, GPU0와 GPU2는 동일한 CP 그룹에, GPU0와 GPU4는 동일한 PP 그룹에, 그리고 GPU0와 GPU8은 동일한 DP 그룹에 속한다.

이러한 문제를 해결하기 위해, 우리는 Figure 6에 표시된 대로 pipeline schedule을 수정하여 을 유연하게 설정할 수 있도록 했다. 이 경우 로, 각 batch에서 임의의 수의 micro-batch를 실행할 수 있다. 이를 통해 다음을 실행할 수 있다: (1) 대규모에서 batch size 제한이 있을 때 stage 수보다 적은 micro-batch를 실행하거나; (2) point-to-point 통신을 숨기기 위해 더 많은 micro-batch를 실행하여, 최상의 통신 및 메모리 효율성을 위해 DFS와 breadth first schedule (BFS) 사이의 최적 지점을 찾을 수 있다. pipeline의 균형을 맞추기 위해, 우리는 첫 번째 stage와 마지막 stage에서 각각 Transformer layer 하나씩을 줄였다. 이는 첫 번째 stage의 첫 번째 모델 청크에는 embedding만 있고, 마지막 stage의 마지막 모델 청크에는 출력 projection과 loss 계산만 있음을 의미한다. pipeline bubble을 줄이기 위해, 우리는 하나의 pipeline rank에서 개의 pipeline stage를 가진 interleaved schedule (Narayanan et al., 2021)을 사용한다. 전체 pipeline bubble ratio는 이다. 또한, 우리는 PP에서 비동기 point-to-point 통신을 채택하여 학습 속도를 상당히 높였는데, 특히 document mask가 추가적인 계산 불균형을 초래하는 경우에 효과적이다. 비동기 point-to-point 통신으로 인한 메모리 사용량을 줄이기 위해 TORCH_NCCL_AVOID_RECORD_STREAMS를 활성화한다. 마지막으로, 메모리 비용을 줄이기 위해, 상세한 메모리 할당 프로파일링을 기반으로, 각 pipeline stage의 입력 및 출력 tensor를 포함하여 향후 계산에 사용되지 않을 tensor들을 사전에 할당 해제한다. 이러한 최적화를 통해, 우리는 activation checkpointing 없이 8K 토큰 시퀀스에서 Llama 3를 사전 학습할 수 있었다.

긴 시퀀스를 위한 Context parallelism (Context parallelism for long sequences). 우리는 Llama 3의 context 길이를 확장할 때 메모리 효율성을 향상시키고 최대 128K 길이의 매우 긴 시퀀스에서 학습을 가능하게 하기 위해 **context parallelism (CP)**을 활용한다. CP에서는 시퀀스 차원을 따라 분할하며, 특히 입력 시퀀스를 청크로 분할하여 각 CP rank가 더 나은 부하 분산을 위해 두 개의 청크를 받도록 한다. -번째 CP rank는 -번째 청크와 -번째 청크를 모두 받는다. ring-like 구조에서 통신과 계산을 중첩시키는 기존 CP 구현(Liu et al., 2023a)과 달리, 우리의 CP 구현은 all-gather 기반 방식을 채택하여 먼저 key (K) 및 value (V) tensor를 all-gather한 다음, local query (Q) tensor 청크에 대한 attention 출력을 계산한다. all-gather 통신 지연 시간이 critical path에 노출되지만, 우리는 두 가지 주요 이유로 이 접근 방식을 채택한다: (1) document mask와 같이 all-gather 기반 CP attention에서 다양한 유형의 attention mask를 지원하기가 더 쉽고 유연하며; (2) GQA (Ainslie et al., 2023)를 사용하기 때문에 통신되는 K 및 V tensor가 Q tensor보다 훨씬 작아서 노출된 all-gather 지연 시간이 작다.

Figure 6 Llama 3의 pipeline parallelism 도식. Pipeline parallelism은 8개의 pipeline stage (0에서 7)를 4개의 pipeline rank (PP rank 0에서 3)에 걸쳐 분할하며, 여기서 rank 0의 GPU는 stage 0과 4를 실행하고, P rank 1의 GPU는 stage 1과 5를 실행하는 식이다. 색깔 블록 (0에서 9)은 micro-batch 시퀀스를 나타내며, 여기서 은 총 micro-batch 수이고 은 동일한 stage의 forward 또는 backward에 대한 연속적인 micro-batch 수이다. 우리의 핵심 통찰은 을 튜닝 가능하게 만드는 것이다.

Figure 6 Llama 3의 pipeline parallelism 도식. Pipeline parallelism은 8개의 pipeline stage (0에서 7)를 4개의 pipeline rank (PP rank 0에서 3)에 걸쳐 분할하며, 여기서 rank 0의 GPU는 stage 0과 4를 실행하고, P rank 1의 GPU는 stage 1과 5를 실행하는 식이다. 색깔 블록 (0에서 9)은 micro-batch 시퀀스를 나타내며, 여기서 은 총 micro-batch 수이고 은 동일한 stage의 forward 또는 backward에 대한 연속적인 micro-batch 수이다. 우리의 핵심 통찰은 을 튜닝 가능하게 만드는 것이다.

따라서 attention 계산의 시간 복잡도는 all-gather보다 한 차수 더 크므로 ( 대 , 여기서 는 전체 causal mask에서의 시퀀스 길이를 나타냄), all-gather 오버헤드는 무시할 수 있다.

네트워크 인식 병렬화 구성 (Network-aware parallelism configuration). 병렬화 차원의 순서인 [TP, CP, PP, DP]는 네트워크 통신에 최적화되어 있다. 가장 안쪽의 병렬화는 가장 높은 네트워크 대역폭과 가장 낮은 지연 시간을 요구하므로, 일반적으로 동일한 서버 내로 제한된다. 가장 바깥쪽의 병렬화는 다중 홉 네트워크에 걸쳐 확산될 수 있으며 더 높은 네트워크 지연 시간을 허용해야 한다. 따라서 네트워크 대역폭 및 지연 시간 요구 사항에 따라 병렬화 차원을 [TP, CP, PP, DP] 순서로 배치한다. DP (즉, FSDP)는 샤딩된 모델 가중치를 비동기적으로 미리 가져오고 gradient를 줄임으로써 더 긴 네트워크 지연 시간을 허용할 수 있기 때문에 가장 바깥쪽 병렬화이다. GPU 메모리 오버플로우를 피하면서 최소한의 통신 오버헤드로 최적의 병렬화 구성을 식별하는 것은 어렵다. 우리는 메모리 소비 추정기와 성능 예측 도구를 개발하여 다양한 병렬화 구성을 탐색하고 전체 학습 성능을 예측하며 메모리 격차를 효과적으로 식별하는 데 도움을 받았다.

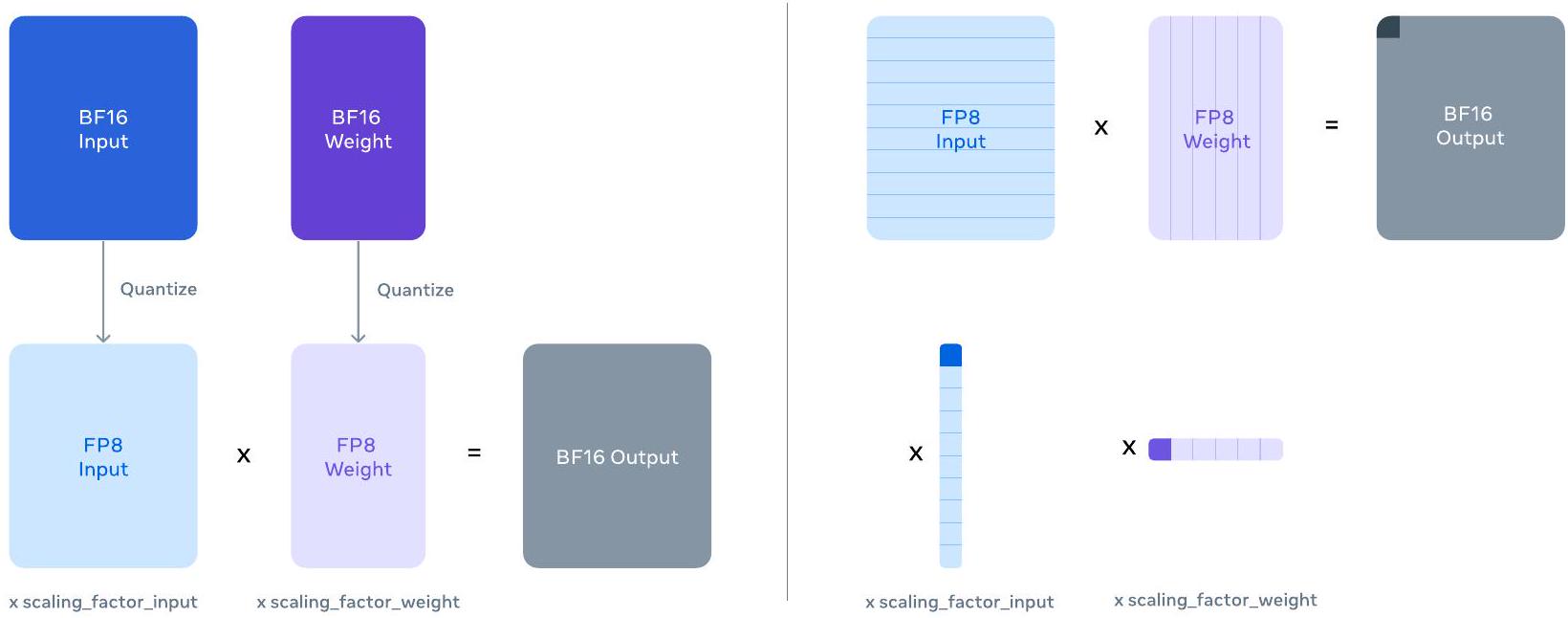

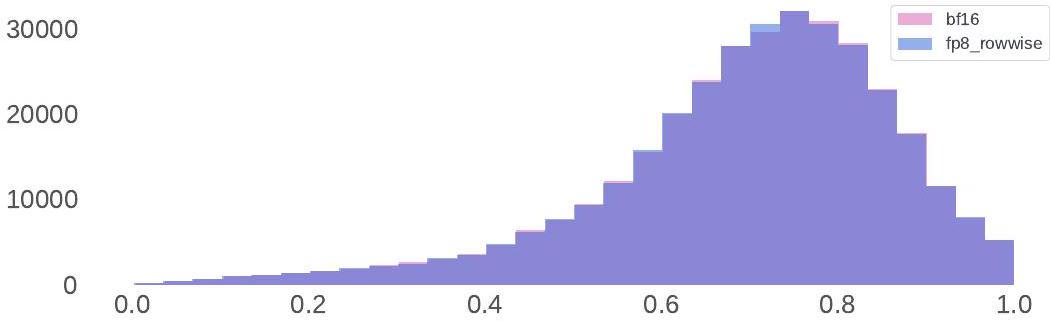

수치 안정성 (Numerical stability). 다른 병렬화 설정 간의 학습 loss를 비교하여, 우리는 학습 안정성에 영향을 미치는 몇 가지 수치 문제를 해결했다. 학습 수렴을 보장하기 위해, 우리는 여러 micro-batch에 걸쳐 backward 계산 동안 FP32 gradient accumulation을 사용하고, FSDP에서 data parallel worker 간에 FP32로 gradient를 reduce-scatter한다. forward 계산에서 여러 번 사용되는 중간 tensor, 예를 들어 vision encoder 출력의 경우, backward gradient도 FP32로 누적된다.

3.3.3 Collective Communication

Llama 3를 위한 우리의 collective communication library는 Nvidia의 NCCL 라이브러리를 포크한 NCCLX를 기반으로 한다. NCCLX는 특히 높은 지연 시간(latency)을 가진 네트워크에서 NCCL의 성능을 크게 향상시킨다.

병렬화 차원의 순서는 **[TP, CP, PP, DP]**이며, 여기서 DP는 FSDP에 해당한다. 가장 바깥쪽 병렬화 차원인 PP와 DP는 수십 마이크로초에 달하는 지연 시간을 가진 multi-hop 네트워크를 통해 통신할 수 있다.

FSDP의 기존 NCCL collective인 all-gather와 reduce-scatter, 그리고 PP의 point-to-point 통신은 데이터 청킹(chunking)과 단계별 데이터 복사(staged data copy)를 요구한다. 이러한 접근 방식은 다음과 같은 여러 비효율성을 초래한다:

(1) 데이터 전송을 용이하게 하기 위해 네트워크를 통해 많은 수의 작은 제어 메시지를 교환해야 함. (2) 추가적인 메모리 복사(memory-copy) 작업 발생. (3) 통신을 위해 추가적인 GPU 사이클 사용.

Llama 3 학습의 경우, 우리는 청킹과 데이터 전송을 네트워크 지연 시간에 맞게 튜닝하여 이러한 비효율성의 일부를 해결한다. 대규모 클러스터에서는 네트워크 지연 시간이 수십 마이크로초에 달할 수 있다. 또한, 우리는 작은 제어 메시지가 더 높은 우선순위로 네트워크를 통과하도록 허용하여, 특히 깊은 버퍼를 가진 코어 스위치에서 head-of-line blocking을 피하도록 한다. 향후 Llama 버전들을 위한 우리의 지속적인 연구는 NCCLX에 더 깊은 변경을 가하여 앞서 언급된 모든 문제들을 총체적으로 해결하는 것을 목표로 한다.

| Component | Category | Interruption Count | % of Interruptions |

|---|---|---|---|

| Faulty GPU | GPU | 148 | 30.1% |

| GPU HBM3 Memory | GPU | 72 | 17.2% |

| Software Bug | Dependency | 54 | 12.9% |

| Network Switch/Cable | Network | 35 | 8.4% |

| Host Maintenance | Unplanned Maintenance | 32 | 7.6% |

| GPU SRAM Memory | GPU | 19 | 4.5% |

| GPU System Processor | GPU | 17 | 4.1% |

| NIC | Host | 7 | 1.7% |

| NCCL Watchdog Timeouts | Unknown | 7 | 1.7% |

| Silent Data Corruption | GPU | 6 | 1.4% |

| GPU Thermal Interface + Sensor | GPU | 6 | 1.4% |

| SSD | Host | 3 | 0.7% |

| Power Supply | Host | 3 | 0.7% |

| Server Chassis | Host | 2 | 0.5% |

| IO Expansion Board | Host | 2 | 0.5% |

| Dependency | Dependency | 2 | 0.5% |

| CPU | Host | 2 | 0.5% |

| System Memory | Host | 2 | 0.5% |

Table 5: Llama 3 405B 사전 학습의 54일 기간 동안 발생한 예기치 않은 중단(interruption)의 근본 원인 분류. 예기치 않은 중단의 약 78%는 확인되거나 의심되는 하드웨어 문제로 인한 것이었다.

3.3.4 Reliability and Operational Challenges

16K GPU 학습의 복잡성과 잠재적 실패 시나리오는 우리가 운영했던 훨씬 더 큰 CPU 클러스터의 그것을 능가한다. 더욱이, 학습의 동기적 특성은 내결함성을 떨어뜨려, 단일 GPU 실패가 전체 작업의 재시작을 요구할 수 있다. 이러한 어려움에도 불구하고, Llama 3의 경우 펌웨어 및 Linux 커널 업그레이드와 같은 자동화된 클러스터 유지보수(Vigraham and Leonhardi, 2024)를 지원하면서 90% 이상의 유효 학습 시간을 달성했으며, 이는 매일 최소 한 번의 학습 중단을 초래했다. 유효 학습 시간은 경과 시간 대비 유용한 학습에 소요된 시간을 측정한다.

사전 학습의 54일 스냅샷 기간 동안, 우리는 총 466건의 작업 중단을 경험했다. 이 중 47건은 펌웨어 업그레이드와 같은 자동화된 유지보수 작업이나 구성 또는 데이터셋 업데이트와 같은 운영자 시작 작업으로 인한 계획된 중단이었다. 나머지 419건은 예상치 못한 중단이었으며, 이는 Table 5에 분류되어 있다. 예상치 못한 중단의 약 78%는 GPU 또는 호스트 구성 요소 고장과 같은 확인된 하드웨어 문제나, 무음 데이터 손상 및 계획되지 않은 개별 호스트 유지보수 이벤트와 같은 하드웨어 관련 문제로 인한 것으로 나타났다. GPU 문제가 가장 큰 범주로, **모든 예상치 못한 문제의 58.7%**를 차지했다. 많은 수의 실패에도 불구하고, 이 기간 동안 수동 개입이 필요한 경우는 단 세 번뿐이었으며, 나머지 문제는 자동화로 처리되었다.

유효 학습 시간을 늘리기 위해 우리는 작업 시작 및 체크포인트 시간을 줄였고, 빠른 진단 및 문제 해결 도구를 개발했다. 우리는 PyTorch의 내장 NCCL flight recorder (Ansel et al., 2024)를 광범위하게 사용한다. 이 기능은 집단 메타데이터 및 스택 트레이스를 링 버퍼에 캡처하여, 특히 NCCLX와 관련하여 대규모에서 멈춤(hang) 및 성능 문제를 신속하게 진단할 수 있게 해준다. 이를 통해 우리는 모든 통신 이벤트와 각 집단 작업의 지속 시간을 효율적으로 기록하고, NCCLX watchdog 또는 heartbeat timeout 시 자동으로 추적 데이터를 덤프한다. 우리는 코드 릴리스나 작업 재시작 없이 온라인 구성 변경 (Tang et al., 2015)을 통해 생산 환경에서 필요에 따라 계산 집약적인 추적 작업 및 메타데이터 수집을 선택적으로 활성화한다.

대규모 학습에서 문제 디버깅은 우리 네트워크에서 NVLink와 RoCE의 혼합 사용으로 인해 복잡하다. NVLink를 통한 데이터 전송은 일반적으로 CUDA 커널에 의해 발행된 load/store 작업으로 발생하며, 원격 GPU 또는 NVLink 연결의 실패는 명확한 오류 코드를 반환하지 않고 CUDA 커널 내에서 정지된 load/store 작업으로 나타나는 경우가 많다. NCCLX는 PyTorch와의 긴밀한 공동 설계를 통해 실패 감지 및 위치 파악의 속도와 정확성을 향상시키며, PyTorch가 NCCLX의 내부 상태에 접근하고 관련 정보를 추적할 수 있도록 한다. NVLink 실패로 인한 정지를 완전히 방지할 수는 없지만, 우리 시스템은 통신 라이브러리의 상태를 모니터링하고 이러한 정지가 감지되면 자동으로 타임아웃된다. 또한, NCCLX는 각 NCCLX 통신의 커널 및 네트워크 활동을 추적하고, 실패한 NCCLX 집단(collective)의 내부 상태 스냅샷을 제공하며, 여기에는 모든 랭크 간의 완료 및 보류 중인 데이터 전송이 포함된다. 우리는 이 데이터를 분석하여 NCCLX 스케일링 문제를 디버깅한다.

때로는 하드웨어 문제로 인해 여전히 작동하지만 느린 straggler가 발생하여 감지하기 어려울 수 있다. 단일 straggler도 수천 개의 다른 GPU를 느리게 만들 수 있으며, 종종 작동하지만 느린 통신으로 나타난다. 우리는 선택된 프로세스 그룹에서 잠재적으로 문제가 있는 통신에 우선순위를 부여하는 도구를 개발했다. 몇몇 상위 의심 대상을 조사함으로써, 우리는 일반적으로 straggler를 효과적으로 식별할 수 있었다.

흥미로운 관찰 중 하나는 대규모 학습 성능에 미치는 환경 요인의 영향이다. Llama 3 405B의 경우, 시간대에 따라 1-2%의 처리량 변동이 나타났다. 이러한 변동은 한낮의 높은 온도가 GPU의 동적 전압 및 주파수 스케일링에 영향을 미친 결과이다.

학습 중 수만 개의 GPU가 동시에 전력 소비를 늘리거나 줄일 수 있다. 예를 들어, 모든 GPU가 체크포인트 또는 집단 통신이 완료되기를 기다리거나, 전체 학습 작업의 시작 또는 종료로 인해 발생할 수 있다. 이러한 현상이 발생하면, 데이터 센터 전반에 걸쳐 수십 메가와트 규모의 즉각적인 전력 소비 변동이 발생하여 전력망의 한계를 시험할 수 있다. 이는 미래의 훨씬 더 큰 Llama 모델을 위한 학습을 확장함에 따라 우리에게 지속적인 도전 과제이다.

3.4 Training Recipe

Llama 3405B를 사전학습하는 데 사용된 레시피는 크게 세 가지 단계로 구성된다: (1) 초기 사전학습 (initial pre-training), (2) 긴 context 사전학습 (long-context pre-training), (3) 어닐링 (annealing). 이 세 단계는 아래에서 각각 설명한다. 우리는 8B 및 70B 모델을 사전학습하는 데에도 유사한 레시피를 사용한다.

3.4.1 Initial Pre-Training

우리는 Llama 3 405B를 AdamW optimizer로 사전학습했으며, **최대 학습률(peak learning rate)은 **이다. 학습률은 **8,000 스텝 동안 선형적으로 증가(linear warm up)**한 후, **1,200,000 스텝에 걸쳐 까지 코사인 형태로 감소(cosine learning rate schedule)**한다. 학습 초기에는 학습 안정성을 높이기 위해 더 낮은 batch size를 사용했으며, 이후 효율성 향상을 위해 점진적으로 증가시켰다. 구체적으로, 초기에는 4M 토큰의 batch size와 4,096 길이의 시퀀스를 사용했으며, 252M 토큰을 사전학습한 후에는 이 값들을 두 배로 늘려 8M 토큰의 batch size와 8,192 길이의 시퀀스를 사용했다. 2.87T 토큰을 사전학습한 후에는 batch size를 다시 16M으로 두 배 증가시켰다. 우리는 이러한 학습 방식이 매우 안정적임을 확인했다: loss spike가 거의 관찰되지 않았으며, 모델 학습 발산(divergence)을 수정하기 위한 개입이 필요 없었다.

데이터 믹스 조정 (Adjusting the data mix)

우리는 특정 다운스트림 task에서의 모델 성능을 향상시키기 위해 사전학습 데이터 믹스에 여러 조정을 가했다. 특히, Llama 3의 다국어 성능을 향상시키기 위해 사전학습 중 비영어 데이터의 비율을 늘렸다. 또한, 모델의 수학적 추론 성능을 향상시키기 위해 수학 관련 데이터를 upsample했으며, 모델의 지식 cut-off를 최신화하기 위해 사전학습 후반 단계에서 더 최근의 웹 데이터를 추가했다. 그리고 나중에 품질이 낮은 것으로 식별된 사전학습 데이터의 일부 하위 집합은 downsample했다.

3.4.2 Long Context Pre-Training

사전학습의 마지막 단계에서는 최대 128K 토큰의 context window를 지원하기 위해 긴 시퀀스로 학습한다. self-attention layer의 연산량이 시퀀스 길이에 따라 제곱으로 증가하기 때문에, 초기 단계에서는 긴 시퀀스로 학습하지 않는다. 우리는 지원되는 context 길이를 점진적으로 늘려가며, 모델이 증가된 context 길이에 성공적으로 적응할 때까지 사전학습을 진행한다. 성공적인 적응 여부는 다음 두 가지를 측정하여 평가한다: (1) 짧은 context 평가에서의 모델 성능이 완전히 회복되었는지, (2) 해당 길이까지 "needle in a haystack" task를 모델이 완벽하게 해결하는지. Llama 3 405B 사전학습에서는 원래의 8K context window에서 시작하여 최종 128K context window에 이르기까지 6단계에 걸쳐 context 길이를 점진적으로 증가시켰다. 이 long-context 사전학습 단계는 약 800B개의 학습 토큰을 사용하여 수행되었다.

Figure 7: Llama 3의 전체 post-training 접근 방식에 대한 설명. 우리의 post-training 전략은 rejection sampling, supervised finetuning, 그리고 direct preference optimization을 포함한다. 자세한 내용은 본문 참조.

Figure 7: Llama 3의 전체 post-training 접근 방식에 대한 설명. 우리의 post-training 전략은 rejection sampling, supervised finetuning, 그리고 direct preference optimization을 포함한다. 자세한 내용은 본문 참조.

3.4.3 Annealing

최종 4천만 개의 token에 대한 사전학습(pre-training) 동안, 우리는 **학습률(learning rate)을 0으로 선형적으로 감소(anneal)**시켰으며, 128K token의 context length를 유지하였다. 이 annealing 단계에서는 매우 높은 품질의 데이터 소스를 상향 샘플링(upsample)하도록 데이터 혼합(data mix)을 조정하였다. 자세한 내용은 Section 3.1.3을 참조하라. 마지막으로, 최종 사전학습 모델을 생성하기 위해 annealing 과정 동안 모델 checkpoint들의 평균(Polyak (1991) averaging)을 계산하였다.

4 Post-Training

우리는 사전학습된 체크포인트 위에 **여러 차례의 후속 학습(post-training)**을 적용하여 정렬된(aligned) Llama 3 모델을 생성한다. 이는 인간 피드백을 통해 모델을 정렬하는 과정이다 [Ouyang et al., 2022; Rafailov et al., 2024]. 각 후속 학습 라운드는 **지도 학습 기반 fine-tuning (SFT)**과 **Direct Preference Optimization (DPO; Rafailov et al., 2024)**으로 구성되며, 이 과정에서 사용되는 예시는 **인간 주석(human annotations)**을 통해 수집되거나 합성적으로 생성된다.

우리의 후속 학습 모델링 및 데이터 접근 방식은 각각 Section 4.1과 4.2에서 설명한다. 또한, Section 4.3에서는 추론, 코딩, 사실성, 다국어, 도구 사용, 긴 문맥, 그리고 정확한 지시 따르기 능력을 향상시키기 위한 맞춤형 데이터 큐레이션 전략을 상세히 설명한다.

4.1 Modeling

우리의 후속 학습(post-training) 전략의 핵심은 **보상 모델(reward model)**과 **언어 모델(language model)**이다. 우리는 먼저 사전학습된 체크포인트 위에 사람의 선호도 데이터로 보상 모델을 학습시킨다 (Section 4.1.2 참조). 그 다음, 사전학습된 체크포인트를 supervised finetuning (SFT)으로 fine-tuning하고 (Section 4.1.3 참조), **Direct Preference Optimization (DPO)를 사용하여 체크포인트를 추가적으로 정렬(align)**한다 (Section 4.1.4 참조). 이 과정은 Figure 7에 설명되어 있다. 별도로 언급되지 않는 한, 우리의 모델링 절차는 Llama 3405 B에 적용되며, 편의상 Llama 3405 B를 Llama 3라고 부른다.

4.1.1 Chat Dialog Format

LLM을 인간-AI 상호작용에 맞게 튜닝하기 위해서는, 모델이 인간의 지시를 이해하고 대화형 task를 수행할 수 있도록 채팅 대화 프로토콜을 정의해야 한다. 이전 버전과 비교하여 Llama 3는 **도구 사용(tool use)**과 같은 새로운 기능을 포함하고 있으며(Section 4.3.5), 이는 단일 대화 턴(turn) 내에서 여러 메시지를 생성하고 이를 다른 위치(예: user, ipython)로 전송해야 할 수 있다. 이를 지원하기 위해 우리는 다양한 특수 헤더(header) 및 종료(termination) 토큰을 사용하는 새로운 multi-message chat protocol을 설계하였다. 헤더 토큰은 대화에서 각 메시지의 **출발지(source)와 목적지(destination)**를 나타내는 데 사용된다. 마찬가지로, 종료 토큰은 인간과 AI가 발언권을 교대할 시점을 나타낸다.

4.1.2 Reward Modeling

우리는 사전학습된 checkpoint 위에 다양한 능력을 포괄하는 reward model (RM)을 학습시킨다. 학습 objective는 Llama 2와 동일하지만, 데이터 스케일링 이후 개선 효과가 줄어드는 것을 관찰하여 loss에서 margin term을 제거하였다. Llama 2와 마찬가지로, 우리는 유사한 응답을 가진 샘플들을 필터링한 후 모든 preference 데이터를 reward modeling에 사용한다. 표준적인 (chosen, rejected) 응답 쌍 외에도, 일부 prompt에 대해서는 세 번째 "edited response"가 추가로 생성된다. 이는 쌍에서 chosen response를 더욱 개선한 것이다 (Section 4.2.1 참조). 따라서 각 preference ranking 샘플은 명확한 순위(edited chosen rejected)를 가진 두 개 또는 세 개의 응답을 포함한다. 우리는 학습 중에 prompt와 여러 응답을 단일 행으로 연결하고 응답들을 무작위로 섞는다. 이는 응답들을 별도의 행에 배치하고 점수를 계산하는 표준 시나리오에 대한 근사치이지만, 우리의 ablation 연구에서는 이 접근 방식이 정확도 손실 없이 학습 효율성을 향상시키는 것으로 나타났다.

4.1.3 Supervised Finetuning

그 다음, **보상 모델(reward model)**은 인간 주석 prompt에 대한 rejection sampling을 수행하는 데 사용되며, 이에 대한 자세한 내용은 Section 4.2에 설명되어 있다. 이 rejection-sampled 데이터와 **다른 데이터 소스(합성 데이터 포함)**를 함께 사용하여, 우리는 사전학습된 language model을 target token에 대한 표준 cross entropy loss로 fine-tuning한다(prompt token에 대한 loss는 마스킹한다). 데이터 혼합에 대한 자세한 내용은 Section 4.2에서 확인할 수 있다. 우리는 이 단계를 **supervised fine-tuning (SFT)**이라고 부른다 (Wei et al., 2022a; Sanh et al., 2022; Wang et al., 2022b). 비록 많은 학습 target이 모델에 의해 생성된 것이지만 말이다. 우리의 가장 큰 모델들은 의 learning rate로 8.5K에서 9K 스텝에 걸쳐 fine-tuning되었다. 우리는 이러한 하이퍼파라미터 설정이 다양한 라운드와 데이터 혼합에서 잘 작동함을 확인했다.

4.1.4 Direct Preference Optimization

우리는 **인간 선호도 정렬(human preference alignment)**을 위해 **Direct Preference Optimization (DPO; Rafailov et al., 2024)**을 사용하여 SFT 모델을 추가 학습시킨다. 학습에는 주로 이전 정렬 라운드에서 가장 성능이 좋았던 모델들을 사용하여 수집된 최신 선호도 데이터 배치를 활용한다. 그 결과, 우리의 학습 데이터는 각 라운드에서 최적화되는 정책 모델(policy model)의 분포에 더 잘 부합하게 된다. 우리는 또한 PPO (Schulman et al., 2017)와 같은 on-policy 알고리즘도 탐색했지만, DPO가 대규모 모델에 대해 더 적은 연산량을 요구하며, 특히 IFEval (Zhou et al., 2023)과 같은 instruction following 벤치마크에서 더 나은 성능을 보였다. Llama 3의 경우, 학습률(learning rate)은 로 설정하고, 하이퍼파라미터는 0.1로 설정한다. 또한, DPO에 다음과 같은 알고리즘적 수정 사항을 적용한다:

- DPO loss에서 포맷팅 토큰 마스킹: DPO 학습의 안정화를 위해 헤더(header) 및 종료(termination) 토큰(Section 4.1.1에 설명)을 포함한 특수 포맷팅 토큰을 선택된(chosen) 응답과 거부된(rejected) 응답 모두에서 loss 계산 시 마스킹한다. 이러한 토큰들이 loss에 기여할 경우, 꼬리 반복(tail repetition)이나 갑작스러운 종료 토큰 생성과 같은 바람직하지 않은 모델 행동으로 이어질 수 있음을 관찰했다. 이는 DPO loss의 대조적(contrastive) 특성 때문이라고 가정한다. 즉, 선택된 응답과 거부된 응답 모두에 공통 토큰이 존재하면, 모델이 이 토큰들의 확률을 동시에 높이고 낮춰야 하므로 학습 목표가 충돌하게 된다.

- NLL loss를 통한 정규화: Pang et al. (2024)과 유사하게, 선택된 시퀀스에 대해 스케일링 계수 0.2를 가진 추가적인 negative log-likelihood (NLL) loss 항을 추가한다. 이는 생성을 위한 바람직한 포맷팅을 유지하고, 선택된 응답의 로그 확률 감소를 방지함으로써 DPO 학습을 더욱 안정화하는 데 도움이 된다 (Pang et al., 2024; Pal et al., 2024).

4.1.5 Model Averaging

마지막으로, 우리는 각 RM, SFT, DPO 단계에서 다양한 버전의 데이터 또는 하이퍼파라미터를 사용한 실험을 통해 얻은 모델들을 평균화한다 (Izmailov et al., 2019; Wortsman et al., 2022; Li et al., 2022).

| Dataset | % of comparisons | Avg. # turns per dialog | Avg. # tokens per example | Avg. # tokens in prompt | Avg. # tokens in response |

|---|---|---|---|---|---|

| General English | 81.99% | 4.1 | 1,000.4 | 36.4 | 271.2 |

| Coding | 6.93% | 3.2 | 1,621.0 | 113.8 | 462.9 |

| Multilingual | 5.19% | 1.8 | 1,299.4 | 77.1 | 420.9 |

| Reasoning and tools | 5.89% | 1.6 | 707.7 | 46.6 | 129.9 |

| Total | 100% | 3.8 | 1,041.6 | 44.5 | 284.0 |

Table 6: 인간 선호도 데이터 통계. Llama 3 정렬(alignment)에 사용된 내부 수집 인간 선호도 데이터의 통계를 나열한다. 우리는 어노테이터에게 모델과 **다중 턴 대화(multi-turn dialogues)**를 수행하고, 각 턴에서 응답 간의 비교를 수행하도록 요청한다. 후처리 과정에서 각 대화를 턴(turn) 수준에서 여러 예시로 분할한다. 각 예시는 **prompt (이전 대화가 있다면 포함)**와 **response (예: 선택되거나 거부된 응답)**로 구성된다.

4.1.6 Iterative Rounds

Llama 2를 따라, 우리는 위에서 언급한 방법들을 여섯 번의 라운드에 걸쳐 적용한다. 각 주기마다 새로운 선호도 어노테이션과 SFT 데이터를 수집하고, 최신 모델로부터 합성 데이터(synthetic data)를 샘플링한다.

4.2 Post-training Data

**학습 후 데이터 구성(post-training data composition)**은 언어 모델의 유용성과 동작에 결정적인 역할을 한다. 이 섹션에서는 인간 주석 절차 및 선호도 데이터 수집(Section 4.2.1), SFT 데이터 구성(Section 4.2.2), 그리고 데이터 품질 관리 및 정제 방법(Section 4.2.3)에 대해 논의한다.

4.2.1 Preference Data

우리의 선호도 데이터 어노테이션 프로세스는 Llama 2와 유사하다. 우리는 각 라운드 후에 여러 모델을 어노테이션에 배포하고, 각 사용자 prompt에 대해 두 개의 다른 모델에서 두 개의 응답을 샘플링한다. 이 모델들은 다양한 데이터 믹스와 alignment recipe로 학습될 수 있어, 서로 다른 능력 강점(예: 코드 전문성)과 증가된 데이터 다양성을 허용한다. 우리는 어노테이터에게 선택된 응답이 거부된 응답보다 얼마나 더 선호되는지에 따라 선호도 강도를 네 가지 수준 중 하나로 분류하여 평가하도록 요청한다: 상당히 더 좋음(significantly better), 더 좋음(better), 약간 더 좋음(slightly better), 또는 미미하게 더 좋음(marginally better). 우리는 또한 선호도 순위 지정 후 편집 단계를 통합하여 어노테이터가 선호하는 응답을 더욱 개선하도록 장려한다. 어노테이터는 선택된 응답을 직접 편집하거나, 모델에 피드백을 prompt로 제공하여 모델 자체의 응답을 개선한다. 결과적으로, 우리 선호도 데이터의 일부는 세 가지 응답이 순위가 매겨져 있다 (편집됨 > 선택됨 > 거부됨).

Table 6에서 우리는 Llama 3 학습에 사용하는 선호도 어노테이션 통계를 보고한다. **일반 영어(General English)**는 지식 기반 질문 및 답변 또는 정확한 지시 따르기와 같은 여러 하위 범주를 포함하며, 이는 특정 능력의 범위를 벗어난다. Llama 2와 비교하여, 우리는 prompt와 응답의 평균 길이가 증가했음을 관찰했으며, 이는 Llama 3를 더 복잡한 task로 학습시킨다는 것을 시사한다. 또한, 우리는 수집된 데이터를 엄격하게 평가하기 위해 품질 분석 및 인간 평가 프로세스를 구현하여, prompt를 개선하고 어노테이터에게 체계적이고 실행 가능한 피드백을 제공할 수 있도록 한다. 예를 들어, Llama 3가 각 라운드 후에 개선됨에 따라, 우리는 모델이 뒤처지는 영역을 목표로 삼기 위해 prompt 복잡도를 그에 맞춰 증가시킨다.

각 후처리 학습 라운드에서, 우리는 reward modeling을 위해 당시 사용 가능한 모든 선호도 데이터를 사용하며, DPO 학습을 위해서는 다양한 능력에서 가장 최신 배치만을 사용한다. reward modeling과 DPO 모두에서, 우리는 선택된 응답이 거부된 응답보다 상당히 더 좋거나 더 좋다고 라벨링된 샘플을 학습에 사용하고, 유사한 응답을 가진 샘플은 폐기한다.

4.2.2 SFT Data

우리의 fine-tuning 데이터는 주로 다음 소스로 구성된다:

- 사람이 주석을 단 프롬프트 컬렉션에서 rejection-sampled된 응답.

- 특정 기능을 목표로 하는 합성 데이터 (자세한 내용은 Section 4.3 참조).

| Dataset | % of examples | Avg. # turns | Avg. # tokens | Avg. # tokens in context | Avg. # tokens in final response |

|---|---|---|---|---|---|

| General English | 52.66% | 6.3 | 974.0 | 656.7 | 317.1 |

| Code | 14.89% | 2.7 | 753.3 | 378.8 | 374.5 |

| Multilingual | 3.01% | 2.7 | 520.5 | 230.8 | 289.7 |

| Exam-like | 8.14% | 2.3 | 297.8 | 124.4 | 173.4 |

| Reasoning and tools | 21.19% | 3.1 | 661.6 | 359.8 | 301.9 |

| Long context | 0.11% | 6.7 | 38,135.6 | 37,395.2 | 740.5 |

| Total | 100% | 4.7 | 846.1 | 535.7 | 310.4 |

Table 7 SFT 데이터 통계. Llama 3 정렬에 사용된 내부 수집 SFT 데이터를 나열한다. 각 SFT 예시는 context (즉, 마지막 턴을 제외한 모든 대화 턴)와 최종 응답으로 구성된다.

- 소량의 사람이 큐레이션한 데이터 (자세한 내용은 Section 4.3 참조).

post-training 라운드가 진행됨에 따라, 우리는 더 강력한 Llama 3 변형 모델을 개발하고, 이를 사용하여 광범위한 복잡한 기능을 포괄하는 더 큰 데이터셋을 수집한다. 이 섹션에서는 rejection-sampling 절차와 최종 SFT 데이터 혼합의 전체 구성에 대한 세부 사항을 논의한다.

Rejection sampling.

rejection sampling (RS) 과정에서, 사람이 주석을 단 각 프롬프트(Section 4.2.1)에 대해 최신 chat model policy (일반적으로 이전 post-training iteration에서 가장 성능이 좋았던 체크포인트 또는 특정 기능에 대해 가장 성능이 좋았던 체크포인트)에서 개 (일반적으로 10개에서 30개 사이)의 출력을 샘플링하고, 우리의 reward model을 사용하여 Bai et al. (2022)와 일관되게 최상의 후보를 선택한다. 후반부 post-training 라운드에서는 RS 응답이 바람직한 톤, 스타일 또는 형식에 부합하도록 유도하기 위해 system prompt를 도입하며, 이는 기능에 따라 다를 수 있다.

rejection sampling의 효율성을 높이기 위해 PagedAttention (Kwon et al., 2023)을 채택했다. PagedAttention은 동적 key-value cache 할당을 통해 메모리 효율성을 향상시킨다. 이는 현재 cache 용량에 따라 요청을 동적으로 스케줄링하여 임의의 출력 길이를 지원한다. 불행히도, 이는 메모리가 부족할 때 swap-out의 위험을 수반한다. 이러한 swap 오버헤드를 제거하기 위해 최대 출력 길이를 정의하고, 해당 길이의 출력을 수용할 수 있는 충분한 메모리가 있을 경우에만 요청을 수행한다. PagedAttention은 또한 프롬프트에 대한 key-value cache 페이지를 모든 해당 출력에 걸쳐 공유할 수 있도록 한다. 이 모든 것을 통해 rejection sampling 중 처리량이 2배 이상 향상된다.

전체 데이터 구성.

Table 7은 우리의 "helpfulness" 혼합의 각 광범위한 범주에 대한 데이터 통계를 보여준다. SFT와 preference 데이터는 중복되는 도메인을 포함하지만, 서로 다르게 큐레이션되어 고유한 통계를 나타낸다. Section 4.2.3에서는 데이터 샘플의 주제, 복잡성 및 품질을 분류하는 기술을 설명한다. 각 post-training 라운드에서 우리는 광범위한 벤치마크에서 성능을 조정하기 위해 이러한 축을 따라 전체 데이터 혼합을 신중하게 조정한다. 우리의 최종 데이터 혼합은 일부 고품질 소스에 대해 여러 번 epoch를 수행하고 다른 소스는 downsample한다.

4.2.3 Data Processing and Quality Control

대부분의 학습 데이터가 모델에 의해 생성되었기 때문에, 세심한 데이터 정제 및 품질 관리가 필요하다.

데이터 정제 (Data cleaning)

초기 라운드에서 우리는 이모지나 느낌표의 과도한 사용과 같이 데이터에서 흔히 나타나는 바람직하지 않은 패턴들을 다수 관찰했다. 따라서 우리는 문제성 데이터를 필터링하거나 정제하기 위해 일련의 규칙 기반 데이터 제거 및 수정 전략을 구현했다. 예를 들어, 지나치게 사과하는 듯한 어조 문제를 완화하기 위해, 우리는 과도하게 사용되는 문구("I'm sorry" 또는 "I apologize" 등)를 식별하고, 데이터셋 내에서 이러한 샘플의 비율을 신중하게 조절한다.

데이터 가지치기 (Data pruning)

우리는 또한 낮은 품질의 학습 샘플을 제거하고 전반적인 모델 성능을 향상시키기 위해 일련의 모델 기반 기술을 적용한다:

-

주제 분류 (Topic classification): 먼저 Llama 3 8B를 fine-tuning하여 주제 분류기로 만들고, 모든 데이터에 대해 추론을 수행하여 **거친 분류("mathematical reasoning")와 세밀한 분류("geometry and trigonometry")**로 나눈다.

-

품질 점수화 (Quality scoring): 우리는 reward model과 Llama 기반 신호를 모두 사용하여 각 샘플의 품질 점수를 얻는다. RM 기반 점수의 경우, RM 점수 상위 25%에 해당하는 데이터를 고품질로 간주한다. Llama 기반 점수의 경우, Llama 3 checkpoint에 prompt를 주어 각 샘플의 품질을 평가하게 한다. 일반 영어 데이터는 정확성, 지시 따르기, 어조/표현에 대해 3점 척도로, 코딩 데이터는 버그 식별 및 사용자 의도에 대해 2점 척도로 평가하며, 최대 점수를 얻은 샘플을 고품질로 간주한다. RM과 Llama 기반 점수는 불일치율이 높지만, 이 두 신호를 결합할 때 내부 테스트 세트에서 가장 좋은 recall을 얻는다는 것을 발견했다. 궁극적으로 우리는 RM 또는 Llama 기반 필터에 의해 고품질로 표시된 예시들을 선택한다.

-

난이도 점수화 (Difficulty scoring): 우리는 모델에게 더 복잡한 예시들을 우선적으로 제공하는 데에도 관심이 있기 때문에, Instag (Lu et al., 2023)과 Llama 기반 점수화라는 두 가지 난이도 측정 방법을 사용하여 데이터를 점수화한다. Instag의 경우, Llama 3 70B에 SFT prompt의 의도 태깅을 수행하도록 prompt를 주며, 더 많은 의도는 더 높은 복잡성을 의미한다. 또한 Llama 3에 prompt를 주어 대화의 난이도 (Liu et al., 2024c)를 3점 척도로 측정하게 한다.

-

의미론적 중복 제거 (Semantic deduplication): 마지막으로, 우리는 **의미론적 중복 제거 (Abbas et al., 2023; Liu et al., 2024c)**를 수행한다. 먼저 RoBERTa (Liu et al., 2019b)를 사용하여 전체 대화를 클러스터링하고, 각 클러스터 내에서 품질 점수 난이도 점수에 따라 정렬한다. 그런 다음 정렬된 모든 예시를 반복하면서 greedy selection을 수행하고, 클러스터 내에서 지금까지 본 예시들과의 최대 코사인 유사도가 특정 임계값 미만인 예시들만 유지한다.

4.3 Capabilities

우리는 **코드(Section 4.3.1), 다국어(Section 4.3.2), 수학 및 추론(Section 4.3.3), 긴 context(Section 4.3.4), 도구 사용(Section 4.3.5), 사실성(Section 4.3.6), 조종 가능성(Section 4.3.7)**과 같은 특정 기능에 대한 성능 향상을 위한 특별한 노력을 강조한다.

4.3.1 Code

코드용 LLM은 Copilot과 Codex (Chen et al., 2021) 출시 이후 상당한 주목을 받았다. 개발자들은 이제 이러한 모델을 널리 사용하여 코드 스니펫을 생성하고, 디버깅하며, 작업을 자동화하고, 코드 품질을 향상시키고 있다. Llama 3의 경우, 우리는 다음의 우선순위가 높은 프로그래밍 언어들(Python, Java, Javascript, C/C++, Typescript, Rust, PHP, HTML/CSS, SQL, bash/shell)에 대한 코드 생성, 문서화, 디버깅, 코드 리뷰 기능을 개선하고 평가하는 것을 목표로 한다. 여기서는 코드 전문가 학습, SFT를 위한 합성 데이터 생성, 시스템 prompt steering을 통한 포맷팅 개선, 그리고 학습 데이터에서 불량 샘플을 제거하기 위한 품질 필터 생성 등을 통해 이러한 코딩 기능을 향상시킨 우리의 작업을 제시한다.

전문가 학습 (Expert training). 우리는 후속 post-training 라운드 전반에 걸쳐 코드에 대한 고품질의 인간 주석을 수집하는 데 사용될 **코드 전문가(code expert)**를 학습시킨다. 이는 주된 pre-training 실행을 분기하여, 대부분(>85%) 코드 데이터로 구성된 1T 토큰 믹스로 pre-training을 계속함으로써 달성된다. domain-specific 데이터에 대한 지속적인 pre-training은 특정 domain에서의 성능 향상에 효과적인 것으로 나타났다 (Gururangan et al., 2020). 우리는 CodeLlama (Rozière et al., 2023)와 유사한 방식을 따른다. 학습의 마지막 수천 단계 동안, 우리는 **long-context finetuning (LCFT)**을 수행하여 전문가의 context 길이를 고품질의 repo-level 코드 데이터 믹스에서 16K 토큰으로 확장한다. 마지막으로, Section 4.1에 설명된 유사한 post-training 모델링 방식을 따라 이 모델을 정렬(align)하는데, 이때 SFT 및 DPO 데이터 믹스는 주로 코드를 대상으로 한다. 이 모델은 코딩 prompt에 대한 rejection sampling (Section 4.2.2)에도 사용된다.

합성 데이터 생성 (Synthetic data generation). 개발 과정에서 우리는 명령어 따르기 어려움, 코드 구문 오류, 잘못된 코드 생성, 버그 수정 어려움 등 코드 생성의 주요 문제점들을 확인했다. 집중적인 인간 주석 작업이 이론적으로 이러한 문제들을 해결할 수 있지만, 합성 데이터 생성은 더 낮은 비용과 더 큰 규모로 보완적인 접근 방식을 제공하며, 주석자의 전문성 수준에 제약받지 않는다. 따라서 우리는 Llama 3와 코드 전문가를 사용하여 대량의 합성 SFT 대화를 생성한다. 우리는 합성 코드 데이터를 생성하기 위한 세 가지 상위 수준 접근 방식을 설명한다. 총 2.7M개 이상의 합성 예시가 생성되어 SFT에 사용되었다.

-

합성 데이터 생성: 실행 피드백 (execution feedback). 8B 및 70B 모델은 더 크고 유능한 모델이 생성한 데이터로 학습될 때 상당한 성능 향상을 보인다. 그러나 초기 실험 결과, Llama 3 405B를 자체 생성 데이터로 학습시키는 것은 도움이 되지 않으며(심지어 성능을 저하시킬 수도 있음) 밝혀졌다. 이러한 한계를 해결하기 위해 우리는 실행 피드백(execution feedback)을 진실의 원천(source of truth)으로 도입하여, 모델이 자신의 실수로부터 학습하고 올바른 방향을 유지할 수 있도록 했다. 특히, 우리는 다음 과정을 사용하여 약 100만 개의 합성 코딩 대화로 구성된 대규모 데이터셋을 생성한다:

- 문제 설명 생성: 먼저, 우리는 long tail 분포에 있는 주제를 포함하여 다양한 주제를 아우르는 대규모 프로그래밍 문제 설명 컬렉션을 생성한다. 이러한 다양성을 달성하기 위해 우리는 다양한 소스에서 무작위 코드 스니펫을 샘플링하고, 이 예시들에서 영감을 받은 프로그래밍 문제를 생성하도록 모델에 prompt를 제공한다. 이를 통해 우리는 광범위한 주제를 활용하고 포괄적인 문제 설명 세트를 만들 수 있었다 (Wei et al., 2024).

- 솔루션 생성: 다음으로, 우리는 Llama 3에 주어진 프로그래밍 언어로 각 문제를 해결하도록 prompt를 제공한다. prompt에 좋은 프로그래밍의 일반적인 규칙을 추가하면 생성된 솔루션 품질이 향상된다는 것을 관찰했다. 또한, 모델이 자신의 사고 과정을 주석으로 설명하도록 요구하는 것이 도움이 된다는 것을 발견했다.

- 정확성 분석: 솔루션을 생성한 후, 그 정확성이 보장되지 않으며, 부정확한 솔루션을 finetuning 데이터셋에 포함하면 모델의 품질을 해칠 수 있다는 점을 인식하는 것이 중요하다. 우리는 완전한 정확성을 보장하지는 않지만, 이를 근사화하는 방법을 개발한다. 이를 위해 우리는 생성된 솔루션에서 소스 코드를 추출하고, 정확성을 테스트하기 위해 정적 및 동적 분석 기술을 조합하여 적용한다. 여기에는 다음이 포함된다:

- 정적 분석: 우리는 생성된 모든 코드를 파서(parser)와 린터(linter)를 통해 실행하여 구문 정확성을 보장하고, 구문 오류, 초기화되지 않은 변수 사용, import되지 않은 함수 사용, 코드 스타일 문제, 타입 오류 등과 같은 오류를 잡아낸다.

- 단위 테스트 생성 및 실행: 각 문제와 솔루션에 대해 우리는 모델에 단위 테스트를 생성하도록 prompt를 제공하며, 이 테스트는 컨테이너화된 환경에서 솔루션과 함께 실행되어 런타임 실행 오류 및 일부 의미론적 오류를 잡아낸다.

- 오류 피드백 및 반복적인 자체 수정: 솔루션이 어떤 단계에서든 실패하면, 우리는 모델에 이를 수정하도록 prompt를 제공한다. prompt에는 **원래 문제 설명, 오류가 있는 솔루션, 그리고 파서/린터/테스터의 피드백(stdout, stderr 및 반환 코드)**이 포함되었다. 단위 테스트 실행 실패 후, 모델은 기존 테스트를 통과하도록 코드를 수정하거나, 생성된 코드에 맞게 단위 테스트를 수정할 수 있었다. 모든 검사를 통과한 대화만 최종 데이터셋에 포함되어 supervised finetuning (SFT)에 사용된다. 특히, 우리는 약 20%의 솔루션이 처음에는 부정확했지만 자체 수정되었음을 관찰했는데, 이는 모델이 실행 피드백으로부터 학습하고 성능을 향상시켰음을 나타낸다.

- Fine-tuning 및 반복적인 개선: finetuning 프로세스는 여러 라운드에 걸쳐 수행되며, 각 라운드는 이전 라운드를 기반으로 구축된다. 각 라운드 후에 모델은 개선되어 다음 라운드를 위한 더 높은 품질의 합성 데이터를 생성한다. 이 반복적인 프로세스는 모델 성능의 점진적인 개선 및 향상을 가능하게 한다.

-

합성 데이터 생성: 프로그래밍 언어 번역 (programming language translation). 우리는 주요 프로그래밍 언어(예: Python/C++)와 덜 일반적인 언어(예: Typescript/PHP) 사이에 성능 격차가 있음을 관찰한다. 이는 덜 일반적인 프로그래밍 언어에 대한 학습 데이터가 적기 때문에 놀라운 일은 아니다. 이를 완화하기 위해 우리는 일반적인 프로그래밍 언어의 데이터를 덜 일반적인 언어로 번역하여 기존 데이터를 보완한다 (추론의 맥락에서 Chen et al. (2023)과 유사). 이는 Llama 3에 prompt를 제공하고 구문 분석, 컴파일 및 실행을 통해 품질을 보장함으로써 달성된다. Figure 8은 Python에서 PHP 코드로 번역된 합성 PHP 코드의 예시를 보여준다. 이는 MultiPL-E (Cassano et al., 2023) 벤치마크로 측정했을 때 덜 일반적인 언어의 성능을 크게 향상시킨다.

-

합성 데이터 생성: 역번역 (backtranslation). 품질을 결정하는 데 실행 피드백이 덜 유익한 특정 코딩 기능(예: 문서화, 설명)을 개선하기 위해 우리는 대체 다단계 접근 방식을 사용한다. 이 절차를 사용하여 우리는 코드 설명, 생성, 문서화 및 디버깅과 관련된 약 1.2M개의 합성 대화를 생성했다. 사전학습 데이터의 다양한 언어로 된 코드 스니펫부터 시작하여:

- 생성: 우리는 Llama 3에 우리의 목표 기능(target capability)을 나타내는 데이터를 생성하도록 prompt를 제공한다 (예: 코드 스니펫에 주석과 docstring을 추가하거나, 모델에 코드 조각을 설명하도록 요청한다).

- 역번역: 그런 다음 우리는 모델에 합성으로 생성된 데이터를 원래 코드로 "역번역"하도록 prompt를 제공한다 (예: 모델에 문서화만으로 코드를 생성하도록 요청하거나, 모델에 설명만으로 코드를 생성하도록 요청한다).

- 필터링: 원래 코드를 참조로 사용하여 우리는 Llama 3에 출력의 품질을 결정하도록 prompt를 제공한다 (예: 모델에 역번역된 코드가 원본에 얼마나 충실한지 묻는다). 그런 다음 우리는 가장 높은 자체 검증 점수를 가진 생성된 예시들을 SFT에 사용한다.

def gushti_cdi(): <?php

arr = lisput()p(int, input().split()))

points = 0

for i in range(n):

if arr[i] == 0 and i != 0:

idx = arr.index(max(arr[:i]))

points += arr[idx]

arr[idx] = 0

return points

for _ in range(int(input())):

print(gushti_cdi())

function gushti_cdi() {

sar (int) fgets(STDIN);

parr = explode(" ", fgets(STDIN));

$points = 0;

for ($i = 0; $i < $n; $i++) {

if ($arr[$i] == 0 && $i != 0) {

$maxVal = max(array_slice($arr, 0, $i));

$idx = array_search($maxVal, $arr);

$points += $arr[$idx];

$arr[$idx] = 0;

}

}

return $points;

}

$t = (int)fgets(STDIN);

for ($i = 0; $i < $t; $i++) {

echo gushti_cdi() . "\n";

?>

Figure 8: 코드 번역 예시. Llama 3를 사용하여 Python 코드(왼쪽)를 PHP 코드(오른쪽)로 번역하여 SFT 데이터셋에 더 넓은 범위의 프로그래밍 언어를 추가하는 예시를 보여준다.

public static int ClimbStairs(int n)

{

if (n == 1)

{

return 1;

}

if (n == 2)

{

return 2;

}

int[] dp = new int[n + 1];

dp[1] = 1;

dp[2] = 2;

for (int i = 3; i <= n; i++)

{ (1nt i , ++)

{

dp[i] = dp[i - 1] + dp[i - 2];

}

return dp[n];

}

public static int ClimbStairs(int n)

{

// Base cases

if (n == 1) return 1;

if (n == 2) return 2;

// Initialize variables to store the number

of ways to climb

int prev = 1;

int curr = 2;

// Calculate the number of ways to climb for

n > 2

for

{ (int i = 3; i <= n; i++)

{

int temp = curr;

curr = prev + curr;

prev = temp;

}

return curr;

}

Figure 9: 시스템 prompt를 통한 생성된 코드 품질 향상. 왼쪽: 시스템 prompt 없음. 오른쪽: 시스템 prompt 있음.

Rejection sampling 중 시스템 prompt steering. rejection sampling 과정에서 우리는 코드 가독성, 문서화, 철저함, 특이성을 향상시키기 위해 코드별 시스템 prompt를 사용했다. Section 7에서 언급했듯이 이 데이터는 언어 모델을 fine-tuning하는 데 사용된다. Figure 9는 시스템 prompt가 생성된 코드 품질을 향상시키는 방법을 보여준다. 즉, 필요한 주석을 추가하고, 더 유익한 변수 이름을 사용하며, 메모리를 절약하는 등의 작업을 수행한다.

실행 및 model-as-judge 신호를 통한 학습 데이터 필터링. Section 4.2.3에서 설명했듯이, 우리는 rejection-sampled 데이터에서 버그가 포함된 코드 블록과 같은 품질 문제를 가끔 발견한다. rejection-sampled 데이터에서 이러한 문제를 감지하는 것은 합성 코드 데이터만큼 간단하지 않다. 왜냐하면 rejection-sampled 응답은 일반적으로 자연어와 코드가 혼합되어 있으며, 코드가 항상 실행 가능할 것으로 예상되지 않을 수 있기 때문이다. (예를 들어, 사용자 prompt는 명시적으로 의사 코드(pseudo-code)나 실행 가능한 프로그램의 아주 작은 스니펫에 대한 편집을 요청할 수 있다.) 이를 해결하기 위해 우리는 "model-as-judge" 접근 방식을 활용한다. 여기서 Llama 3의 이전 버전이 코드 정확성(code correctness)과 코드 스타일(code style)이라는 두 가지 기준에 따라 이진(0/1) 점수를 평가하고 할당한다. 우리는 완벽한 점수 2를 달성한 샘플만 유지한다. 처음에는 이러한 엄격한 필터링이 다운스트림 벤치마크 성능의 회귀(regression)로 이어졌는데, 이는 주로 도전적인 prompt가 포함된 예시를 불균형적으로 제거했기 때문이다. 이를 상쇄하기 위해 우리는 가장 도전적인 것으로 분류된 일부 코딩 데이터의 응답을 Llama 기반 "model-as-judge" 기준을 충족할 때까지 전략적으로 수정했다. 이러한 도전적인 문제를 개선함으로써 코딩 데이터는 품질과 난이도 사이의 균형을 달성하여 최적의 다운스트림 성능을 이끌어낸다.

4.3.2 Multilinguality

우리는 Llama 3의 다국어 능력을 향상시키기 위한 방법을 설명한다. 여기에는 상당히 더 많은 다국어 데이터에 특화된 expert 모델 학습, 독일어, 프랑스어, 이탈리아어, 포르투갈어, 힌디어, 스페인어, 태국어에 대한 고품질 다국어 instruction tuning 데이터 확보 및 생성, 그리고 다국어 언어 조향(language steering)의 특정 과제 해결을 통해 모델의 전반적인 성능을 향상시키는 내용이 포함된다.

Expert 학습. Llama 3의 사전학습 데이터 혼합(mix)은 비영어 토큰보다 영어 토큰을 훨씬 더 많이 포함한다. 비영어권 언어에서 더 높은 품질의 인간 주석(human annotations)을 수집하기 위해, 우리는 사전학습 실행에서 분기하여 90%의 다국어 토큰으로 구성된 데이터 혼합으로 사전학습을 계속 진행함으로써 다국어 expert를 학습시킨다. 그런 다음 Section 4.1에 따라 이 expert에 대해 **후처리 학습(post-training)**을 수행한다. 이 expert 모델은 사전학습이 완전히 완료될 때까지 비영어권 언어에서 더 높은 품질의 주석을 수집하는 데 사용된다.

다국어 데이터 수집. 우리의 다국어 SFT 데이터는 주로 아래 설명된 출처에서 파생된다. 전체 분포는 2.4%의 인간 주석, 44.2%의 다른 NLP task 데이터, 18.8%의 rejection sampled 데이터, 34.6%의 번역된 reasoning 데이터로 구성된다.

- 인간 주석 (Human annotations): 우리는 언어학자와 원어민으로부터 고품질의 수동으로 주석된 데이터를 수집한다. 이 주석은 대부분 실제 사용 사례를 나타내는 open-ended prompt로 구성된다.

- 다른 NLP task 데이터 (Data from other NLP tasks): 추가적으로 데이터를 보강하기 위해, 우리는 다른 task의 다국어 학습 데이터를 사용하고 이를 대화 형식으로 재작성한다. 예를 들어, 우리는 exams-qa (Hardalov et al., 2020) 및 Conic10k (Wu et al., 2023)의 데이터를 사용한다. 언어 정렬(language alignment)을 개선하기 위해 GlobalVoices (Prokopidis et al., 2016) 및 Wikimedia (Tiedemann, 2012)의 병렬 텍스트도 사용한다. 우리는 LID 기반 필터링과 Blaser2.0 (Seamless Communication et al., 2023)을 사용하여 저품질 데이터를 제거한다. 병렬 텍스트 데이터의 경우, bitext 쌍을 직접 사용하는 대신, Wei et al. (2022a)에서 영감을 받은 다국어 템플릿을 적용하여 번역 및 언어 학습 시나리오에서 실제 대화를 더 잘 시뮬레이션한다.

- Rejection sampled 데이터 (Rejection sampled data): 우리는 인간 주석 prompt에 대해 rejection sampling을 적용하여 fine-tuning을 위한 고품질 샘플을 생성한다. 이 과정은 영어 데이터에 대한 과정과 비교하여 몇 가지 수정 사항이 있다:

- 생성 (Generation): 후처리 학습 초기 단계에서 다양한 생성을 위해 온도(temperature) 하이퍼파라미터를 0.2-1 범위에서 무작위로 선택하는 것을 탐색했다. 높은 온도에서는 다국어 prompt에 대한 응답이 창의적이고 영감을 줄 수 있지만, 불필요하거나 부자연스러운 code-switching에 취약할 수도 있다. 후처리 학습의 최종 단계에서는 trade-off의 균형을 맞추기 위해 0.6의 상수 값을 사용한다. 또한, 응답 형식, 구조 및 전반적인 가독성을 개선하기 위해 특수 시스템 prompt를 사용했다.

- 선택 (Selection): reward model 기반 선택 전에, prompt와 응답 간의 높은 언어 일치율을 보장하기 위해 다국어별 특정 검사를 구현한다 (예: 로마자화된 힌디어 prompt는 힌디어 데바나가리 스크립트로 된 응답을 기대해서는 안 된다).

- 번역된 데이터 (Translated data): 우리는 translationese (Bizzoni et al., 2020; Muennighoff et al., 2023) 또는 가능한 이름 편향 (Wang et al., 2022a), 성별 편향 (Savoldi et al., 2021), 문화적 편향 (Ji et al., 2023)을 방지하기 위해 모델을 fine-tuning할 때 기계 번역된 데이터 사용을 피하려고 노력한다. 또한, 모델이 영어 문화적 맥락에 뿌리를 둔 task에만 노출되는 것을 방지하고자 한다. 이는 우리가 포착하고자 하는 언어적, 문화적 다양성을 대표하지 않을 수 있기 때문이다. 우리는 이에 대한 한 가지 예외를 두어, 비영어권 언어의 정량적 추론 성능을 향상시키기 위해 합성 정량적 추론 데이터(자세한 내용은 Section 4.3.3 참조)를 번역했다. 이러한 수학 문제의 언어는 단순한 특성을 가지므로, 번역된 샘플에서 품질 문제가 거의 또는 전혀 발견되지 않았다. 이 번역된 데이터를 추가함으로써 MGSM (Shi et al., 2022)에서 강력한 성능 향상을 관찰했다.

4.3.3 Math and Reasoning

우리는 **추론(reasoning)**을 다단계 계산을 수행하고 올바른 최종 답변에 도달하는 능력으로 정의한다. 수학적 추론에 뛰어난 모델을 훈련하기 위한 우리의 접근 방식은 다음과 같은 여러 도전 과제에 의해 결정된다:

- 프롬프트 부족: 질문의 복잡성이 증가함에 따라, Supervised Fine-Tuning (SFT)을 위한 유효한 프롬프트 또는 질문의 수가 감소한다. 이러한 희소성으로 인해 모델에 다양한 수학적 기술을 가르치기 위한 다양하고 대표적인 훈련 데이터셋을 생성하기 어렵다 (Yu et al., 2023; Yue et al., 2023; Luo et al., 2023; Mitra et al., 2024; Shao et al., 2024; Yue et al., 2024b).

- 정답 chain of thought 부족: 효과적인 추론은 추론 과정을 용이하게 하기 위한 단계별 해결책을 필요로 한다 (Wei et al., 2022c). 그러나 문제를 단계별로 분해하고 최종 답변에 도달하는 방법을 모델에 안내하는 데 필수적인 정답 chain of thought가 종종 부족하다 (Zelikman et al., 2022).

- 중간 단계의 부정확성: 모델이 생성한 chain of thought를 사용할 때, 중간 단계가 항상 정확하지 않을 수 있다 (Cobbe et al., 2021; Uesato et al., 2022; Lightman et al., 2023; Wang et al., 2023a). 이러한 부정확성은 잘못된 최종 답변으로 이어질 수 있으므로 해결해야 한다.

- 모델에 외부 도구 사용법 가르치기: 코드 인터프리터와 같은 외부 도구를 활용하도록 모델을 향상시키면, 코드와 텍스트를 interleave하여 추론할 수 있게 된다 (Gao et al., 2023; Chen et al., 2022; Gou et al., 2023). 이 능력은 문제 해결 능력을 크게 향상시킬 수 있다.

- 훈련과 추론 간의 불일치: 모델이 훈련 중에 fine-tuning되는 방식과 추론 중에 사용되는 방식 사이에 종종 불일치가 존재한다. 추론 중에 fine-tuned 모델은 사람 또는 다른 모델과 상호 작용할 수 있으며, 피드백을 사용하여 추론을 개선해야 한다. 훈련과 실제 사용 간의 일관성을 보장하는 것은 추론 성능을 유지하는 데 중요하다.

이러한 도전 과제를 해결하기 위해 우리는 다음 방법론을 적용한다:

- 프롬프트 부족 문제 해결: 우리는 수학적 맥락에서 관련 사전 훈련 데이터를 확보하고 이를 질문-답변 형식으로 변환하여 supervised fine-tuning에 사용할 수 있도록 한다. 또한, 모델이 성능이 저조한 수학적 기술을 식별하고, 해당 기술을 모델에 가르치기 위해 사람으로부터 프롬프트를 적극적으로 확보한다. 이 과정을 용이하게 하기 위해 우리는 수학적 기술의 taxonomy를 생성하고 (Didolkar et al., 2024) 사람들에게 그에 맞는 관련 프롬프트/질문을 제공하도록 요청한다.

- 단계별 추론 trace로 훈련 데이터 증강: 우리는 Llama 3를 사용하여 일련의 프롬프트에 대한 단계별 해결책을 생성한다. 각 프롬프트에 대해 모델은 가변적인 수의 생성을 생성한다. 이 생성들은 올바른 답변을 기반으로 필터링된다 (Li et al., 2024a). 또한 Llama 3를 사용하여 특정 단계별 해결책이 주어진 질문에 대해 유효한지 확인하는 self-verification을 수행한다. 이 과정은 모델이 유효한 추론 trace를 생성하지 않는 경우를 제거하여 fine-tuning 데이터의 품질을 향상시킨다.

- 부정확한 추론 trace 필터링: 우리는 중간 추론 단계가 부정확한 훈련 데이터를 필터링하기 위해 outcome 및 stepwise reward model을 훈련한다 (Lightman et al., 2023; Wang et al., 2023a). 이 reward model은 유효하지 않은 단계별 추론이 포함된 데이터를 제거하여 fine-tuning을 위한 고품질 데이터를 보장하는 데 사용된다. 더 어려운 프롬프트의 경우, 학습된 step-wise reward model과 함께 **Monte Carlo Tree Search (MCTS)**를 사용하여 유효한 추론 trace를 생성함으로써 고품질 추론 데이터 수집을 더욱 향상시킨다 (Xie et al., 2024).

- 코드와 텍스트 추론의 interleaving: 우리는 Llama 3에게 텍스트 추론과 관련 Python 코드를 조합하여 추론 문제를 해결하도록 프롬프트한다 (Gou et al., 2023). 코드 실행은 추론 chain이 유효하지 않은 경우를 제거하는 피드백 신호로 사용되어 추론 과정의 정확성을 보장한다.

- 피드백과 실수로부터 학습: 인간 피드백을 시뮬레이션하기 위해, 우리는 부정확한 생성(즉, 부정확한 추론 trace로 이어지는 생성)을 활용하고, Llama 3에게 올바른 생성을 생성하도록 프롬프트하여 오류 수정을 수행한다 (An et al., 2023b; Welleck et al., 2022; Madaan et al., 2024a). 부정확한 시도에서 얻은 피드백을 사용하고 이를 수정하는 반복적인 과정은 모델의 정확한 추론 능력과 실수로부터 학습하는 능력을 향상시키는 데 도움이 된다.

4.3.4 Long Context

최종 사전학습 단계에서 우리는 Llama 3의 context 길이를 8K 토큰에서 128K 토큰으로 확장한다 (자세한 내용은 Section 3.4 참조). 사전학습과 유사하게, fine-tuning 시에도 짧은 context와 긴 context 능력의 균형을 맞추기 위해 레시피를 신중하게 조정해야 한다는 것을 발견했다.

SFT 및 합성 데이터 생성 (SFT and synthetic data generation)

기존 SFT 레시피를 짧은 context 데이터에만 순진하게 적용한 결과, 사전학습에서 얻은 긴 context 능력에 상당한 퇴보가 발생했다. 이는 SFT 데이터 혼합에 긴 context 데이터를 포함할 필요성을 강조한다. 그러나 실제로는 긴 context를 읽는 것이 지루하고 시간이 많이 소요되기 때문에, 인간이 이러한 예시들을 주석(annotate)하는 것은 거의 불가능하다. 따라서 우리는 이러한 격차를 메우기 위해 주로 합성 데이터에 의존한다. 우리는 Llama 3의 이전 버전을 사용하여 주요 긴 context 사용 사례(다중 턴 질의응답, 긴 문서 요약, 코드 저장소 추론)를 기반으로 합성 데이터를 생성했으며, 이에 대해 아래에서 더 자세히 설명한다.

- 질의응답 (Question answering): 우리는 사전학습 데이터 혼합에서 긴 문서 세트를 신중하게 선별한다. 이 문서들을 8K 토큰 단위로 분할하고, Llama 3 모델의 이전 버전에 무작위로 선택된 청크(chunk)에 조건부로 QA 쌍을 생성하도록 prompt를 주었다. 학습 중에는 전체 문서가 context로 사용된다.

- 요약 (Summarization): 우리는 긴 context 문서의 계층적 요약을 적용했다. 먼저 가장 강력한 Llama 3 8K context 모델을 사용하여 8K 입력 길이의 청크를 요약한 다음, 요약된 내용을 다시 요약했다. 학습 중에는 전체 문서를 제공하고 모델이 모든 중요한 세부 사항을 보존하면서 문서를 요약하도록 prompt를 주었다. 또한 문서 요약을 기반으로 QA 쌍을 생성하고, 전체 긴 문서에 대한 전역적인 이해를 요구하는 질문으로 모델에 prompt를 주었다.

- 긴 context 코드 추론 (Long context code reasoning): 우리는 Python 파일을 파싱하여 import 문을 식별하고 그 종속성을 결정한다. 여기에서 가장 일반적으로 의존되는 파일, 특히 다른 파일 5개 이상에서 참조되는 파일을 선택한다. 이 핵심 파일 중 하나를 저장소에서 제거하고, 모델이 누락된 파일에 의존하는 파일을 식별하고 필요한 누락된 코드를 생성하도록 prompt를 주었다.

우리는 입력 길이의 보다 세밀한 타겟팅을 가능하게 하기 위해 이러한 합성 생성 샘플을 시퀀스 길이(16K, 32K, 64K, 128K)에 따라 추가로 분류한다.

신중한 ablation을 통해, 합성 생성된 긴 context 데이터 0.1%를 원래의 짧은 context 데이터와 혼합하면 짧은 context 및 긴 context 벤치마크 모두에서 성능이 최적화된다는 것을 확인했다.

DPO. 우리는 DPO에서 짧은 context 학습 데이터만 사용하는 것이 긴 context 성능에 부정적인 영향을 미치지 않는다는 것을 확인했다. 이는 SFT 모델이 긴 context task에서 고품질인 한 유효하다. 우리는 이러한 현상이 DPO 레시피가 SFT보다 optimizer step이 적기 때문이라고 추측한다. 이러한 발견을 바탕으로, 우리는 긴 context SFT 체크포인트 위에 DPO를 위한 표준 짧은 context 레시피를 유지한다.

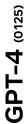

4.3.5 Tool Use

검색 엔진이나 코드 인터프리터와 같은 도구를 사용하도록 LLM을 학습시키는 것은 LLM이 해결할 수 있는 task의 범위를 크게 확장시키며, 순수한 챗 모델에서 더욱 일반적인 assistant로 변모시킨다 (Nakano et al., 2021; Thoppilan et al., 2022; Parisi et al., 2022; Gao et al., 2023; Mialon et al., 2023a; Schick et al., 2024). 우리는 Llama 3가 다음 도구들과 상호작용하도록 학습시켰다:

-

검색 엔진: Llama 3는 Brave Search를 사용하여 지식 cutoff를 넘어서는 최신 사건에 대한 질문이나 웹에서 특정 정보를 검색해야 하는 질문에 답하도록 학습되었다.

-

Python interpreter: Llama 3는 복잡한 계산을 수행하고, 사용자가 업로드한 파일을 읽고, 이를 기반으로 질문 응답, 요약, 데이터 분석 또는 시각화와 같은 task를 해결하기 위해 코드를 생성하고 실행할 수 있다.

-

수학 계산 엔진: Llama 3는 Wolfram Alpha API를 사용하여 수학, 과학 문제를 더 정확하게 해결하거나 Wolfram의 데이터베이스에서 정확한 정보를 검색할 수 있다.

그 결과, 모델은 이러한 도구들을 챗 환경에서 사용하여 사용자의 쿼리를 해결할 수 있으며, 이는 다중 턴(multi-turn) 대화에서도 가능하다. 쿼리가 여러 도구 호출을 필요로 하는 경우, 모델은 단계별 계획을 작성하고, 도구를 순차적으로 호출하며, 각 도구 호출 후에 추론을 수행할 수 있다.

또한 우리는 Llama 3의 zero-shot tool use 능력을 향상시켰다. 즉, in-context로 제공되는, 잠재적으로 이전에 본 적 없는 도구 정의와 사용자 쿼리가 주어졌을 때, 모델이 올바른 도구 호출을 생성하도록 학습시켰다.

구현 (Implementation)

우리는 핵심 도구들을 다양한 메서드를 가진 Python 객체로 구현한다. Zero-shot 도구는 설명, 문서(예: 사용 방법 예시)를 포함하는 Python 함수로 구현될 수 있으며, 모델은 적절한 호출을 생성하기 위해 함수의 signature와 docstring만 context로 필요로 한다. 또한 우리는 함수 정의와 호출을 JSON 형식으로 변환한다 (예: 웹 API 호출의 경우). 모든 도구 호출은 Python interpreter에 의해 실행되어야 하며, 이는 Llama 3 시스템 프롬프트에서 활성화되어야 한다. 핵심 도구들은 시스템 프롬프트에서 개별적으로 활성화하거나 비활성화할 수 있다.

데이터 수집 (Data collection)

Schick et al. (2024)와 달리, 우리는 Llama 3가 도구를 사용하도록 가르치기 위해 인간의 주석(annotation)과 선호도(preference)에 의존한다. Llama 3에서 일반적으로 사용되는 post-training 파이프라인과 비교하여 두 가지 주요 차이점이 있다:

- 도구 사용의 경우, 대화는 종종 단일 assistant 메시지 이상을 포함한다 (예: 도구를 호출하고 도구 출력에 대해 추론하는 과정). 따라서 우리는 메시지 수준에서 주석을 달아 세분화된 피드백을 수집한다: 주석자는 동일한 context를 가진 두 assistant 메시지 사이에서 선호도를 제공하거나, 둘 다 심각한 문제가 있는 경우 메시지 중 하나를 편집한다. 선택되거나 편집된 메시지는 context에 추가되고 대화가 계속된다. 이는 assistant의 도구 호출 능력과 도구 출력에 대한 추론 능력 모두에 대한 인간 피드백을 제공한다. 주석자는 도구 출력을 순위 매기거나 편집할 수 없다.

- 우리는 rejection sampling을 수행하지 않았다. 이는 우리의 도구 벤치마크에서 성능 향상을 관찰하지 못했기 때문이다.

주석 프로세스를 가속화하기 위해, 우리는 이전 Llama 3 체크포인트에서 합성적으로 생성된 데이터로 fine-tuning하여 기본적인 도구 사용 능력을 부트스트랩하는 것으로 시작한다. 따라서 주석자는 수행해야 할 편집 작업이 줄어든다. 유사하게, Llama 3가 개발을 통해 점진적으로 개선됨에 따라, 우리는 인간 주석 프로토콜을 점진적으로 복잡하게 만들었다: 단일 턴(single-turn) 도구 사용 주석으로 시작하여, 대화 내 도구 사용으로 이동하고, 최종적으로 다단계(multi-step) 도구 사용 및 데이터 분석에 대한 주석을 달았다.

도구 데이터셋 (Tool datasets)

도구 사용 애플리케이션을 위한 데이터를 생성하기 위해, 우리는 다음 절차를 활용한다:

- 단일 단계 도구 사용 (Single-step tool use): 우리는 먼저 합성 사용자 프롬프트의 few-shot 생성을 시작한다. 이 프롬프트는 구성상 우리의 핵심 도구 중 하나를 호출해야 한다 (예: 우리의 지식 cutoff 날짜를 초과하는 질문). 그런 다음, 여전히 few-shot 생성을 사용하여 이러한 프롬프트에 대한 적절한 도구 호출을 생성하고, 이를 실행하며, 출력을 모델의 context에 추가한다. 마지막으로, 도구 출력을 기반으로 사용자의 쿼리에 대한 최종 답변을 생성하도록 모델에 다시 프롬프트한다. 우리는 다음과 같은 형태의 궤적을 얻는다: 시스템 프롬프트, 사용자 프롬프트, 도구 호출, 도구 출력, 최종 답변. 또한 이 데이터셋의 약 30%를 필터링하여 실행할 수 없는 도구 호출이나 기타 형식 문제를 제거한다.

- 다단계 도구 사용 (Multi-step tool use): 우리는 유사한 프로토콜을 따르며, 먼저 모델에 기본적인 다단계 도구 사용 능력을 가르치기 위해 합성 데이터를 생성한다. 이를 위해, 우리는 먼저 Llama 3에 최소 두 번의 도구 호출을 필요로 하는 사용자 프롬프트를 생성하도록 프롬프트한다. 이 도구 호출은 우리의 핵심 세트에서 동일하거나 다른 도구일 수 있다. 그런 다음, 이러한 프롬프트를 조건으로 하여, Llama 3에 ReAct (Yao et al., 2022)와 유사하게 추론 단계와 도구 호출이 섞인(interleaved) 솔루션을 생성하도록 few-shot 프롬프트한다. Llama 3가 다단계 도구 사용을 포함하는 task를 수행하는 예시는 Figure 10을 참조하라.

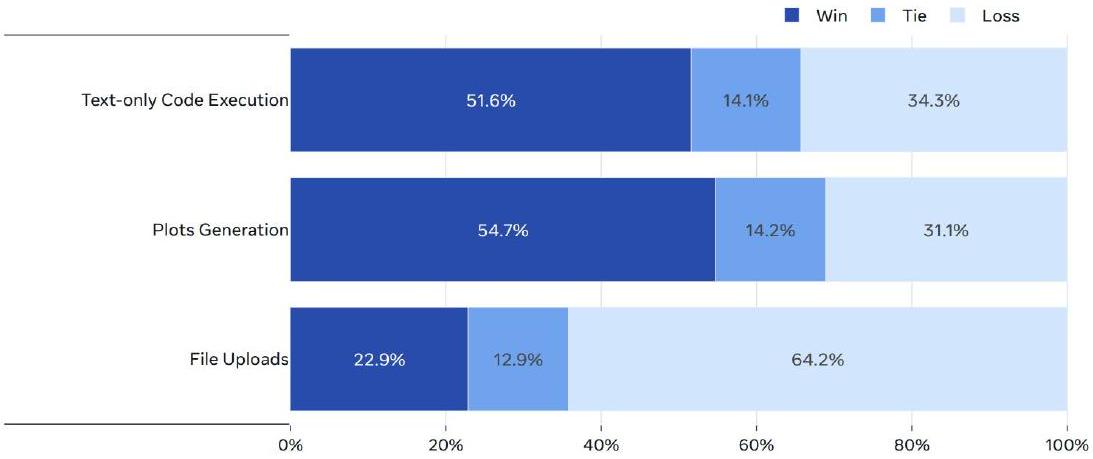

- 파일 업로드 (File uploads): 우리는 다음 파일 형식에 대해 주석을 달았다: .TXT, .DOCX, .PDF, .PPTX, .XLSX, .CSV, .TSV, .PY, .JSON, .JSONL, .HTML, .XML. 우리의 프롬프트는 제공된 파일을 기반으로 하며, 파일 내용 요약, 버그 찾기 및 수정, 코드 최적화, 데이터 분석 또는 시각화를 요청한다. Llama 3가 파일 업로드를 포함하는 task를 수행하는 예시는 Figure 11을 참조하라.

이 합성 데이터로 fine-tuning한 후, 우리는 다중 턴 상호작용, 3단계 이상의 도구 사용, 그리고 도구 호출이 결과를 산출하지 않는 경우를 포함한 다양하고 도전적인 시나리오에서 인간 주석을 수집한다.

Based on the inflation rate for the US in February 2024, and the cost of this list of tuples containing my daily groceries, [("eggsl",3),("chickenl",4),("ricel",2),("beansl",2.50),("applesl",6.25)], can you give me the estimated total cost of my groceries over a 30 day month when you add 1 cookie per day at Costco's food court giant cookie debut price and adjust the total for the inflation percentage in \ \mathrm{X} . \mathrm{XX}$ ?

Define the list of tuples containing the

일일 식료품 groceries = [("eggs",3),("chicken",4),

\# 결과 출력

print(f"코스트코 푸드코트의 대형 쿠키 출시 가격으로 매일 1개의 쿠키를 추가하고 인플레이션 비율을 조정한 30일간의 식료품 예상 총 비용은 \$\{total_cost_for_30_days_with_cookie_and_i

("rice", 2), ("beans", 2.50), ("apples", 6.25)]

\# 하루 식료품 총 비용 계산

day = sum([item[1] for item

in groceries])

\# 쿠키를 포함한 하루 식료품 총 비용 계산

total_cost_per_day_with_cookie =

total_cost_per_day + 2.49

\# 쿠키를 포함한 30일간의 식료품 총 비용 계산

total_cost_per_day_with_cookie * 30

total_cost_per_day_with_cookie * 30

\# 인플레이션율 정의

inflation_rate = 0.032

\# 쿠키를 포함하고 인플레이션을 조정한 30일간의 식료품 총 비용 계산

total_cost_for_30_days_w

lation =

total_cost_for_30_days_with_cookie * (1 +

inflation_rate)

(1) 도구 출력

코스트코 푸드코트의 대형 쿠키 출시 가격으로 매일 1개의 쿠키를 추가하고 인플레이션 비율을 조정한 30일간의 식료품 예상 총 비용은 $626.63이다.

코스트코 푸드코트의 대형 쿠키 출시 가격으로 매일 1개의 쿠키를 추가하고 인플레이션 비율을 조정한 30일간의 식료품 예상 총 비용은 **$626.63**이다.

Figure 10: 다단계 도구 사용. Llama 3가 task를 해결하기 위해 다단계 계획, 추론 및 도구 호출을 수행하는 예시.

만족스러운 답변을 제공한다. 우리는 모델이 도구가 활성화되었을 때만 도구를 사용하도록 가르치기 위해 다양한 시스템 프롬프트로 합성 데이터를 보강한다. 모델이 간단한 쿼리에 대해 도구 호출을 피하도록 훈련하기 위해, 우리는 쉬운 수학 또는 질문 답변 데이터셋(Berant et al., 2013; Koncel-Kedziorski et al., 2016; Joshi et al., 2017; Amini et al., 2019)의 쿼리와 도구 없이 생성된 응답을 추가하지만, 시스템 프롬프트에서 도구를 활성화한다.

**Zero-shot tool use 데이터.** 우리는 부분적으로 합성된(함수 정의, 사용자 쿼리, 해당 호출) 튜플의 크고 다양한 세트에 대해 fine-tuning함으로써 Llama 3의 **zero-shot tool use** 능력(함수 호출이라고도 함)을 향상시킨다. 우리는 보지 못한 도구 세트에 대해 모델을 평가한다.

* **단일, 중첩 및 병렬 함수 호출**: 호출은 단순하거나, 중첩될 수 있다. 즉, 함수 호출을 다른 함수의 인수로 전달하거나, 병렬로, 즉 모델이 독립적인 함수 호출 목록을 반환할 수 있다. 다양한 함수, 쿼리 및 ground truth를 생성하는 것은 어려울 수 있으며(Mekala et al., 2024), 우리는 실제 함수에 합성 사용자 쿼리를 grounding하기 위해 Stack(Kocetkov et al., 2022)을 마이닝하는 데 의존한다. 더 정확하게는, 함수 호출과 그 정의를 추출하고, 누락된 docstring 또는 실행 불가능한 함수에 대해 정리 및 필터링한 다음, Llama 3를 사용하여 함수 호출에 해당하는 자연어 쿼리를 생성한다.

* **다중 턴 함수 호출**: 우리는 Li et al.(2023b)에서 제안한 프로토콜과 유사한 프로토콜에 따라 함수 호출이 포함된 다중 턴 대화에 대한 합성 데이터도 생성한다. 우리는 도메인, API, 사용자 쿼리, API 호출 및 응답을 생성하는 여러 에이전트를 사용하며, 생성된 데이터가 다양한 도메인과 현실적인 API 세트를 포괄하도록 보장한다. 모든 에이전트는 역할에 따라 다른 방식으로 프롬프트된 Llama 3의 변형이며 단계별로 협력한다.

### 4.3.6 Factuality

**Hallucination**은 대규모 language model의 주요 도전 과제로 남아 있다. 모델은 지식이 거의 없는 영역에서도 **과도한 자신감**을 보이는 경향이 있다. 이러한 단점에도 불구하고, 모델은 종종 **지식 기반**으로 사용되며, 이는 **잘못된 정보의 확산**과 같은 위험한 결과를 초래할 수 있다. 우리는 **factuality**가 **hallucination**을 넘어설 수 있음을 인지하지만, 여기서는 **hallucination 중심의 접근 방식**을 취했다.

Figure 11: 파일 업로드 처리. Llama 3가 업로드된 파일을 분석하고 시각화하는 예시.

우리는 **post-training**이 지식을 추가하기보다는 **모델이 "자신이 아는 것을 알도록" 정렬해야 한다**는 원칙을 따른다 (Gekhman et al., 2024; Mielke et al., 2020). 우리의 주요 접근 방식은 **모델 생성을 사전학습 데이터에 존재하는 사실 데이터의 하위 집합과 정렬하는 데이터**를 생성하는 것이다. 이를 달성하기 위해 우리는 **Llama 3의 in-context 능력**을 활용하는 **지식 탐색(knowledge probing) 기술**을 개발한다. 이 데이터 생성 과정은 다음 절차를 포함한다:

1. 사전학습 데이터에서 **데이터 스니펫(snippet)**을 추출한다.

2. Llama 3에 **prompt를 주어 이 스니펫(context)에 대한 사실 질문**을 생성한다.

3. 질문에 대한 Llama 3의 **응답을 샘플링**한다.

4. **원래 context를 참조로, Llama 3를 심판으로 사용하여 생성된 응답의 정확성을 평가**한다.

5. Llama 3를 심판으로 사용하여 **생성된 응답의 정보성(informativeness)을 평가**한다.

6. Llama 3를 사용하여 **일관되게 정보성이 높지만 부정확한 응답에 대한 거부(refusal)를 생성**한다.

우리는 **지식 탐색을 통해 생성된 데이터**를 사용하여 모델이 **자신이 아는 질문에만 답하고, 확신하지 못하는 질문에 대해서는 답변을 거부하도록 유도**한다. 또한, 사전학습 데이터는 항상 사실적으로 일관되거나 정확하지는 않다. 따라서 우리는 **사실적으로 모순되거나 부정확한 진술이 만연한 민감한 주제를 다루는 제한된 양의 labeled factuality 데이터**도 수집한다.

### 4.3.7 Steerability

**Steerability**는 **모델의 행동과 결과물을 개발자 및 사용자의 요구사항에 맞게 지시할 수 있는 능력**을 의미한다. Llama 3는 범용적인 foundational model이므로, 다양한 다운스트림 use case에 쉽게 **최대한 steerable**해야 한다. Llama 3의 경우, 우리는 **자연어 지시를 포함하는 system prompt**를 통해 steerability를 강화하는 데 중점을 두었으며, 특히 **응답 길이, 형식, 어조, 그리고 캐릭터/페르소나**에 초점을 맞췄다.

**데이터 수집 (Data collection)**

우리는 Llama 3를 위한 다양한 system prompt를 설계하도록 어노테이터에게 요청하여 **일반 영어 카테고리 내에서 steerability 선호도 샘플을 수집**했다. 어노테이터는 모델과 대화를 나누면서, **대화 과정 전반에 걸쳐 system prompt에 정의된 지시를 모델이 얼마나 일관성 있게 따르는지 평가**했다. steerability 강화를 위해 사용된 맞춤형 system prompt 예시는 다음과 같다:

> 당신은 바쁜 가족을 위한 식단 계획 도우미 역할을 하는 친절하고 쾌활한 AI 챗봇입니다. 가족은 성인 2명, 십대 3명, 미취학 아동 2명으로 구성됩니다. 한 번에 2~3일치 식단을 계획하고, 둘째 날 계획에는 남은 음식이나 여분의 재료를 활용하세요. 사용자가 2일 또는 3일치를 원하는지 알려줄 것입니다. 만약 알려주지 않으면 3일치로 가정하세요. 각 계획에는 아침, 점심, 간식, 저녁이 포함되어야 합니다. 사용자에게 계획 승인 여부 또는 조정 필요 여부를 물어보세요. 승인하면 가족 규모를 고려한 장보기 목록을 제공하세요. 항상 가족의 선호도를 염두에 두고, 싫어하는 음식이 있다면 대체 음식을 제공하세요. 사용자가 영감을 받지 못한다면, 이번 주 휴가에 가장 가고 싶은 곳이 어디인지 물어본 다음, 그 지역 문화에 기반한 식사를 제안하세요. 주말 식사는 더 복잡할 수 있습니다. 주중 식사는 빠르고 쉬워야 합니다. 아침과 점심은 시리얼, 미리 조리된 베이컨을 곁들인 잉글리시 머핀 등 빠르고 쉬운 음식이 선호됩니다. 가족은 바쁩니다. 커피나 에너지 드링크와 같은 필수품이나 좋아하는 물품이 있는지 물어봐서 구매를 잊지 않도록 하세요. 특별한 날이 아니라면 항상 예산을 고려하세요.

**모델링 (Modeling)**

선호도 데이터를 수집한 후, 우리는 이 데이터를 **reward modeling, rejection sampling, SFT, DPO**에 활용하여 Llama 3의 steerability를 강화했다.

## 5 Results

우리는 Llama 3에 대한 광범위한 평가를 수행했으며, 다음 항목들의 성능을 조사했다:

(1) 사전학습된 language model,

(2) 사후학습된 language model,

(3) Llama 3의 안전 특성.

이러한 평가 결과는 아래의 별도 하위 섹션에서 제시한다.

### 5.1 Pre-trained Language Model

이 섹션에서는 **사전학습된 Llama 3 모델**(Section 3)의 평가 결과를 보고하며, **유사한 크기의 다양한 다른 모델들과 비교**한다. 우리는 가능한 경우 **경쟁 모델들의 결과를 재현**하였다. Llama 모델이 아닌 경우, **공개적으로 보고되었거나 (가능한 경우) 우리가 직접 재현한 결과 중 가장 좋은 점수**를 보고한다.

**평가에 사용된 shot 수, metric, 기타 관련 하이퍼파라미터 및 설정**과 같은 구체적인 내용은 **Github 저장소**에서 확인할 수 있다. 또한, **공개 벤치마크를 사용한 평가 과정에서 생성된 데이터**는 **Huggingface**에서 확인할 수 있다.

우리는 다음 기준에 따라 모델의 품질을 평가한다:

* **표준 벤치마크에서의 성능**(Section 5.1.1),

* **multiple-choice 질문 설정 변화에 대한 강건성**(Section 5.1.2),

* **적대적 평가**(Section 5.1.3).

또한, **학습 데이터 오염이 평가에 미치는 영향을 추정하기 위한 오염 분석**(Section 5.1.4)도 수행한다.

### 5.1.1 Standard Benchmarks

현재 state-of-the-art 모델들과 비교하기 위해, 우리는 **Table 8**에 제시된 **다수의 표준 벤치마크 평가에서 Llama 3를 평가**하였다. 이 평가들은 **8가지 최상위 범주**를 포함한다:

(1) 상식 추론 (commonsense reasoning);

(2) 지식 (knowledge);

(3) 독해 (reading comprehension);

(4) 수학, 추론 및 문제 해결 (math, reasoning, and problem solving);

(5) 긴 문맥 (long context);

(6) 코드 (code);

(7) 적대적 평가 (adversarial evaluations);

(8) 종합 평가 (aggregate evaluations).

| Reading Comprehension | SQuAD V2 (Rajpurkar et al., 2018), QuaC (Choi et al., 2018), RACE (Lai et al., 2017), |

| :--- | :--- |

| Code | HumanEval (Chen et al., 2021), MBPP (Austin et al., 2021), |

| Commonsense reasoning/understanding | CommonSenseQA (Talmor et al., 2019), PiQA (Bisk et al., 2020), SiQA (Sap et al., 2019), OpenBookQA (Mihaylov et al., 2018), WinoGrande (Sakaguchi et al., 2021) |

| Math, reasoning, and problem solving | GSM8K (Cobbe et al., 2021), MATH (Hendrycks et al., 2021b), ARC Challenge (Clark et al., 2018), DROP (Dua et al., 2019), WorldSense (Benchekroun et al., 2023) |

| Adversarial | Adv SQuAD (Jia and Liang, 2017), Dynabench SQuAD (Kiela et al., 2021), GSM-Plus (Li et al., 2024c) PAWS (Zhang et al., 2019) |

| Long context | QuALITY (Pang et al., 2022), many-shot GSM8K (An et al., 2023a) |

| Aggregate | MMLU (Hendrycks et al., 2021a), MMLU-Pro (Wang et al., 2024b), AGIEval (Zhong et al., 2023), BIG-Bench Hard (Suzgun et al., 2023) |

Table 8 범주별 사전학습 벤치마크. 사전학습된 Llama 3 모델을 평가하는 데 사용된 모든 벤치마크를 능력 범주별로 그룹화하여 보여준다.

**실험 설정 (Experimental setup)**

각 벤치마크에 대해 우리는 **Llama 3와 유사한 크기의 다른 사전학습 모델들의 점수를 계산**하였다. 가능한 경우, **다른 모델들의 수치도 우리의 파이프라인으로 재계산**하였다. 공정한 비교를 위해, 우리가 계산한 점수와 해당 모델에 대해 **유사하거나 더 보수적인 설정으로 보고된 수치 중 더 좋은 점수를 선택**하였다. 평가 설정에 대한 추가 세부 정보는 [여기](https://github.com/meta-llama/llama3/blob/main/llama/README.md)에서 확인할 수 있다. 일부 모델의 경우, 사전학습 모델이 공개되지 않았거나 API가 log-probability에 대한 접근을 제공하지 않아 벤치마크 값을 (재)계산하는 것이 불가능하다. 특히, 이는 **Llama 3 405B와 비교 가능한 모든 모델에 해당**한다. 따라서, 모든 벤치마크에 대한 모든 수치가 필요하기 때문에 **Llama 3 405B에 대한 범주별 평균은 보고하지 않는다.**

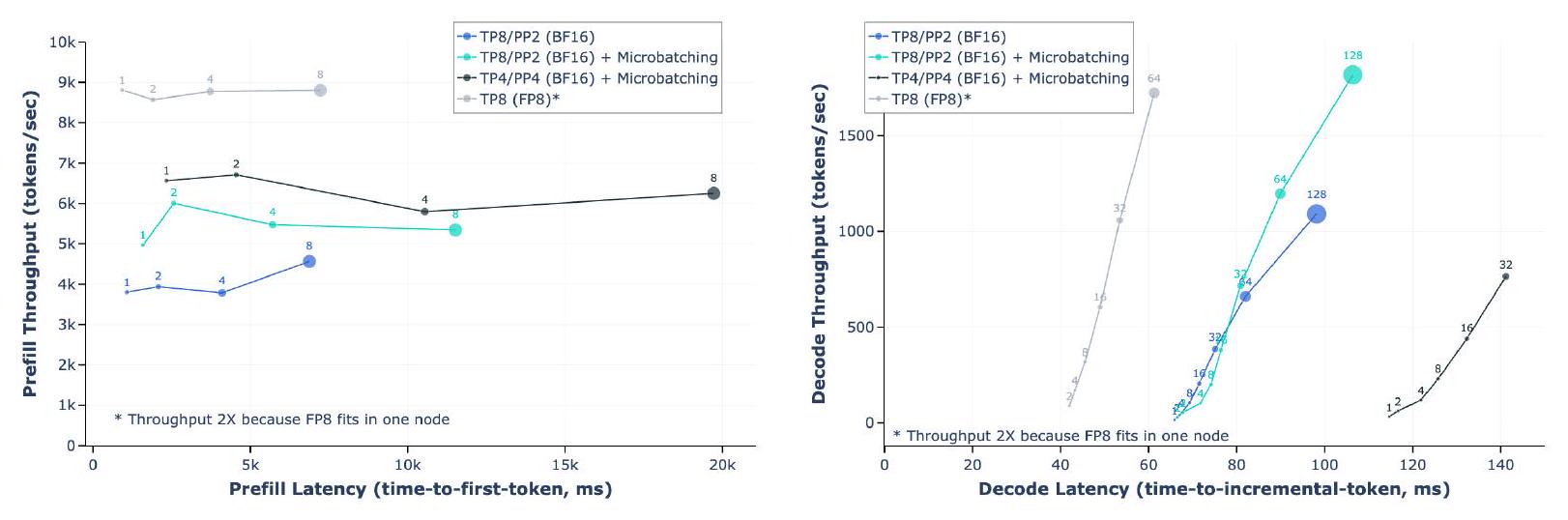

**유의성 추정 (Significance estimates)**