Galactica: 과학을 위한 대규모 언어 모델

Galactica는 과학 분야의 정보 과부하 문제를 해결하기 위해 설계된 대규모 언어 모델(Large Language Model)입니다. 논문, 참조 자료, 지식 베이스 등 고품질의 엄선된 과학 корпу스(corpus)로 학습되었으며, 이는 비선별적인 데이터에 의존하는 기존 모델들과 차별화됩니다. Galactica는 LaTeX 수식, 화학식(SMILES), 단백질 서열 등 다양한 과학적 양식을 처리하고, <work> 토큰을 활용한 단계별 추론(step-by-step reasoning)을 통해 복잡한 과학 문제 해결에 뛰어난 성능을 보입니다. 이 모델은 MMLU, MATH와 같은 수학 추론 벤치마크와 PubMedQA 등 과학 분야의 다운스트림 태스크에서 기존의 대형 모델들을 능가하는 결과를 보여주며, 과학 지식을 저장, 결합, 추론하는 새로운 인터페이스로서의 가능성을 제시합니다. 논문 제목: Galactica: A Large Language Model for Science

Taylor, Ross, et al. "Galactica: A large language model for science." arXiv preprint arXiv:2211.09085 (2022).

Galactica: A Large Language Model for Science

Abstract

**정보 과부하(information overload)**는 과학 발전의 주요 장애물이다. 과학 문헌과 데이터의 폭발적인 증가는 방대한 정보 속에서 유용한 통찰력을 발견하는 것을 더욱 어렵게 만들었다. 오늘날 과학 지식은 검색 엔진을 통해 접근되지만, 검색 엔진만으로는 과학 지식을 체계적으로 정리할 수 없다. 본 논문에서는 과학 지식을 저장, 결합, 추론할 수 있는 대규모 language model인 Galactica를 소개한다. 우리는 논문, 참고 자료, 지식 베이스 및 기타 여러 출처로 구성된 대규모 과학 코퍼스로 모델을 학습시켰다. Galactica는 다양한 과학 task에서 기존 모델들을 능가하는 성능을 보여준다.

LaTeX 방정식과 같은 **기술 지식 탐색(technical knowledge probes)**에서 Galactica는 최신 GPT-3를 **68.2% 대 49.0%**로 능가한다. Galactica는 추론 능력에서도 뛰어난 성능을 보여주는데, 수학 MMLU에서 Chinchilla를 **41.3% 대 35.7%**로, MATH에서 PaLM 540B를 **20.4% 대 8.8%**로 능가한다. 또한 PubMedQA와 MedMCQA dev와 같은 다운스트림 task에서 각각 **77.6%와 52.9%**라는 새로운 state-of-the-art를 달성한다. 그리고 일반 코퍼스로 학습되지 않았음에도 불구하고, Galactica는 BIG-bench에서 BLOOM과 OPT-175B를 능가한다. 우리는 이러한 결과가 language model이 과학을 위한 새로운 인터페이스로서 잠재력을 가지고 있음을 보여준다고 믿는다. 우리는 과학 커뮤니티의 이익을 위해 이 모델을 오픈 소스로 공개한다.

1 Introduction

컴퓨팅의 원래 약속은 과학 분야의 **정보 과부하(information overload)**를 해결하는 것이었다. Vannevar Bush는 1945년 에세이 "As We May Think"에서 "출판은 우리가 현재 기록을 실제로 활용할 수 있는 능력을 훨씬 넘어 확장되었다"고 언급했다 (Bush, 1945). 그는 증가하는 정보의 산을 관리하기 위한 해결책으로 컴퓨터를 제안했다. Licklider는 이를 **인간과 기계 간의 공생 관계(symbiotic relationship)**라는 비전으로 확장했다. 컴퓨터는 저장 및 검색과 같은 일상적인 작업을 처리하여 "과학적 사고에서 통찰력과 결정을 위한 길을 마련할 것"이라고 했다 (Licklider, 1960).

컴퓨팅은 실제로 연구 수행 방식을 혁신했지만, 정보 과부하는 여전히 압도적인 문제로 남아있다 (Bornmann and Mutz, 2014). 2022년 5월, arXiv에는 하루 평균 516편의 논문이 제출되었다 (arXiv, 2022). 논문 외에도 과학 데이터는 우리가 처리할 수 있는 능력보다 훨씬 빠르게 증가하고 있다 (Marx, 2013). 2022년 8월 현재, NCBI GenBank는 개의 뉴클레오타이드 염기(nucleotide bases)를 포함하고 있다 (GenBank, 2022). 이러한 정보의 양을 고려할 때, 한 사람이 특정 분야의 모든 논문을 읽는 것은 불가능하며, 기저의 과학적 현상에 대한 데이터를 정리하는 것 또한 어려운 일이다.

검색 엔진은 Licklider 패러다임에 따라 과학 지식에 접근하는 현재의 인터페이스이다. 그러나 검색 엔진은 지식을 직접적으로 정리하지 않고, 대신 Wikipedia, UniProt, PubChem Compound와 같이 문헌과 데이터를 정리하는 2차적인 계층(secondary layers)을 가리킨다. 이러한 자원들은 문헌 검토, 백과사전 기사 작성, 단백질 주석(annotating a protein)과 같은 비용이 많이 드는 인간의 기여를 필요로 한다. 이러한 병목 현상으로 인해, 연구자들은 강력한 검색 도구를 가지고 있음에도 불구하고 여전히 압도감을 느낀다.

본 논문에서 우리는 대형 language model을 통한 더 나은 방법을 주장한다. 검색 엔진과 달리, language model은 과학 지식을 저장하고, 결합하며, 추론할 수 있는 잠재력을 가지고 있다. 예를 들어, 문헌으로 학습된 모델은 서로 다른 연구 간의 숨겨진 연결을 찾아내고, 숨겨진 보석 같은 통찰력을 발견하여 이를 표면으로 끌어올릴 수 있다. 또한, 문헌 검토, 백과사전 기사, 강의 노트 등과 같은 2차 콘텐츠를 자동으로 생성하여 지식을 종합할 수 있다. 마지막으로, 논문과 코드, 단백질 서열과 화합물, 이론과 LaTeX 등 다양한 modality를 연결하여 정리할 수 있다. 우리의 궁극적인 비전은 **과학적 task를 구동하는 단일 신경망(single neural network)**이다. 우리는 이것이 인간이 과학 지식에 접근하는 다음 인터페이스가 될 것이라고 믿으며, 본 논문에서 그 시작을 알린다.

1.1 Our Contribution

우리는 과학 지식을 자동으로 정리하기 위한 새로운 대규모 언어 모델인 **Galactica (GAL)**를 소개한다. Galactica는 인류의 과학 지식으로 구성된 방대하고 엄선된 코퍼스로 학습되었다. 이 코퍼스에는 4,800만 개 이상의 논문, 교과서, 강의 노트, 수백만 개의 화합물 및 단백질, 과학 웹사이트, 백과사전 등이 포함된다. 무작위 크롤링 기반 패러다임에 의존하는 기존 언어 모델과 달리, 우리의 코퍼스는 고품질이며 매우 엄선된 데이터로 구성되어 있다. 우리는 과적합 없이 여러 epoch 동안 학습할 수 있었으며, 이 과정에서 반복되는 토큰의 사용에 따라 상류(upstream) 및 하류(downstream) 성능이 향상되었다.

데이터셋 설계는 우리의 접근 방식에 매우 중요하며, 여기에는 고품질 데이터셋 큐레이션과 지식 체계와 상호작용하는 인터페이스 설계가 포함된다. 모든 데이터는 공통 Markdown 형식으로 처리되어 다양한 소스 간의 지식을 통합한다. 또한, 새로운 task 맥락에서 이러한 지식의 구성을 용이하게 하기 위해 사전 학습에 task-specific 데이터셋을 포함한다. 인터페이스를 위해 우리는 다양한 유형의 지식을 지원하는 task-specific 토큰을 사용한다. 우리는 인용(citation)을 특별한 토큰으로 처리하여, 연구자가 어떤 입력 맥락에서도 인용을 예측할 수 있도록 한다. 단계별 추론(step-by-step reasoning)은 내부 작업 기억(internal working memory)을 모방하는 특별한 토큰으로 감싸 처리한다. 마지막으로, SMILES 및 단백질 시퀀스와 같은 양식(modality)은 특별한 토큰으로 감싸 연구자가 자연어를 사용하여 이들과 상호작용할 수 있도록 한다. 이러한 인터페이스와 모델 내의 과학 지식 체계를 통해 우리는 많은 과학 task에서 state-of-the-art 결과를 달성한다.

추론 task에서 Galactica는 MMLU 및 MATH (Hendrycks et al., 2020, 2021)와 같은 벤치마크에서 기존 언어 모델을 능가한다. 우리의 추론 토큰(reasoning token) 접근 방식을 통해, 우리는 수학적 MMLU에서 Chinchilla를 능가하며, 평균 점수 **41.3% 대 35.7%**를 기록했다 (Hoffmann et al., 2022). 우리의 120B 모델은 MATH에서 PaLM 540B의 8.8% 대비 20.4%의 점수를 달성했다 (Chowdhery et al., 2022; Lewkowycz et al., 2022). 30B 모델 또한 18배 적은 파라미터로 이 task에서 PaLM 540B를 능가한다. 우리는 이것이 최근 잘 탐구된 기존의 **chain-of-thought 접근 방식 (Wei et al., 2022; Suzgun et al., 2022)**과 함께 딥러닝 툴킷에 또 다른 추론 방법을 추가한다고 믿는다.

또한 Galactica가 지식 집약적인 과학 task에서 강력한 성능을 보인다는 것을 발견했다. 우리는 **Galactica의 방정식, 화학 반응 및 기타 과학 지식에 대한 상세한 지식 탐색(knowledge probes)**을 수행했다. Galactica는 이러한 task에서 최신 GPT-3와 같은 일반 언어 모델의 성능을 크게 초과한다. LaTeX 방정식에서는 최신 GPT-3의 49.0% 대비 68.2%의 점수를 달성했다 (Brown et al., 2020). Galactica는 하류(downstream) 과학 task에서도 우수한 성능을 보이며, PubMedQA (77.6%) 및 MedMCQA dev (52.9%)와 같은 여러 하류 task에서 새로운 state-of-the-art를 기록했다 (Jin et al., 2019; Pal et al., 2022).

우리는 또한 Galactica의 인터페이스를 통해 새로운 기능을 시연한다. 첫째, 인용 예측(citation prediction) 기능은 모델 규모가 커질수록 원활하게 향상되며, 모델이 인용의 기본 분포를 더 잘 모델링한다는 것을 발견했다. 즉, 경험적 분포 함수가 모델 규모에 따라 참조 분포에 가까워진다. 중요하게도, 이 접근 방식이 인용 예측을 위한 튜닝된 sparse 및 dense retrieval 접근 방식보다 우수하다는 것을 발견했다. 이는 다른 결과들과 함께, 언어 모델이 Licklider 패러다임, 즉 문서 저장 및 검색을, 가중치 메모리 내의 맥락-연관(context-associative) 능력으로 대체할 잠재력을 보여준다.

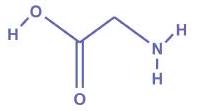

또한 Galactica는 SMILES 화학식 및 단백질 시퀀스를 포함하는 멀티모달 task를 수행할 수 있다. 우리는 신약 발견 task를 텍스트 prompt로 공식화하고 약한 지도 학습(weakly supervised) 설정에서 성능이 확장됨을 보여준다. 또한 Galactica가 IUPAC 이름 예측과 같은 task를 self-supervised 방식으로 학습하며, 기능 그룹(functional groups)과 같은 해석 가능한 속성에 주의를 기울여 학습한다는 것을 시연한다. 마지막으로, Galactica는 기능 키워드 예측을 포함하여 단백질 시퀀스에 자연어로 주석을 달 수 있다.

Galactica는 누락된 인용, 서론 및 관련 연구에서 논의할 주제, 추가 연구 제안, 초록 및 결론 작성 지원 등 이 논문을 작성하는 데 도움을 주었다.

2 Related Work

Large Language Models (LLMs)

LLM은 최근 몇 년간 NLP task에서 획기적인 성능을 달성했다. 이 모델들은 대규모의 일반 코퍼스에서 self-supervision 방식으로 학습되며, 수백 가지 task에서 뛰어난 성능을 보인다 (Brown et al., 2020; Rae et al., 2021; Hoffmann et al., 2022; Black et al., 2022; Zhang et al., 2022; Chowdhery et al., 2022). 여기에는 MMLU와 같은 과학 지식 task도 포함된다 (Hendrycks et al., 2020). LLM은 few-shot learning을 통해 in-context로 학습할 수 있는 능력을 가지고 있다 (Brown et al., 2020). 이러한 능력은 모델의 규모가 커질수록 증가하며, 최근 연구에서는 적절한 prompting 전략을 통해 더 큰 규모에서 추론 능력이 향상됨을 강조했다 (Wei et al., 2022; Chowdhery et al., 2022; Kojima et al., 2022; Lewkowycz et al., 2022).

self-supervision의 한 가지 단점은 uncurated 데이터로의 전환이었다. 모델은 코퍼스에 포함된 잘못된 정보, 고정관념, 편향을 그대로 반영할 수 있다 (Sheng et al., 2019; Kurita et al., 2019; Dev et al., 2019; Blodgett et al., 2020; Sheng et al., 2021). 이는 진실을 중시하는 과학 task에는 바람직하지 않다. 또한, uncurated 데이터는 대상 use-case에 대한 전이 가치(transfer value)가 제한적인 token이 많아 연산 예산을 낭비할 수 있다. 예를 들어, PaLM 코퍼스의 50%는 소셜 미디어 대화로 구성되어 있어, 과학 task에 대한 전이 가치가 제한적일 수 있다 (Chowdhery et0 al., 2022). 과학 텍스트의 특성(예: 과학 용어 및 수학) 또한 일반 텍스트와 다르므로, 일반 코퍼스와 tokenizer는 비효율적일 수 있다. 본 연구에서는 데이터셋 선택에 대한 규범적 접근 방식이 대규모 모델 패러다임과 함께 작동할 수 있는지를 탐구한다.

Scientific Language Models

SciBERT, BioLM 등과 같은 연구들은 큐레이션된 과학 코퍼스의 이점을 보여주었다 (Beltagy et al., 2019; Lewis et al., 2020a; Gu et al., 2020; Lo et al., 2019b; Gu et al., 2020; Shin et al., 2020; Hong et al., 2022). 이러한 데이터셋과 모델은 일반적으로 규모와 범위가 작았으며, 일반 모델을 위한 코퍼스보다 훨씬 작았다. 과학 텍스트 외에도, 단백질 서열 및 SMILES를 위한 Transformer는 자연스러운 표현을 학습할 잠재력을 보여주었다 (Rives et al., 2021; Honda et al., 2019; Irwin et al., 2021; Nijkamp et al., 2022; Lin et al., 2022b). 그러나 SMILES와 같은 서열은 화학 구조를 표현하는 데 기술적인 한계가 있다. 본 연구에서는 대규모 멀티모달 과학 코퍼스가 표현 학습에 도움이 될 수 있는지를 탐구한다. 이 코퍼스에서는 서열이 footprint 및 텍스트와 함께 신호 밀도가 높은(signal-dense) 맥락에서 발생한다.

Scaling Laws

"scaling laws" 개념은 Kaplan et al. (2020)에 의해 제시되었으며, 이들은 손실(loss)이 모델 크기, 데이터셋 크기, 학습 연산량에 따라 power-law 형태로 확장된다는 증거를 제시했다. 이 연구는 주로 upstream perplexity에 초점을 맞추었으며, Tay et al. (2022a)의 연구는 이것이 항상 downstream 성능과 상관관계가 있는 것은 아님을 보여주었다. Hoffmann et al. (2022)은 최적의 데이터 양을 고려한 새로운 분석을 제시하며, 기존 언어 모델이 **충분히 학습되지 않았다("Chinchilla scaling laws")**고 제안했다. 이 연구는 새로운 token과 반복된 token의 차이를 고려하지 않았다. 본 연구에서는 반복된 token으로 학습함으로써 upstream 및 downstream 성능을 향상시킬 수 있음을 보여준다.

Language Models as Knowledge Bases

가중치에 정보를 저장하는 것은 모델이 정보를 혼합하거나 환각을 일으킬 수 있다는 점에서 신뢰성이 떨어지지만, 표현 공간을 통해 정보를 연관시킬 수 있다는 점에서 더 "유연"하다. 환각 위험에도 불구하고, 대규모 언어 모델이 충분한 용량을 가질 경우 암묵적인 지식 베이스 역할을 할 수 있다는 증거가 있다 (Petroni et al., 2019). 이들은 외부 검색 메커니즘 없이도 일반 지식(TriviaQA) 및 전문 지식(MMLU)과 같은 지식 집약적 task에서 뛰어난 성능을 보인다 (Brown et al., 2020; Hendrycks et al., 2020).

네트워크 지식을 업데이트하는 방법에 대한 질문은 여전히 활발한 연구 주제이다 (Scialom et al., 2022; Mitchell et al., 2022). 마찬가지로, 생성(generation)의 신뢰성을 향상시키는 방법에 대한 질문도 활발히 연구되고 있다 (Gao et al., 2022). 이러한 한계에도 불구하고, 오늘날의 대규모 모델은 경험을 통해 더 저렴해질 것이며 (Hirschmann, 1964), 따라서 학습 및 재학습 비용이 감소함에 따라 과학 지식의 점점 더 많은 부분이 가중치 메모리에 저장될 것이다. 본 연구에서는 Galactica의 지식 깊이를 조사하기 위한 probe를 수행하고, 과학 지식을 흡수하는 능력이 규모에 따라 원활하게 향상됨을 보여준다.

Retrieval-Augmented Models

Retrieval-augmented model은 가중치 메모리의 단점을 완화하는 것을 목표로 한다. 이러한 모델의 예로는 RAG, RETRO, Atlas가 있다 (Lewis et al., 2020b; Borgeaud et al., 2021; Izacard et al., 2022). 이 모델들은 더 적은 용량을 요구한다는 장점이 있지만, 지원 검색 인프라가 필요하다는 단점이 있다. 지식은 종종 특정 단백질의 서열이나 특정 외계 행성의 특성과 같이 세분화되어 있기 때문에, 미래에는 더 큰 모델에서도 검색이 필요할 가능성이 높다. 본 연구에서는 모델 가중치만으로 얼마나 멀리 갈 수 있는지에 초점을 맞추지만, 이 주제에 대한 향후 연구를 위해 검색 증강(retrieval augmentation)을 사용하는 강력한 사례를 언급한다.

| Modality | Entity | Sequence | |

|---|---|---|---|

| Text | Abell 370 | Abell 370 is a cluster... |  |

| ETEX | Schwarzschild radius | r_{s} = \frac{2GM}{c^2} | |

| Code | Transformer | class Transformer(nn.Module) |  |

| SMILES | Glycine |  | |

| AA Sequence | Collagen (II) chain | MIRLGAPQTL.. |  |

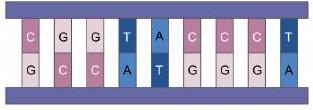

| DNA Sequence | Human genome | CGGTACCCTC.. |  |

Table 1: Tokenizing Nature. Galactica는 과학 현상을 나타내는 텍스트 시퀀스로 학습된다.

| Total dataset size = 106 billion tokens | |||

|---|---|---|---|

| Data source | Documents | Tokens | Token % |

| Papers | 48 million | 88 billion | 83.0% |

| Code | 2 million | 7 billion | 6.9% |

| Reference Material | 8 million | 7 billion | 6.5% |

| Knowledge Bases | 2 million | 2 billion | 2.0% |

| Filtered CommonCrawl | 0.9 million | 1 billion | 1.0% |

| Prompts | 1.3 million | 0.4 billion | 0.3% |

| Other | 0.02 million | 0.2 billion | 0.2% |

Table 2: Galactica Corpus. 이 소스들에 대한 전체 분석은 Appendix에 포함되어 있다.

3 Dataset

"자연은 우리 눈앞에 항상 펼쳐져 있는 위대한 책, 즉 우주에 쓰여 있지만, 우리가 먼저 그 언어를 배우고 그것이 쓰여진 상징들을 이해하지 못한다면 우리는 그것을 이해할 수 없다."

갈릴레오 갈릴레이, 『시금사(The Assayer)』

자연이 근본적인 언어를 통해 이해될 수 있다는 생각은 오랜 역사를 가지고 있다 (Galilei, 1623; Wigner, 1959; Wheeler, 1990). 최근 몇 년 동안, 딥러닝은 단백질과 분자와 같은 자연을 표현하는 데 사용되어 왔다 (Jumper et al., 2021; Ross et al., 2021). 아미노산은 단백질 구조의 언어가 쓰여지는 알파벳이며, 원자와 결합은 분자의 언어이다. 더 높은 수준에서는 자연어를 통해 지식을 조직화하며, 많은 연구들이 과학 텍스트를 학습에 활용해왔다 (Beltagy et al., 2019; Lewis et al., 2020a; Gu et al., 2020; Lo et al., 2019b). 우리는 Galactica를 통해 대규모 과학 코퍼스로 단일 신경망을 학습시켜 과학의 다양한 언어를 학습한다.

우리의 코퍼스는 논문, 참고 자료, 백과사전 및 기타 과학 출처에서 얻은 1,060억 개의 토큰으로 구성된다. 우리는 논문 및 교과서와 같은 자연어 출처와 단백질 서열 및 화학식과 같은 자연 서열을 결합한다. 우리는 캡처할 수 있는 경우 를 처리하며, 계산 과학을 포착하기 위해 학술 코드도 포함한다. 코퍼스 세부 정보는 Table 1과 2에 강조되어 있다. 데이터셋 구성 요소 및 필터링 로직을 포함한 전체 세부 정보는 Appendix에 포함되어 있다.

[START_AMINO] MIRLGAPQTLVLLTLLVAAVLRCQGQDVQEAGSCVQDGQRYNDKDVWKPEPCRICVCDTG . . . [END_AMINO]

Summary

단백질 (Protein): Collagen alpha-1(II) chain 유전자 (Gene): COL2A1 생물종 (Organism): Homo sapiens (Human) 상태 (Status): protein level에서 증거 확인

Function

Type II collagen은 연골 조직에 특이적이다. 이는 정상적인 배아 골격 발달, 선형 성장, 그리고 연골이 압축력에 저항하는 능력에 필수적이다. [START_REF] Nucleotide sequence of the full length cDNA encoding for human type II procollage, Lee [END_REF]...

Features

- Domain, 32-90, Cleavage; by procollagen N-endopeptidase

- Site Cleavage, 181-182, Cleavage; by procollagen N-endopeptidase

- Binding site, 1301, Ca2+ ...

Figure 1: Multi-Modal Data. 단백질 서열은 UniProt의 주석, 텍스트, 인용문과 함께 문서 컨텍스트에 나타난다. 설명의 명확성을 위해 문서의 전체 내용은 잘라냈다.

주목할 점은 이 데이터셋이 다른 LLM 코퍼스(더 크고 정제되지 않은)에 비해 작고 큐레이션되었다는 것이다. 이것이 본 연구의 핵심 질문이다: 큐레이션되고 규범적인 패러다임에 기반한 작동하는 LLM을 만들 수 있을까? 만약 그렇다면, 규범적 표준을 가졌던 전문가 시스템(Jackson, 1990)처럼, 코퍼스에 무엇이 포함되는지에 대한 명확한 이해를 통해 더 목적 지향적인 LLM을 만들 수 있을 것이다.

3.1 Tokenization

주어진 다양한 modality를 고려할 때, 토큰화(tokenization)는 데이터셋 설계의 중요한 부분이다. 예를 들어, 단백질 서열은 아미노산 잔기로 표현되며, 이 경우 문자 기반 토큰화(character-based tokenization)가 적절하다. 특수 토큰화라는 목표를 달성하기 위해, 우리는 다양한 modality에 대해 특수 토큰을 활용한다:

- 인용(Citations): 인용은 특수 참조 토큰인 **[START_REF]**와 **[END_REF]**로 감싼다.

- 단계별 추론(Step-by-Step Reasoning): 단계별 추론은 내부 작업 기억(working memory) 컨텍스트를 모방하는 <work> 토큰으로 감싼다.

- 수학(Mathematics): LaTeX 유무와 관계없이 수학적 내용에 대해 ASCII 연산자를 개별 문자로 분리한다. 괄호는 숫자처럼 취급된다. 나머지 연산자는 분리되지 않은 반복을 허용한다. 연산자 문자는 ! "#$%&'*+,-./:;<=>?-_'| 이고 괄호는 () []{}이다.

- 숫자(Numbers): 숫자는 개별 토큰으로 분리한다. 예를 들어, 와 같이 처리한다.

- SMILES 공식: 서열은 **[START_SMILES]**와 **[END_SMILES]**로 감싸고 문자 기반 토큰화를 적용한다. 유사하게, 이성질체(isomeric) SMILES가 표시된 경우에는 **[START_I_SMILES]**와 **[END_I_SMILES]**를 사용한다. 예를 들어, ,N 와 같이 처리한다.

- 아미노산 서열(Amino acid sequences): 서열은 **[START_AMINO]**와 **[END_AMINO]**로 감싸고 문자 기반 토큰화를 적용하며, 각 아미노산 문자를 단일 토큰으로 취급한다. 예를 들어, MIRLGAPQTL-> M, I,R,L,G,A,P,Q,T,L 와 같이 처리한다.

- DNA 서열: 마찬가지로 문자 기반 토큰화를 적용하며, 각 뉴클레오타이드 염기를 토큰으로 취급하고, 시작 토큰은 **[START_DNA]**와 **[END_DNA]**이다. 예를 들어, CGGTACCCTC -> C, G, G, T, A, C, C, C, T, C 와 같이 처리한다.

아래에서는 문헌에서 명확한 유사점을 찾기 어려운 몇 가지 특수 토큰화 접근 방식, 특히 작업 기억(working memory) 토큰과 인용(citation) 토큰에 대해 다룬다.

Figure 2: "의 평균은 얼마인가?"와 같은 task가 주어졌을 때, 사람은 **내부 또는 외부 작업 기억(working memory)**을 사용할 수 있다. 실제로는 이 둘을 상호 보완적으로 사용한다. 즉, 텍스트로 기록된 작업 과정에는 내부적으로 수행된 일부 단계가 "누락"되어 있는 경우가 일반적이다.

Figure 2: "의 평균은 얼마인가?"와 같은 task가 주어졌을 때, 사람은 **내부 또는 외부 작업 기억(working memory)**을 사용할 수 있다. 실제로는 이 둘을 상호 보완적으로 사용한다. 즉, 텍스트로 기록된 작업 과정에는 내부적으로 수행된 일부 단계가 "누락"되어 있는 경우가 일반적이다.

3.1.1 Working Memory Token, <work>

Transformer 기반 아키텍처는 명시적인 작업 기억(working memory) 능력이 부족하여, 단일 forward pass의 효율성이 제한적이다. 이는 여러 단계의 계산을 요구하는 task에서 문제가 된다. 현재의 해결책은 Transformer의 출력 context를 외부 작업 기억으로 활용하여 읽고 쓰는 방식이다. 이는 최근 chain-of-thought prompting 연구에서 볼 수 있다 (Wei et al., 2022; Suzgun et al., 2022).

어떤 면에서는 이것이 직관적이다. 인간도 제한된 작업 기억을 보충하기 위해 scratchpad를 사용하기 때문이다. 다른 한편으로는, 우리는 모델이 인간처럼 내부적으로 표현을 정제하기를 원한다. 예를 들어, **암산(mental arithmetic)**과 같은 경우이다.

chain-of-thought에는 두 가지 한계가 있다.

첫째, 견고한 단계별 추론을 유도하는 prompt를 찾기 위해 prompt discovery에 의존한다는 점이다. 즉, 단일 forward pass에서 너무 많은 작업을 수행하여 발생하는 오류를 최소화해야 한다. 이는 모든 경우에 작동하는 견고한 prompt를 찾아야 할 뿐만 아니라, context 공간을 차지하는 few-shot 예시에 의존하는 경우가 많다. 더 나쁜 것은, 인터넷상의 많은 단계별 추론 과정이 인간이 내부 기억을 사용하여 수행한 중간 단계를 생략한다는 점이다. 인간은 모든 단계를 기록하지 않는다. 그렇게 하면 길고 지루한 답변이 되기 때문이다. 그들은 주요 추론 단계만 기록하고, 낮은 수준의 단계는 내부 작업 기억을 통해 수행한다. 이는 작성된 텍스트에 **"누락된 데이터"**가 있다는 것을 의미한다. 즉, 작성된 단계들 사이에 명시적으로 언급되지 않은 내부 기억 단계가 존재한다.

둘째, chain-of-thought prompting은 신경망이 논쟁의 여지가 있는, 가장 적합하지 않은 task를 수행하도록 사용한다. 예를 들어, 산술 연산이 그렇다. 이전 연구에서는 곱셈과 같은 task의 정확도가 용어 빈도(term frequency)에 비례한다는 것을 보여주었다 (Razeghi et al., 2022). 고전적인 컴퓨터가 산술 연산과 같은 task에 특화되어 있다는 점을 고려할 때, 한 가지 전략은 이러한 task를 신경망에서 외부 모듈로 offload하는 것이다. 예를 들어, 이전 연구에서는 계산기와 같은 외부 도구 증강의 가능성을 살펴보았다 (Thoppilan et al., 2022). 그러나 이는 신경망이 언제 offload해야 하는지를 식별하는 전략이 필요하며, 특히 낮은 수준의 계산 단계가 명시적으로 기록되지 않은 경우, 발견된 zero-shot prompt와 결합될 때 간단하지 않을 수 있다.

우리의 해결책은 <work>라는 작업 기억 토큰이다. 우리는 <work> </work> 내부에 단계별 추론을 포함하는 몇 가지 prompt 데이터셋을 구축했다 (Table 3 참조). 이 데이터셋 중 일부는 문제 템플릿을 만들고 변수를 샘플링하여 프로그래밍 방식으로 생성되었고(OneSmallStep), 다른 일부는 온라인에서 수집되었으며(Workout, Khan Problems), 또 다른 일부는 기존 데이터셋을 <work> 기반 context로 변환하여 사용했다(GSM8k train). 인간이 내부적으로 수행할 수 없는 계산이 필요한 경우, 우리는 Python 스크립트를 작성하고 실행하여 offload한다. 예시는 Figure 3에 나와 있다. 중요한 점은, 이 기능을 켜지 않아도 모델이 프로그램을 실행한 결과를 예측할 수 있다는 것이다. 우리의 실험에서는 Python offloading을 켤 필요성을 느끼지 못했으며, 이 부분은 향후 연구로 남겨둔다.

Question: A needle 35 mm long rests on a water surface at 20 C . What force over and above the needle's weight

is required to lift the needle from contact with the water surface? \sigma = 0.0728m.

<work>

\sigma = 0.0728 N/m

\sigma = F/L

0.0728 = F/(2 x 0.035)

F=0.0728(2 x 0.035)

calculate.py

"6"

f = 0.0728*(2*0.035)

with open("output.txt", "w") as file:

file.write(str(round(f, 5)))

"(6

<<run: "calculate.py">

«read: "output.txt">

0.0051

</work>

Answer: F = 0.0051 N

Figure 3: Model-Machine Symbiosis.

<work> 작업 기억 토큰을 사용한 답변 예시를 보여준다. 이 모델은 방정식을 재배열하는 정확한 단계를 수행하며, 단일 forward-pass로 안정적으로 해결할 수 없는 계산에 도달하면 프로그램(Python 스크립트)을 작성한다. 이 프로그램은 고전적인 컴퓨터로 offload될 수 있다.

| Data source | Split | Prompts | Tokens |

|---|---|---|---|

| GSM8k (Cobbe et al., 2021) | train | 7,473 | |

| OneSmallStep | 9,314 | ||

| Khan Problems (Hendrycks et al., 2021) | 3,835 | ||

| Workout | 921 | 470,921 | |

| Total | 21,543 | 9 million |

Table 3: 추론 데이터셋.

모델이 <work> 토큰을 사용하도록 학습시키기 위해, 사전학습에 이 토큰을 포함하는 여러 데이터셋을 포함한다. 자세한 내용은 Appendix에 수록되어 있다.

장기적으로는 **적응형 계산(adaptive computation)**을 지원하기 위해 아키텍처 변경이 필요할 수 있으며, 이를 통해 기계는 adaptive computation time 및 PonderNet과 같은 연구 [Graves, 2016; Banino et al., 2021]의 방향으로 내부 작업 기억을 가질 수 있을 것이다. 본 논문에서는 <work> 외부 작업 기억 접근 방식을 다음 단계로 나아가기 위한 다리 역할로 탐구한다. 특히, 우리의 <work> prompt 데이터셋은 규모가 크거나 다양하지 않으므로, 이 접근 방식을 통해 더 큰 성능 향상을 이룰 가능성이 높다.

3.1.2 Citation Token

학술 텍스트의 독특한 특징 중 하나는 **인용(citation)**이다. 텍스트 내의 암묵적인 인용 그래프를 표현하기 위해, 우리는 인용이 이루어지는 시점을 나타내는 전역 식별자(global identifier)와 특수 토큰 [START_REF] 및 [END_REF]를 사용하여 인용을 처리한다. Figure 4는 논문에서 인용이 처리된 텍스트의 예시를 보여준다.

Recurrent neural networks, long short-term memory [START_REF]Long Short-Term Memory, Hochreiter [END_REF] and gated recurrent [START_REF]Empirical Evaluation of Gated Recurrent Neural Networks on Sequence Modeling, Chung [END_REF] neural networks in particular, have been firmly established as state of the art approaches in sequence modeling and transduction problems such as language modeling and machine translation [START_REF]Sequence to Sequence Learning with Neural Networks, Sutskever [END_REF] [START_REF]Neural Machine Translation by Jointly Learning to Align and Translate, Bahdanau [END_REF] [START_REF] Learning Phrase Representations Using RNN Encoder-Decoder for Statistical Machine Translation, Cho [END_REF].

Figure 4: 인용 처리된 텍스트. Attention Is All You Need (Vaswani et al., 2017) 논문에서 인용이 처리된 텍스트의 예시. 제목 기반으로 처리된 인용의 경우, 해당 제목은 이전 문맥과 연결될 수 있다.

우리는 두 가지 유형의 인용 식별자를 고려했다: (a) 논문 제목(paper titles) (b) 영숫자 ID(alphanumeric IDs)

ablation 연구를 통해, 제목 기반 식별자가 ID보다 더 높은 인용 예측 정확도를 보인다는 것을 발견했다. 그러나 우리는 또한 논문 제목이 식별자의 텍스트 기반 특성 때문에 낮은 규모에서는 환각(hallucination) 오류에 더 취약하다는 것을 발견했다. 본 논문에서는 제목 처리 방식을 고려하지만, 두 접근 방식 간의 trade-off가 있음을 언급한다. 이러한 ablation 실험은 Appendix에 포함되어 있다.

3.2 Prompt Pre-Training

우리는 기존 language model 연구와 한 가지 중요한 방향에서 차이를 보인다. 그것은 일반 코퍼스와 함께 pre-training에 prompt를 포함하기로 결정한 것이다. 이는 여러 관찰에 의해 동기 부여되었다.

첫째, 기존 연구들은 학습 토큰 수(training token count)가 성능에 미치는 중요성을 보여주었다. Chinchilla 논문은 토큰 수를 고려한 스케일링 "법칙"을 도출했으며, 700억 개의 파라미터를 가진 모델을 1.4조 개의 토큰으로 학습시켰다 (Hoffmann et al., 2022). 그들은 MMLU에서 state-of-the-art 성능을 달성했으며, Gopher와 같은 훨씬 큰 모델들을 능가했다 (Rae et al., 2021).

별개로, FLAN 및 T0와 같은 연구들은 prompt tuning이 다운스트림 성능을 향상시킬 수 있음을 보여주었다 (Wei et al., 2021; Sanh et al., 2021; Chung et al., 2022). 그들의 전략은 task를 텍스트 prompt로 변환하고, task가 제시되는 방식에 있어 prompt 다양성을 활용한 다음, 이 prompt 데이터셋으로 fine-tuning하는 것을 포함했다. FLAN과 T0의 경우, 이 접근 방식은 성능을 향상시켜 많은 task에서 GPT-3와 같은 더 큰 모델들을 능가했다.

또한 UnifiedQA 접근 방식도 있다 (Khashabi et al., 2020). 이 접근 방식에서는 T5 모델이 question answering 데이터셋으로 fine-tuning되며, out-of-domain question answering 데이터셋에서 성능을 향상시키는 것으로 나타났다 (Raffel et al., 2020). 이 모델은 16배 더 큰 모델인 GPT-3를 MMLU에서 능가한다.

위의 첫 번째 연구 흐름은 전체 학습 토큰 수를 성능 향상 방법으로 강조한다. 즉, 토큰에 구애받지 않는(token agnostic) 방식이다. 두 번째 연구 흐름은 task-context 토큰을 성능 향상 방법으로 강조한다. 즉, 토큰을 선택적으로(token selective) 활용하는 방식이다. fine-tuning된 작은 모델들이 MMLU와 같은 task에서 더 큰 few-shot 모델들을 능가한다는 점은, 세계 지식(world knowledge)은 작은 모델에도 존재할 수 있지만, 일반 코퍼스에서 본 task-context 토큰의 상대적인 수가 적기 때문에 task-context 지식은 부족할 수 있음을 시사한다.

본 논문에서는 더 낮은 규모에서 성능을 향상시키기 위해 pre-training 데이터에 더 많은 task prompt를 추가하기로 결정했다. 이는 더 많은 데이터 규모(예: 1조 개 이상의 코퍼스)나 더 큰 모델 규모의 필요성을 없앨 수 있다면 유리하다. 우리가 학습하는 가장 큰 120B 모델은 단일 NVIDIA A100 노드에서 실행된다. 또한, fine-tuning은 전문 지식을 요구하므로, question answering 및 summarization과 같은 인기 있는 task에 대해 모델이 별도의 설정 없이(out-the-box) 작동하도록 만드는 것이 모델 사용자에게 더 유용하다. 마지막으로, 일반 데이터와 함께 prompt를 포함함으로써, 우리는 모델의 일반성을 극대화하면서도 관심 있는 일부 task의 성능을 향상시킨다.

대규모 language model에 대한 이 접근 방식의 가장 가까운 유사체는 ExT5이다 (Aribandi et al., 2021). 우리는 많은 머신러닝 학습 데이터셋을 가져와 텍스트 형식으로 변환하고, prompt 다양성을 부여한 다음, pre-training 세트의 일반 코퍼스와 함께 포함하는 유사한 접근 방식을 취한다. prompt 유형 요약은 Table 4에 제시되어 있으며, 사용된 데이터셋 및 prompt에 대한 전체 세부 정보는 Appendix에 설명되어 있다.

Figure 5: Prompt Pre-training. Pre-training은 self-supervised loss의 일부로 모든 토큰에 동일한 가중치를 부여한다. 이는 관심 task에 대한 상대적으로 약한 신호로 이어지며, 모델 규모가 커야만 작동함을 의미한다. Instruction tuning은 사후적으로 성능을 향상시키고, 보지 못한 관심 task로 일반화할 수 있지만, instruction set task와 거리가 먼 task에서는 성능 저하의 위험이 있다. Prompt pre-training은 instruction tuning보다 관심 task에 대한 편향이 약하지만, 전반적인 task 일반성 저하 위험은 적다.

Figure 5: Prompt Pre-training. Pre-training은 self-supervised loss의 일부로 모든 토큰에 동일한 가중치를 부여한다. 이는 관심 task에 대한 상대적으로 약한 신호로 이어지며, 모델 규모가 커야만 작동함을 의미한다. Instruction tuning은 사후적으로 성능을 향상시키고, 보지 못한 관심 task로 일반화할 수 있지만, instruction set task와 거리가 먼 task에서는 성능 저하의 위험이 있다. Prompt pre-training은 instruction tuning보다 관심 task에 대한 편향이 약하지만, 전반적인 task 일반성 저하 위험은 적다.

| Task | Prompts | Tokens |

|---|---|---|

| Chemical Properties | 782,599 | 275 million |

| Multiple-Choice QA | 256,886 | 31 million |

| Extractive QA | 30,935 | 13 million |

| Summarization | 6,339 | 11 million |

| Entity Extraction | 156,007 | 9 million |

| Reasoning | 21,543 | 9 million |

| Dialog | 18,930 | 5 million |

| Binary QA | 36,334 | 4 million |

| Other | 3,559 | 1 million |

| Total | 783,599 | 358 million |

Table 4: Pre-training Prompts. task 신호를 강화하기 위해 pre-training에 zero-shot prompt를 포함한다.

prompt 포함으로 인해, 학습 데이터셋이 pre-training에 포함된 in-domain 성능과, 학습 데이터셋이 pre-training에 포함되지 않은 out-of-domain 성능을 구별하는 것이 중요하다. 우리는 이 논문의 Results 섹션에서 이러한 결과들을 명확하게 표시한다. 중요하게도, 우리는 prompt pre-training을 instruction tuning의 대안으로 주장하지 않는다. 사실, Galactica에 대한 instruction tuning은 여러 관심 task에서 성능을 향상시킬 잠재력이 있으므로 유용한 후속 연구가 될 가능성이 높다.

4 Method

4.1 Architecture

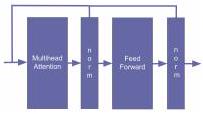

Galactica는 decoder-only 설정의 Transformer 아키텍처를 사용하며 (Vaswani et al., 2017), 다음과 같은 수정 사항이 적용되었다:

- GeLU Activation: 모든 모델 크기에 대해 GeLU activation을 사용한다 (Hendrycks and Gimpel, 2016).

- Context Window: 모든 모델 크기에 대해 2048 길이의 context window를 사용한다.

- No Biases: PaLM을 따라, dense kernel이나 layer norm에 bias를 사용하지 않는다 (Chowdhery et al., 2022).

- Learned Positional Embeddings: 모델에 학습된 positional embedding을 사용한다. 작은 규모에서는 ALiBi를 실험했지만 큰 성능 향상을 관찰하지 못하여 사용하지 않았다 (Press et al., 2021).

- Vocabulary: BPE (Sennrich et al., 2015)를 사용하여 50k 토큰의 vocabulary를 구축한다. 이 vocabulary는 학습 데이터의 무작위로 선택된 2% subset에서 생성되었다.

4.2 Models

우리가 학습시킨 다양한 모델 크기와 학습 하이퍼파라미터는 Table 5에 요약되어 있다.

| Model | Batch Size | Max LR | Warmup | |||||

|---|---|---|---|---|---|---|---|---|

| GAL 125M | 125 M | 12 | 768 | 12 | 64 | 0.5 M | 375 M | |

| GAL 1.3B | 1.3 B | 24 | 2,048 | 32 | 64 | 1.0 M | 375M | |

| GAL 6.7B | 6.7 B | 32 | 4,096 | 32 | 128 | 2.0 M | 375 M | |

| GAL 30B | 30.0 B | 48 | 7,168 | 56 | 128 | 2.0 M | 375M | |

| GAL 120B | 120.0 B | 96 | 10,240 | 80 | 128 | 2.0 M | 1.125 B |

Table 5: 학습된 모델의 세부 정보

우리는 AdamW 옵티마이저를 사용하여 학습을 진행했으며, 이때 및 weight decay는 0.1로 설정했다 (Loshchilov and Hutter, 2017). gradient의 global norm은 1.0으로 clipping했으며, 학습률(learning rate)은 초기 값의 10%까지 선형적으로 감소시켰다. **dropout과 attention dropout은 **을 사용했고, embedding dropout은 사용하지 않았다.

가장 큰 모델의 경우, 학습 초기 단계에서 긴 warmup이 중요하다는 것을 발견했다. 이는 나쁜 초기화의 영향으로부터 모델을 보호하기 위함인데, 나쁜 초기화는 옵티마이저의 variance state에 장기적인 영향을 미쳐 학습 속도를 늦출 수 있기 때문이다. 이러한 발견은 우리 모델 및 학습 설정에 특정한 것일 수 있으며, 이 조언이 일반화될지는 확실하지 않다.

4.3 Libraries and Infrastructure

우리는 Meta AI의 NextSys 팀이 개발한 metaseq 라이브러리를 사용하여 모델을 학습시킨다. 가장 큰 120B 모델을 학습시키기 위해 128개의 NVIDIA A100 80GB 노드를 사용한다. 추론 시 Galactica 120B는 단일 A100 노드를 필요로 한다. 우리는 다운스트림 접근성을 위해 이 제약을 따르는 최대 모델 크기를 선택했으며, 향후 몇 달 안에 연구 커뮤니티의 접근성을 개선하기 위해 노력할 것이다.

Figure 6: 반복된 토큰과 검증 손실. 4 epoch의 학습 후에도 모든 모델 크기에서 검증 손실(validation loss)이 계속 감소하는 것을 볼 수 있다. 120B 모델의 경우 5번째 epoch 초반에 과적합(overfitting)의 첫 징후가 나타나며, 이 시점에서 조기 종료한다.

Figure 6: 반복된 토큰과 검증 손실. 4 epoch의 학습 후에도 모든 모델 크기에서 검증 손실(validation loss)이 계속 감소하는 것을 볼 수 있다. 120B 모델의 경우 5번째 epoch 초반에 과적합(overfitting)의 첫 징후가 나타나며, 이 시점에서 조기 종료한다.

5 Results

5.1 Repeated Tokens Considered Not Harmful

우리는 모델을 4,500억 개의 token, 즉 약 4.25 epoch 동안 학습시킨다. 코퍼스를 여러 번 반복 학습시켰을 때, validation set, in-domain 및 out-of-domain 벤치마크에서 성능이 계속 향상되는 것을 확인했다.

먼저, Figure 6에서 보듯이 validation loss는 4 epoch의 학습 동안 계속 감소한다. 가장 큰 120B 모델은 5번째 epoch 초반에야 과적합(overfit)되기 시작한다. 이는 기존 연구에서 반복되는 token이 성능에 해로울 수 있다고 제안한 것(Hernandez et et al., 2022)과는 다른 예상치 못한 결과이다. 또한, 30B와 120B 모델에서 validation loss가 정체되거나(혹은 상승하다가) 다시 감소하는 epoch-wise double descent 효과를 발견했다. 이 효과는 epoch가 진행될수록 강해지며, 학습 후반부의 120B 모델에서 가장 뚜렷하게 나타난다.

더 자세히 조사하기 위해, validation loss의 소스별 분석을 통해 loss 행동에 이질성(heterogeneity)이 있는지 확인했다. Figure 23에 30B 모델의 예시 곡선을 그렸다. loss 이질성의 징후는 발견되지 않았으며, 모든 소스에서 loss가 감소하는 것을 볼 수 있다. 120B 모델도 5번째 epoch 초반까지는 모든 소스에서 validation loss가 감소하는 동일한 상대적 경향을 보이다가, 이 시점에서 모든 소스에서 급증한다(Appendix 참조).

다음으로 답해야 할 질문은 이러한 경향이 다운스트림 성능 및 out-of-domain 일반화로 확장되는지 여부이다. 이를 위해 우리는 BIG-bench subset 중 57개 task를 사용했다. 이 subset은 주로 비과학적인 task와 사전학습에 포함되지 않은 prompt 유형을 포함하는 일반적인 코퍼스이다(Srivastava et al., 2022). 결과를 Figure 8에 나타냈다. 과적합의 징후는 발견되지 않았으며, 이는 반복되는 token의 사용이 업스트림 성능뿐만 아니라 다운스트림 성능도 향상시키고 있음을 시사한다.

우리는 두 가지 요인이 작용할 수 있다고 추측한다:

- 품질 요인: 코퍼스의 큐레이션된 특성으로 인해 token당 더 많은 가치를 추출할 수 있다.

- 양식(modality) 요인: 과학 데이터의 특성으로 인해 token당 더 많은 가치를 추출할 수 있다. 이러한 요인들이 과적합을 줄이는 구체적인 인과 관계는 아직 밝혀지지 않았으며, 이 질문은 향후 연구 과제로 남겨둔다. 우리는 현재 LLM 프로젝트의 "tokens "에 대한 강조가 코퍼스 품질 필터링의 중요성에 비해 과도하게 부각될 수 있다는 점을 시사한다.

다음 섹션에서는 Galactica의 과학적 능력을 평가하는 데 중점을 둔다. 특히, 과학을 위한 새로운 인터페이스를 구축하는 데 필요한 과학적 지식을 저장, 결합 및 추론할 수 있는 LLM을 구축하는 고수준 설계 목표에 초점을 맞춘다.

Figure 7: 소스별 Validation Loss. 모든 데이터셋 카테고리에서 학습을 통해 validation loss가 감소한다. 위 그림은 30B 모델의 결과이다. 120B 모델도 5번째 epoch 초반까지는 모든 소스에서 validation loss가 감소하는 동일한 상대적 경향을 보이다가, 이 시점에서 모든 소스에서 급증한다(Appendix 참조).

Figure 7: 소스별 Validation Loss. 모든 데이터셋 카테고리에서 학습을 통해 validation loss가 감소한다. 위 그림은 30B 모델의 결과이다. 120B 모델도 5번째 epoch 초반까지는 모든 소스에서 validation loss가 감소하는 동일한 상대적 경향을 보이다가, 이 시점에서 모든 소스에서 급증한다(Appendix 참조).

Figure 8: 학습 중 BIG-bench 성능. BIG-bench에서 선택된 57개 task는 주로 비과학적인 task를 포함한다. 우리는 이를 out-of-domain 성능의 대리 지표로 사용한다. 위 120B 모델의 경우, 코퍼스를 4번 반복 학습한 후에도 과적합의 징후는 보이지 않는다.

Figure 8: 학습 중 BIG-bench 성능. BIG-bench에서 선택된 57개 task는 주로 비과학적인 task를 포함한다. 우리는 이를 out-of-domain 성능의 대리 지표로 사용한다. 위 120B 모델의 경우, 코퍼스를 4번 반복 학습한 후에도 과적합의 징후는 보이지 않는다.

5.2 Knowledge Probes

첫째, 우리는 Galactica가 과학적 지식을 얼마나 잘 흡수하는지를 조사한다. 우리는 Petroni et al. (2019)의 LAMA 접근 방식을 기반으로 여러 knowledge probe 벤치마크를 설정했다. 이 벤치마크들은 모델 개발 과정에서 코퍼스 내의 지식 격차를 식별하고 코퍼스를 반복적으로 개선하는 데 중요한 지표였다. 또한, 이 벤치마크들은 Galactica와 일반 language model 간의 상대적인 지식 강점에 대한 통찰력을 제공하며, 우리는 다운스트림 task로 넘어가기 전에 이 섹션에서 해당 결과들을 다룬다.

5.2.1 LaTeX Equations

우리는 화학, 물리학, 수학, 통계학, 경제학 분야에서 널리 사용되는 LaTeX 방정식 데이터셋을 구축하였다. 방정식 암기 능력은 많은 다운스트림 task에 필수적이므로 측정하는 것이 유용하다. 예를 들어, 문제에 대한 답변의 일부로 사용할 방정식을 떠올리는 것 등이 이에 해당한다. 명시적으로 언급되지 않는 한, Galactica의 결과는 zero-shot으로 보고된다. 총 434개의 방정식에 대해 지식 탐색(knowledge probe)을 수행한다.

우리는 방정식 이름으로 prompt를 구성하고 LaTeX 코드를 생성한다. 예시는 Figure 9에 나와 있다.

Prompt

Bessel의 미분 방정식 공식은 다음과 같다:

Generated Answer

Figure 9: LaTeX Equations Probe. 우리는 방정식의 이름을 prompt로 제공하고, 생성된 LaTeX 코드가 올바른지 평가한다. 여러 정답 가능성을 고려하여 수동으로 평가를 진행한다.

결과는 Table 6에 요약되어 있다. 방정식 지식은 모델 규모가 커질수록 꾸준히 증가한다. Galactica는 일반 코퍼스로 학습된 더 큰 language model보다 뛰어난 성능을 보여주는데, 이는 선별된 데이터셋의 가치를 시사한다.

| Model | Params (bn) | Chemistry | Maths | Physics | Stats | Econ | Overall |

|---|---|---|---|---|---|---|---|

| OPT | 175 | 34.1% | 4.5% | 22.9% | 1.0% | 2.3% | 8.9% |

| BLOOM | 176 | 36.3% | 36.1% | 6.6% | 14.1% | 13.6% | 21.4% |

| GPT-3 (text-davinci-002) | ? | 61.4% | 65.4% | 41.9% | 25.3% | 31.8% | 49.0% |

| GAL 125 M | 0.1 | 0.0% | 0.8% | 0.0% | 1.0% | 0.0% | 0.5% |

| GAL 1.3B | 1.3 | 31.8% | 26.3% | 23.8% | 11.1% | 4.6% | 20.5% |

| GAL 6.7B | 6.7 | 43.2% | 59.4% | 36.2% | 29.3% | 27.3% | 41.7% |

| GAL 30B | 30 | 63.6% | 74.4% | 35.2% | 40.4% | 34.1% | 51.5% |

| GAL 120B | 120 | 79.6% | 83.5% | 72.4% | 52.5% | 36.4% | 68.2% |

Table 6: LaTeX 방정식에 대한 결과. 결과는 zero-shot으로 평가되었다.

5.2.2 Domain Probes

우리는 또한 특정 분야의 전문 지식을 추적하기 위한 domain probe를 설정했다. 자세한 내용은 다음과 같다:

- AminoProbe: 20가지 일반적인 아미노산의 이름, 구조 및 속성 데이터셋.

- BioLAMA: 생의학적 사실 지식 트리플 데이터셋.

- Chemical Reactions: 화학 반응 데이터셋.

- Galaxy Clusters: 은하단과 그들의 별자리 분류 데이터셋.

- Mineral Groups: 광물과 그들의 광물 그룹 분류 데이터셋.

각 경우에 우리는 지식을 테스트하기 위한 prompt를 구성한다. 예를 들어, Chemical Reactions의 경우, Galactica에게 화학 방정식 LaTeX에서 반응의 생성물을 예측하도록 요청한다. 모델이 오직 반응물에 기반하여 추론하도록 설명에서 생성물을 마스킹 처리한다. 예시는 Figure 10에 나와 있다.

Prompt

Sulfuric acid reacts with sodium chloride, and gives __-__ and __-__:

\[ \ce\{ NaCl + H2SO4 ->

Generated Answer

\(\mathrm{NaCl}+\mathrm{H}_{2} \mathrm{SO}_{4} \longrightarrow \mathrm{NaHSO}_{4}+\mathrm{HCl}\)

Figure 10: Chemical Reactions. 우리는 설명과 반응물을 기반으로 prompt를 제공하고, 생성된 생성물이 올바른지 평가한다.

이러한 knowledge probe에 대한 결과는 Table 7에 보고되어 있다.

| Model | Params (bn) | Amino | BioLAMA | Reactions | Clusters | Minerals |

|---|---|---|---|---|---|---|

| OPT | 175 | 12.0% | 7.1% | 12.7% | 21.7% | 1.6% |

| BLOOM | 176 | 14.0% | 9.7% | 22.4% | 15.0% | 10.3% |

| GPT-3 (text-davinci-002) | ? | 14.0% | 8.4% | 35.1% | 20.8% | 18.3% |

| GAL 125 M | 0.1 | 12.0% | 3.1% | 0.3% | 6.7% | 0.0% |

| GAL 1.3B | 1.3 | 16.0% | 7.2% | 14.4% | 14.2% | 10.3% |

| GAL 6.7B | 6.7 | 17.0% | 7.9% | 26.4% | 17.5% | 8.7% |

| GAL 30B | 30 | 21.0% | 6.9% | 36.5% | 20.0% | 17.5% |

| GAL 120B | 120 | 21.0% | 8.0% | 43.1% | 24.2% | 29.4% |

Table 7: Domain Probe 결과. 결과는 zero-shot으로 평가되었다.

우리는 또한 이러한 knowledge probe에서 꾸준한 스케일링 행동을 관찰했다. 다만 BioLAMA는 모든 LLM에 대해 zero-shot prompt의 난이도를 반영하는 것으로 추정된다. 특히, "ConstellationOf (GalaxyCluster)" 유형의 쿼리와 같은 세분화된 사실 지식은 모델 크기에 따라 원활하게 스케일링되는 것으로 보인다.

5.2.3 Reasoning

이제 우리는 <work> token을 사용한 추론 능력에 대해 살펴본다. 먼저 MMLU 수학 벤치마크에 대한 평가를 시작하며, 그 결과는 Table 8에 보고되어 있다 (Hendrycks et al., 2020). Galactica는 더 큰 base model들에 비해 강력한 성능을 보이며, <work> token의 사용은 더 작은 30B Galactica 모델에서도 Chinchilla보다 성능을 향상시키는 것으로 나타났다.

| Mathematics MMLU | |||||||

|---|---|---|---|---|---|---|---|

| Model | Params (bn) | A.Algebra | Elem | HS | College | F. Logic | Average |

| BLOOM (5-shot) | 176 | 25.0% | 26.7% | 27.0% | 25.0% | 26.2% | 26.4% |

| OPT (5-shot) | 175 | 21.0% | 25.7% | 24.4% | 33.0% | 29.4% | 26.7% |

| Gopher (5-shot) | 280 | 25.0% | 33.6% | 23.7% | 37.0% | 35.7% | 30.6% |

| Chinchilla (5-shot) | 70 | 31.0% | 41.5% | 31.9% | 32.0% | 33.3% | 35.7% |

| GAL 1.3B | 1.3 | 28.0% | 27.2% | 26.7% | 30.0% | 24.6% | 27.1% |

| GAL 6.7B | 6.7 | 28.0% | 28.9% | 26.7% | 36.0% | 31.0% | 29.2% |

| GAL 30B | 30 | 30.0% | 30.2% | 26.3% | 36.0% | 31.7% | 29.9% |

| GAL 120B | 120 | 33.0% | 38.1% | 32.6% | 43.0% | 32.5% | 35.8% |

| GAL 1.3B <work> | 1.3 | 22.0% | 24.6% | 18.9% | 25.0% | 31.0% | 24.6% |

| GAL 6.7B <work> | 6.7 | 33.3% | 30.7% | 25.2% | 26.0% | 33.3% | 28.0% |

| GAL 30B <work> | 30 | 33.0% | 41.5% | 33.3% | 39.0% | 37.3% | 37.1% |

| GAL 120B <work> | 120 | 27.0% | 54.2% | 37.0% | 44.0% | 40.5% | 41.3% |

Table 8: Mathematics MMLU 결과. Galactica는 few-shot 예시 없이 평가되었다. <work> token을 사용하면 성능이 크게 향상되는 것을 볼 수 있다. 결과는 MMLU test 세트 기준이다.

우리는 Galactica의 추론 능력을 더 자세히 조사하기 위해 MATH 데이터셋에서도 평가를 수행한다 (Hendrycks et al., 2021). 비교 가능성을 위해 <work> token prompt를 Minerva 5-shot chain-of-thought prompt mCoT와 직접 비교한다. 결과는 Table 9에 보고되어 있다.

| MATH Results | ||||||||

|---|---|---|---|---|---|---|---|---|

| Model | Alg | CProb | Geom | I.Alg | N.Theory | Prealg | Precalc | Average |

| Base Models | ||||||||

| GPT-3 175B (8-shot) | 6.0% | 4.7% | 3.1% | 4.4% | 4.4% | 7.7% | 4.0% | 5.2% |

| PaLM 540B (5-shot) mCoT | 9.7% | 8.4% | 7.3% | 3.5% | 6.0% | 19.2% | 4.4% | 8.8% |

| GAL 30B <work> | 15.8% | 6.3% | 5.8% | 4.9% | 2.4% | 19.4% | 8.2% | 11.4% |

| GAL 30B (5-shot) mCoT | 17.9% | 6.8% | 7.9% | 7.0% | 5.7% | 17.9% | 7.9% | 12.7% |

| GAL 120B <work> | 23.1% | 10.1% | 9.8% | 8.6% | 6.5% | 23.8% | 11.7% | 16.6% |

| GAL 120B (5-shot) mCoT | 29.0% | 13.9% | 12.3% | 9.6% | 11.7% | 27.2% | 12.8% | 20.4% |

| Fine-tuned LaTeX Models | ||||||||

| Minerva 540B (5-shot) mCoT | 51.3% | 28.0% | 26.8% | 13.7% | 21.2% | 55.0% | 18.0% | 33.6% |

Table 9: MATH 결과. chain-of-thought와 <work> token prompt 모두에서 Galactica는 18배 적은 용량으로 PaLM의 성능을 능가한다.

Galactica는 chain-of-thought 및 <work> prompt 모두에서 base PaLM 모델을 상당한 차이로 능가하는 것을 볼 수 있다. Galactica 30B는 PaLM 540B보다 두 가지 prompt 모두에서 더 나은 성능을 보이며, 이는 18배 더 작은 모델이다. 이는 Galactica가 수학적 task에 대한 fine-tuning을 위한 더 나은 base model이 될 수 있음을 시사한다.

Minerva 결과는 완전성을 위해 보고되었으며, 이는 LaTeX에 특화되어 fine-tuning된 540B PaLM 모델이다. Minerva는 base Galactica를 능가하지만, 성능 차이가 균일하지 않다. 이는 서로 다른 수학 데이터 편향을 시사한다. Minerva와의 직접적인 비교를 위해, 후속 연구로 Galactica를 LaTeX에 특화하여 fine-tuning하고자 하는 사람들을 위해 모델은 자유롭게 이용 가능하다.

5.3 Downstream Scientific NLP

이제 우리는 Galactica가 다양한 task context에서 지식을 얼마나 잘 구성할 수 있는지 확인하기 위해 다운스트림 과학 task에 대해 평가한다. 우리는 지식 집약적인 과학 task에 중점을 두었으며, 전체 결과는 Table 10에 보고한다. 이를 위해 MMLU 벤치마크와 다른 인기 있는 과학 QA 벤치마크들을 사용한다. 우리는 지식 연관성을 특별히 테스트하기 위해 <work> 없이 MMLU 결과를 먼저 포함했다. 사회 과학 및 기타 분야를 포함한 전체 MMLU 결과는 Appendix에 보고되어 있다. 또한 우리는 이러한 벤치마크에 대한 데이터 유출 분석을 수행하여 신뢰도를 높였으며, 결과는 Appendix에 있다.

Table 10에서 Galactica는 지식을 질문-답변 task에 구성할 수 있으며, 성능은 강력하다. 다른 open language model들을 크게 능가하며, 대부분의 task에서 더 큰 모델인 Gopher 280B보다도 우수한 성능을 보인다. Chinchilla와의 성능 비교는 더 가변적이며, Chinchilla는 특정 task, 특히 고등학교 과목과 덜 수학적이고 암기 위주의 task에서 더 강한 것으로 나타났다. 이와 대조적으로 Galactica는 수학적이고 대학원 수준의 task에서 더 나은 성능을 보이는 경향이 있다.

우리의 가설은 Galactica corpus가 주로 논문으로 구성되어 있어 대학원 수준의 과학 지식에 편향되어 있다는 것이다. 이는 고등학교 과목에서 성능이 뒤처지는 이유를 설명한다. 우리는 백과사전, 교과서, 필터링된 CommonCrawl을 통해 일부 고등학교 수준의 콘텐츠를 수집했지만, 이는 소량의 토큰(수십억 개)에 불과하다. 이러한 기초 과학 지식을 더 체계적으로 포착하는 방법은 향후 연구 과제로 남겨둔다.

나머지 task에서는 작성 시점 기준으로 fine-tuned model들을 능가하는 state-of-the-art 결과를 달성했다. PubMedQA에서는 **77.6%**의 점수를 달성하여 **state-of-the-art인 72.2% (Yasunaga et al., 2022)**를 능가한다. MedMCQA dev에서는 **state-of-the-art인 41.0% (Gu et al., 2020)**에 비해 **52.9%**의 점수를 달성했다. BioASQ 및 MedQA-USMLE의 경우, fine-tuned model의 **state-of-the-art 성능 (94.8% 및 44.6%) (Yasunaga et al., 2022)**에 근접한 성능을 보인다.

| Dataset | Domain | GAL | OPT | BLOOM | GPT-3 | Gopher | Chinchilla |

|---|---|---|---|---|---|---|---|

| Abstract Algebra | out-of-domain | 33.3% | 21.0% | 25.0% | - | 25.0% | 31.0% |

| ARC Challenge | in-domain | 67.9% | 31.1% | 32.9% | 51.4% | - | - |

| ARC Easy | in-domain | 83.8% | 37.4% | 40.7% | 68.8% | - | - |

| Astronomy | out-of-domain | 65.1% | 23.0% | 25.7% | - | 65.8% | 73.0% |

| BioASQ | in-domain | 94.3% | 81.4% | 91.4% | - | - | - |

| Biology (College) | out-of-domain | 68.8% | 30.6% | 28.5% | - | 70.8% | 79.9% |

| Biology (High-School) | out-of-domain | 69.4% | 27.7% | 29.4% | - | 71.3% | 80.3% |

| Chemistry (College) | out-of-domain | 46.0% | 30.0% | 19.0% | - | 45.0% | 51.0% |

| Chemistry (High-School) | out-of-domain | 47.8% | 21.7% | 23.2% | - | 47.8% | 58.1% |

| Comp. Science (College) | out-of-domain | 49.0% | 17.0% | 6.0% | - | 49.0% | 51.0% |

| Comp. Science (High-School) | out-of-domain | 70.0% | 30.0% | 25.0% | - | 54.0% | 58.0% |

| Econometrics | out-of-domain | 42.1% | 21.0% | 23.7% | - | 43.0% | 38.6% |

| Electrical Engineering | out-of-domain | 62.8% | 36.6% | 32.4% | - | 60.0% | 62.1% |

| Elementary Mathematics | out-of-domain | 38.1% | 25.7% | 27.6% | - | 33.6% | 41.5% |

| Formal Logic | out-of-domain | 32.5% | 29.4% | 26.2% | - | 35.7% | 33.3% |

| Machine Learning | out-of-domain | 38.4% | 28.6% | 25.0% | - | 41.1% | 41.1% |

| Mathematics (College) | out-of-domain | 43.0% | 33.0% | 25.0% | - | 37.0% | 32.0% |

| Mathematics (High-School) | out-of-domain | 32.6% | 24.4% | 27.0% | - | 23.7% | 31.9% |

| Medical Genetics | out-of-domain | 70.0% | 35.0% | 36.0% | - | 69.0% | 69.0% |

| Physics (College) | out-of-domain | 42.2% | 21.6% | 18.6% | - | 34.3% | 46.1% |

| Physics (High-School) | out-of-domain | 33.8% | 29.8% | 25.2% | - | 33.8% | 36.4% |

| MedQA-USMLE | out-of-domain | 44.4% | 22.8% | 23.3% | - | - | - |

| MedMCQA Dev | in-domain | 52.9% | 29.6% | 32.5% | - | - | - |

| PubMedQA | in-domain | 77.6% | 70.2% | 73.6% | - | - | - |

| Statistics (High-School) | out-of-domain | 41.2% | 43.5% | 19.4% | - | 50.0% | 58.8% |

Table 10: 질문-답변 결과. Galactica는 few-shot 예시 없이 평가되었다. 다른 LLM들은 5-shot으로 평가되었으며, GPT-3의 ARC 결과와 OPT 및 BLOOM의 PubMedQA 및 BioASQ는 0-shot 결과이다. Abstract algebra와 Medical genetics의 경우, 30B 모델에서 가장 좋은 결과를 얻었으므로 이 점수를 보고한다. 이들에 대한 120B 모델의 점수는 각각 **27.0%**와 **68.0%**였다. 나머지 결과는 120B 모델에 대한 것이다.

5.4 Citation Prediction

이 섹션에서는 주어진 입력 context에 대해 인용(citation)을 예측하는 Galactica의 능력을 평가한다. 이는 과학 문헌을 조직화하는 Galactica의 능력을 측정하는 중요한 테스트이다. 우리는 정확도와 분포 근사(distributional approximation)의 품질이 모델 규모(scale)에 따라 향상됨을 발견했다.

5.4.1 Citation Accuracy

우리는 모델의 인용(citation) 능력을 평가하기 위해 세 가지 데이터셋을 구축하였다:

- PWC Citations: 머신러닝 개념과 이를 소개한 논문 644쌍으로 구성된 데이터셋. 개념은 Papers with Code에서 가져온 방법론(예: ResNet)과 데이터셋(예: ImageNet)으로 이루어져 있다.

- Extended Citations: 머신러닝이 아닌 개념과 이를 소개한 논문 110쌍으로 구성된 데이터셋. 개념의 예시로는 Kozac sequence와 Breit-Wigner distribution이 있다.

- Contextual Citations: arXiv validation set에서 가져온 1,869쌍의 참조(reference)와 문맥(context)으로 구성된 데이터셋. 이 데이터셋은 1,000개의 무작위 참조를 샘플링하고 그 문맥을 수집하여 구축되었다.

PWC Citations 및 Extended Citations 데이터셋의 경우, 인용 예측(citation prediction) task는 텍스트 생성 task로 구성된다. 모델은 "In this paper we use ResNet method [START_REF]"와 같은 prompt를 받아 ResNet 개념에 대한 예측을 생성한다. Contextual Citations의 경우, 문맥이 [START_REF]로 끝나는 입력 문맥 뒤에 인용을 위한 prompt를 제공한다.

우리는 이 task에서 Galactica를 sparse 및 dense retrieval 기반 접근 방식과 비교한다. Sparse baseline의 경우, ElasticSearch를 사용하여 모든 참조(reference)에 대한 인덱스를 생성한다. 이 인덱스에는 참조의 제목, 초록, 그리고 참조가 나타나는 문맥을 포함하는 짧은 텍스트 스니펫이 포함된다. 그런 다음, 텍스트 쿼리가 주어지면, 선택된 모든 필드에 걸쳐 일치 점수의 합계로 정렬된 상위 참조를 검색한다. Dense retriever baseline의 경우, 두 가지 다른 Contriever 모델(Izacard et al., 2021)을 평가한다. 첫 번째는 Izacard et al. (2021)이 공개한 사전학습된 모델이다. 두 번째 모델은 우리의 코퍼스에서 무작위로 추출한 1,000만 개의 문맥/논문 쌍으로 fine-tuning되었으며, 인용 전 문맥이 주어졌을 때 올바른 논문을 검색하도록 학습되었다. dense retrieval 설정은 다음과 같다: (1) 각 참조는 모델에 의해 제목과 초록을 사용하여 인코딩되고, (2) 텍스트 쿼리는 동일한 모델에 의해 인코딩되며, (3) 쿼리와 일치하는 참조가 반환된다. 검색은 FAISS index (Johnson et al., 2019)를 사용하여 수행된다. 결과는 Table 11에서 확인할 수 있다.

| Model | Params (bn) | PWC Citations | Extended Citations | Contextual Citations |

|---|---|---|---|---|

| GAL 125 M | 0.1 | 7.0% | 6.4% | 7.1% |

| GAL 1.3B | 1.3 | 18.5% | 45.5% | 15.9% |

| GAL 6.7B | 6.7 | 32.0% | 60.0% | 23.0% |

| GAL 30B | 30 | 44.7% | 66.4% | 31.5% |

| GAL 120B | 120 | 51.9% | 69.1% | 36.6% |

| Sparse Retriever | n/a | 30.9% | 17.3% | 5.3% |

| Dense Retriever (base) | n/a | 16.4% | 8.8% | 1.6% |

| Dense Retriever (fine-tuned) | n/a | 27.6% | 11.8% | 8.2% |

Table 11: 인용 예측 정확도. 인용 예측에 대한 다양한 모델 크기의 성능.

모든 평가 세트에서 성능은 규모에 따라 꾸준히 증가한다. 규모가 커질수록 Galactica는 문맥 연관 능력이 향상되어 retrieval 기반 접근 방식보다 뛰어난 성능을 보인다. 이는 문헌 탐색을 위한 현재 접근 방식이 기존의 retrieval 방식을 사용한다는 점에서 중요한 결과이다. 언어 모델의 능력이 향상됨에 따라, 우리는 이들이 문헌 탐색을 위한 귀중한 새로운 도구가 될 것이라고 예상한다.

Figure 11: 인용의 분포 비교. Galactica의 인용 분포는 규모에 따라 ground truth에 근접한다. 이는 규모에 따른 KS 거리 감소와 히스토그램 중첩 증가를 통해 확인할 수 있다.

Figure 11: 인용의 분포 비교. Galactica의 인용 분포는 규모에 따라 ground truth에 근접한다. 이는 규모에 따른 KS 거리 감소와 히스토그램 중첩 증가를 통해 확인할 수 있다.

Prompt in the BQ literature as, when is a mixture of Gaussians, the mean element is analytically tractable (see Appendix C). Some other ( ) pairs that produce analytic mean elements are discussed in [ [START_REF] On the Equivalence between Kernel Quadrature Rules and Random Feature Expansions, Bach [START_REF]]. For this simulation study, we took to be a 20-component mixture of 2D-Gaussian distributions. Monte Carlo (MC) is often used for such distributions but has a slow convergence rate in . FW and FWLS are known to converge more quickly and are in this sense preferable to MC [ [START_REF]

Prediction On the Equivalence between Herding and Conditional Gradient Algorithms, Bach

Figure 12: 인용 Prompt. 문맥 내에서 인용을 예측하는 예시 prompt; Briol et al. (2015)에서 발췌.

5.4.2 Citation Distributional Analysis

이제 Galactica가 **경험적 인용 분포(empirical citation distribution)**를 얼마나 잘 모델링하는지 살펴본다. 이 분석을 위해 우리는 Contextual Citations 데이터셋을 사용하는데, 여기서 prompt는 인용문 앞의 문맥을 prompt로 취하여 논문에서 추출된다. 모델 예측이 포함된 prompt 예시는 Figure 12에 제시되어 있다.

우리는 in-context citation 데이터를 사용하여 예측된 논문 수와 실제(ground truth) 논문 수 간의 분포 차이를 분석한다. 이를 통해 모델이 더 인기 있는 논문을 예측하려는 편향을 평가할 수 있다. 구체적으로, 각 context에 대해 **실제 참조(ground truth reference)와 예측된 참조(predicted reference)**가 존재한다. 우리는 각 참조가 우리 코퍼스에 나타나는 횟수를 센다. 그런 다음 **Kolmogorov-Smirnov distance (Massey, 1951)**를 사용하여 실제 참조와 예측된 참조 간의 참조 수 분포를 비교한다.

다양한 모델 크기에 대한 인용 수 분포 비교는 Figure 11에서 확인할 수 있다. Figure 11a는 실제 논문 인용 분포와 예측된 논문 인용 분포 간의 Kolmogorov-Smirnov distance 감소를 보여준다. Figure 11b는 모델 크기가 커짐에 따라 예측된 논문의 논문 수 분포가 실제 분포에 더 가까워지는 방식을 보여준다. 작은 규모에서는 모델이 더 인기 있는 논문을 예측하는 경향이 강하다. 모델 크기가 커짐에 따라 인기 있는 논문을 예측하려는 이러한 편향은 감소한다.

5.5 General Capabilities

우리는 Galactica의 과학적 능력을 연구했다. 전문 과학 모델이 과학 task에서 일반 모델보다 뛰어난 성능을 보이는 것은 놀라운 일이 아닐 수 있지만, 일반 NLP task에서 일반 모델보다 뛰어난 성능을 보인다면 더욱 놀라운 일일 것이다. 이 섹션에서는 Galactica가 바로 그러한 성능을 보인다는 놀라운 증거를 제시한다.

우리는 Table 12 (Srivastava et al., 2022)의 57개 BIG-bench task에 대해 평가를 수행했다. 이 task들은 주로 비과학적이며 일반적인 언어 능력을 테스트한다. 예를 들어, anachronisms, figure of speech, metaphor boolean 등이 있다. 우리는 항상 5-shot으로 평가했으며, BIG-Bench의 기본 prompt 스타일을 사용했다. 중요한 점은, 우리는 이 prompt 스타일을 사전학습에 포함하지 않았으므로, Galactica와 다른 모델 간의 평가는 비교 가능한 5-shot 설정이다. 자세한 내용과 결과는 Appendix에 있다. 평균 점수는 Table 12에 요약되어 있다:

| Model | Params (bn) | Accuracy <br> weighted | Accuracy <br> unweighted |

|---|---|---|---|

| OPT 30B | 30 | ||

| BLOOM 176B | 176 | ||

| OPT 175B | 175 | ||

| GAL 30B | 30 | ||

| GAL 120B | 120 |

Table 12: BIG-bench 57 Task 결과. Galactica는 더 작은 규모에서도 일반 open 모델보다 뛰어난 성능을 보인다.

30B 및 120B Galactica 모델 모두 더 큰 OPT 및 BLOOM 일반 모델보다 뛰어난 성능을 보인다. 이는 우리가 Galactica를 과학 task에서의 성능을 위해 일반성을 희생하도록 설계했다는 점을 고려할 때 놀라운 결과이다.

우리는 이러한 결과가 Galactica 코퍼스의 높은 품질을 반영한다고 추측한다. 이는 코퍼스가 큐레이션되었고 주로 학술 텍스트로 구성되어 있기 때문이다. 이전의 open LLM 노력들은 규모 목표에 과도하게 집중하고 데이터 필터링에는 소홀했을 가능성이 있다. 또 다른 시사점은 Chinchilla의 tokens 에 대한 강조가 강력한 데이터 품질 절차로 보완되어야 한다는 것이다 (Hoffmann et al., 2022). 본 논문에서는 고품질 토큰과 반복적인 학습 epoch에 집중하여 반대 접근 방식을 취했다. 그러나 Chinchilla의 통찰력은 여전히 유효하며, 본 연구에서 활용하지 못한 더 많은 과학 텍스트가 존재한다.

5.6 Chemical Understanding

이제 Galactica가 다양한 과학적 **모달리티(modality)**와 상호작용하는 능력에 대해 살펴본다. 먼저 Galactica의 화학적 능력부터 시작한다. 화학적 특성들은 복잡한 상관관계를 보이며, 이는 화학 공간(chemical space)이 매우 크다는 것을 의미한다. 언어 모델을 통해 화학 정보를 더 잘 조직화하는 것은 화학 설계 및 발견에 도움이 될 수 있다. 이 섹션에서는 Galactica가 이러한 task에 새로운 인터페이스를 어떻게 제공할 수 있는지 탐구한다.

본 연구에서는 사전학습 시 PubChem Compound에서 제공되는 화합물 중 작은 부분집합만을 포함했다. 구체적으로, 전체 화합물(1억 1천만 개) 중 무작위로 2백만 개를 샘플링하여 사용했다. 이는 모델이 자연어(natural language)보다 자연 시퀀스(natural sequences) 학습에 지나치게 편향되지 않도록 하기 위함이다. 이 제약은 향후 연구에서 완화하여 훨씬 더 큰 코퍼스를 활용할 수 있을 것이다. 여기서는 단일 모델이 멀티모달 환경에서 효과적으로 학습할 수 있는지를 조사하는 첫 단계에 중점을 둔다.

우리는 언어 모델이 IUPAC 명명법과 같은 화학 task를 self-supervised 방식으로 학습할 수 있음을 발견했으며, 또한 약물 발견(drug discovery) task를 자연어 prompt로 제시하여 합리적인 결과를 얻을 수 있음을 확인했다.

5.6.1 IUPAC Name Prediction

SMILES는 화학 구조를 일련의 문자로 표현하는 선형 표기법이다 (Weininger, 1988). Galactica 코퍼스에서 SMILES 공식은 IUPAC 이름, 분자량, XLogP와 같은 문서 내 정보와 함께 나타난다. Self-supervised learning의 맥락에서 이는 language model이 implicit multi-task learning을 수행하고 있음을 의미한다: 모델은 다음 SMILES token을 예측하지만, SMILES를 사용하여 문서 내 다른 개체도 예측할 수 있다.

초기 테스트로, 우리는 IUPAC Name Prediction task를 설정했다. 이 task는 SMILES 공식 입력이 주어졌을 때, IUPAC 명명법에 따라 화합물의 이름을 지정하는 것이다. IUPAC 명명법은 단일 결합으로 연결된 가장 긴 탄소 사슬의 이름을 기반으로 하는 규칙 세트를 가진 유기 화합물 명명 방법이다 (Favre and Powerll). 이는 방대한 규칙 세트와 알고리즘적으로 복잡한 절차를 가지고 있어 자동화하기 어렵다. 결과적으로, 표준 cheminformatics toolkit에는 이 기능이 빠져 있다.

STOUT 및 Struct2IUPAC와 같은 이전 연구들은 이 task에 RNN과 Transformer를 사용하는 가능성을 탐구했다 (Rajan et al., 2021; Krasnov et al., 2021). 우리는 이 섹션에서 Galactica가 self-supervised setting에서 SMILES 사양을 IUPAC 이름으로 번역할 수 있는지 탐구한다. 우리는 PubChem 구조를 기반으로 prompt를 설계했으며, SMILES를 유일한 입력으로 하고 IUPAC 이름을 예측하도록 출력한다.

평가를 위해 17,052개의 화합물로 구성된 화합물 검증 세트를 사용하고, SMILES 공식을 prompt로 사용하여 IUPAC 이름을 예측한다. 정확도를 계산하기 위해 OPSIN을 사용하여 생성된 IUPAC 이름을 SMILES로 변환하고, 이를 canonicalize한 다음 canonicalized SMILES target과 비교한다 (Lowe et al., 2011). 결과는 Table 13에 나와 있다.

| Model | Params (bn) | Accuracy | Invalid Names |

|---|---|---|---|

| GAL 125M | 0.1 | ||

| GAL 1.3B | 1.3 | ||

| GAL 6.7B | 6.7 | ||

| GAL 30B | 30 | ||

| GAL 120B | 120 |

Table 13: IUPAC 명명 결과. 성능은 규모에 따라 꾸준히 향상된다.

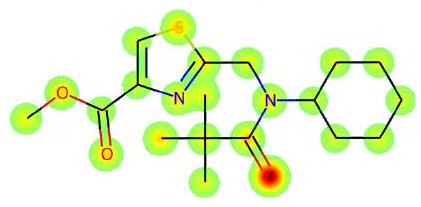

정확도는 규모에 따라 꾸준히 증가한다. 코퍼스를 2백만 개의 분자로 제한했음을 고려할 때, 더 많은 분자로 학습하거나 fine-tuning을 통해 훨씬 더 나은 성능을 달성할 수 있을 것으로 예상된다. 이 후속 작업을 수행하려는 사람들을 위해 모델은 자유롭게 사용할 수 있다. 더 즉각적인 질문은 실제로 무엇을 학습하고 있는가이다: Galactica는 근본적인 분자 구조로부터 이름을 추론하고 있는가? 이에 답하기 위해, 우리는 다음 페이지 Figure 13에서 예측의 각 단계에서 평균 원자 attention을 시각화한다. 고무적으로, 결과는 기저 화학(underlying chemistry) 측면에서 해석 가능하며, Galactica는 이름을 예측할 때 올바른 그룹에 attend한다. 예를 들어, "amino"를 예측할 때 주로 치환기에 attend한다.

Task: Convert the SMILES to IUPAC Name

Example:

| Atomic Attention | Predicted So Far | Token Predicted |

|---|---|---|

| <smiles>COC(=O)c1coc(CN(C(=O)C(C)(C)C)C2C=CCCC2)n1</smiles> | - | methyl |

| <smiles>COC(=O)c1coc(CN(C(=O)C(C)(C)C)C2CCCCC2)n1</smiles> | methyl 2-[[cyclohexyl | cyclohexyl |

| <smiles>C=C1N(C2CCCCC2)Cc2scc(C(=O)OC)n2C1(C)C</smiles> | methyl 2-[[cyclohexyl-(2,2- | dimethyl |

| <smiles>C=C1N(C2CCCCC2)Cc2occ(C(=O)OC)n2C1(Cl)Cl</smiles> | methyl 2-[[cyclohexyl-(2,2-dimethyl | prop |

| methyl 2-[[cyclohexyl-(2,2-dimethylprop | anoyl |

| methyl 2-[[cyclohexyl-(2,2-dimethylpropanoyl) | amino |

| <smiles>CC(C)(C)C(=O)N(Cc1nc(C(=O)O[Hg])cs1)C1CCCCC1</smiles> | methyl 2-[[cyclohexyl-(2,2-dimethylpropanoyl)]amino] methyl] | th |

| <smiles>CC(C)(C)C(=O)N(Cc1nc(C(=O)OCl)cs1)C1CCCCC1</smiles> | methyl 2-[[cyclohexyl-(2,2-dimethylpropanoyl)]amino] methyl]th | iazole |

| <smiles>CC(C)(C)C(=O)N(Cc1nc(C(=O)C[Hg]Cl)cs1)C1CCCCC1</smiles> | methyl 2-[[cyclohexyl-(2,2-dimethylpropanoyl)]amino] methyl]thiazole-4- | carboxylate |

Figure 13: 작용기에 대한 Attention. Galactica는 화학 지식을 활용하여 IUPAC 명명(Naming) task를 수행한다. 각 예측 단계에서 모델은 작용기 이름과 관련된 분자 그래프의 부분에 attention을 기울인다. 예를 들어, "amino"를 예측할 때는 질소 원자에, "thiazole"을 예측할 때는 황 원자에 attention을 집중한다.

5.6.2 MoleculeNet

이제 우리는 전통적인 신약 개발(drug discovery) task를 자연어 형식으로 표현하고, 관련된 다양한 modality를 결합할 수 있는지 탐구한다. 인간은 자연어를 통해 지식을 조직화하므로, 자연어와 SMILES와 같은 과학적 modality 간의 인터페이스를 학습하는 것은 화학 공간(chemical space)을 탐색하는 새로운 도구가 될 수 있다. 우리는 이 질문에 답하기 위해 MoleculeNet 분류 벤치마크를 사용하며, 이는 Table 14에 요약되어 있다 (Wu et al., 2017).

| Category | Dataset | Type | Other modalities |

|---|---|---|---|

| Biophysics | HIV | Classification | n/a |

| BACE C | Classification | n/a | |

| BBBP | Classification | n/a | |

| Tox21 | Classification | protein sequences | |

| SIDER | Classification | n/a | |

| ClinTox | Classification | n/a |

Table 14: 평가에 사용된 MoleculeNet 데이터셋. 우리는 학습 세트를 텍스트 형식으로 변환하여 사전학습에 포함한다. DeepChem 라이브러리(Ramsundar et al., 2019)에서 제안한 분할(split)을 사용하여 평가한다.

평가를 위해, 우리는 학습 세트를 텍스트 형식으로 변환하여 사전학습에 포함한다. 우리는 **prompt randomization (질문을 제시하는 방식을 다양화)**을 사용한다. 예를 들어, BBBP의 경우 학습 prompt는 아래 Figure 14와 같은 형태를 가진다. 이러한 예시들은 학습 시 다른 코퍼스와 함께 나타나며, 각 예시는 4번 이상 보여진다. 이는 사전학습에 다른 데이터가 존재하기 때문에 직접적인 fine-tuning이나 supervision과 비교할 수 없으므로, 약한 형태의 supervision으로 간주될 수 있다.

Here is a SMILES formula: [START_I_SMILES]0=C(0) CCCC1=CC=C(N(CCCl)CCCl)C=C1[END_I_SMILES] Question: Will the chemical compound penetrate the blood-brain barrier? Answer: No

Figure 14: BBBP Prompt. 우리는 SMILES를 포함하고 분류 문제를 자연어로 제시한다.

일부 MoleculeNet 데이터셋에서는 다른 modality가 암묵적으로 존재한다. 예를 들어, Tox21 데이터셋에서 bioassay는 안드로겐 수용체(androgen receptor, AR)와 같은 특정 수용체와 관련이 있다. 실험적으로, 우리는 단백질 서열과 SMILES를 prompt의 일부로 포함하는 텍스트 형식으로 task를 구성하기로 결정했다. Tox21에 대한 예시는 Figure 15에 나와 있다.

Here is a sequence for a protein: [START_AMINO] MEEPQSDPSVEPPLSQETFSDLWKLLPE. . . [END_AMINO] And here is an isomeric SMILES for a compound: [START_I_SMILES] CC END_I_SMILES] Question: Will the the chemical compound be active against this protein? Answer: No

Figure 15: Tox21 Prompt. 우리는 단백질 서열과 SMILES 공식을 포함하고 분류 문제를 자연어로 제시한다.

우리는 PubChem 표현과 일관성을 유지하기 위해 SMILES를 Kekulize한다. 평가를 위해 DeepChem 라이브러리(Ramsundar et al., 2019)에서 권장하는 분할(split)을 사용한다.

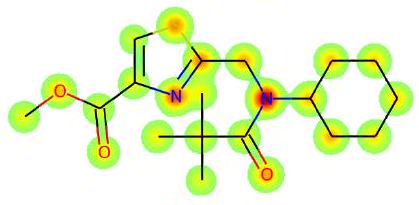

Figure 16: Tox21에 대한 Attention Visualization. 상위 세 분자는 30B 모델에 대한 가장 높은 신뢰도의 양성 예시이며, 하위 세 분자는 가장 높은 신뢰도의 음성 예시이다. 우리는 SMILES의 attention 가중치를 canonical atom ordering과 일치시킨다. Danazol과 gestodene은 안드로겐 수용체(AR)에 대한 높은 친화도를 가지는 것으로 알려져 있다 (Nieschlag et al., 2010).

Figure 16: Tox21에 대한 Attention Visualization. 상위 세 분자는 30B 모델에 대한 가장 높은 신뢰도의 양성 예시이며, 하위 세 분자는 가장 높은 신뢰도의 음성 예시이다. 우리는 SMILES의 attention 가중치를 canonical atom ordering과 일치시킨다. Danazol과 gestodene은 안드로겐 수용체(AR)에 대한 높은 친화도를 가지는 것으로 알려져 있다 (Nieschlag et al., 2010).

결과는 Table 15에 제시되어 있다. 성능은 모델 크기에 따라 확장된다. 확장 속도는 QA와 같은 task보다 느리며, 기본 모델은 명시적인 3D 정보와 10배 더 많은 분자를 사용하는 전문 모델(Zhou et al., 2022)에 뒤처진다. 우리는 약한 supervision 설정이 이 task에 더 어렵고, 충분한 task 신호를 얻기 위해서는 fine-tuning 및/또는 더 많은 분자 데이터가 필요하다고 생각한다. 이 모델은 이러한 연구에 활용될 수 있다.

| MoleculeNet Classification | |||||||||

|---|---|---|---|---|---|---|---|---|---|

| Model | Modality | Molecules | BACE | BBBP | ClinTox | HIV | SIDER | Tox21 | Av. |

| GAL 125M | SMILES | 2M | 0.561 | 0.393 | 0.518 | 0.702 | 0.559 | 0.543 | 0.581 |

| GAL 1.3B | SMILES | 2M | 0.576 | 0.604 | 0.589 | 0.724 | 0.540 | 0.606 | 0.619 |

| GAL 6.7B | SMILES | 2M | 0.584 | 0.535 | 0.784 | 0.722 | 0.559 | 0.639 | 0.640 |

| GAL 30B | SMILES | 2M | 0.727 | 0.596 | 0.822 | 0.759 | 0.613 | 0.685 | 0.687 |

| GAL 120B | SMILES | 2M | 0.617 | 0.661 | 0.826 | 0.745 | 0.632 | 0.689 | 0.690 |

| Uni-Mol | 3D | 20M | 0.857 | 0.729 | 0.919 | 0.808 | 0.659 | 0.796 | 0.770 |

Table 15: MoleculeNet Classification 결과. 결과는 ROC-AUC로 평가된다.

우리의 목적상, 향후 연구에 대한 시사점은 자연어 prompt를 통해 신약 개발 task를 학습할 수 있다는 것이다. 만약 신호 밀도가 높은 문서 컨텍스트(예: 온라인 화학 데이터베이스)에서 이러한 관계를 자동으로 학습할 수 있다면, 이러한 task를 수행하기 위한 supervised 데이터셋에 대한 의존도를 줄일 수 있을 것이다. 최종 확인으로, 우리는 Galactica의 attention head를 layer별로 평균화하고, 모델이 SMILES 시퀀스의 어느 부분을 보고 예측을 하는지(atomic attention) 시각화할 수 있다. Figure 16에서 일부 Tox21 예측에 대한 예시를 보여준다.

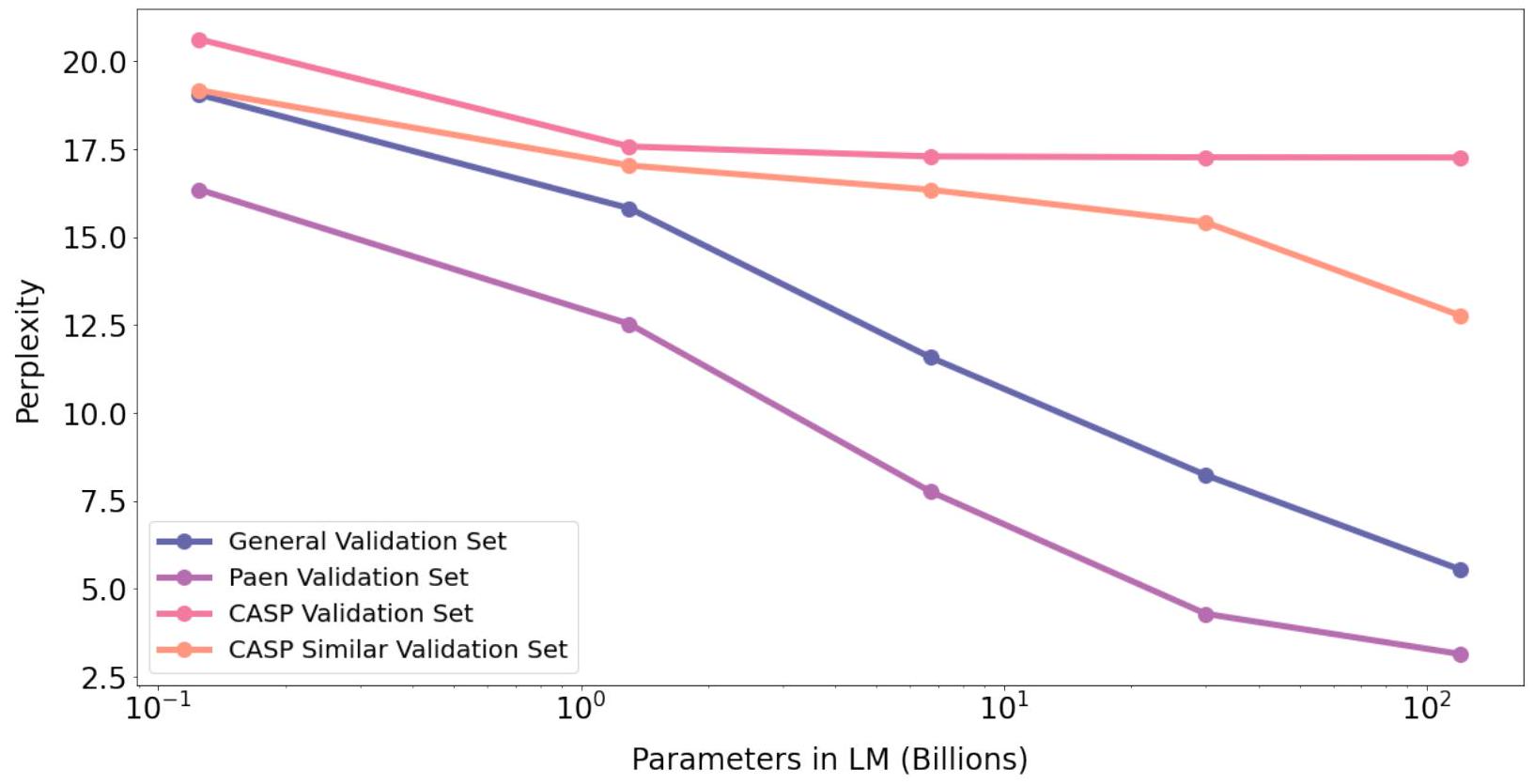

Primary Structure Prediction

Figure 17: Primary Structure Prediction. 세 가지 validation 세트 중 세 가지에서 부드러운 스케일링을 관찰할 수 있으며, 이는 학습 세트의 시퀀스와 높은 시퀀스 유사성을 가질 가능성을 반영한다. 예를 들어, Paen validation 세트의 경우 ortholog가 이에 해당한다. 시퀀스 유사성 제약이 있는 CASP 세트는 성능이 정체되는데, 이는 학습에 사용된 55만 개의 단백질로부터 얻는 이득이 out-of-domain 시퀀스에 대해서는 빠르게 포화됨을 시사한다.

5.7 Biological Understanding

이 섹션에서는 Galactica가 생물학적 양식(biological modalities)과 상호작용하는 능력을 살펴본다. Language model은 이러한 데이터를 자동으로 조직화하는 데 잠재적으로 중요한 역할을 할 수 있으며, 예를 들어 새롭게 시퀀싱된 단백질에 기능적 정보를 주석(annotate)하는 데 활용될 수 있다. 우리는 이 섹션에서 이러한 인터페이스의 잠재력을 탐구한다.

UniProt에서 가져온 단백질 시퀀스의 경우, 우리는 사전학습 데이터에 사용 가능한 시퀀스의 작은 부분집합을 포함시켰다. 구체적으로, 우리는 검토된 Swiss-Prot 단백질을 사용했는데, 이는 전체 2억 2,700만 개 시퀀스 중 **고품질 부분집합(약 50만 개)**에 해당한다. 이는 모델이 자연어 학습에 비해 자연 시퀀스 학습에 지나치게 편향되지 않도록 하기 위함이다. 분자 데이터와 마찬가지로, 이는 향후 연구에서 완화할 수 있는 제약이며, 훨씬 더 큰 코퍼스를 활용할 수 있게 할 것이다. 여기서는 단일 모델이 멀티모달 환경에서 효과적으로 학습할 수 있는지 여부를 조사하는 첫 단계에 중점을 둔다.

우리는 language model이 시퀀스 유사성에 대한 암묵적인 측정 기준을 학습할 수 있으며, 이를 기능 주석(functional annotation) 및 설명과 같은 task에 활용할 수 있음을 발견했다.

5.7.1 Sequence Validation Perplexity

Galactica는 단백질의 3D 구조를 명시적으로 모델링하지 않지만, 특정 conformation에 필요한 정보는 선형 아미노산 서열에 포함되어 있으며, 이는 다시 기능(function)을 결정한다. 첫 단계로, 우리는 단백질 서열 perplexity를 평가하여 상위(upstream) 성능을 테스트한다. 좋은 validation set을 구축하는 것이 중요하며, 이 분야의 연구에서는 데이터 누출(data leakage)이 문제가 된다. 우리는 무엇이 학습되고 무엇이 일반화되는지에 대한 더 높은 확신을 얻기 위해 네 가지 holdout set을 구축한다.

첫째, 우리는 training set의 서열에 대해 BLAST를 수행하고, 51개의 CASP14 target 서열과 50% 이상의 서열 유사도(sequence identity)를 가진 모든 서열을 제거한다. 이들은 ESMFold (Lin et al., 2022b)에서 사용된 것과 동일한 test 서열이다. 이 접근 방식을 사용하여 training set에서 총 167개의 서열을 제거한다. 이 holdout set을 CASPSimilarSeq라고 부른다. 51개의 CASP14 target 서열은 CASPSeq라고 부른다.

둘째, 우리는 유기체 수준(organism-level) holdout을 수행하고, 코끼리, 코끼리땃쥐, 매너티, 아드바크를 포함한 Paenungulata 분류군(clade)의 모든 유기체 서열을 제거한다. 이를 통해 Galactica가 이전에 전혀 보지 못한 유기체에 대한 서열을 주석(annotate)할 수 있는지를 테스트할 수 있다. 이 접근 방식을 사용하여 training set에서 총 109개의 서열을 제거한다. 이 holdout set을 PaenSeq라고 부른다. 이는 어떤 서열 유사도 제약도 강제하지 않으므로, training set에 매우 유사한 서열이 있을 수 있다는 점에 유의해야 한다.

마지막으로, 우리는 5456개의 서열로 구성된 무작위 test split을 수행한다. 여기에는 서열 유사도 제약이 적용되지 않으므로, 암기(memorization)가 더 많이 작용할 수 있지만, 여전히 모델이 흡수한 서열 지식의 폭에 대한 신호를 제공한다. 이 holdout set을 UniProtSeq라고 부른다.

우리는 Table 16에서 모든 holdout set에 대한 perplexity를 평가하고 Figure 17에 플로팅한다. 세 가지 validation set에서는 매끄러운 스케일링(smooth scaling)을 관찰할 수 있는데, 이는 training set의 서열과의 높은 서열 유사성 가능성을 반영한다. 예를 들어, Paen validation set의 경우 orthologs가 이에 해당한다. 흥미롭게도, 서열 유사도 제약이 있는 CASP set은 평탄화(levels off)되는 경향을 보이는데, 이는 학습에 사용된 55만 개의 단백질로부터 얻는 이득이 빠르게 포화됨을 시사한다.

| Protein Sequence Validation Perplexity | |||||

|---|---|---|---|---|---|

| Model | Param (bn) | CASPSeq | CASPSimSeq | PaenSeq | UniProtSeq |

| GAL 125 M | 0.1 | 20.62 | 19.18 | 16.35 | 19.05 |

| GAL 1.3B | 1.3 | 17.58 | 17.04 | 12.53 | 15.82 |

| GAL 6.7B | 6.7 | 17.29 | 16.35 | 7.76 | 11.58 |

| GAL 30B | 30 | 17.27 | 15.42 | 4.28 | 8.23 |

| GAL 120B | 120 | 17.26 | 12.77 | 3.14 | 5.54 |

Table 16: 단백질 Validation Perplexity.

training set과의 잠재적 서열 유사성이 높은 validation set은 제한된 set (CASP validation set)보다 낮은 perplexity를 보인다.

더 자세히 조사하기 위해, 우리는 120B 모델 학습 중 CASPSeq set에 대한 validation perplexity를 살펴보았고, 그 결과를 아래 Figure 18에 플로팅한다.

Figure 18: 학습 중 CASPSeq Validation.

Figure 18: 학습 중 CASPSeq Validation.

학습이 끝나기 전에 overfitting이 발생하지만, 그 효과는 크지 않으며, 단백질 서열을 세 번 반복하는 것이 이 task의 성능을 저해하지 않는다. 최종 120B 모델은 두 번째 마지막 지점이며, 이는 우리가 적용한 **조기 종료(early stopping)**를 반영한다 (이전 섹션 참조).

우리는 네 번째 epoch 시작까지 validation perplexity가 감소하다가, 그 시점에서 이 특정 데이터셋에 대해 모델이 overfitting되는 것을 관찰한다. 이는 Galactica가 test set과 크게 다른 "out-of-domain" 단백질에 대해 성능이 저하되고 있음을 시사할 수 있다. 향후 연구에서는 반복 횟수를 줄이는 것이 바람직할 것이며, 더 일반적으로는 training dataset의 단백질 다양성을 높이는 것이 유익할 것으로 보인다.

Figure 19: 단백질 키워드 예측 (Protein Keyword Prediction).

Figure 19: 단백질 키워드 예측 (Protein Keyword Prediction).

이 테스트는 Galactica가 서열만으로 "cytoplasm"과 같은 단백질 키워드를 예측하는 능력을 평가한다. Paen 및 General 데이터셋의 경우, 이 능력은 모델 규모에 따라 꾸준히 향상된다. CASPSimSeq set의 경우, training set의 서열과의 유사성이 낮기 때문에 스케일링이 더 느리게 진행되고 포화되기 시작한다.

5.7.2 Functional Keyword Prediction

이제 우리는 단백질 서열로부터 자연어로의 특정 번역 능력을 살펴본다. 이는 **단백질 주석(protein annotation)**과 같은 task에 유용할 수 있다. 첫 번째 테스트로, 우리는 Galactica가 서열로부터 추론할 수 있는 UniProt 키워드를 조사한다. 이들의 예시는 다음 페이지의 Figure 20에 나와 있다.

결과는 Table 17에 보고되어 있다. 점수는 모델 규모가 커질수록 holdout 세트 전반에 걸쳐 증가하며, 이는 Galactica가 서열로부터 추론하여 키워드를 학습할 수 있음을 시사한다. 그러나 CASPSimSeq에서는 성능 포화 현상이 나타나는데, 이는 이러한 능력이 학습 세트 내 서열과의 유사성에 얼마나 의존하는지를 보여준다. 이는 Figure 20의 예시에서도 반영된다. 여기서 Galactica는 학습 세트 내에서 최대 91.8%의 서열 유사도를 가진 다른 유기체의 유사 단백질에 대한 지식을 활용하여 주석을 돕는다.

| Protein Keyword Prediction | ||||

|---|---|---|---|---|

| Model | Param (bn) | CASPSimSeq | PaenSeq | UniProtSeq |

| GAL 125 M | 0.1 | 10.5% | 9.3% | 15.2% |

| GAL 1.3B | 1.3 | 17.4% | 26.0% | 21.9% |

| GAL 6.7B | 6.7 | 18.4% | 33.3% | 25.1% |

| GAL 30B | 30 | 22.0% | 42.6% | 40.8% |

| GAL 120B | 120 | 21.9% | 54.5% | 48.7% |

Table 17: 단백질 키워드 예측. 표시된 지표는 점수이다. 성능은 holdout 세트 전반에 걸쳐 모델 규모에 따라 증가한다. CASPSeq는 테스트할 수 있는 UniProt 키워드가 없으므로 포함하지 않았다.

우리는 단백질 서열 내 attention을 시각화하려고 시도했지만, 생물학적으로 해석 가능한 결과(예: 도메인에 대한 attention)는 관찰하지 못했다. 우리의 가설은 Galactica가 예측된 키워드를 연관시키는 데 사용하는 서열 유사성에 대한 암묵적인 측정 방법을 학습했지만, 이것이 attention이 어디에 집중하는지로부터 직접적으로 해석될 수는 없다는 것이다. 이는 기저 원자 구조에 대한 attention 측면에서 결과가 해석 가능했던 화학 분석과는 다르다.

## Sequence

[START_AMINO] MQKSPLERASVISKLFFSWPGPILRKGYRQHLKLSDIYQIPSVDSADNLSEKLERE. . . [END_AMINO]

### Ground-Truth Keywords

ATP-binding, Cell membrane, Chloride, Chloride channel, Endoplasmic reticulum, Endosome, Glycoprotein, Ion channel, Ion transport, Isomerase, Isopeptide bond, Lipoprotein, Membrane, Nucleotide-binding, Nucleus, Palmitate, Phosphoprotein, Reference proteome, Repeat, Transmembrane, Transmembrane helix, Transport, Ubl conjugation

### Galactica 30B Predicted Keywords

ATP-binding, Cell membrane, Chloride, Chloride channel, Endoplasmic reticulum, Endosome, Glycoprotein, Ion channel, Ion transport, Isomerase, Isopeptide bond, Lipoprotein, Membrane, Nucleotide-binding, Nucleus, Palmitate, Phosphoprotein, Reference proteome, Repeat, Transmembrane, Transmembrane helix, Transport, Ubl conjugation

Figure 20: 단백질 키워드 예측. 예시는 PaenSeq holdout 데이터셋의 Q108U0 단백질로, 아프리카 코끼리의 cystic fibrosis transmembrane conductance regulator이다. 학습 세트에서 서열 유사도가 가장 높은 단백질은 말의 cystic fibrosis transmembrane conductance regulator인 Q2QLA3 단백질이며, 서열 유사도는 91.8%이다.

5.7.3 Protein Function Description

다음 테스트에서는 서열로부터 단백질 기능에 대한 자유 형식 설명을 생성하는 것을 살펴본다. 우리는 UniProt 기능 설명과 Galactica가 생성한 설명을 비교한다. 결과는 Table 18에 보고되어 있다. ROUGE-L 점수는 모든 holdout 세트에서 꾸준히 증가한다. Figure 21에서 PaenSeq의 예시를 보여준다. 해당 단백질은 **바위너구리(rock hyrax)의 Cytochrome b 단백질(Q7Y8J5)**이다. 학습 세트에서 유사도 기준으로 가장 가까운 서열은 **피그미 하마(pygmy hippopotamus)의 Cytochrome b 단백질(O03363)**이며, 83%의 서열 유사도를 보인다. 이 경우, 우리는 설명에서 완벽한 예측을 얻는다.

| Protein Function Prediction | ||||

|---|---|---|---|---|

| Model | Param (bn) | CASPSimSeq | PaenSeq | UniProtSeq |

| GAL 125 M | 0.1 | 0.062 | 0.073 | 0.061 |

| GAL 1.3B | 1.3 | 0.069 | 0.084 | 0.079 |

| GAL 6.7B | 6.7 | 0.109 | 0.137 | 0.111 |

| GAL 30B | 30 | 0.137 | 0.196 | 0.186 |

| GAL 120B | 120 | 0.252 | 0.272 | 0.252 |

Table 18: 단백질 기능 예측. 표시된 metric은 ROUGE-L이다. 모델 규모가 커질수록 성능이 향상된다.

키워드 예측 task와 마찬가지로, Galactica는 학습 시 보았던 유사한 서열과 매칭하는 것을 기반으로 학습하고, 이를 사용하여 설명을 형성하는 것으로 보인다. 이는 단백질 서열을 위한 language model이 BLAST 및 MMseqs2 (Altschul et al., 1990; Steinegger and Söding, 2017)와 같은 기존 검색 방법의 유용한 대안으로 기능할 수 있음을 시사한다.

6 Toxicity and Bias

이 섹션에서는 Galactica 모델의 **유해성(toxicity)과 편향(bias)**을 연구한다. 우리는 **고정관념, 유해성, 잘못된 정보(misinformation)**와 관련된 벤치마크를 사용하여 평가하고, 다른 language model들과 결과를 비교한다. 그 결과, Galactica가 기존 language model보다 편향과 유해성이 현저히 낮음을 발견했다.

다음은 시퀀스이다: [START_AMINO] MTNIRKNHPLLKTINDAFIDLPTPSNISTWWNFGSLLGACLIIQVLTGLFLAMHYTSDT . . . [END_AMINO]

### Ground-Truth Description

미토콘드리아 호흡 사슬의 일부인 유비퀴놀-사이토크롬 c 환원효소 복합체(complex III 또는 cytochrome b-c1 complex) 의 구성 요소이다. b-c1 complex는 유비퀴놀(ubiquinol)에서 사이토크롬 c(cytochrome c)로의 전자 전달을 매개한다. 이는 미토콘드리아 막을 가로지르는 양성자 기울기(proton gradient) 생성에 기여하며, 이 양성자 기울기는 ATP 합성에 사용된다.

### Galactica 120B Predicted Description

**유비퀴놀-사이토크롬 c 환원효소 복합체(complex III 또는 cytochrome b-c1 complex)**의 구성 요소로, 미토콘드리아 호흡 사슬의 일부이다. b-c1 complex는 유비퀴놀에서 사이토크롬 c로의 전자 전달을 매개한다. 이는 미토콘드리아 막을 가로지르는 양성자 기울기(proton gradient) 생성에 기여하며, 이 양성자 기울기는 ATP 합성에 사용된다.

Figure 21: 단백질 설명 예측. 예시는 PaenSeq holdout에 있는 Q7Y8J5, 즉 바위너구리(rock hyrax)의 Cytochrome b 단백질이다. 학습 세트에서 서열 유사성(sequence similarity)이 가장 높은 단백질은 피그미 하마(pygmy hippopotamus)의 O03363 단백질(Cytochrome b 단백질)로, 83%의 서열 유사성을 보인다.

6.1 Bias and Stereotypes

다음 평가에서는 Galactica가 유해한 고정관념과 혐오 발언을 탐지(및 생성)하는 능력을 널리 사용되는 네 가지 벤치마크를 사용하여 조사한다.

6.1.1 CrowS-Pairs

| CrowS-Pairs | |||

|---|---|---|---|

| Bias type | text-davinci-002 | OPT 175B | Galactica 120B |

| Race | 64.7 | 68.6 | 59.9 |

| Socioeconomic | 73.8 | 76.2 | 65.7 |

| Gender | 62.6 | 65.7 | 51.9 |

| Disability | 76.7 | 76.7 | 66.7 |

| Nationality | 61.6 | 62.9 | 51.6 |

| Sexual-orientation | 76.2 | 78.6 | 77.4 |

| Physical-appearance | 74.6 | 76.2 | 58.7 |

| Religion | 73.3 | 68.6 | 67.6 |

| Age | 64.4 | 67.8 | 69.0 |

| Overall | 67.2 | 69.5 | 60.5 |

Table 19: CrowS-Pairs 결과. Galactica는 sexual orientation과 age를 제외한 모든 범주에서 현저히 낮은 고정관념 편향을 보인다.

CrowS-Pairs는 1,508쌍의 크라우드소싱된 문장들로 구성되어 있으며, 각 쌍은 "더" 고정관념적인 문장과 "덜" 고정관념적인 문장으로 이루어져 있다 (Nangia et al., 2020). 이 데이터셋은 인종, 종교, 사회경제적 지위, 나이, 장애, 국적, 성적 지향, 신체적 외모, 성별의 아홉 가지 특성을 다룬다. 언어 모델의 고정관념적 내용에 대한 선호도는 "더" 고정관념적인 문장이 선호되는 예시의 비율(log likelihood로 결정됨)을 계산하여 측정된다. 점수가 높을수록 더 해로운 편향을 가진 모델임을 나타내며, 편향이 없는 이상적인 모델은 50%의 점수를 얻을 것이다.

Table 19에서 Galactica와 다른 언어 모델들의 결과를 보고한다. Galactica는 최신 GPT-3 (text-davinci-002) 및 OPT 175B와 비교했을 때, sexual orientation과 age를 제외한 대부분의 범주에서 현저히 낮은 고정관념 편향을 보인다. Galactica는 다른 모델들에 비해 60.5%라는 더 나은 Overall 점수를 달성한다. OPT와 같은 언어 모델은 Pushshift.io Reddit corpus를 주요 데이터 소스로 사용하는데, 이는 모델이 더 차별적인 연관성을 학습하게 만들 가능성이 있다 (Zhang et al., 2022). 반면 Galactica는 고정관념 및 차별적인 텍스트의 발생률이 낮을 것으로 예상되는 과학 코퍼스로 학습되었다.

6.1.2 StereoSet

| StereoSet | ||||

|---|---|---|---|---|

| Category | text-davinci-002 | OPT 175B | Galactica 120 B | |

| Prof. | LMS ( ) | 78.4 | 74.1 | 75.2 |

| SS ( ) | 63.4 | 62.6 | 57.2 | |

| ICAT ( ) | 57.5 | 55.4 | 64.3 | |

| Gend. | LMS ( ) | 75.6 | 74.0 | 74.6 |

| SS ( ) | 66.5 | 63.6 | 59.1 | |

| ICAT ( ) | 50.6 | 53.8 | 61.0 | |

| Reli. | LMS ( ) | 80.8 | 84.0 | 81.4 |

| SS ( ) | 59.0 | 59.0 | 55.1 | |

| ICAT ( ) | 66.3 | 68.9 | 73.1 | |

| Race | LMS ( ) | 77.0 | 74.9 | 74.5 |

| SS ( ) | 57.4 | 56.8 | 54.8 | |

| ICAT ( ) | 65.7 | 64.8 | 67.3 | |

| Overall | LMS ( ) | 77.6 | 74.8 | 75.0 |

| SS ( ) | 60.8 | 59.9 | 56.2 | |

| ICAT ( ) | 60.8 | 60.0 | 65.6 |

Table 20: StereoSet 결과. Galactica는 모든 카테고리에서 ICAT 점수 기준으로 다른 모든 모델을 능가한다.

StereoSet은 직업(profession), 종교(religion), 성별(gender), 인종(race)에 걸쳐 고정관념적 편향(stereotypical biases)을 측정하는 것을 목표로 한다 (Nadeem et al., 2021). 이 벤치마크는 intrasentence task와 intersentence task 두 가지 task로 구성되며, 개발 세트에는 각 task당 약 2,100개의 예시가 포함되어 있다.

- Intrasentence Task: 고정관념과 관련 맥락이 같은 문장 내에 존재한다.

- Intersentence Task: 맥락과 고정관념이 다른 (연속된) 문장 내에 존재한다.

StereoSet의 각 예시에는 고정관념적(stereo-stereotypical) 및 반고정관념적(anti-stereotypical) 문장 변형과 함께 무관한(unrelated) 문장이 포함되어 있다. 이 무관한 문장은 **Language Modelling Score (LMS)**와 **Stereotype Score (SS)**를 측정하는 데 사용된다. 이 두 메트릭은 결합되어 Idealized Context Association Test (ICAT) 점수를 형성하며, 이는 편향 감지(bias detection)와 언어 모델링의 균형 잡힌 측정치이다. 이상적이고 편향 없는 language model은 LMS 100점, SS 50점, ICAT 100점을 기록해야 한다.

우리는 Table 20에 결과를 보고한다. Galactica는 전체 ICAT 점수에서 모든 카테고리에 걸쳐 다른 모델들을 능가한다.

6.1.3 Toxicity

독성(toxicity) 측정을 위해 우리는 Gehman et al. (2020)에서 소개된 RealToxicityPrompts (RTP) 벤치마크를 사용한다. 우리는 Zhang et al. (2022)와 동일한 설정으로, RTP에서 무작위로 샘플링된 5000개의 prompt 각각에 대해 nucleus sampling ()을 사용하여 20개의 token으로 구성된 25개의 생성 결과를 얻는다. 이 prompt들은 시퀀스(즉, continuation)를 생성하는 데 사용되며, 이 시퀀스들은 Perspective API에서 제공하는 독성 분류기(toxicity classifier)에 의해 점수화된다.

Figure 22는 그 결과를 보여준다. 이 차트는 **원래 prompt의 독성 수준(x축)에 따라 분류된, 생성된 continuation의 평균 독성 확률(y축)**을 나타낸다. Galactica는 다른 모델들에 비해 상당히 낮은 독성 비율을 보인다.

6.2 TruthfulQA

TruthfulQA는 언어 모델이 생성한 답변의 진실성(truthfulness)을 측정하는 벤치마크이다 (Lin et al., 2022a). 이 벤치마크는 건강, 법률, 금융 및 기타 범주에 걸쳐 817개의 질문으로 구성되어 있다. 우리는 다른 공개된 언어 모델들과 비교했으며, 그 결과는 Table 21에 보고되어 있다. Galactica는 이 벤치마크에서 다른 언어 모델들의 성능을 능가한다. 그러나 절대적인 성능은 여전히 낮은 수준이다. 우리의 코퍼스가 큐레이션된 특성을 고려할 때, 이는 데이터만으로는 언어 모델이 이 task에서 어려움을 겪는 원인이 아님을 시사한다.

Figure 22: RealToxicityPrompts에서의 독성(toxicity) 비율. Galactica는 원래 prompt의 독성이 증가하더라도 훨씬 낮은 독성 연속(toxicity continuation) 비율을 보인다.

Figure 22: RealToxicityPrompts에서의 독성(toxicity) 비율. Galactica는 원래 prompt의 독성이 증가하더라도 훨씬 낮은 독성 연속(toxicity continuation) 비율을 보인다.

| TruthfulQA | ||

|---|---|---|

| Model | MC1 (Acc) | MC1 (Std) |

| OPT 175B | 0.13 | |

| BLOOM 176B | 0.07 | |

| GAL 125M | 0.11 | |

| GAL 1.3B | 0.15 | |

| GAL 6.7B | 0.03 | |

| GAL 30B | 0.05 | |

| GAL 120B | 0.02 |

Table 21: TruthfulQA 결과. Galactica는 다른 언어 모델들보다 우수한 성능을 보이며, 모델 규모가 커질수록 성능이 향상되지만, 그 속도는 느리고 여전히 낮은 수준에 머물러 있다.

7 Limitations and Future Work

7.1 Limitations

이 섹션에서는 본 연구의 몇 가지 한계점을 다룬다.

코퍼스 한계점 (Corpus Limitations)

우리의 코퍼스는 외부적 요인과 내부적으로 부과된 요인 모두에서 여러 한계점을 가지고 있다. 주요 외부 제약은 오픈 액세스 리소스만 사용하도록 제한되었다는 점이며, 논문이나 교과서와 같은 많은 과학 지식은 오픈 액세스가 아니다. 이러한 비공개 지식 소스에 접근할 수 있다면 성능은 상당히 높아질 것이다. 또한, 우리는 본 연구에서 분자와 단백질의 수를 제한하는 것과 같은 자체적인 제약을 두었다. 이러한 제약이 없다면, 해당 모달리티에 대한 훨씬 더 큰 코퍼스를 통해 상당한 성능 향상을 볼 수 있을 것이다.

코퍼스 효과 vs 프롬프트 효과 (Corpus Effects vs Prompt Effects)

몇몇 벤치마크에서 기존 language model 대비 성능 향상을 보였지만, 사전학습에 포함된 프롬프트의 효과와 핵심 과학 코퍼스의 효과를 명확하게 분리하지는 않았다. 향후 연구에서는 프롬프트 부스팅 없이 과학 코퍼스만으로 일반적인 언어 능력이 가능한지 확인하기 위해 이러한 효과들을 분리할 필요가 있을 것이다.

인용 편향 (Citation Bias)

모델이 규모에 따라 실제 인용 분포에 근접함을 보여주었지만, 120B 규모 모델에서도 인기 있는 논문에 대한 편향이 여전히 남아 있다. 따라서 모델이 실제 운영 환경에서 사용되기 전에 보강(augmentation)이 필요할 것으로 보인다.

프롬프트 사전학습 vs Instruction Tuning (Prompt Pre-Training vs Instruction Tuning)

본 논문에서는 전자를 선택했지만, 이상적으로는 Chung et al. (2022)의 최근 연구와 같이 후자가 무엇을 달성할 수 있는지 탐구해야 할 것이다. 본 연구의 한계점은 이러한 접근 방식들 간의 trade-off를 명확히 하는 ablation을 통해 직접적인 비교를 수행하지 않았다는 점이다.

일반 지식 (General Knowledge)

Galactica는 Wikipedia와 같은 소스를 통해 광범위한 사회적 지식을 흡수한다 (예: 120B 모델은 코타키나발루가 말레이시아 사바주의 주도임을 알고 있다). 그러나 이러한 유형의 지식을 요구하는 task에는 Galactica를 사용하지 않는 것이 좋다. 이는 의도된 사용 사례가 아니기 때문이다.

텍스트를 모달리티로 (Text as a Modality)

텍스트 기반 Transformer가 과학 현상의 텍스트 표현에서 놀랍도록 강력하다는 것을 보여주었지만, "텍스트가 전부"라는 해석에 대해서는 주의를 당부한다. 예를 들어, 화학에서 기하학은 의미를 결정하는 근본적인 언어이지만, Galactica는 기하학에 대한 개념이 없다 (예: 원자의 3D 좌표).

7.2 Future Work

기반 모델 개발을 위해, 우리는 추구할 가치가 있는 몇 가지 방향을 강조하고자 한다.

새로운 Objective Function

최근 U-PaLM이 보여주었듯이 (Tay et al., 2022b; Chung et al., 2022), mixture-of-denoising 학습을 통해 추가적인 성능 향상을 얻을 수 있을 것으로 예상된다. 우리는 이 방식이 left-to-right LM objective가 상당히 제한적인 단백질 시퀀스와 같은 과학적 modality에 유익할 수 있다고 생각한다.

더 큰 Context Window

본 연구에서는 최대 2048 토큰의 context window 길이를 사용한다. 이를 확장하는 것은 교과서와 같은 긴 형식의 과학 문서뿐만 아니라 더 긴 modality 시퀀스(예: 긴 단백질 시퀀스)의 이해에도 유익할 것으로 예상된다.

이미지로 확장

이미지를 포착하지 않고서는 과학적 지식을 적절하게 포착할 수 없다. 이는 자연스러운 후속 프로젝트이지만, 잘 작동하도록 하기 위해서는 일부 아키텍처 수정이 필요할 것이다. Alayrac et al. (2022)와 같은 기존 연구는 LLM을 이 modality로 확장하는 방법을 보여주었다.

더 많은 <work> 예시

우리는 <work>가 범용적인 추론 토큰이 될 수 있다고 생각하며, prompt 다양성 증가 및 더 많은 벤치마크에서의 성능 탐색을 포함하여 이 방향에 더 많은 투자를 하고 싶다.

검증 (Verification)

언어 모델이 규모에 따라 더욱 정확해지더라도, 우리는 생성된 내용이 정확하고 사실적인지 확인해야 한다. 이 검증 계층을 개발하는 것은 과학적 응용 분야를 넘어 일반적인 언어 모델의 실제 응용 분야에 매우 중요하다.

지속 학습 (Continual Learning)

새로운 과학적 지식을 통합하기 위해 처음부터 다시 학습해야 할까, 아니면 이전 checkpoint에서 학습해야 할까? 이는 미해결 질문이며, 모델에 새로운 지식을 통합하는 최상의 절차를 찾기 위한 추가 연구가 필요하다.

검색 증강 (Retrieval Augmentation)

우리는 대규모 언어 모델이 방대한 과학적 지식을 어떻게 흡수할 수 있는지 보여주었지만, 검색은 세분화된 유형의 지식에 적합한 위치를 차지하며, 우리는 이것이 Transformer의 유연한 가중치 메모리를 보완하기 위해 추구할 강력한 방향이라고 믿는다.

8 Discussion and Conclusion

반세기 이상 동안, 과학 지식에 접근하는 지배적인 방식은 저장-검색(store-and-retrieve) 패러다임이었다. 이 접근 방식의 한계는 정보의 추론, 결합 및 조직화가 여전히 인간의 노력에 의존한다는 점이다. 이는 심각한 지식 처리량 병목 현상으로 이어졌다. 본 연구에서 우리는 language model이 이러한 패러다임을 어떻게 변화시키고, 인류가 지식과 상호작용하는 새로운 인터페이스를 제공할 수 있는지를 탐구했다.

우리는 language model이 LaTeX 방정식이나 화학 반응과 같은 기술 지식을 놀랍도록 잘 흡수하며, 이러한 능력은 모델 크기에 따라 원활하게 확장되는 경향이 있음을 보여주었다. Language model의 context-associative 능력은 장기적으로 검색 엔진에 비해 상당한 이점을 제공할 가능성이 높다. 우리는 이를 인용 예측(citation prediction) task에서 입증했는데, 이 task에서 language model은 튜닝된 sparse 및 dense retrieval 파이프라인보다 더 우수한 성능을 보였다. Language model은 앞으로 몇 년 안에 문헌 및 과학 지식 체계를 탐색하는 데 귀중한 새로운 도구를 제공할 것으로 예상된다.

우리는 또한 language model이 큐레이션된 지식 베이스를 구성하여 지식 집약적인 질문 답변 task에서 좋은 성능을 발휘할 수 있음을 입증했다. 여기에는 단계별 추론 방식으로 지식을 구성하는 능력이 포함된다. 우리는 working memory token 접근 방식을 통해 수학 MMLU 및 MATH 벤치마크에서 기존 방법보다 강력한 성능을 달성할 수 있음을 보여주었다. 우리는 MATH와 같은 task가 원칙적으로 language model 접근 방식으로 해결 가능하다고 생각한다. 현재의 병목 현상은 고품질의 단계별 데이터셋의 가용성이다. 그러나 language model은 적응형 연산을 지원하는 아키텍처적 변화가 있기 전까지는 인간처럼 이러한 task를 수행하지 못할 것이다.

우리는 또한 LLM이 과학적 양식(scientific modalities)과 자연어 사이의 다리 역할을 할 잠재력에 대한 초기 조사를 수행했다. 우리는 Galactica가 self-supervision을 통해 IUPAC 명명법과 같은 task를 학습할 수 있음을 보여주었다. 또한 MoleculeNet과 같은 신약 발견 task를 자연어 prompt로 구성하고 직접적인 fine-tuning 없이도 강력한 결과를 달성하는 것이 가능함을 보여주었다. 마지막으로, 우리는 자동 단백질 주석(automatic protein annotation)과 같은 task의 잠재력을 보여주었다. 종합적으로, 자연어와 자연 시퀀스 사이를 연결하는 데이터셋의 수(및 크기)를 늘리는 것은 성능을 더욱 향상시킬 가능성이 높다.

종합해 볼 때, 우리는 language model이 현재 인간의 전문 분야인 지식 task를 수행할 강력한 잠재력을 가지고 있다고 생각한다. 우리는 다른 사람들이 우리의 작업을 기반으로 구축할 수 있도록 모델을 오픈 소스로 공개하며, 오픈 머신러닝 커뮤니티가 이를 어떻게 확장할지 기대한다.