GPT-3: Language Models are Few-Shot Learners

GPT-3는 1750억 개의 파라미터를 가진 autoregressive language model로, 대규모 언어 모델의 스케일링이 task-agnostic few-shot 성능을 크게 향상시킴을 보여줍니다. 이 모델은 별도의 gradient 업데이트나 fine-tuning 없이, 오직 텍스트 상호작용을 통해 few-shot demonstrations 만으로 다양한 NLP 태스크(번역, 질의응답, 문장 완성 등)에서 강력한 성능을 달성합니다. 특히, GPT-3는 실시간 추론이나 도메인 적응이 필요한 새로운 태스크에서도 뛰어난 능력을 보이며, 인간이 작성한 기사와 구별하기 어려운 수준의 텍스트를 생성할 수 있습니다. 논문 제목: Language Models are Few-Shot Learners

논문 요약: GPT-3: Language Models are Few-Shot Learners

- 논문 링크: NeurIPS 2020 (Advances in Neural Information Processing Systems 33 (2020): 1877-1901)

- 저자: Tom B. Brown 외 다수 (OpenAI)

- 발표 시기: 2020년, NeurIPS

- 주요 키워드: Large Language Model, Few-shot Learning, NLP

1. 연구 배경 및 문제 정의

- 문제 정의:

기존 NLP 시스템은 대규모 텍스트 코퍼스에서 사전학습된 후에도 특정 태스크에 대해 수천 또는 수만 개의 예시로 구성된 태스크별 파인튜닝 데이터셋을 필요로 한다. 이는 새로운 태스크에 대한 적용 가능성을 제한하고, 학습 데이터 내의 허위 상관관계를 악용할 가능성을 높이며, 인간이 단 몇 개의 예시나 간단한 지시만으로 새로운 언어 태스크를 수행하는 능력(적응성 및 유동성)과 큰 차이를 보인다. - 기존 접근 방식:

기존 연구는 사전학습된 언어 표현(pre-trained language representations)을 활용한 후 태스크별 파인튜닝을 수행하여 성능을 향상시켰다. GPT-2와 같은 모델은 "in-context learning"을 통해 자연어 지시 및 소수의 데모를 활용하는 메타 학습을 시도했지만, 파인튜닝 방식에 비해 성능이 현저히 낮았다.

2. 주요 기여 및 제안 방법

- 논문의 주요 기여:

- 언어 모델의 규모를 확장하는 것이 태스크 불가지론적(task-agnostic) 퓨샷(few-shot) 성능을 크게 향상시키며, 때로는 기존 SOTA 파인튜닝 접근 방식과도 경쟁할 만한 수준에 도달함을 입증했다.

- 1,750억 개의 파라미터를 가진 자기회귀(autoregressive) 언어 모델인 GPT-3를 학습시켰으며, 이는 이전의 어떤 비희소(non-sparse) 언어 모델보다 10배 더 큰 규모이다.

- GPT-3를 20개 이상의 NLP 데이터셋과 새로운 합성 태스크에 대해 그라디언트 업데이트나 파인튜닝 없이 제로샷(zero-shot), 원샷(one-shot), 퓨샷(few-shot) 설정에서 평가하여 강력한 성능을 보여주었다.

- GPT-3가 인간이 작성한 기사와 구별하기 어려운 수준의 합성 뉴스 기사를 생성할 수 있음을 정성적으로 입증했다.

- 대규모 언어 모델 학습 시 발생하는 테스트 데이터 오염(data contamination) 문제를 체계적으로 측정하고 분석하는 방법론을 제시했다.

- 제안 방법:

GPT-3는 GPT-2와 동일한 모델 및 아키텍처(수정된 초기화, 사전 정규화, 가역 토큰화)를 사용하며, Transformer 레이어에서 dense attention과 locally banded sparse attention 패턴을 번갈아 사용한다. 학습 데이터셋은 필터링 및 퍼지 중복 제거된 Common Crawl, WebText2, Books1, Books2, Wikipedia 등 총 3천억 개의 토큰으로 구성되었다. 평가 시에는 모델의 가중치를 업데이트하지 않고, 태스크 설명과 함께 컨텍스트 윈도우(2048 토큰) 내에 1개(원샷) 또는 10~100개(퓨샷)의 데모 예시를 제공하여 모델이 다음 내용을 예측하도록 하는 "in-context learning" 방식을 사용한다.

3. 실험 결과

- 데이터셋:

Penn Tree Bank (PTB), LAMBADA, HellaSwag, StoryCloze (언어 모델링 및 완성), Natural Questions, WebQuestions, TriviaQA (폐쇄형 질문 응답), WMT'14 Fr En, WMT'16 De En, WMT'16 Ro En (번역), Winograd Schemas Challenge, Winogrande (Winograd 스타일), PIQA, ARC, OpenBookQA (상식 추론), CoQA, DROP, QuAC, SQuADv2, RACE (독해), SuperGLUE 벤치마크 스위트 (BoolQ, CB, COPA, RTE, WiC, WSC, MultiRC, ReCoRD), ANLI (자연어 추론), 산술 연산, 단어 재배열, SAT 유추, 뉴스 기사 생성, 새로운 단어 사용, 영어 문법 교정 등 다양한 NLP 태스크 및 합성 태스크. 모든 모델은 Microsoft의 고대역폭 클러스터에 있는 V100 GPU에서 학습되었다. - 주요 결과:

- 전반적인 성능 확장: 모델 크기가 커질수록 제로샷, 원샷, 퓨샷 설정 모두에서 성능이 꾸준히 향상되었으며, 특히 퓨샷 학습의 이점이 커졌다.

- SOTA 달성 및 근접: PTB 언어 모델링에서 새로운 SOTA를 달성했으며, LAMBADA, TriviaQA (퓨샷), PIQA (퓨샷) 등 여러 태스크에서 기존 SOTA를 능가하거나 근접한 성능을 보였다. 특히 TriviaQA 퓨샷 결과는 오픈 도메인 파인튜닝 SOTA와 일치하거나 능가했다.

- 인간 수준의 텍스트 생성: GPT-3가 생성한 약 200~500단어 길이의 뉴스 기사는 인간 평가자들이 약 52%의 정확도로만 기계 생성임을 식별할 수 있어, 거의 인간이 작성한 것과 구별하기 어려운 수준임을 입증했다.

- 새로운 능력 발현: 산술 연산(2자리 덧셈 100%, 3자리 덧셈 80.4% 퓨샷), 단어 재배열, SAT 유추(65.2% 퓨샷, 대학 지원자 평균과 유사) 등 학습 데이터에 명시적으로 존재하지 않았을 수 있는 태스크에서도 상당한 능력을 보여주었다.

- 한계점: ANLI, WiC와 같이 두 문장 간의 비교를 요구하는 자연어 추론 태스크나 일부 독해 태스크에서는 퓨샷 설정에서도 무작위 수준보다 크게 나은 성능을 보이지 못하는 약점을 드러냈다.

4. 개인적인 생각 및 응용 가능성

- 장점:

GPT-3는 파인튜닝 없이도 대규모 모델의 스케일링이 태스크 불가지론적 퓨샷 학습 능력을 극적으로 향상시킬 수 있음을 보여주며, 이는 범용 AI 시스템 개발의 중요한 이정표이다. 특히 인간과 구별하기 어려운 수준의 텍스트 생성 능력과 명시적인 학습 없이도 산술, 유추 등 다양한 태스크에서 emergent 능력을 보이는 점이 인상 깊다. 이는 미래의 AI가 훨씬 적은 데이터로도 새로운 태스크에 빠르게 적응할 수 있음을 시사한다. - 단점/한계:

여전히 문서 수준의 일관성 부족, 비논리적 문장 생성, 특정 추론(예: 상식적인 물리) 및 비교 태스크에서의 약점을 보인다. 또한, 학습 데이터에 내재된 성별, 인종, 종교 등 다양한 편향을 그대로 반영하여 고정관념적이거나 편견에 찬 콘텐츠를 생성할 수 있다는 윤리적 문제가 크다. 모델 학습 및 추론 비용이 매우 높다는 점도 실용적인 한계이다. - 응용 가능성:

고품질 콘텐츠 생성(뉴스 기사, 마케팅 문구, 창작물), 지능형 비서 및 챗봇의 자연어 이해 및 생성 능력 향상, 문법 교정 및 글쓰기 지원 도구, 교육 분야에서의 맞춤형 학습 자료 및 문제 생성, 그리고 새로운 도메인에 대한 빠른 적응을 통한 데이터 수집 비용 절감 등 광범위한 분야에 적용될 수 있다.

Brown, Tom, et al. "Language models are few-shot learners." Advances in neural information processing systems 33 (2020): 1877-1901.

Language Models are Few-Shot Learners

Tom B. Brown* Benjamin Mann* Nick Ryder* Melanie Subbiah* Jared Kaplan Prafulla Dhariwal Arvind Neelakantan Pranav Shyam Girish Sastry Amanda Askell Sandhini Agarwal Ariel Herbert-Voss Gretchen Krueger Tom Henighan Rewon Child Aditya Ramesh Daniel M. Ziegler Jeffrey Wu Clemens Winter Christopher Hesse Mark Chen Eric Sigler Mateusz Litwin Scott Gray Benjamin Chess Jack Clark Christopher Berner Sam McCandlish Alec Radford Ilya Sutskever Dario Amodei

OpenAI

Abstract

최근 연구들은 대규모 텍스트 코퍼스에서 사전학습(pre-training)한 후 특정 task에 대해 fine-tuning하는 방식으로 많은 NLP task 및 벤치마크에서 상당한 성능 향상을 보여주었다. 이러한 방법은 일반적으로 아키텍처는 task-agnostic하지만, 여전히 수천 또는 수만 개의 예시로 구성된 task-specific fine-tuning 데이터셋을 필요로 한다. 대조적으로, 인간은 일반적으로 단 몇 개의 예시나 간단한 지시만으로 새로운 언어 task를 수행할 수 있는데, 이는 현재 NLP 시스템이 여전히 크게 어려움을 겪는 부분이다.

본 논문에서는 언어 모델의 규모를 확장하는 것이 task-agnostic한 few-shot 성능을 크게 향상시키며, 때로는 기존 state-of-the-art fine-tuning 접근 방식과도 경쟁할 만한 수준에 도달함을 보여준다. 구체적으로, 우리는 1,750억 개의 파라미터를 가진 autoregressive language model인 GPT-3를 학습시켰는데, 이는 이전의 어떤 non-sparse language model보다 10배 더 많은 규모이다. 그리고 이 모델의 성능을 few-shot setting에서 테스트하였다.

모든 task에서 GPT-3는 어떠한 gradient 업데이트나 fine-tuning 없이 적용되었으며, task와 few-shot demonstration은 모델과의 텍스트 상호작용을 통해서만 지정되었다. GPT-3는 번역, 질문-응답, cloze task를 포함한 많은 NLP 데이터셋에서 강력한 성능을 달성했으며, 단어 재배열, 문장에서 새로운 단어 사용, 3자리 산술 연산 수행과 같이 즉석 추론(on-the-fly reasoning)이나 도메인 적응(domain adaptation)을 요구하는 여러 task에서도 좋은 성능을 보였다.

동시에, 우리는 GPT-3의 few-shot learning이 여전히 어려움을 겪는 일부 데이터셋과, 대규모 웹 코퍼스 학습과 관련된 방법론적 문제에 직면하는 일부 데이터셋도 식별하였다. 마지막으로, 우리는 GPT-3가 생성한 뉴스 기사 샘플을 인간 평가자들이 인간이 작성한 기사와 구별하기 어려워한다는 것을 발견했다. 우리는 이러한 발견과 GPT-3 전반의 광범위한 사회적 영향에 대해 논의한다.

Contents

1 서론 ..... 3 2 접근 방식 (Approach) ..... 6 2.1 모델 및 아키텍처 (Model and Architectures) ..... 8 2.2 학습 데이터셋 (Training Dataset) ..... 8 2.3 학습 과정 (Training Process) ..... 9 2.4 평가 (Evaluation) ..... 10 3 결과 (Results) ..... 10 3.1 Language Modeling, Cloze, 및 Completion Task ..... 11 3.2 Closed Book Question Answering ..... 13 3.3 번역 (Translation) ..... 14 3.4 Winograd-Style Task ..... 16 3.5 상식 추론 (Common Sense Reasoning) ..... 17 3.6 독해 (Reading Comprehension) ..... 18 3.7 SuperGLUE ..... 18 3.8 NLI ..... 20 3.9 합성 및 정성적 Task (Synthetic and Qualitative Tasks) ..... 21 4 벤치마크 암기 측정 및 방지 (Measuring and Preventing Memorization Of Benchmarks) ..... 29 5 한계점 (Limitations) ..... 33 6 광범위한 영향 (Broader Impacts) ..... 34 6.1 Language Model의 오용 (Misuse of Language Models) ..... 35 6.2 공정성, 편향, 및 표현 (Fairness, Bias, and Representation) ..... 36 6.3 에너지 사용량 (Energy Usage) ..... 39 7 관련 연구 (Related Work) ..... 39 8 결론 (Conclusion) ..... 40 A Common Crawl 필터링 세부 정보 (Details of Common Crawl Filtering) ..... 43 B 모델 학습 세부 정보 (Details of Model Training) ..... 43 C 테스트 세트 오염 연구 세부 정보 (Details of Test Set Contamination Studies) ..... 43 D Language Model 학습에 사용된 총 연산량 (Total Compute Used to Train Language Models) ..... 46 E 합성 뉴스 기사의 인간 품질 평가 (Human Quality Assessment of Synthetic News Articles) ..... 46 F GPT-3의 추가 샘플 (Additional Samples from GPT-3) ..... 48 G Task 문구 및 사양 세부 정보 (Details of Task Phrasing and Specifications) ..... 50 H 모든 모델 크기에 대한 모든 Task 결과 (Results on All Tasks for All Model Sizes) ..... 63

1 Introduction

최근 몇 년간 NLP 시스템에서는 **사전학습된 언어 표현(pre-trained language representations)**을 활용하는 경향이 두드러졌으며, 이는 점점 더 유연하고 task-agnostic한 방식으로 다운스트림 전이에 적용되고 있다.

초기에는 단일 레이어 표현이 word vector [MCCD13, PSM14]를 사용하여 학습되었고, 이는 task-specific 아키텍처에 입력되었다.

이후에는 다중 레이어 표현과 contextual state를 가진 RNN이 더 강력한 표현을 형성하는 데 사용되었다 [DL15, MBXS17, PNZtY18] (여전히 task-specific 아키텍처에 적용되었지만).

그리고 최근에는 사전학습된 recurrent 또는 Transformer language model [VSP17]이 직접 fine-tuning되어, task-specific 아키텍처의 필요성을 완전히 제거하였다 [RNSS18, DCLT18, HR18].

이러한 마지막 패러다임은 독해(reading comprehension), 질문 응답(question answering), 텍스트 함의(textual entailment) 등 많은 도전적인 NLP task에서 상당한 발전을 가져왔으며, 새로운 아키텍처와 알고리즘을 기반으로 계속 발전하고 있다 [RSR19, LOG19, YDY19, LCG19].

그러나 이 접근 방식의 주요 한계는 아키텍처가 task-agnostic함에도 불구하고, 여전히 task-specific 데이터셋과 task-specific fine-tuning이 필요하다는 점이다. 즉, 원하는 task에서 강력한 성능을 달성하려면 일반적으로 해당 task에 특화된 수천에서 수십만 개의 예시로 구성된 데이터셋에 대한 fine-tuning이 필요하다. 이러한 한계를 제거하는 것은 여러 가지 이유로 바람직하다.

첫째, 실용적인 관점에서, 새로운 task마다 대규모의 labeled example 데이터셋이 필요하다는 점은 언어 모델의 적용 가능성을 제한한다. 문법 교정부터 추상적인 개념의 예시 생성, 단편 소설 비평에 이르기까지 매우 광범위하고 유용한 언어 task들이 존재한다. 이들 중 상당수는 대규모 supervised training dataset을 수집하기 어렵고, 특히 새로운 task마다 이 과정을 반복해야 할 때 더욱 그러하다.

둘째, 학습 데이터 내의 spurious correlation을 악용할 가능성은 모델의 표현력과 학습 분포의 협소함에 따라 근본적으로 증가한다. 이는 사전학습(pre-training)과 fine-tuning 패러다임에 문제를 야기할 수 있다. 이 패러다임에서는 모델이 사전학습 동안 정보를 흡수하기 위해 크게 설계되지만, 이후 매우 협소한 task 분포에 대해 fine-tuning된다. 예를 들어 [HLW20]는 더 큰 모델이 out-of-distribution 상황에서 반드시 더 잘 일반화되는 것은 아님을 관찰했다. 이 패러다임에서 달성되는 일반화가 모델이 학습 분포에 지나치게 특화되어 외부로 잘 일반화되지 못하기 때문에 좋지 않을 수 있다는 증거가 있다 [YdC19, MPL19]. 따라서 fine-tuned 모델의 특정 벤치마크에서의 성능은, 비록 명목상 인간 수준일지라도, 실제 underlying task에서의 성능을 과장할 수 있다 [GSL18, NK19].

셋째, 인간은 대부분의 언어 task를 학습하기 위해 대규모 supervised dataset을 필요로 하지 않는다. 자연어로 된 짧은 지시(예: "이 문장이 행복한 것을 묘사하는지 슬픈 것을 묘사하는지 알려주세요") 또는 아주 적은 수의 demonstration(예: "여기 용감하게 행동하는 사람들의 두 가지 예시가 있습니다; 세 번째 용감한 행동의 예시를 들어주세요")만으로도 인간이 새로운 task를 최소한 합리적인 수준의 능력으로 수행하는 데 충분한 경우가 많다. 현재 NLP 기술의 개념적 한계를 지적하는 것 외에도, 이러한 적응성은 실용적인 이점을 가진다. 예를 들어, 인간은 긴 대화 중에 덧셈을 수행하는 것처럼 많은 task와 기술을 원활하게 혼합하거나 전환할 수 있다. 광범위하게 유용하기 위해서는 언젠가 우리의 NLP 시스템도 이러한 유동성과 일반성을 갖추기를 바란다.

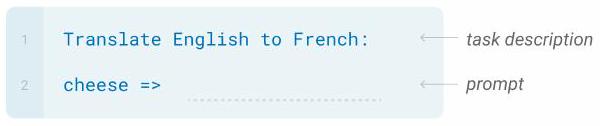

Figure 1.1: 언어 모델 메타 학습. 비지도 사전 학습 동안, 언어 모델은 광범위한 기술과 패턴 인식 능력을 개발한다. 그런 다음 추론 시 이러한 능력을 사용하여 원하는 task에 빠르게 적응하거나 인식한다. 우리는 이 과정의 내부 루프를 "in-context learning"이라고 부르며, 이는 각 시퀀스에 대한 forward-pass 내에서 발생한다. 이 다이어그램의 시퀀스는 모델이 사전 학습 동안 볼 데이터를 대표하기 위한 것이 아니라, 단일 시퀀스 내에 때때로 반복되는 하위 task가 포함될 수 있음을 보여주기 위한 것이다.

Figure 1.1: 언어 모델 메타 학습. 비지도 사전 학습 동안, 언어 모델은 광범위한 기술과 패턴 인식 능력을 개발한다. 그런 다음 추론 시 이러한 능력을 사용하여 원하는 task에 빠르게 적응하거나 인식한다. 우리는 이 과정의 내부 루프를 "in-context learning"이라고 부르며, 이는 각 시퀀스에 대한 forward-pass 내에서 발생한다. 이 다이어그램의 시퀀스는 모델이 사전 학습 동안 볼 데이터를 대표하기 위한 것이 아니라, 단일 시퀀스 내에 때때로 반복되는 하위 task가 포함될 수 있음을 보여주기 위한 것이다.

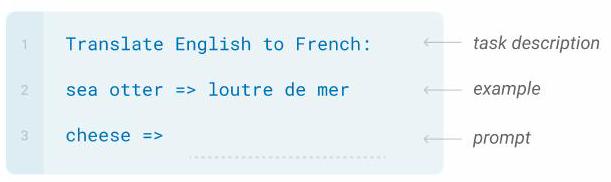

Figure 1.2: 더 큰 모델은 in-context 정보를 점점 더 효율적으로 사용한다. 우리는 모델이 단어에서 무작위 기호를 제거하도록 요구하는 간단한 task에 대한 in-context learning 성능을 자연어 task 설명 유무에 따라 보여준다 (Sec. 3.9.2 참조). 대규모 모델의 더 가파른 "in-context learning 곡선"은 contextual 정보로부터 task를 학습하는 능력이 향상되었음을 보여준다. 우리는 광범위한 task에서 질적으로 유사한 행동을 관찰한다.

Figure 1.2: 더 큰 모델은 in-context 정보를 점점 더 효율적으로 사용한다. 우리는 모델이 단어에서 무작위 기호를 제거하도록 요구하는 간단한 task에 대한 in-context learning 성능을 자연어 task 설명 유무에 따라 보여준다 (Sec. 3.9.2 참조). 대규모 모델의 더 가파른 "in-context learning 곡선"은 contextual 정보로부터 task를 학습하는 능력이 향상되었음을 보여준다. 우리는 광범위한 task에서 질적으로 유사한 행동을 관찰한다.

이러한 문제들을 해결하기 위한 한 가지 잠재적인 방법은 **메타 학습(meta-learning)**이다. 언어 모델의 맥락에서 메타 학습은 모델이 학습 시점에 광범위한 기술과 패턴 인식 능력을 개발하고, 추론 시점에 이러한 능력을 사용하여 원하는 task에 빠르게 적응하거나 인식하는 것을 의미한다 (Figure 1.1 참조). 최근 연구 [RWC19]는 우리가 "in-context learning"이라고 부르는 방식을 통해 이를 시도한다. 이는 사전학습된 언어 모델의 텍스트 입력을 task 명세의 한 형태로 사용하는 것이다. 즉, 모델은 자연어 지시 및/또는 task의 몇 가지 demonstration에 조건화되고, 단순히 다음에 올 것을 예측함으로써 task의 추가 인스턴스를 완료하도록 기대된다.

이 접근 방식은 초기에는 어느 정도 가능성을 보였지만, 여전히 fine-tuning에 비해 훨씬 낮은 결과를 달성한다. 예를 들어 [RWC19]는 Natural Questions에서 단 4%의 성능을 달성했으며, CoQa에서 55 F1이라는 결과조차 현재 state-of-the-art에 비해 35점 이상 뒤처진다. 메타 학습이 언어 task를 해결하는 실용적인 방법으로 자리 잡기 위해서는 분명 상당한 개선이 필요하다.

언어 모델링의 또 다른 최근 경향은 앞으로 나아갈 길을 제시할 수 있다. 최근 몇 년간 Transformer language model의 용량은 크게 증가하여, 1억 개 [RNSS18]에서 3억 개 [DCLT18], 15억 개 [RWC19], 80억 개 [SPP19], 110억 개 [RSR19], 그리고 마침내 170억 개 [Tur20]의 파라미터에 이르렀다. 각 증가는 텍스트 합성 및/또는 다운스트림 NLP task에서 개선을 가져왔으며, 많은 다운스트림 task와 잘 상관관계가 있는 log loss가 규모에 따라 부드러운 개선 추세를 따른다는 증거가 있다 [KMH20]. in-context learning은 모델의 파라미터 내에 많은 기술과 task를 흡수하는 것을 포함하므로, in-context learning 능력도 규모에 따라 유사하게 강력한 이득을 보일 수 있다는 것이 타당하다.

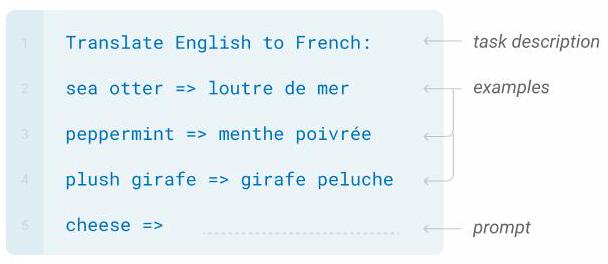

Figure 1.3: 42개 정확도 기반 벤치마크의 총체적 성능. zero-shot 성능은 모델 크기에 따라 꾸준히 향상되는 반면, few-shot 성능은 더 빠르게 증가하여, 더 큰 모델이 in-context learning에 더 능숙함을 보여준다. 표준 NLP 벤치마크 스위트인 SuperGLUE에 대한 더 자세한 분석은 Figure 3.8을 참조하라.

Figure 1.3: 42개 정확도 기반 벤치마크의 총체적 성능. zero-shot 성능은 모델 크기에 따라 꾸준히 향상되는 반면, few-shot 성능은 더 빠르게 증가하여, 더 큰 모델이 in-context learning에 더 능숙함을 보여준다. 표준 NLP 벤치마크 스위트인 SuperGLUE에 대한 더 자세한 분석은 Figure 3.8을 참조하라.

본 논문에서는 GPT-3라고 명명한 1,750억 개의 파라미터를 가진 autoregressive language model을 학습하고, 그 in-context learning 능력을 측정함으로써 이 가설을 검증한다. 구체적으로, 우리는 20개 이상의 NLP 데이터셋과 학습 세트에 직접 포함될 가능성이 낮은 task에 대한 빠른 적응을 테스트하기 위해 설계된 몇 가지 새로운 task에 대해 GPT-3를 평가한다. 각 task에 대해 GPT-3를 3가지 조건에서 평가한다: (a) "few-shot learning" 또는 in-context learning으로, 모델의 context window에 들어갈 수 있는 만큼의 demonstration을 허용한다 (일반적으로 10~100개). (b) "one-shot learning"으로, 단 하나의 demonstration만 허용한다. (c) "zero-shot learning"으로, demonstration은 전혀 허용되지 않고 모델에 자연어 지시만 주어진다. GPT-3는 원칙적으로 전통적인 fine-tuning 설정에서도 평가될 수 있지만, 이는 향후 연구로 남겨둔다.

Figure 1.2는 우리가 연구하는 조건들을 보여주며, 모델이 단어에서 불필요한 기호를 제거하도록 요구하는 간단한 task의 few-shot learning을 보여준다. 모델 성능은 자연어 task 설명의 추가와 모델 context 내 예시 수 의 증가에 따라 향상된다. Few-shot learning은 모델 크기에 따라 극적으로 향상되기도 한다. 이 경우의 결과는 특히 인상적이지만, 모델 크기와 in-context 예시 수에 따른 일반적인 경향은 우리가 연구하는 대부분의 task에서 유지된다. 우리는 이러한 "학습" 곡선이 gradient 업데이트나 fine-tuning을 포함하지 않으며, 단지 conditioning으로 주어지는 demonstration의 수가 증가하는 것임을 강조한다.

전반적으로, NLP task에서 GPT-3는 zero-shot 및 one-shot 설정에서 유망한 결과를 달성하며, few-shot 설정에서는 때때로 state-of-the-art와 경쟁하거나 심지어 능가하기도 한다 (state-of-the-art가 fine-tuned 모델에 의해 유지됨에도 불구하고). 예를 들어, GPT-3는 CoQA에서 zero-shot 설정에서 81.5 F1, one-shot 설정에서 84.0 F1, few-shot 설정에서 85.0 F1을 달성한다. 유사하게, GPT-3는 TriviaQA에서 zero-shot 설정에서 64.3% 정확도, one-shot 설정에서 68.0%, few-shot 설정에서 71.2%를 달성하며, 후자는 동일한 closed-book 설정에서 작동하는 fine-tuned 모델에 비해 state-of-the-art이다.

GPT-3는 또한 빠른 적응 또는 즉석 추론을 테스트하기 위해 설계된 task에서 one-shot 및 few-shot 숙련도를 보여준다. 여기에는 단어 뒤섞기, 산술 연산 수행, 그리고 한 번만 정의된 새로운 단어를 문장에서 사용하는 것이 포함된다. 우리는 또한 few-shot 설정에서 GPT-3가 인간 평가자가 인간이 생성한 기사와 구별하기 어려운 합성 뉴스 기사를 생성할 수 있음을 보여준다.

동시에, 우리는 GPT-3 규모에서도 few-shot 성능이 어려움을 겪는 몇 가지 task를 발견한다. 여기에는 ANLI 데이터셋과 같은 자연어 추론 task, 그리고 RACE 또는 QuAC와 같은 일부 독해 데이터셋이 포함된다. 이러한 한계를 포함하여 GPT-3의 강점과 약점에 대한 광범위한 특성화를 제시함으로써, 우리는 언어 모델의 few-shot learning 연구를 촉진하고 가장 진전이 필요한 부분에 주의를 환기시키고자 한다. 전반적인 결과에 대한 경험적 감각은 Figure 1.3에서 볼 수 있으며, 이는 다양한 task를 집계한 것이다 (그러나 그 자체로 엄격하거나 의미 있는 벤치마크로 간주되어서는 안 된다).

우리는 또한 "데이터 오염(data contamination)"에 대한 체계적인 연구를 수행한다. 이는 Common Crawl과 같은 데이터셋에서 고용량 모델을 학습할 때 증가하는 문제로, 웹에 해당 콘텐츠가 존재한다는 이유만으로 테스트 데이터셋의 콘텐츠가 포함될 수 있다. 본 논문에서는 데이터 오염을 측정하고 그 왜곡 효과를 정량화하기 위한 체계적인 도구를 개발한다. 데이터 오염이 대부분의 데이터셋에서 GPT-3의 성능에 미미한 영향을 미친다는 것을 발견했지만, 결과를 부풀릴 수 있는 몇몇 데이터셋을 식별했으며, 심각도에 따라 이러한 데이터셋에 대한 결과는 보고하지 않거나 별표로 표시한다.

위의 모든 내용 외에도, 우리는 **zero, one, few-shot 설정에서 GPT-3와 성능을 비교하기 위해 일련의 더 작은 모델들(1억 2,500만 개에서 130억 개의 파라미터 범위)**을 학습시켰다. 전반적으로, 대부분의 task에서 세 가지 설정 모두에서 모델 용량에 따라 비교적 부드러운 스케일링을 발견했다. 한 가지 주목할 만한 패턴은 zero-, one-, few-shot 성능 간의 격차가 모델 용량에 따라 종종 증가한다는 점인데, 이는 더 큰 모델이 더 능숙한 메타 학습자일 수 있음을 시사한다. 마지막으로, GPT-3가 보여주는 광범위한 능력 스펙트럼을 고려하여, 편향, 공정성 및 더 넓은 사회적 영향에 대한 우려를 논의하고, 이와 관련하여 GPT-3의 특성에 대한 예비 분석을 시도한다.

본 논문의 나머지 부분은 다음과 같이 구성된다. Section 2에서는 GPT-3 학습 및 평가를 위한 우리의 접근 방식과 방법론을 설명한다. Section 3에서는 zero-, one-, few-shot 설정에서 전체 task 범위에 대한 결과를 제시한다. Section 4에서는 데이터 오염(학습-테스트 중복) 문제를 다룬다. Section 5에서는 GPT-3의 한계점을 논의한다. Section 6에서는 더 넓은 영향에 대해 논의한다. Section 7에서는 관련 연구를 검토하고 Section 8에서 결론을 맺는다.

2 Approach

모델, 데이터, 학습을 포함한 우리의 기본적인 사전학습(pre-training) 접근 방식은 [RWC19]에서 설명된 과정과 유사하며, 모델 크기, 데이터셋 크기 및 다양성, 학습 기간을 상대적으로 간단하게 확장하였다. in-context learning의 사용 또한 [RWC19]와 유사하지만, 본 연구에서는 context 내 학습을 위한 다양한 설정을 체계적으로 탐구한다. 따라서 이 섹션에서는 GPT-3를 평가할, 또는 원칙적으로 평가할 수 있는 다양한 설정을 명확하게 정의하고 대조하는 것으로 시작한다. 이러한 설정들은 task-specific 데이터에 얼마나 의존하는지에 대한 스펙트럼에 놓여 있다고 볼 수 있다. 구체적으로, 이 스펙트럼에는 최소한 네 가지 지점(Figure 2.1 참조)이 있다:

- **Fine-Tuning (FT)**은 최근 몇 년간 가장 일반적인 접근 방식이었으며, 원하는 task에 특화된 supervised 데이터셋으로 학습하여 사전학습된 모델의 가중치를 업데이트하는 것을 포함한다. 일반적으로 수천에서 수십만 개의 labeled example이 사용된다. fine-tuning의 주요 장점은 많은 벤치마크에서 강력한 성능을 보인다는 것이다. 주요 단점은 모든 task마다 새로운 대규모 데이터셋이 필요하다는 점, out-of-distribution에 대한 일반화 성능이 저조할 가능성 [MPL19], 그리고 학습 데이터의 spurious feature를 악용할 가능성 [GSL18, NK19]이 있어 인간 성능과의 불공정한 비교를 초래할 수 있다는 점이다. 본 연구에서는 task-agnostic 성능에 초점을 맞추기 때문에 GPT-3를 fine-tuning하지 않지만, GPT-3는 원칙적으로 fine-tuning될 수 있으며 이는 향후 연구를 위한 유망한 방향이다.

- **Few-Shot (FS)**은 본 연구에서 추론 시 모델에 task에 대한 몇 가지 demonstration을 conditioning으로 제공하지만, 가중치 업데이트는 허용되지 않는 설정을 지칭하는 데 사용될 용어이다 [RWC19]. Figure 2.1에서 보듯이, 일반적인 데이터셋의 예시는 context와 원하는 completion(예: 영어 문장과 프랑스어 번역)을 가지며, few-shot은 개의 context와 completion 예시를 제공한 다음, 마지막으로 하나의 context 예시를 제공하여 모델이 completion을 제공하도록 하는 방식으로 작동한다. 우리는 일반적으로 를 10에서 100 사이로 설정하는데, 이는 모델의 context window()에 들어갈 수 있는 예시의 수이다. few-shot의 주요 장점은 task-specific 데이터의 필요성을 크게 줄이고, 크지만 좁은 fine-tuning 데이터셋으로부터 지나치게 좁은 분포를 학습할 가능성을 줄인다는 것이다. 주요 단점은 이 방법의 결과가 지금까지 state-of-the-art fine-tuned 모델보다 훨씬 나빴다는 것이다. 또한, 소량의 task-specific 데이터는 여전히 필요하다. 이름에서 알 수 있듯이, 여기서 설명하는 언어 모델을 위한 few-shot learning은 ML의 다른 맥락에서 사용되는 few-shot learning [HYC01, VBL+ 16]과 관련이 있다. 둘 다 광범위한 task 분포(이 경우 사전학습 데이터에 내재된)를 기반으로 학습한 다음 새로운 task에 빠르게 적응하는 것을 포함한다.

- **One-Shot (1S)**은 few-shot과 동일하지만, Figure 1에서 보듯이 task에 대한 자연어 설명 외에 단 하나의 demonstration만 허용된다. one-shot을 few-shot 및 zero-shot(아래 참조)과 구별하는 이유는 일부 task가 인간에게 전달되는 방식과 가장 유사하기 때문이다. 예를 들어, 인간 작업자 서비스(예: Mechanical Turk)에서 인간에게 데이터셋을 생성하도록 요청할 때, task에 대한 하나의 demonstration을 제공하는 것이 일반적이다. 반대로, 예시가 주어지지 않으면 task의 내용이나 형식을 전달하기 어려운 경우가 있다.

우리가 탐구하는 in-context learning의 세 가지 설정

Zero-shot

모델은 task에 대한 자연어 설명만으로 답을 예측한다. gradient 업데이트는 수행되지 않는다.

One-shot

task 설명 외에, 모델은 task의 단일 예시를 본다. gradient 업데이트는 수행되지 않는다.

task 설명 외에, 모델은 task의 몇 가지 예시를 본다. gradient 업데이트는 수행되지 않는다.

Few-shot

Traditional fine-tuning (GPT-3에는 사용되지 않음)

| Fine-tuning |

|---|

| 모델은 대규모 예시 task 코퍼스를 사용하여 반복적인 gradient 업데이트를 통해 학습된다. |

Figure 2.1: Zero-shot, one-shot, few-shot과 전통적인 fine-tuning의 대비. 위 패널들은 언어 모델로 task를 수행하는 네 가지 방법을 보여준다. fine-tuning은 전통적인 방법인 반면, 본 연구에서 다루는 zero-shot, one-shot, few-shot은 테스트 시 모델이 forward pass만으로 task를 수행하도록 요구한다. 우리는 일반적으로 few-shot 설정에서 모델에 수십 개의 예시를 제시한다. 모든 task 설명, 예시 및 prompt에 대한 정확한 문구는 Appendix G에서 찾을 수 있다.

- **Zero-Shot (0S)**은 one-shot과 동일하지만, demonstration이 전혀 허용되지 않으며, 모델에는 task를 설명하는 자연어 지시만 제공된다. 이 방법은 **최대한의 편의성, 견고성 잠재력, 그리고 spurious correlation 회피(사전학습 데이터의 대규모 코퍼스 전반에 걸쳐 매우 광범위하게 발생하지 않는 한)**를 제공하지만, 가장 도전적인 설정이기도 하다. 어떤 경우에는 이전 예시 없이는 인간조차 task의 형식을 이해하기 어려울 수 있으므로, 이 설정은 때때로 "불공평하게 어렵다". 예를 들어, 누군가에게 "200m 달리기 세계 기록 표를 만들어라"고 요청하면, 이 요청은 모호할 수 있다. 표의 정확한 형식이나 포함되어야 할 내용이 명확하지 않을 수 있기 때문이다(그리고 신중한 설명에도 불구하고, 정확히 무엇이 요구되는지 이해하기 어려울 수 있다). 그럼에도 불구하고, 적어도 일부 설정에서는 zero-shot이 인간이 task를 수행하는 방식과 가장 유사하다. 예를 들어, Figure 2.1의 번역 예시에서 인간은 텍스트 지시만으로 무엇을 해야 할지 알 수 있을 것이다.

Figure 2.1은 영어-프랑스어 번역 예시를 사용하여 네 가지 방법을 보여준다. 본 논문에서는 zero-shot, one-shot, few-shot에 초점을 맞추며, 이들을 경쟁적인 대안이 아니라 특정 벤치마크에서의 성능과 sample efficiency 사이에서 다양한 trade-off를 제공하는 다른 문제 설정으로 비교하는 것을 목표로 한다. 특히, few-shot 결과 중 상당수가 state-of-the-art fine-tuned 모델에 비해 약간 뒤처지는 수준이라는 점을 강조한다. 궁극적으로는 one-shot, 또는 때로는 zero-shot이 인간 성능과의 가장 공정한 비교처럼 보이며, 향후 연구를 위한 중요한 목표이다.

아래 섹션 2.1-2.3은 각각 모델, 학습 데이터 및 학습 과정에 대한 세부 정보를 제공한다. 섹션 2.4에서는 few-shot, one-shot, zero-shot 평가를 수행하는 방법에 대한 세부 정보를 논의한다.

| Model Name | Batch Size | Learning Rate | |||||

|---|---|---|---|---|---|---|---|

| GPT-3 Small | 125 M | 12 | 768 | 12 | 64 | 0.5 M | |

| GPT-3 Medium | 350 M | 24 | 1024 | 16 | 64 | 0.5 M | |

| GPT-3 Large | 760 M | 24 | 1536 | 16 | 96 | 0.5 M | |

| GPT-3 XL | 1.3 B | 24 | 2048 | 24 | 128 | 1 M | |

| GPT-3 2.7B | 2.7 B | 32 | 2560 | 32 | 80 | 1 M | |

| GPT-3 6.7B | 6.7 B | 32 | 4096 | 32 | 128 | 2M | |

| GPT-3 13B | 13.0 B | 40 | 5140 | 40 | 128 | 2 M | |

| GPT-3 175B or "GPT-3" | 175.0 B | 96 | 12288 | 96 | 128 | 3.2 M |

Table 2.1: 우리가 학습한 모델들의 크기, 아키텍처, 학습 하이퍼파라미터(토큰 단위 배치 크기 및 학습률). 모든 모델은 총 3천억 개의 토큰으로 학습되었다.

2.1 Model and Architectures

우리는 GPT-2 [RWC19]와 동일한 모델 및 아키텍처를 사용하며, 여기에는 **수정된 초기화(modified initialization), 사전 정규화(pre-normalization), 가역 토큰화(reversible tokenization)**가 포함된다. 단, Transformer의 layer에서 Sparse Transformer [CGRS19]와 유사하게 dense attention과 locally banded sparse attention 패턴을 번갈아 사용한다는 점이 예외이다.

ML 성능이 모델 크기에 어떻게 의존하는지 연구하기 위해, 우리는 1억 2천 5백만 개에서 1,750억 개에 이르는 8가지 다른 크기의 모델을 학습시켰으며, 이는 세 자릿수 규모의 차이를 보인다. 이 중 가장 큰 모델을 GPT-3라고 부른다.

이전 연구 [KMH20]에 따르면, 충분한 학습 데이터가 주어지면 validation loss의 스케일링은 모델 크기의 함수로서 대략적으로 매끄러운 power law를 따를 것이라고 제안한다. 다양한 크기의 모델을 학습시킴으로써 우리는 이 가설을 validation loss와 다운스트림 언어 task 모두에 대해 테스트할 수 있었다.

Table 2.1은 우리가 사용한 8가지 모델의 크기와 아키텍처를 보여준다. 여기서 는 총 학습 가능한 파라미터 수, 는 총 layer 수, 은 각 bottleneck layer의 유닛 수이다 (feedforward layer는 항상 bottleneck layer 크기의 4배, 즉 이다). 그리고 는 각 attention head의 차원이다. 모든 모델은 토큰의 context window를 사용한다. 우리는 노드 간 데이터 전송을 최소화하기 위해 깊이(depth)와 너비(width) 차원 모두에서 모델을 GPU에 분할한다. 각 모델의 정확한 아키텍처 파라미터는 GPU에 모델을 배치할 때의 계산 효율성과 로드 밸런싱을 기반으로 선택되었다. 이전 연구 [KMH20]는 validation loss가 합리적으로 넓은 범위 내에서 이러한 파라미터에 크게 민감하지 않다고 제안한다.

2.2 Training Dataset

Language Model용 데이터셋은 빠르게 확장되어, 궁극적으로는 거의 1조 단어에 달하는 Common Crawl 데이터셋 [RSR19]에 이르렀다. 이 정도 규모의 데이터셋은 동일한 시퀀스를 두 번 업데이트하지 않고도 가장 큰 모델을 학습시키기에 충분하다. 그러나 우리는 필터링되지 않거나 가볍게 필터링된 Common Crawl 버전이 더 잘 정제된(curated) 데이터셋보다 품질이 낮은 경향이 있음을 발견했다. 따라서 우리는 데이터셋의 평균 품질을 향상시키기 위해 다음 세 단계를 거쳤다: (1) 다양한 고품질 참조 코퍼스와의 유사성을 기반으로 Common Crawl의 한 버전을 다운로드하고 필터링했다. (2) 데이터셋 내외부에서 문서 수준의 fuzzy deduplication을 수행하여 중복을 방지하고, held-out validation set이 overfitting을 정확하게 측정하는 도구로서의 무결성을 유지하도록 했다. (3) Common Crawl을 보강하고 다양성을 높이기 위해 알려진 고품질 참조 코퍼스를 학습 혼합에 추가했다.

첫 두 가지 사항(Common Crawl 처리)에 대한 자세한 내용은 Appendix A에 설명되어 있다. 세 번째 사항의 경우, 우리는 확장된 WebText 데이터셋 [RWC19]을 포함한 여러 정제된 고품질 데이터셋을 추가했다. 이 WebText 데이터셋은 더 긴 기간 동안 링크를 스크랩하여 수집되었으며, [KMH20]에서 처음 설명되었다. 또한 **인터넷 기반의 두 가지 도서 코퍼스(Books1 및 Books2)**와 영문 Wikipedia도 포함되었다.

Table 2.2는 우리가 학습에 사용한 최종 데이터셋 혼합을 보여준다. Common Crawl 데이터는 2016년부터 2019년까지의 월별 Common Crawl 41개 shard에서 다운로드되었으며, 필터링 전에는 45TB의 압축된 plaintext였고, 필터링 후에는 570GB로 줄어들었다. 이는 약 4천억 개의 byte-pair-encoded token에 해당한다. 학습 중에는 데이터셋이 크기에 비례하여 샘플링되지 않고, 더 고품질이라고 판단되는 데이터셋이 더 자주 샘플링된다. 따라서 Common Crawl과 Books2 데이터셋은 학습 중 한 번 미만으로 샘플링되지만, 다른 데이터셋은 2~3번 샘플링된다. 이는 더 높은 품질의 학습 데이터를 얻기 위해 약간의 overfitting을 감수하는 방식이다.

Figure 2.2: 학습 중 사용된 총 연산량. Scaling Laws For Neural Language Models [KMH20]의 분석에 따르면, 우리는 일반적인 경우보다 훨씬 적은 token으로 훨씬 큰 모델을 학습시킨다. 결과적으로, GPT-3 3B 모델이 RoBERTa-Large (355M 파라미터)보다 거의 10배 크지만, 두 모델 모두 사전학습 중 약 50 petaflop/s-days의 연산량을 사용했다. 이러한 계산 방법론은 Appendix D에서 확인할 수 있다.

Figure 2.2: 학습 중 사용된 총 연산량. Scaling Laws For Neural Language Models [KMH20]의 분석에 따르면, 우리는 일반적인 경우보다 훨씬 적은 token으로 훨씬 큰 모델을 학습시킨다. 결과적으로, GPT-3 3B 모델이 RoBERTa-Large (355M 파라미터)보다 거의 10배 크지만, 두 모델 모두 사전학습 중 약 50 petaflop/s-days의 연산량을 사용했다. 이러한 계산 방법론은 Appendix D에서 확인할 수 있다.

| Dataset | Quantity (tokens) | Weight in training mix | Epochs elapsed when training for 300B tokens |

|---|---|---|---|

| Common Crawl (filtered) | 410 billion | 60% | 0.44 |

| WebText2 | 19 billion | 22% | 2.9 |

| Books 1 | 12 billion | 8% | 1.9 |

| Books2 | 55 billion | 8% | 0.43 |

| Wikipedia | 3 billion | 3% | 3.4 |

Table 2.2: GPT-3 학습에 사용된 데이터셋. "Weight in training mix"는 학습 중 특정 데이터셋에서 추출되는 예시의 비율을 나타내며, 이는 데이터셋의 크기에 비례하지 않도록 의도적으로 설정되었다. 결과적으로, 3천억 개의 token으로 학습할 때, 일부 데이터셋은 학습 중 최대 3.4번까지 사용되는 반면, 다른 데이터셋은 한 번 미만으로 사용된다.

인터넷의 광범위한 데이터로 사전학습된 언어 모델, 특히 방대한 양의 콘텐츠를 기억할 수 있는 대규모 모델의 경우, 사전학습 중에 downstream task의 test 또는 development set이 의도치 않게 노출되어 오염될 수 있다는 점이 주요 방법론적 우려 사항이다. 이러한 오염을 줄이기 위해, 우리는 본 논문에서 연구된 모든 벤치마크의 development 및 test set과의 중복을 찾아 제거하려고 시도했다. 불행히도, 필터링 과정의 버그로 인해 일부 중복이 무시되었고, 학습 비용 때문에 모델을 재학습하는 것은 불가능했다. Section 4에서는 남아있는 중복의 영향을 분석하며, 향후 연구에서는 데이터 오염을 더욱 적극적으로 제거할 것이다.

2.3 Training Process

에서 밝혀진 바와 같이, 더 큰 모델은 일반적으로 더 큰 batch size를 사용할 수 있지만, 더 작은 learning rate를 필요로 한다. 우리는 학습 중 gradient noise scale을 측정하고 이를 batch size 선택에 활용하였다 [MKAT18]. Table 2.1은 우리가 사용한 파라미터 설정을 보여준다.

더 큰 모델을 메모리 부족 없이 학습시키기 위해, 우리는 각 matrix multiply 내의 model parallelism과 네트워크 layer 간의 model parallelism을 혼합하여 사용하였다. 모든 모델은 Microsoft에서 제공한 고대역폭 클러스터의 V100 GPU에서 학습되었다. 학습 과정 및 하이퍼파라미터 설정에 대한 자세한 내용은 Appendix B에 설명되어 있다.

2.4 Evaluation

Few-shot learning의 경우, 우리는 평가 세트의 각 예시에 대해 해당 task의 학습 세트에서 무작위로 개의 예시를 추출하여 조건(conditioning)으로 사용한다. 이 조건 예시들은 task에 따라 1개 또는 2개의 개행(newline)으로 구분된다. LAMBADA와 Storycloze의 경우, supervised training set이 없으므로 개발 세트에서 조건 예시를 추출하여 테스트 세트에서 평가한다. **Winograd (SuperGLUE 버전이 아닌 원본)**의 경우, 데이터셋이 하나뿐이므로 여기서 직접 조건 예시를 추출한다.

는 모델의 context window가 허용하는 최대 값까지 설정할 수 있으며, 모든 모델에서 ****이다. 일반적으로 이는 10개에서 100개의 예시를 포함할 수 있다. 값이 클수록 항상 좋은 것은 아니지만, 대개는 더 나은 성능을 보인다. 따라서 별도의 개발 세트와 테스트 세트가 있는 경우, 개발 세트에서 몇 가지 값을 실험한 후 가장 좋은 값을 테스트 세트에 적용한다. 일부 task의 경우 (Appendix G 참조), demonstration 외에 (또는 일 경우 demonstration 대신) 자연어 prompt도 사용한다.

여러 옵션 중 하나의 정답을 선택하는 객관식(multiple choice) task의 경우, 우리는 개의 컨텍스트와 정답 완성 예시를 제공한 후, 컨텍스트만 있는 하나의 예시를 제공하고, 각 완성(completion)에 대한 LM의 likelihood를 비교한다. 대부분의 task에서는 **토큰당 likelihood (길이 정규화를 위해)**를 비교하지만, 소수의 데이터셋(ARC, OpenBookQA, RACE)에서는 각 완성의 무조건부 확률로 정규화하여 개발 세트에서 추가적인 이점을 얻는다. 이는 \frac{P \text { (completion|context) }}{P(\text { completion } \mid \text { answer_context })}를 계산하는 방식으로, 여기서 answer_context는 "Answer: " 또는 "A: " 문자열이며, 완성(completion)이 답변이어야 함을 prompt하는 데 사용되지만 그 외에는 일반적이다.

이진 분류(binary classification) task의 경우, 우리는 옵션에 **더 의미 있는 이름(예: 0 또는 1 대신 "True" 또는 "False")**을 부여한 다음 객관식처럼 task를 처리한다. 때로는 [RSR19]에서 수행하는 방식과 유사하게 task를 구성하기도 한다 (자세한 내용은 Appendix G 참조).

자유 형식 완성(free-form completion) task의 경우, 우리는 [RSR19]와 동일한 매개변수로 beam search를 사용한다: **beam width는 4, length penalty는 **이다. 모델 평가는 해당 데이터셋의 표준에 따라 F1 유사도 점수, BLEU, 또는 exact match를 사용한다.

최종 결과는 **각 모델 크기 및 학습 설정(zero-, one-, few-shot)**에 대해 공개적으로 사용 가능한 경우 테스트 세트에서 보고된다. 테스트 세트가 비공개인 경우, 우리 모델은 테스트 서버에 적합하기에는 너무 큰 경우가 많으므로 개발 세트에서 결과를 보고한다. SuperGLUE, TriviaQA, PiQa와 같이 제출이 가능했던 소수의 데이터셋에 대해서는 테스트 서버에 제출했으며, 200B few-shot 결과만 제출하고 나머지는 개발 세트 결과를 보고한다.

3 Results

Figure 3.1에서는 Section 2에서 설명된 8개 모델의 학습 곡선을 보여준다. 이 그래프에는 파라미터 수가 10만 개에 불과한 6개의 추가적인 초소형 모델도 포함되어 있다. [KMH+20]에서 관찰된 바와 같이, 언어 모델링 성능은 학습 연산 자원을 효율적으로 사용할 때 power-law를 따른다. 이 경향을 두 자릿수 더 확장한 결과, 우리는 power-law에서 아주 미미한(혹은 전혀 없는) 이탈만을 관찰했다. 이러한 cross-entropy loss의 개선이 학습 코퍼스의 불필요한 세부 사항을 모델링하는 데서만 비롯된 것이 아니냐는 우려가 있을 수 있다. 그러나 다음 섹션들에서 우리는 cross-entropy loss의 개선이 광범위한 자연어 task에서 일관된 성능 향상으로 이어진다는 것을 확인할 것이다.

아래에서는 Section 2에서 설명된 8개 모델(1,750억 개의 파라미터를 가진 GPT-3와 7개의 더 작은 모델)을 광범위한 데이터셋에서 평가한다. 우리는 데이터셋을 대략적으로 유사한 task를 나타내는 9가지 범주로 그룹화했다.

Section 3.1에서는 전통적인 language modeling task와 Cloze task, 문장/단락 완성 task와 같이 language modeling과 유사한 task를 평가한다. Section 3.2에서는 "closed book" question answering task를 평가한다. 이 task는 일반 지식 질문에 답하기 위해 모델의 파라미터에 저장된 정보를 사용하는 것을 요구한다. Section 3.3에서는 모델의 **언어 간 번역 능력(특히 one-shot 및 few-shot)**을 평가한다. Section 3.4에서는 Winograd Schema와 유사한 task에서 모델의 성능을 평가한다. Section 3.5에서는 상식 추론(commonsense reasoning) 또는 질문 응답(question answering)과 관련된 데이터셋을 평가한다. Section 3.6에서는 독해(reading comprehension) task를 평가하고, Section 3.7에서는 SuperGLUE 벤치마크 스위트를 평가하며, 3.8에서는 NLI를 간략하게 탐구한다. 마지막으로 Section 3.9에서는 in-context learning 능력을 특별히 탐색하기 위해 고안된 몇 가지 추가 task를 제시한다. 이 task들은 즉석 추론(on-the-fly reasoning), 적응 능력(adaptation skills), 또는 open-ended 텍스트 합성에 중점을 둔다. 우리는 모든 task를 few-shot, one-shot, zero-shot 설정에서 평가한다.

Figure 3.1: 연산량에 따른 성능의 부드러운 확장(Smooth scaling of performance with compute).

성능(cross-entropy validation loss로 측정)은 학습에 사용된 연산량에 따라 power-law 경향을 따른다.

[KMH+20]에서 관찰된 power-law 거동은 예측 곡선에서 작은 편차만을 보이며 두 자릿수 더 확장된다.

이 그림에서는 embedding 파라미터를 연산량 및 파라미터 수에서 제외하였다.

Figure 3.1: 연산량에 따른 성능의 부드러운 확장(Smooth scaling of performance with compute).

성능(cross-entropy validation loss로 측정)은 학습에 사용된 연산량에 따라 power-law 경향을 따른다.

[KMH+20]에서 관찰된 power-law 거동은 예측 곡선에서 작은 편차만을 보이며 두 자릿수 더 확장된다.

이 그림에서는 embedding 파라미터를 연산량 및 파라미터 수에서 제외하였다.

| Setting | PTB |

|---|---|

| SOTA (Zero-Shot) | |

| GPT-3 Zero-Shot |

Table 3.1: PTB language modeling 데이터셋에 대한 Zero-shot 결과. 다른 많은 일반적인 language modeling 데이터셋은 GPT-3의 학습 데이터에 포함된 Wikipedia 또는 다른 출처에서 파생되었기 때문에 생략되었다. [RWC+19]

3.1 Language Modeling, Cloze, and Completion Tasks

이 섹션에서는 GPT-3의 전통적인 language modeling task 성능을 테스트하고, 더불어 단일 단어 예측, 문장 또는 단락 완성, 주어진 텍스트의 가능한 완성본 중 선택과 같은 관련 task에서의 성능도 평가한다.

3.1.1 Language Modeling

우리는 [RWC19]에서 측정된 Penn Tree Bank (PTB) [MKM94] 데이터셋에 대한 zero-shot perplexity를 계산한다. 해당 연구의 4가지 Wikipedia 관련 task는 우리의 학습 데이터에 완전히 포함되어 있으므로 제외했으며, one-billion word 벤치마크 또한 데이터셋의 상당 부분이 우리의 학습 세트에 포함되어 있어 제외했다. PTB는 현대 인터넷 이전에 만들어진 데이터셋이므로 이러한 문제에서 자유롭다. 우리의 가장 큰 모델은 PTB에서 15점이라는 상당한 차이로 새로운 SOTA를 달성했으며, 20.50의 perplexity를 기록했다. PTB는 전통적인 language modeling 데이터셋이므로 one-shot 또는 few-shot 평가를 정의할 명확한 예시 구분이 없어 zero-shot만 측정했다.

3.1.2 LAMBADA

LAMBADA 데이터셋 [PKL+ 16]은 텍스트 내 장거리 의존성 모델링을 테스트한다. 모델은 문맥 단락을 읽고 문장의 마지막 단어를 예측하도록 요구받는다. 최근에는 언어 모델의 지속적인 스케일링이 이 어려운 벤치마크에서 점진적인 수익 감소(diminishing returns)를 보이고 있다는 주장이 제기되었다. [BHT 20]는 최근 두 가지 state-of-the-art 결과 ([SPP 19] 및 [Tur20]) 사이에서 모델 크기를 두 배로 늘렸음에도 불구하고 1.5%의 작은 개선에 그쳤다는 점을 언급하며, "하드웨어와 데이터 크기를 몇 배씩 계속 확장하는 것이 앞으로 나아갈 길은 아니다"라고 주장한다. 우리는 여전히 그 길이 유망하다고 생각하며, zero-shot 설정에서 GPT-3는 LAMBADA에서 76%의 성능을 달성하여 이전 state-of-the-art 대비 8%의 향상을 보였다.

| Setting | LAMBADA <br> | LAMBADA <br> | StoryCloze <br> | HellaSwag <br> |

|---|---|---|---|---|

| SOTA | ||||

| GPT-3 Zero-Shot | 83.2 | 78.9 | ||

| GPT-3 One-Shot | 84.7 | 78.1 | ||

| GPT-3 Few-Shot | 87.7 | 79.3 |

Table 3.2: cloze 및 completion task 성능. GPT-3는 LAMBADA에서 SOTA를 크게 개선했으며, 두 가지 어려운 completion prediction 데이터셋에서도 준수한 성능을 달성했다. [Tur20] [RWC 19] [LDL19]

Figure 3.2: LAMBADA에서 언어 모델의 few-shot 능력은 정확도를 크게 향상시킨다. GPT-3 2.7B는 이 설정에서 SOTA인 17B 파라미터 Turing-NLG [Tur20]를 능가하며, GPT-3 175B는 state-of-the-art를 18% 향상시킨다. zero-shot은 본문에서 설명된 one-shot 및 few-shot과 다른 형식을 사용한다.

Figure 3.2: LAMBADA에서 언어 모델의 few-shot 능력은 정확도를 크게 향상시킨다. GPT-3 2.7B는 이 설정에서 SOTA인 17B 파라미터 Turing-NLG [Tur20]를 능가하며, GPT-3 175B는 state-of-the-art를 18% 향상시킨다. zero-shot은 본문에서 설명된 one-shot 및 few-shot과 다른 형식을 사용한다.

LAMBADA는 또한 few-shot learning의 유연성을 보여주는 사례이기도 하다. 이는 이 데이터셋에서 고전적으로 발생하는 문제를 해결하는 방법을 제공한다. LAMBADA의 completion은 항상 문장의 마지막 단어이지만, 표준 언어 모델은 이러한 세부 사항을 알 방법이 없다. 따라서 모델은 정답뿐만 아니라 단락의 다른 유효한 연속에도 확률을 할당한다. 이 문제는 과거에 stop-word filter [RWC 19] (즉, "연속" 단어를 금지하는 필터)를 통해 부분적으로 해결되었다. 반면 few-shot 설정은 **task를 cloze-test로 "프레임화"**하여 언어 모델이 예시를 통해 정확히 한 단어의 completion이 필요하다는 것을 추론할 수 있도록 한다. 우리는 다음 빈칸 채우기 형식을 사용한다:

\begin{aligned} & \text { Alice was friends with Bob. Alice went to visit her friend ___ . } \rightarrow \text { Bob } \\ & \text { George bought some baseball equipment, a ball, a glove, and a _ _ . } \rightarrow \end{aligned}이러한 형식으로 제시된 예시를 통해 GPT-3는 few-shot 설정에서 86.4%의 정확도를 달성했으며, 이는 이전 state-of-the-art 대비 18% 이상 증가한 수치이다. 우리는 few-shot 성능이 모델 크기에 따라 크게 향상됨을 관찰했다. 이 설정은 가장 작은 모델의 성능을 거의 20% 감소시키지만, GPT-3의 경우 정확도를 10% 향상시킨다. 마지막으로, 빈칸 채우기 방식은 one-shot에서는 효과적이지 않으며, 항상 zero-shot 설정보다 낮은 성능을 보인다. 아마도 이는 모든 모델이 패턴을 인식하기 위해 여전히 여러 예시를 필요로 하기 때문일 것이다.

| Setting | NaturalQS | WebQS | TriviaQA |

|---|---|---|---|

| RAG (Fine-tuned, Open-Domain) [LPP 20] | 44.5 | 45.5 | 68.0 |

| T5-11B+SSM (Fine-tuned, Closed-Book) [RRS20] | 36.6 | 44.7 | 60.5 |

| T5-11B (Fine-tuned, Closed-Book) | 34.5 | 37.4 | 50.1 |

| GPT-3 Zero-Shot | 14.6 | 14.4 | 64.3 |

| GPT-3 One-Shot | 23.0 | 25.3 | 68.0 |

| GPT-3 Few-Shot | 29.9 | 41.5 | 71.2 |

Table 3.3: 세 가지 Open-Domain QA task 결과. GPT-3는 few-shot, one-shot, zero-shot 설정에서 이전 closed book 및 open domain 설정의 SOTA 결과와 비교된다. TriviaQA few-shot 결과는 wiki split test server에서 평가되었다.

한 가지 주의할 점은 테스트 세트 오염 분석 결과, LAMBADA 데이터셋의 상당 부분이 우리 학습 데이터에 포함되어 있는 것으로 확인되었다는 것이다. 그러나 Section 4에서 수행된 분석에 따르면 성능에 미치는 영향은 미미한 것으로 나타났다.

3.1.3 HellaSwag

HellaSwag 데이터셋 [ZHB19]은 이야기나 지시문의 가장 적절한 끝 부분을 선택하는 task이다. 이 데이터셋의 예시들은 언어 모델에게는 어렵지만 인간에게는 쉬운(인간 정확도 95.6%) 방식으로 adversarial하게 추출되었다. GPT-3는 one-shot 설정에서 78.1%, few-shot 설정에서 79.3%의 정확도를 달성하여, fine-tuned된 1.5B 파라미터 언어 모델 [ZHR19]의 75.4% 정확도를 능가하지만, fine-tuned된 multi-task 모델인 ALUM이 달성한 전체 SOTA 85.6%보다는 여전히 낮은 수준이다.

3.1.4 StoryCloze

다음으로 우리는 StoryCloze 2016 데이터셋 [MCH16]에 대해 GPT-3를 평가하였다. 이 데이터셋은 다섯 문장으로 구성된 이야기의 올바른 마지막 문장을 선택하는 task이다. 여기서 GPT-3는 zero-shot 설정에서 83.2%, few-shot 설정(K=70)에서 87.7%의 성능을 달성하였다. 이는 BERT 기반 모델 [LDL19]을 사용한 fine-tuned SOTA보다는 4.1% 낮은 수치이지만, 이전 zero-shot 결과에 비해 약 10% 향상된 성능이다.

3.2 Closed Book Question Answering

이 섹션에서는 GPT-3가 광범위한 사실 지식에 대한 질문에 답하는 능력을 측정한다. 가능한 쿼리의 방대한 양 때문에, 이 task는 일반적으로 정보 검색 시스템을 사용하여 관련 텍스트를 찾고, 질문과 검색된 텍스트가 주어졌을 때 답변을 생성하도록 학습된 모델을 결합하는 방식으로 접근되어 왔다. 이러한 설정은 시스템이 잠재적으로 답변을 포함하는 텍스트를 검색하고 이를 조건으로 사용할 수 있기 때문에 "open-book"이라고 불린다.

최근 [RRS20]은 대규모 language model이 보조 정보에 조건을 걸지 않고도 질문에 직접 답하는 데 놀랍도록 뛰어난 성능을 보일 수 있음을 입증했다. 그들은 이처럼 **더 제한적인 평가 설정을 "closed-book"**이라고 명명했다. 그들의 연구는 더 높은 용량의 모델이 훨씬 더 나은 성능을 보일 수 있다는 가설을 제시하며, 우리는 GPT-3를 통해 이 가설을 테스트한다. 우리는 [RRS20]에서 사용된 Natural Questions [KPR+19], WebQuestions [BCFL13], TriviaQA [JCWZ17]의 3가지 데이터셋에 대해 동일한 분할(split)을 사용하여 GPT-3를 평가한다.

모든 결과가 closed-book 설정에서 이루어졌을 뿐만 아니라, 우리의 few-shot, one-shot, zero-shot 평가는 이전 closed-book QA 연구보다 훨씬 더 엄격한 설정을 나타낸다: 외부 콘텐츠가 허용되지 않을 뿐만 아니라, Q&A 데이터셋 자체에 대한 fine-tuning도 허용되지 않는다.

GPT-3의 결과는 Table 3.3에 나와 있다. TriviaQA에서 우리는 zero-shot 설정에서 64.3%, one-shot 설정에서 68.0%, **few-shot 설정에서 71.2%**를 달성했다. zero-shot 결과는 이미 fine-tuned T5-11B를 14.2% 능가하며, 사전학습 중 Q&A에 특화된 span prediction을 사용한 버전보다도 3.8% 더 우수하다. one-shot 결과는 3.7% 향상되었으며, fine-tuning뿐만 아니라 2,100만 개 문서의 15.3B 파라미터 dense vector index에 대한 학습된 검색 메커니즘을 활용하는 open-domain QA 시스템의 SOTA와 일치한다 [LPP+20]. GPT-3의 few-shot 결과는 이보다 3.2% 더 성능을 향상시킨다.

**WebQuestions (WebQs)**에서 GPT-3는 zero-shot 설정에서 14.4%, one-shot 설정에서 25.3%, **few-shot 설정에서 41.5%**를 달성했다. 이는 fine-tuned T5-11B의 37.4% 및 **Q&A 특화 사전학습 절차를 사용하는 fine-tuned T5-11B+SSM의 44.7%**와 비교된다. few-shot 설정의 GPT-3는 state-of-the-art fine-tuned 모델의 성능에 근접한다. 특히, TriviaQA와 비교하여 WebQS는 zero-shot에서 few-shot으로 갈 때 훨씬 더 큰 성능 향상을 보이며 (실제로 zero-shot 및 one-shot 성능은 좋지 않다), 이는 WebQs 질문 및/또는 답변 스타일이 GPT-3에게 out-of-distribution임을 시사할 수 있다. 그럼에도 불구하고, GPT-3는 이 분포에 적응하여 few-shot 설정에서 강력한 성능을 회복하는 것으로 보인다.

Figure 3.3: TriviaQA에서 GPT-3의 성능은 모델 크기에 따라 꾸준히 증가하며, 이는 language model이 용량이 증가함에 따라 지식을 계속 흡수한다는 것을 시사한다. One-shot 및 few-shot 성능은 zero-shot 성능에 비해 크게 향상되어, SOTA fine-tuned open-domain 모델인 RAG [LPP+20]의 성능과 일치하거나 이를 능가한다.

Figure 3.3: TriviaQA에서 GPT-3의 성능은 모델 크기에 따라 꾸준히 증가하며, 이는 language model이 용량이 증가함에 따라 지식을 계속 흡수한다는 것을 시사한다. One-shot 및 few-shot 성능은 zero-shot 성능에 비해 크게 향상되어, SOTA fine-tuned open-domain 모델인 RAG [LPP+20]의 성능과 일치하거나 이를 능가한다.

**Natural Questions (NQs)**에서 GPT-3는 zero-shot 설정에서 14.6%, one-shot 설정에서 23.0%, **few-shot 설정에서 29.9%**를 달성했으며, 이는 **fine-tuned T5 11B+SSM의 36.6%**와 비교된다. WebQS와 유사하게, zero-shot에서 few-shot으로의 큰 성능 향상은 분포 변화를 시사할 수 있으며, TriviaQA 및 WebQS에 비해 경쟁력이 떨어지는 성능을 설명할 수도 있다. 특히, NQs의 질문은 Wikipedia에 특화된 매우 세분화된 지식을 다루는 경향이 있어, 이는 GPT-3의 용량과 광범위한 사전학습 분포의 한계를 시험할 수 있다.

전반적으로, 세 가지 데이터셋 중 하나에서 GPT-3의 one-shot 성능은 open-domain fine-tuning SOTA와 일치한다. 나머지 두 데이터셋에서는 fine-tuning을 사용하지 않았음에도 closed-book SOTA의 성능에 근접한다. 세 가지 데이터셋 모두에서 성능이 모델 크기에 따라 매우 꾸준히 확장되는 것을 발견했으며 (Figure 3.3 및 Appendix H Figure H.7), 이는 모델 용량이 모델 파라미터에 흡수되는 더 많은 '지식'으로 직접적으로 이어진다는 아이디어를 반영하는 것일 수 있다.

3.3 Translation

GPT-2의 경우, 용량 문제로 인해 다국어 문서 모음에서 영어 전용 데이터셋을 생성하기 위해 필터가 사용되었다. 이러한 필터링에도 불구하고 GPT-2는 다국어 능력에 대한 일부 증거를 보였으며, 남아있는 프랑스어 텍스트 10MB만으로 학습했음에도 불구하고 프랑스어와 영어 간 번역에서 비정상적으로(non-trivially) 좋은 성능을 보였다. 우리는 GPT-2에서 GPT-3로 용량을 두 자릿수 이상 늘렸기 때문에, 학습 데이터셋의 범위를 확장하여 다른 언어의 표현을 더 많이 포함시켰지만, 이는 여전히 추가 개선이 필요한 영역이다. 2.2절에서 논의했듯이, 우리 데이터의 대부분은 품질 기반 필터링만 거친 원본 Common Crawl에서 파생되었다. GPT-3의 학습 데이터는 여전히 **주로 영어(단어 수 기준 93%)**이지만, 다른 언어의 텍스트도 7% 포함하고 있다. 이 언어들은 보충 자료에 문서화되어 있다. 번역 능력을 더 잘 이해하기 위해, 우리는 분석을 확장하여 일반적으로 연구되는 두 가지 추가 언어인 독일어와 루마니아어를 포함시켰다.

기존의 비지도 기계 번역(unsupervised machine translation) 접근 방식은 종종 단일 언어 데이터셋 쌍에 대한 사전학습과 **back-translation [SHB15]**을 결합하여 두 언어를 통제된 방식으로 연결한다. 이와 대조적으로, GPT-3는 많은 언어를 단어, 문장, 문서 수준에서 자연스럽게 혼합한 학습 데이터로부터 학습한다. GPT-3는 또한 특정 task에 맞춤화되거나 설계되지 않은 단일 학습 objective를 사용한다. 그러나 우리의 one/few-shot 설정은 소량의 쌍으로 된 예시(1개 또는 64개)를 사용하기 때문에 기존의 비지도 작업과 엄격하게 비교할 수는 없다. 이는 한두 페이지 분량의 in-context 학습 데이터에 해당한다.

결과는 Table 3.4에 나와 있다. Zero-shot GPT-3는 task에 대한 자연어 설명만 받음에도 불구하고 최근의 비지도 NMT 결과보다 여전히 낮은 성능을 보인다. 그러나 각 번역 task에 대해 단 하나의 예시 demonstration만 제공하면

| Setting | En Fr | Fr En | En De | De En | En Ro | Ro En |

|---|---|---|---|---|---|---|

| SOTA (Supervised) | ||||||

| XLM [LC19] | 33.4 | 33.3 | 26.4 | 34.3 | 33.3 | 31.8 |

| MASS [STQ 19] | 34.9 | 28.3 | 35.2 | 33.1 | ||

| mBART [LGG*20] | - | - | 34.0 | 35.0 | 30.5 | |

| GPT-3 Zero-Shot | 25.2 | 21.2 | 24.6 | 27.2 | 14.1 | 19.9 |

| GPT-3 One-Shot | 28.3 | 33.7 | 26.2 | 30.4 | 20.6 | 38.6 |

| GPT-3 Few-Shot | 32.6 | 39.2 | 29.7 | 40.6 | 21.0 | 39.5 |

Table 3.4: Few-shot GPT-3는 영어로 번역할 때 기존의 비지도 NMT 작업보다 5 BLEU 더 높은 성능을 보여주며, 이는 영어 LM으로서의 강점을 반영한다. 우리는 WMT'14 Fr En, WMT'16 De En, WMT'16 Ro En 데이터셋에 대해 multi-bleu.perl로 측정된 BLEU 점수를 보고하며, XLM의 토큰화를 사용하여 기존의 비지도 NMT 작업과 가장 가깝게 비교한다. SacreBLEU [Pos18] 결과는 Appendix H에 보고되어 있다. 밑줄은 비지도 또는 few-shot SOTA를 나타내고, 굵은 글씨는 상대적 신뢰도를 가진 지도 학습 SOTA를 나타낸다. [EOAG18] [DHKH14] SacreBLEU signature: BLEU+case.mixed+numrefs.1+smooth.exp+tok.intl+version.1.2.20]

Figure 3.4: 모델 용량이 증가함에 따른 6개 언어 쌍에 대한 few-shot 번역 성능. 모델이 확장됨에 따라 모든 데이터셋에서 일관된 성능 향상 추세가 나타나며, 영어에서 다른 언어로의 번역보다 영어로의 번역이 더 강한 경향을 보인다.

Figure 3.4: 모델 용량이 증가함에 따른 6개 언어 쌍에 대한 few-shot 번역 성능. 모델이 확장됨에 따라 모든 데이터셋에서 일관된 성능 향상 추세가 나타나며, 영어에서 다른 언어로의 번역보다 영어로의 번역이 더 강한 경향을 보인다.

| Setting | Winograd | Winogrande (XL) |

|---|---|---|

| Fine-tuned SOTA | ||

| GPT-3 Zero-Shot | 70.2 | |

| GPT-3 One-Shot | 73.2 | |

| GPT-3 Few-Shot | 77.7 |

Table 3.5: Winograd schemas의 WSC273 버전과 적대적 Winogrande 데이터셋에 대한 결과. Winograd 테스트 세트의 잠재적 오염에 대한 자세한 내용은 Section 4를 참조하라. [SBBC19] [LYN 20]

Figure 3.5: 모델 용량이 확장됨에 따른 적대적 Winogrande 데이터셋에 대한 zero-, one-, few-shot 성능. 스케일링은 비교적 원활하며, few-shot 학습의 이득은 모델 크기에 따라 증가하고, few-shot GPT-3 175B는 fine-tuned RoBERTA-large와 경쟁력이 있다.

Figure 3.5: 모델 용량이 확장됨에 따른 적대적 Winogrande 데이터셋에 대한 zero-, one-, few-shot 성능. 스케일링은 비교적 원활하며, few-shot 학습의 이득은 모델 크기에 따라 증가하고, few-shot GPT-3 175B는 fine-tuned RoBERTA-large와 경쟁력이 있다.

성능이 7 BLEU 이상 향상되어 기존 작업과 경쟁력 있는 성능에 근접한다. 전체 few-shot 설정에서 GPT-3는 추가로 4 BLEU 더 향상되어 기존의 비지도 NMT 작업과 유사한 평균 성능을 보인다. GPT-3는 언어 방향에 따라 성능에 눈에 띄는 편차를 보인다. 연구된 세 가지 입력 언어에 대해 GPT-3는 영어로 번역할 때 기존의 비지도 NMT 작업보다 훨씬 뛰어난 성능을 보이지만, 다른 방향으로 번역할 때는 낮은 성능을 보인다. En-Ro의 성능은 기존의 비지도 NMT 작업보다 10 BLEU 이상 낮아 눈에 띄는 예외이다. 이는 거의 전적으로 영어 학습 데이터셋을 위해 개발된 GPT-2의 바이트 수준 BPE 토크나이저를 재사용했기 때문일 수 있는 약점이다. Fr-En과 De-En 모두에서 few-shot GPT-3는 우리가 찾을 수 있었던 최고의 지도 학습 결과보다 뛰어난 성능을 보이지만, 문헌에 대한 우리의 익숙하지 않음과 이러한 벤치마크가 경쟁력이 없어 보인다는 점 때문에 이러한 결과가 진정한 state of the art를 나타낸다고는 생각하지 않는다. Ro-En의 경우, few-shot GPT-3는 비지도 사전학습, 608K 레이블링된 예시에 대한 지도 fine-tuning, 그리고 back-translation [LHCG19b]의 조합으로 달성된 전체 SOTA와 0.5 BLEU 이내의 성능을 보인다. 마지막으로, 모든 언어 쌍과 세 가지 설정(zero-, one-, few-shot) 모두에서 모델 용량에 따라 성능이 꾸준히 향상되는 추세를 보인다. 이는 few-shot 결과의 경우 Figure 3.4에 나와 있으며, 세 가지 설정 모두에 대한 스케일링은 Appendix H에 나와 있다.

3.4 Winograd-Style Tasks

Winograd Schemas Challenge [LDM12]는 NLP의 고전적인 task로, 문법적으로는 모호하지만 인간에게는 의미적으로 명확한 대명사가 어떤 단어를 지칭하는지를 결정하는 문제이다. 최근 fine-tuning된 language model들은 원래 Winograd 데이터셋에서 인간에 가까운 성능을 달성했지만, adversarially-mined Winogrande 데이터셋 [SBBC19]과 같은 더 어려운 버전에서는 여전히 인간 성능에 크게 뒤처진다. 우리는 GPT-3의 성능을 Winograd와 Winogrande 모두에서, 평소와 같이 zero-shot, one-shot, few-shot 설정으로 테스트한다.

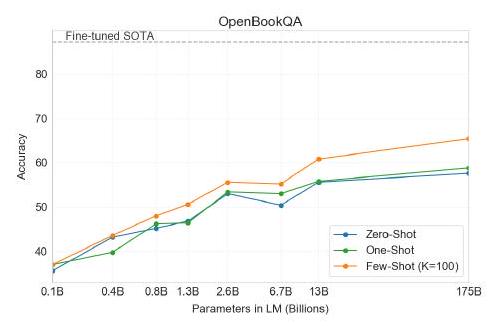

| Setting | PIQA | ARC (Easy) | ARC (Challenge) | OpenBookQA |

|---|---|---|---|---|

| Fine-tuned SOTA | 79.4 | |||

| GPT-3 Zero-Shot | 68.8 | 51.4 | 57.6 | |

| GPT-3 One-Shot | 71.2 | 53.2 | 58.8 | |

| GPT-3 Few-Shot | 70.1 | 51.5 | 65.4 |

Table 3.6: PIQA, ARC, OpenBookQA 세 가지 상식 추론 task에 대한 GPT-3 결과. GPT-3 Few-Shot PIQA 결과는 테스트 서버에서 평가되었다. PIQA 테스트 세트의 잠재적 오염 문제에 대한 자세한 내용은 Section 4를 참조하라.

Figure 3.6: zero-shot, one-shot, few-shot 설정에서 PIQA에 대한 GPT-3 결과. 가장 큰 모델은 세 가지 조건 모두에서 개발 세트에서 해당 task의 최고 기록 점수를 초과하는 점수를 달성했다.

Figure 3.6: zero-shot, one-shot, few-shot 설정에서 PIQA에 대한 GPT-3 결과. 가장 큰 모델은 세 가지 조건 모두에서 개발 세트에서 해당 task의 최고 기록 점수를 초과하는 점수를 달성했다.

Winograd에 대해 우리는 원래의 273개 Winograd schema 세트를 사용하여 GPT-3를 테스트했으며, [RWC19]에서 설명된 것과 동일한 "partial evaluation" 방법을 사용했다. 이 설정은 SuperGLUE 벤치마크의 WSC task와 약간 다르다는 점에 유의해야 한다. SuperGLUE의 WSC task는 이진 분류로 제시되며, 이 섹션에서 설명하는 형태로 변환하기 위해 개체 추출(entity extraction)이 필요하다. Winograd에서 GPT-3는 zero-shot, one-shot, few-shot 설정에서 각각 88.3%, 89.7%, 88.6%를 달성하여 명확한 in-context learning 효과는 보이지 않았지만, 모든 경우에 state-of-the-art 및 추정된 인간 성능보다 단 몇 점 낮은 강력한 결과를 보여주었다. 오염 분석 결과 학습 데이터에 일부 Winograd schema가 포함되어 있었지만, 이는 결과에 미미한 영향만 미친 것으로 보인다 (Section 4 참조).

더 어려운 Winogrande 데이터셋에서는 in-context learning의 이점을 발견했다: GPT-3는 zero-shot 설정에서 70.2%, one-shot 설정에서 73.2%, few-shot 설정에서 77.7%를 달성했다. 비교를 위해 fine-tuned RoBERTA 모델은 79%를 달성했으며, **state-of-the-art는 fine-tuned 고용량 모델(T5)로 달성된 84.6%**이다. [SBBC19]에 따르면 해당 task의 **인간 성능은 94.0%**이다.

3.5 Common Sense Reasoning

다음으로 우리는 문장 완성, 독해, 또는 광범위한 지식 질문 답변과는 구별되는 물리적 또는 과학적 추론을 포착하려는 세 가지 데이터셋을 살펴본다. 첫 번째인 PhysicalQA (PIQA) [BZB19]는 물리 세계가 어떻게 작동하는지에 대한 상식적인 질문을 묻고, 세상에 대한 grounded understanding을 탐구하기 위해 고안되었다. GPT-3는 zero-shot에서 81.0% 정확도, one-shot에서 80.5% 정확도, few-shot에서 82.8% 정확도를 달성했다 (마지막은 PIQA의 테스트 서버에서 측정됨). 이는 fine-tuned RoBERTa의 이전 state-of-the-art인 79.4% 정확도와 비교했을 때 우수한 결과이다.

| Setting | CoQA | DROP | QuAC | SQuADv2 | RACE-h | RACE-m |

|---|---|---|---|---|---|---|

| Fine-tuned SOTA | ||||||

| GPT-3 Zero-Shot | 81.5 | 23.6 | 41.5 | 59.5 | 45.5 | 58.4 |

| GPT-3 One-Shot | 84.0 | 34.3 | 43.3 | 65.4 | 45.9 | 57.4 |

| GPT-3 Few-Shot | 85.0 | 36.5 | 44.3 | 69.8 | 46.8 | 58.1 |

Table 3.7: 독해 task 결과. RACE 결과는 정확도를 보고하며, 그 외 모든 점수는 F1이다. [JZC19] [JN20] [AI19] [QIA20] [SPP+ 19]

PIQA는 모델 크기에 따른 scaling이 상대적으로 얕고 여전히 인간 성능보다 10% 이상 낮지만, GPT-3의 few-shot 및 심지어 zero-shot 결과는 현재 state-of-the-art를 능가한다. 우리의 분석 결과 PIQA에서 잠재적인 데이터 오염 문제가 발견되어 (숨겨진 테스트 레이블에도 불구하고), 우리는 보수적으로 결과에 별표를 표시했다. 자세한 내용은 Section 4를 참조하라.

ARC [CCE18]는 3학년부터 9학년까지의 과학 시험 문제에서 수집된 객관식 질문 데이터셋이다. 간단한 통계적 또는 정보 검색 방법으로는 올바르게 답변할 수 없도록 필터링된 데이터셋의 "Challenge" 버전에서, GPT-3는 zero-shot 설정에서 51.4% 정확도, one-shot 설정에서 53.2%, few-shot 설정에서 51.5% 정확도를 달성했다. 이는 **fine-tuned RoBERTa baseline (55.9%)**인 UnifiedQA [KKS20]의 성능에 근접한다. 데이터셋의 "Easy" 버전 (언급된 baseline 접근 방식 중 하나가 올바르게 답변한 질문들)에서, GPT-3는 **68.8%, 71.2%, 70.1%**를 달성했으며, 이는 [KKS20]의 fine-tuned RoBERTa baseline을 약간 상회한다. 그러나 이 두 결과 모두 UnifiedQA가 달성한 전반적인 SOTA보다 훨씬 낮은 성능을 보이며, UnifiedQA는 challenge set에서 GPT-3의 few-shot 결과보다 27%, easy set에서 22% 더 높은 성능을 보인다.

OpenBookQA [MCKS18]에서 GPT-3는 zero-shot에서 few-shot 설정으로 갈수록 크게 향상되지만, 여전히 전반적인 SOTA에는 20점 이상 미치지 못한다. GPT-3의 few-shot 성능은 리더보드의 fine-tuned BERT Large baseline과 유사하다.

전반적으로, GPT-3를 사용한 in-context learning은 상식 추론 task에서 엇갈린 결과를 보여준다. PIQA와 ARC 모두에서 one-shot 및 few-shot 학습 설정에서 작고 일관성 없는 개선이 관찰되었지만, OpenBookQA에서는 상당한 개선이 관찰되었다. GPT-3는 새로운 PIQA 데이터셋에서 모든 평가 설정에서 SOTA를 달성했다.

3.6 Reading Comprehension

다음으로 우리는 GPT-3를 독해(reading comprehension) task에서 평가한다. 우리는 추상적(abstractive), 다중 선택(multiple choice), span 기반 답변 형식을 포함하는 5개의 데이터셋을 사용하며, 이는 대화(dialog) 및 단일 질문(single question) 설정을 모두 포함한다. 우리는 이들 데이터셋 전반에 걸쳐 GPT-3의 성능이 크게 차이 나는 것을 관찰했는데, 이는 다양한 답변 형식에 대한 GPT-3의 능력 차이를 시사한다. 일반적으로 GPT-3는 각 데이터셋에서 contextual representation을 사용하여 학습된 초기 baseline 및 초기 결과와 비슷한 수준의 성능을 보인다.

GPT-3는 자유 형식 대화 데이터셋인 CoQA [RCM19]에서 가장 좋은 성능을 보였으며 (인간 baseline과 3점 이내 차이), 교사-학생 상호작용에서 구조화된 대화 행위(dialog acts) 및 답변 span 선택 모델링을 요구하는 데이터셋인 QuAC [CHI+18]에서는 가장 낮은 성능을 보였다 (ELMo baseline보다 F1 점수 13점 낮음). **독해 맥락에서 이산 추론(discrete reasoning) 및 수리 능력(numeracy)을 테스트하는 데이터셋인 DROP [DWD+19]**에서는, few-shot 설정의 GPT-3가 원 논문의 fine-tuned BERT baseline을 능가했지만, 인간 성능 및 신경망에 symbolic system을 보강한 state-of-the-art 접근법 [RLL+19]에는 여전히 크게 못 미쳤다. **SQuAD 2.0 [RJL18]**에서는 GPT-3가 zero-shot 설정 대비 거의 10 F1 (69.8로) 향상되며 few-shot learning 능력을 보여주었다. 이를 통해 원 논문의 최고 fine-tuned 결과보다 약간 더 나은 성능을 달성했다. **중고등학교 영어 시험 문제로 구성된 다중 선택 데이터셋인 RACE [LXL+17]**에서는 GPT-3가 상대적으로 약한 성능을 보였으며, contextual representation을 활용한 초기 연구들과만 경쟁할 수 있는 수준이었고, SOTA에는 여전히 45% 뒤처졌다.

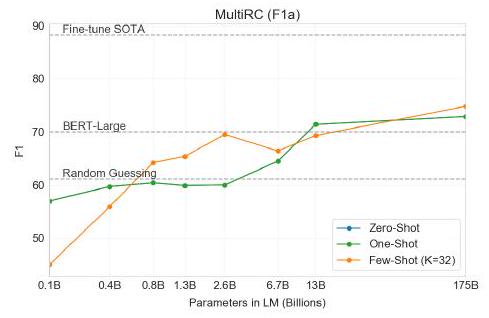

3.7 SuperGLUE

NLP task의 결과를 더 잘 통합하고 BERT 및 RoBERTa와 같은 인기 모델과 보다 체계적으로 비교하기 위해, 우리는 표준화된 데이터셋 모음인 SuperGLUE 벤치마크 [WPN 19] [WPN 19] [CLC 19] [DMST19] [RBG11] [KCR 18] [ZLL 18] [DGM06] [BHDD 06] [GMDD07] [BDD 09] [PCC18] [PHR 18]에서도 GPT-3를 평가했다. SuperGLUE 데이터셋에 대한 GPT-3의 test-set 성능은 Table 3.8에 나와 있다. few-shot 설정에서는 모든 task에 대해 학습 세트에서 무작위로 샘플링한 32개의 예시를 사용했다. WSC를 제외한 모든 task와 MultiRC에 대해서는 각 문제에 대한 context로 사용할 새로운 예시 세트를 샘플링했다. WSC와 MultiRC의 경우, 평가한 모든 문제에 대해 context로 사용하기 위해 학습 세트에서 무작위로 추출한 동일한 예시 세트를 사용했다.

Figure 3.7: CoQA 독해 task에 대한 GPT-3 결과. GPT-3 175B는 few-shot 설정에서 85 F1을 달성했으며, 이는 측정된 인간 성능 및 state-of-the-art fine-tuned 모델보다 불과 몇 포인트 뒤처지는 수치이다. Zero-shot 및 one-shot 성능은 몇 포인트 뒤처지며, few-shot으로 인한 성능 향상은 모델이 클수록 가장 크게 나타난다.

Figure 3.7: CoQA 독해 task에 대한 GPT-3 결과. GPT-3 175B는 few-shot 설정에서 85 F1을 달성했으며, 이는 측정된 인간 성능 및 state-of-the-art fine-tuned 모델보다 불과 몇 포인트 뒤처지는 수치이다. Zero-shot 및 one-shot 성능은 몇 포인트 뒤처지며, few-shot으로 인한 성능 향상은 모델이 클수록 가장 크게 나타난다.

| SuperGLUE Average | BoolQ Accuracy | CB Accuracy | CB F1 | COPA Accuracy | RTE Accuracy | |

|---|---|---|---|---|---|---|

| Fine-tuned SOTA | 89.0 | 91.0 | 96.9 | 93.9 | 94.8 | 92.5 |

| Fine-tuned BERT-Large | 69.0 | 77.4 | 83.6 | 75.7 | 70.6 | 71.7 |

| GPT-3 Few-Shot | 71.8 | 76.4 | 75.6 | 52.0 | 92.0 | 69.0 |

| WiC Accuracy | WSC Accuracy | MultiRC Accuracy | MultiRC F1a | ReCoRD Accuracy | ReCoRD F1 | |

| Fine-tuned SOTA | 76.1 | 93.8 | 62.3 | 88.2 | 92.5 | 93.3 |

| Fine-tuned BERT-Large | 69.6 | 64.6 | 24.1 | 70.0 | 71.3 | 72.0 |

| GPT-3 Few-Shot | 49.4 | 80.1 | 30.5 | 75.4 | 90.2 | 91.1 |

Table 3.8: fine-tuned baseline 및 SOTA와 비교한 SuperGLUE에 대한 GPT-3의 성능. 모든 결과는 test set에서 보고되었다. GPT-3 few-shot은 각 task의 context 내에서 총 32개의 예시가 주어지며, gradient update는 수행하지 않는다.

Figure 3.8: SuperGLUE 성능은 모델 크기와 context 내 예시 수에 따라 증가하며, in-context learning의 이점이 커짐을 보여준다. 값은 우리 모델이 SuperGLUE의 8개 task에 걸쳐 총 256개의 예시를 위해 task당 32개의 예시를 보았음을 의미한다. 우리는 dev set에 대한 GPT-3 값을 보고하므로, 우리 수치는 점선 참조선과 직접 비교할 수 없다 (우리의 test set 결과는 Table 3.8에 있다). BERT-Large 참조 모델은 SuperGLUE 학습 세트(125K 예시)에서 fine-tuned되었고, BERT++는 MultiNLI(392K 예시) 및 SWAG(113K 예시)에서 먼저 fine-tuned된 후 SuperGLUE 학습 세트에서 추가 fine-tuning되었다(총 630K fine-tuning 예시). 우리는 BERT-Large와 BERT++ 간의 성능 차이가 context당 하나의 예시를 사용하는 GPT-3와 context당 8개의 예시를 사용하는 GPT-3 간의 차이와 거의 동일하다는 것을 발견했다.

Figure 3.8: SuperGLUE 성능은 모델 크기와 context 내 예시 수에 따라 증가하며, in-context learning의 이점이 커짐을 보여준다. 값은 우리 모델이 SuperGLUE의 8개 task에 걸쳐 총 256개의 예시를 위해 task당 32개의 예시를 보았음을 의미한다. 우리는 dev set에 대한 GPT-3 값을 보고하므로, 우리 수치는 점선 참조선과 직접 비교할 수 없다 (우리의 test set 결과는 Table 3.8에 있다). BERT-Large 참조 모델은 SuperGLUE 학습 세트(125K 예시)에서 fine-tuned되었고, BERT++는 MultiNLI(392K 예시) 및 SWAG(113K 예시)에서 먼저 fine-tuned된 후 SuperGLUE 학습 세트에서 추가 fine-tuning되었다(총 630K fine-tuning 예시). 우리는 BERT-Large와 BERT++ 간의 성능 차이가 context당 하나의 예시를 사용하는 GPT-3와 context당 8개의 예시를 사용하는 GPT-3 간의 차이와 거의 동일하다는 것을 발견했다.

우리는 GPT-3의 task별 성능에서 넓은 범위의 차이를 관찰했다. COPA와 ReCoRD에서 GPT-3는 one-shot 및 few-shot 설정에서 거의 SOTA 성능을 달성했으며, COPA는 불과 몇 포인트 차이로 2위를 차지했고, 1위는 fine-tuned된 110억 파라미터 모델(T5)이 차지했다. WSC에서는 few-shot 설정에서 80.1%를 달성하며 여전히 비교적 강력한 성능을 보였다(GPT-3는 Section 3.4에서 설명된 원래 Winograd 데이터셋에서 88.6%를 달성한다). BoolQ, MultiRC, RTE에서는 fine-tuned BERT-Large와 거의 일치하는 합리적인 성능을 보였다. CB에서는 few-shot 설정에서 75.6%로 가능성을 보였다.

WiC는 few-shot 성능이 49.4%로 현저히 약한 부분이었다(무작위 확률 수준). 우리는 WiC(두 문장에서 단어가 같은 의미로 사용되었는지 판단하는 task)에 대해 여러 가지 다른 표현과 공식을 시도했지만, 어떤 것도 강력한 성능을 달성하지 못했다. 이는 다음 섹션(ANLI 벤치마크를 논의하는 섹션)에서 더 명확해질 현상을 암시한다. GPT-3는 few-shot 또는 one-shot 설정에서 두 문장이나 스니펫을 비교하는 일부 task(예: 두 문장에서 단어가 같은 방식으로 사용되는지 여부(WiC), 한 문장이 다른 문장의 paraphrase인지 여부, 한 문장이 다른 문장을 함축하는지 여부)에서 약점을 보이는 것으로 보인다. 이는 또한 RTE 및 CB의 비교적 낮은 점수를 설명할 수 있는데, 이들도 이 형식을 따른다. 이러한 약점에도 불구하고, GPT-3는 8개 task 중 4개에서 fine-tuned BERT-large를 능가하며, 2개 task에서는 fine-tuned된 110억 파라미터 모델이 보유한 state-of-the-art에 근접한다.

마지막으로, 우리는 few-shot SuperGLUE 점수가 모델 크기와 context 내 예시 수 모두에 따라 꾸준히 향상되어 in-context learning의 이점이 증가함을 보여준다(Figure 3.8). 우리는 를 task당 32개 예시까지 확장했으며, 그 이후에는 추가 예시가 context에 안정적으로 맞지 않는다. 값을 스윕할 때, GPT-3는 전체 SuperGLUE 점수에서 fine-tuned BERT-Large를 능가하기 위해 task당 8개 미만의 총 예시가 필요하다는 것을 발견했다.

3.8 NLI

자연어 추론(Natural Language Inference, NLI) [Fyo00]은 두 문장 간의 관계를 이해하는 능력과 관련이 있다. 실제로는 이 task가 두 개 또는 세 개의 클래스 분류 문제로 구성되는 경우가 많으며, 모델은 두 번째 문장이 첫 번째 문장에서 논리적으로 도출되는지(entailment), 첫 번째 문장과 모순되는지(contradiction), 또는 **가능성이 있는지(neutral)**를 분류한다.

Figure 3.9: ANLI Round 3에서의 GPT-3 성능. 결과는 dev-set 기준이며, 1500개의 예시만 포함되어 있어 분산이 높다(표준 편차 1.2%로 추정). 작은 모델들은 무작위 추측 수준에 머무는 반면, few-shot GPT-3 175B는 무작위 추측과 SOTA 사이의 격차를 거의 절반으로 줄였다. ANLI Round 1과 2의 결과는 부록에 제시되어 있다.

Figure 3.9: ANLI Round 3에서의 GPT-3 성능. 결과는 dev-set 기준이며, 1500개의 예시만 포함되어 있어 분산이 높다(표준 편차 1.2%로 추정). 작은 모델들은 무작위 추측 수준에 머무는 반면, few-shot GPT-3 175B는 무작위 추측과 SOTA 사이의 격차를 거의 절반으로 줄였다. ANLI Round 1과 2의 결과는 부록에 제시되어 있다.

SuperGLUE에는 이 task의 이진(binary) 버전을 평가하는 NLI 데이터셋인 RTE가 포함되어 있다. RTE에서 GPT-3의 가장 큰 버전만이 모든 평가 설정에서 무작위 추측(56%)보다 확실히 더 나은 성능을 보였지만, few-shot 설정에서는 GPT-3가 단일 task fine-tuned BERT Large와 유사한 성능을 나타냈다. 우리는 또한 최근에 도입된 Adversarial Natural Language Inference (ANLI) 데이터셋 [NWD19]에 대해서도 평가를 수행했다. ANLI는 세 라운드(R1, R2, R3)에 걸쳐 적대적으로 추출된(adversarially mined) 자연어 추론 질문들을 포함하는 어려운 데이터셋이다. RTE와 유사하게, GPT-3보다 작은 모든 모델들은 few-shot 설정에서도 ANLI에서 거의 정확히 무작위 추측 수준(약 33%)의 성능을 보인 반면, GPT-3 자체는 Round 3에서 진전의 조짐을 보였다. ANLI R3의 결과는 Figure 3.9에 강조되어 있으며, 모든 라운드의 전체 결과는 Appendix H에서 확인할 수 있다. RTE와 ANLI 모두에서의 이러한 결과는 NLI가 언어 모델에게 여전히 매우 어려운 task이며, 이제 막 진전의 조짐을 보이기 시작했다는 점을 시사한다.

3.9 Synthetic and Qualitative Tasks

few-shot (또는 zero-shot, one-shot) 설정에서 GPT-3의 능력 범위를 탐색하는 한 가지 방법은, 모델이 간단한 즉석 연산 추론을 수행하거나, 학습 시에는 나타나지 않았을 새로운 패턴을 인식하거나, 특이한 task에 빠르게 적응해야 하는 task를 주는 것이다. 우리는 이러한 종류의 능력을 테스트하기 위해 몇 가지 task를 고안했다.

첫째, 우리는 GPT-3의 산술 연산 능력을 테스트한다. 둘째, 단어의 글자를 재배열하거나 해독하는 여러 task를 만들었는데, 이러한 task는 학습 중에 정확히 본 적이 없을 가능성이 높다. 셋째, 우리는 GPT-3의 SAT 스타일 유추 문제 해결 능력을 few-shot으로 테스트한다. 마지막으로, 우리는 문장에서 새로운 단어 사용, 영어 문법 교정, 뉴스 기사 생성을 포함한 몇 가지 정성적(qualitative) task에 대해 GPT-3를 테스트한다.

우리는 언어 모델의 테스트 시 동작에 대한 추가 연구를 촉진하기 위해 합성 데이터셋을 공개할 예정이다.

3.9.1 Arithmetic

GPT-3의 task-specific 학습 없이 간단한 산술 연산 수행 능력을 테스트하기 위해, 우리는 자연어로 GPT-3에게 간단한 산술 문제를 질문하는 10가지 소규모 테스트 세트를 개발했다:

- 2자리 덧셈 (2D+): 모델은 [0, 100) 범위에서 균일하게 샘플링된 두 정수를 더하도록 요청받으며, 질문 형식은 "Q: What is 48 plus 76? A: 124."와 같다.

- 2자리 뺄셈 (2D-): 모델은 [0, 100) 범위에서 균일하게 샘플링된 두 정수를 빼도록 요청받으며, 음수 결과가 나올 수 있다. 예시: "Q: What is 34 minus 53? A: -19".

- 3자리 덧셈 (3D+): 2자리 덧셈과 동일하지만, 숫자는 [0, 1000) 범위에서 균일하게 샘플링된다.

Figure 3.10: 다양한 크기의 모델에 대한 few-shot 설정에서 10가지 산술 task 전체의 결과. 두 번째로 큰 모델(GPT-3 13B)에서 가장 큰 모델(GPT-3 175)로 넘어갈 때 상당한 성능 향상이 있으며, 후자는 2자리 산술 연산에서 안정적으로 정확하고, 3자리 산술 연산에서 일반적으로 정확하며, 4-5자리 산술 연산, 2자리 곱셈, 복합 연산에서 상당한 비율로 정답을 맞춘다. one-shot 및 zero-shot 결과는 appendix에 제시되어 있다.

Figure 3.10: 다양한 크기의 모델에 대한 few-shot 설정에서 10가지 산술 task 전체의 결과. 두 번째로 큰 모델(GPT-3 13B)에서 가장 큰 모델(GPT-3 175)로 넘어갈 때 상당한 성능 향상이 있으며, 후자는 2자리 산술 연산에서 안정적으로 정확하고, 3자리 산술 연산에서 일반적으로 정확하며, 4-5자리 산술 연산, 2자리 곱셈, 복합 연산에서 상당한 비율로 정답을 맞춘다. one-shot 및 zero-shot 결과는 appendix에 제시되어 있다.

- 3자리 뺄셈 (3D-): 2자리 뺄셈과 동일하지만, 숫자는 [0, 1000) 범위에서 균일하게 샘플링된다.

- 4자리 덧셈 (4D+): 3자리 덧셈과 동일하지만, 숫자는 [0, 10000) 범위에서 균일하게 샘플링된다.

- 4자리 뺄셈 (4D-): 3자리 뺄셈과 동일하지만, 숫자는 [0, 10000) 범위에서 균일하게 샘플링된다.

- 5자리 덧셈 (5D+): 3자리 덧셈과 동일하지만, 숫자는 [0, 100000) 범위에서 균일하게 샘플링된다.

- 5자리 뺄셈 (5D-): 3자리 뺄셈과 동일하지만, 숫자는 [0, 100000) 범위에서 균일하게 샘플링된다.

- 2자리 곱셈 (2Dx): 모델은 [0, 100) 범위에서 균일하게 샘플링된 두 정수를 곱하도록 요청받는다. 예시: "Q: What is 24 times 42? A: 1008".

- 한 자리 복합 연산 (1DC): 모델은 세 개의 한 자리 숫자에 대해 복합 연산을 수행하도록 요청받으며, 마지막 두 숫자에는 괄호가 포함된다. 예를 들어, "Q: What is ? A: 38 ". 세 개의 한 자리 숫자는 [0, 10) 범위에서 균일하게 선택되며, 연산은 {+,-,*} 중에서 균일하게 선택된다.

10가지 task 모두에서 모델은 정확한 정답을 생성해야 한다. 각 task에 대해 우리는 2,000개의 무작위 인스턴스로 구성된 데이터셋을 생성하고, 모든 모델을 이 인스턴스들로 평가한다.

먼저 우리는 few-shot 설정에서 GPT-3를 평가했으며, 그 결과는 Figure 3.10에 나와 있다. 덧셈과 뺄셈에서 GPT-3는 자릿수가 작을 때 강력한 숙련도를 보여주며, 2자리 덧셈에서 100% 정확도, 2자리 뺄셈에서 98.9%, 3자리 덧셈에서 80.2%, 3자리 뺄셈에서 94.2%를 달성했다. 자릿수가 증가함에 따라 성능은 감소하지만, GPT-3는 여전히 4자리 연산에서 25-26%의 정확도를, 5자리 연산에서 9-10%의 정확도를 달성하여, 더 많은 자릿수로 일반화할 수 있는 최소한의 능력을 시사한다. GPT-3는 또한 특히 계산 집약적인 연산인 2자리 곱셈에서 29.2%의 정확도를 달성했다. 마지막으로, GPT-3는 한 자리 복합 연산(예: )에서 21.3%의 정확도를 달성하여, 단일 연산을 넘어선 어느 정도의 견고성을 보여준다. Figure 3.10이 명확히 보여주듯이, 작은 모델들은 이 모든 task에서 저조한 성능을 보인다. 심지어 130억 파라미터 모델(1750억 파라미터의 전체 GPT-3 다음으로 두 번째로 큰 모델)조차 2자리 덧셈과 뺄셈을 절반 정도만 풀 수 있으며, 다른 모든 연산은 10% 미만의 성공률을 보인다.

one-shot 및 zero-shot 성능은 few-shot 성능에 비해 다소 저하되는데, 이는 task에 대한 적응(또는 최소한 task 인식)이 이러한 계산을 올바르게 수행하는 데 중요함을 시사한다. 그럼에도 불구하고, one-shot 성능은 여전히 상당히 강력하며, 전체 GPT-3의 zero-shot 성능조차 모든 작은 모델의 few-shot 학습 성능을 크게 능가한다. 전체 GPT-3의 세 가지 설정에 대한 결과는 Table 3.9에 나와 있으며, 세 가지 설정 모두에 대한 모델 용량 스케일링은 Appendix H에 나와 있다. 모델이 단순히 특정 산술 문제를 암기하는지 여부를 확인하기 위해, 우리는 테스트 세트의 3자리 산술 문제들을 가져와 학습 데이터에서 "<NUM1> + <NUM2> =" 및 "<NUM1> plus <NUM2>" 두 가지 형식으로 검색했다. 2,000개의 덧셈 문제 중 일치하는 것은 17개(0.8%)에 불과했으며, 2,000개의 뺄셈 문제 중 일치하는 것은 2개(0.1%)에 불과하여, 정답 중 극히 일부만이 암기되었을 가능성을 시사한다. 또한, 오답을 검토한 결과 모델이 종종 "1"을 올리지 않는 것과 같은 실수를 저지르는 것을 발견했는데, 이는 모델이 테이블을 암기하는 대신 실제로 관련 계산을 시도하고 있음을 시사한다. 전반적으로 GPT-3는 few-shot, one-shot, 심지어 zero-shot 설정에서도 중간 정도의 복잡한 산술 연산에서 합리적인 숙련도를 보여준다.

| Setting | 2 Dx | 1 DC | ||||||||

|---|---|---|---|---|---|---|---|---|---|---|

| GPT-3 Zero-shot | 76.9 | 58.0 | 34.2 | 48.3 | 4.0 | 7.5 | 0.7 | 0.8 | 19.8 | 9.8 |

| GPT-3 One-shot | 99.6 | 86.4 | 65.5 | 78.7 | 14.0 | 14.0 | 3.5 | 3.8 | 27.4 | 14.3 |

| GPT-3 Few-shot | 100.0 | 98.9 | 80.4 | 94.2 | 25.5 | 26.8 | 9.3 | 9.9 | 29.2 | 21.3 |

Table 3.9: GPT-3 175B의 기본 산술 task 결과. 는 2, 3, 4, 5자리 덧셈 또는 뺄셈, 2Dx는 2자리 곱셈이다. 1DC는 1자리 복합 연산이다. zero-shot에서 one-shot, few-shot 설정으로 갈수록 성능이 점진적으로 강해지지만, zero-shot에서도 상당한 산술 능력을 보여준다.

| Setting | CL | A 1 | A 2 | RI | RW |

|---|---|---|---|---|---|

| GPT-3 Zero-shot | 3.66 | 2.28 | 8.91 | 8.26 | 0.09 |

| GPT-3 One-shot | 21.7 | 8.62 | 25.9 | 45.4 | 0.48 |

| GPT-3 Few-shot | 37.9 | 15.1 | 39.7 | 67.2 | 0.44 |

Table 3.10: GPT-3 175B의 다양한 단어 재배열 및 단어 조작 task에 대한 zero-shot, one-shot, few-shot 설정에서의 성능. CL은 "cycle letters in word", A1은 첫 글자와 마지막 글자를 제외한 아나그램, A2는 첫 두 글자와 마지막 두 글자를 제외한 아나그램, RI는 "Random insertion in word", RW는 "reversed words"이다.

3.9.2 Word Scrambling and Manipulation Tasks

GPT-3가 소수의 예시로부터 새로운 상징적 조작(symbolic manipulation)을 학습하는 능력을 테스트하기 위해, 우리는 5가지 "문자 조작(character manipulation)" task로 구성된 작은 테스트 세트를 설계했다. 각 task는 문자 뒤섞기, 추가, 삭제 등의 조합으로 왜곡된 단어를 모델에 제공하고, 원본 단어를 복구하도록 요구한다. 5가지 task는 다음과 같다:

- Cycle letters in word (CL): 모델에 글자가 순환된 단어가 주어지고, 이어서 "=" 기호가 주어진다. 모델은 원본 단어를 생성해야 한다. 예를 들어, "lyinevitab"이 주어지면 "inevitably"를 출력해야 한다.

- Anagrams of all but first and last characters (A1): 모델에 첫 글자와 마지막 글자를 제외한 모든 글자가 무작위로 뒤섞인 단어가 주어지고, 원본 단어를 출력해야 한다. 예시: criroptuon = corruption.

- Anagrams of all but first and last 2 characters (A2): 모델에 처음 2글자와 마지막 2글자를 제외한 모든 글자가 무작위로 뒤섞인 단어가 주어지고, 원본 단어를 복구해야 한다. 예시: opoepnnt opponent.

- Random insertion in word (RI): 단어의 각 글자 사이에 무작위 구두점 또는 공백 문자가 삽입되고, 모델은 원본 단어를 출력해야 한다. 예시: s.u!c/c!e.s s i/o/n = succession.

- Reversed words (RW): 모델에 거꾸로 철자가 쓰인 단어가 주어지고, 원본 단어를 출력해야 한다. 예시: stcejbo objects.

각 task에 대해 우리는 10,000개의 예시를 생성했다. 이 예시들은 [Nor09]에서 측정된 가장 빈번한 상위 10,000개 단어 중 길이가 4자 초과 15자 미만인 단어들을 선택하여 구성되었다. few-shot 결과는 Figure 3.11에 나타나 있다. task 성능은 모델 크기에 따라 꾸준히 증가하는 경향을 보이며, 전체 GPT-3 모델은 무작위 삽입 제거 task에서 66.9%, 글자 순환 task에서 38.6%, 더 쉬운 아나그램 task에서 40.2%, 그리고 **더 어려운 아나그램 task(첫 글자와 마지막 글자만 고정된 경우)에서 15.1%**의 성능을 달성했다. 어떤 모델도 단어의 글자를 거꾸로 뒤집는 task는 수행하지 못했다.

Figure 3.11: 다양한 모델 크기에 대한 5가지 단어 뒤섞기 task의 few-shot 성능. 모델 크기가 커질수록 전반적으로 꾸준한 성능 향상이 나타나며, 특히 random insertion task는 175B 모델에서 대부분의 경우 task를 해결하며 가파른 개선 곡선을 보인다. one-shot 및 zero-shot 성능의 스케일링은 부록에 제시되어 있다. 모든 task는 으로 수행되었다.

Figure 3.11: 다양한 모델 크기에 대한 5가지 단어 뒤섞기 task의 few-shot 성능. 모델 크기가 커질수록 전반적으로 꾸준한 성능 향상이 나타나며, 특히 random insertion task는 175B 모델에서 대부분의 경우 task를 해결하며 가파른 개선 곡선을 보인다. one-shot 및 zero-shot 성능의 스케일링은 부록에 제시되어 있다. 모든 task는 으로 수행되었다.

one-shot 설정에서는 성능이 상당히 약화되었고(절반 이상 감소), zero-shot 설정에서는 모델이 거의 어떤 task도 수행하지 못했다(Table 3.10). 이는 모델이 실제로 테스트 시점에 이러한 task를 학습하는 것으로 보이며, 모델이 zero-shot으로 이들을 수행할 수 없고, 이들의 인위적인 특성상 사전학습 데이터에 나타날 가능성이 낮기 때문이다(확실하게 확인할 수는 없지만).

우리는 **"in-context learning curves"**를 그려 in-context 예시 수에 따른 task 성능을 시각화하여 성능을 더욱 정량화할 수 있다. Figure 1.2에서는 Symbol Insertion task에 대한 in-context learning curves를 보여준다. 우리는 더 큰 모델이 task 예시와 자연어 task 설명 모두를 포함하여 in-context 정보를 점점 더 효과적으로 활용할 수 있음을 확인할 수 있다.

마지막으로, 이러한 task를 해결하려면 문자 수준의 조작이 필요하다는 점을 덧붙일 가치가 있다. 반면 우리의 BPE 인코딩은 단어의 상당 부분(평균적으로 토큰당 약 0.7단어)을 처리하므로, LM의 관점에서 이러한 task를 성공적으로 수행한다는 것은 단순히 BPE 토큰을 조작하는 것을 넘어 그 하위 구조를 이해하고 분해하는 것을 포함한다. 또한, CL, A1, A2는 단사 함수(bijective)가 아니므로(즉, 뒤섞인 단어로부터 원래 단어가 결정론적으로 결정되지 않으므로), 모델이 올바른 원래 단어를 찾기 위해 어느 정도의 탐색을 수행해야 한다. 따라서 관련된 기술은 사소하지 않은 패턴 매칭과 계산 능력을 요구하는 것으로 보인다.

3.9.3 SAT Analogies

일반적인 텍스트 분포와는 다소 이례적인 다른 task에서 GPT-3를 테스트하기 위해, 우리는 374개의 "SAT 유추(analogy)" 문제 세트를 수집했다 [TLBS03]. 유추 문제는 2005년 이전 SAT 대학 입학 시험의 한 섹션을 구성했던 객관식 질문 유형이다. 일반적인 예시는 다음과 같다: "audacious is to boldness as (a) sanctimonious is to hypocrisy, (b) anonymous is to identity, (c) remorseful is to misdeed, (d) deleterious is to result, (e) impressionable is to temptation". 학생은 원래 단어 쌍과 동일한 관계를 가진 다섯 단어 쌍 중 하나를 선택해야 한다. 이 예시의 정답은 "sanctimonious is to hypocrisy"이다.

이 task에서 GPT-3는 few-shot 설정에서 65.2%, one-shot 설정에서 59.1%, **zero-shot 설정에서 53.7%**의 정확도를 달성했으며, 이는 대학 지원자들의 평균 점수 57% [TL05]와 비교된다 (무작위 추측은 20%의 정확도를 보인다). Figure 3.12에서 볼 수 있듯이, 모델 규모가 커질수록 결과가 향상되며, 1,750억 파라미터 모델은 130억 파라미터 모델에 비해 10% 이상 성능이 향상되었다.

Figure 3.12: SAT 유추 task에서 모델 크기별 zero-shot, one-shot, few-shot 성능. 가장 큰 모델은 few-shot 설정에서 65%의 정확도를 달성했으며, 작은 모델에서는 나타나지 않는 in-context learning의 상당한 이점을 보여준다.

Figure 3.12: SAT 유추 task에서 모델 크기별 zero-shot, one-shot, few-shot 성능. 가장 큰 모델은 few-shot 설정에서 65%의 정확도를 달성했으며, 작은 모델에서는 나타나지 않는 in-context learning의 상당한 이점을 보여준다.

3.9.4 News Article Generation

생성형 language model에 대한 이전 연구에서는 사람이 작성한 뉴스 기사의 첫 문장으로 구성된 그럴듯한 prompt를 모델에 제공하여 조건부 샘플링을 통해 합성 "뉴스 기사"를 생성하는 능력을 정성적으로 테스트했다 [RWC19]. [RWC19]와 비교했을 때, GPT-3 학습에 사용된 데이터셋은 뉴스 기사에 대한 가중치가 훨씬 낮기 때문에, 조건 없이(unconditional) raw 샘플을 통해 뉴스 기사를 생성하는 것은 덜 효과적이다. 예를 들어, GPT-3는 종종 "뉴스 기사"의 첫 문장을 트윗으로 해석하고 합성 응답이나 후속 트윗을 게시하기도 한다. 이 문제를 해결하기 위해 우리는 모델의 context에 세 개의 이전 뉴스 기사를 제공하여 GPT-3의 few-shot learning 능력을 활용했다. 제안된 다음 기사의 제목과 부제목이 주어지면, 모델은 "뉴스" 장르의 짧은 기사를 안정적으로 생성할 수 있다.

GPT-3의 뉴스 기사 생성 품질(이는 일반적으로 조건부 샘플 생성 품질과 관련이 있을 것으로 판단됨)을 측정하기 위해, 우리는 GPT-3가 생성한 기사와 실제 기사를 사람이 구별하는 능력을 측정하기로 결정했다. 유사한 연구는 Kreps et al. [KMB20]과 Zellers et al. [ZHR+19]에 의해 수행되었다. 생성형 language model은 사람이 생성한 콘텐츠의 분포와 일치하도록 학습되므로, 사람이 둘을 구별하는 (불)능력은 품질의 잠재적으로 중요한 척도가 될 수 있다.

모델이 생성한 텍스트를 사람이 얼마나 잘 감지할 수 있는지 알아보기 위해, 우리는 newser.com 웹사이트에서 임의로 25개의 기사 제목과 부제목을 선택했다 (평균 길이: 215단어). 그런 다음 125M에서 175B(GPT-3) 파라미터에 이르는 4개의 language model로부터 이 제목과 부제목에 대한 완성을 생성했다 (평균 길이: 200단어). 각 모델에 대해 우리는 약 80명의 미국 기반 참가자에게 실제 제목과 부제목 뒤에 사람이 작성한 기사 또는 모델이 생성한 기사가 이어지는 퀴즈를 제시했다. 참가자들은 기사가 "매우 높은 확률로 사람이 작성함", "높은 확률로 사람이 작성함", "모르겠음", "높은 확률로 기계가 작성함", 또는 "매우 높은 확률로 기계가 작성함" 중 하나를 선택하도록 요청받았다.

우리가 선택한 기사들은 모델의 학습 데이터에 포함되지 않았으며, 모델 출력은 사람이 임의로 선택하는 것을 방지하기 위해 프로그램적으로 형식화되고 선택되었다. 모든 모델은 출력을 조건화하기 위해 동일한 context를 사용했으며, 동일한 context 크기로 사전학습되었고, 각 모델의 prompt로 동일한 기사 제목과 부제목이 사용되었다. 그러나 우리는 참가자의 노력과 주의를 통제하기 위한 실험도 수행했는데, 이는 동일한 형식을 따르지만 의도적으로 품질이 낮은 모델 생성 기사를 포함했다. 이는 **"control model"**에서 기사를 생성함으로써 이루어졌다: context가 없고 출력 무작위성이 증가된 160M 파라미터 모델이다.

| Mean accuracy | 95% Confidence Interval (low, hi) | compared to control ( -value) | "I don't know" assignments | |

|---|---|---|---|---|

| Control (deliberately bad model) | 86% | 83%-90% | - | 3.6 % |

| GPT-3 Small | 76% | 72%-80% | 3.9 (2e-4) | 4.9% |

| GPT-3 Medium | 61% | 58%-65% | 10.3 (7e-21) | 6.0% |

| GPT-3 Large | 68% | 64%-72% | 7.3 (3e-11) | 8.7% |

| GPT-3 XL | 62% | 59%-65% | 10.7 (1e-19) | 7.5% |

| GPT-3 2.7B | 62% | 58%-65% | 10.4 (5e-19) | 7.1% |

| GPT-3 6.7B | 60% | 56%-63% | 11.2 (3e-21) | 6.2% |

| GPT-3 13B | 55% | 52%-58% | 15.3 (1e-32) | 7.1% |

| GPT-3 175B | 52% | 49%-54% | 16.9 (1e-34) | 7.8% |

Table 3.11: 짧은 (~200단어) 뉴스 기사가 모델에 의해 생성되었는지 여부를 식별하는 인간의 정확도. 인간의 정확도(정확한 할당과 비중립적 할당의 비율로 측정)는 control model에서 86%에서 GPT-3 175B에서 52%까지 다양하다. 이 표는 5가지 다른 모델 간의 평균 정확도를 비교하고, 각 모델과 control model(출력 무작위성이 증가된 조건 없는 GPT-3 Small 모델) 간의 평균 정확도 차이에 대한 두 표본 T-Test 결과를 보여준다.

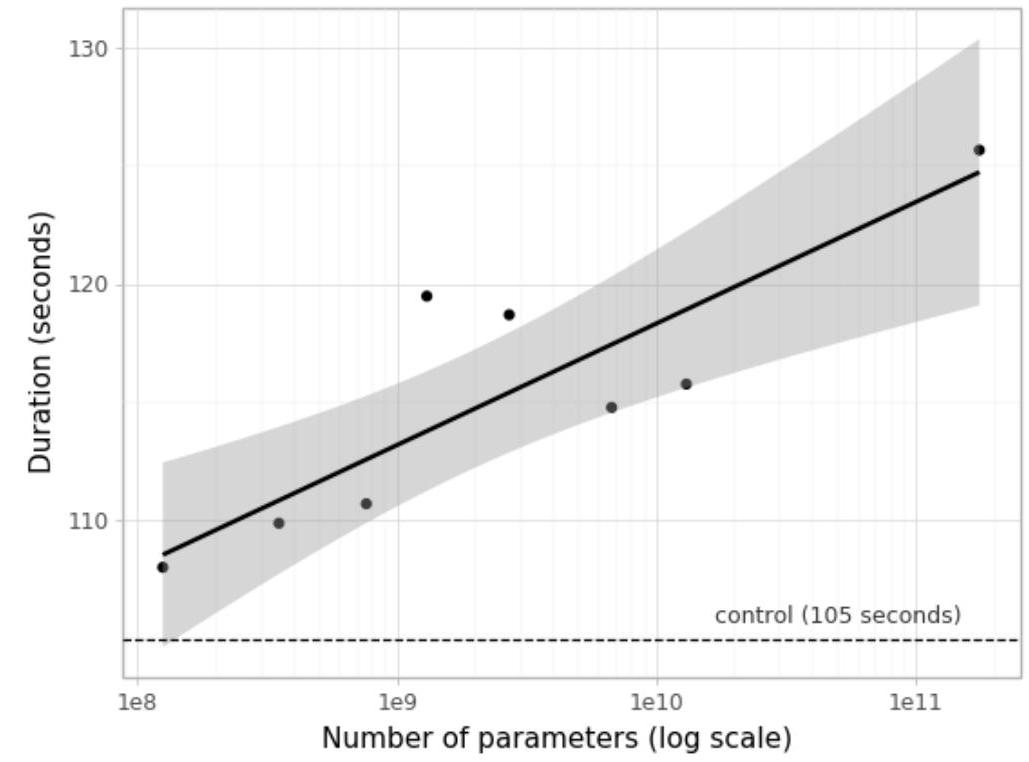

의도적으로 품질이 낮은 기사가 모델에 의해 생성되었음을 감지하는 **인간의 평균 정확도(참가자당 정확한 할당과 비중립적 할당의 비율)는 약 86%**였으며, 50%는 우연 수준의 성능이다. 대조적으로, 175B 파라미터 모델이 생성한 기사를 감지하는 인간의 평균 정확도는 약 52%로 우연 수준을 겨우 넘는 수준이었다 (Table 3.11 참조). 모델이 생성한 텍스트를 감지하는 인간의 능력은 모델 크기가 증가함에 따라 감소하는 것으로 보이며: 모델 크기에 따라 우연 수준의 정확도로 향하는 경향이 있는 것으로 보이며, GPT-3에 대한 인간의 감지 능력은 우연 수준에 가깝다. 이는 참가자들이 모델 크기가 증가함에 따라 각 출력에 더 많은 시간을 할애했음에도 불구하고 사실이다 (Appendix E 참조).

GPT-3가 생성한 합성 기사의 예시는 Figure 3.14 및 3.15에 제시되어 있다. 평가에서 나타났듯이, 텍스트의 상당 부분은 사람이 실제 인간 콘텐츠와 구별하기 어렵다. 사실적 부정확성은 기사가 모델에 의해 생성되었음을 나타내는 지표가 될 수 있는데, 이는 인간 저자와 달리 모델은 기사 제목이 참조하는 특정 사실이나 기사가 작성된 시점에 접근할 수 없기 때문이다. 다른 지표로는 반복, 비논리적 비약(non sequiturs), 특이한 표현 등이 있지만, 이러한 것들은 종종 너무 미묘하여 눈치채지 못하는 경우가 많다.

Ippolito et al. [IDCBE19]의 language model 감지에 대한 관련 연구는 Grover [ZHR19] 및 GLTR [GSR19]와 같은 자동 판별기가 인간 평가자보다 모델 생성 텍스트를 감지하는 데 더 큰 성공을 거둘 수 있음을 나타낸다. 이러한 모델의 자동 감지는 향후 연구의 유망한 분야가 될 수 있다.

Ippolito et al. [IDCBE19]은 또한 사람이 더 많은 토큰을 관찰할수록 모델 생성 텍스트를 감지하는 인간의 정확도가 증가한다고 언급한다. GPT-3 175B가 생성한 더 긴 뉴스 기사를 사람이 얼마나 잘 감지하는지에 대한 예비 조사를 위해, 우리는 평균 길이 569단어의 로이터 통신 세계 뉴스 기사 12개를 선택하고, 평균 길이 498단어(초기 실험보다 298단어 더 김)의 GPT-3로 이 기사들의 완성을 생성했다. 위 방법론에 따라, 우리는 각각 약 80명의 미국 기반 참가자를 대상으로 두 가지 실험을 수행하여 GPT-3와 control model이 생성한 기사를 감지하는 인간의 능력을 비교했다.

control model에서 의도적으로 품질이 낮은 더 긴 기사를 감지하는 **인간의 평균 정확도는 약 88%**였지만, GPT-3 175B가 생성한 더 긴 기사를 감지하는 인간의 평균 정확도는 여전히 약 52%로 우연 수준을 겨우 넘는 수준이었다 (Table 3.12 참조). 이는 약 500단어 길이의 뉴스 기사의 경우, GPT-3가 사람이 작성한 뉴스 기사와 구별하기 어려운 기사를 계속해서 생성한다는 것을 나타낸다.

3.9.5 Learning and Using Novel Words

발달 언어학에서 연구되는 task 중 하나는 새로운 단어를 학습하고 활용하는 능력이다 [CB78]. 예를 들어, 단어의 정의를 한 번만 보고도 문장에서 그 단어를 사용하거나, 반대로 단어의 사용 예시를 한 번만 보고도 그 의미를 추론하는 능력 등이 이에 해당한다. 여기서 우리는 GPT-3가 전자의 능력을 수행하는지 정성적으로 테스트한다. 구체적으로, 우리는 GPT-3에게 "Gigamuru"와 같은 존재하지 않는 단어의 정의를 제공한 다음, 그 단어를 문장에서 사용하도록 요청한다. 우리는 (별개의)

Figure 3.13: 뉴스 기사가 모델 생성인지 여부를 식별하는 사람들의 능력(정확한 할당 대 비중립적 할당 비율로 측정)은 모델 크기가 증가함에 따라 감소한다. 의도적으로 품질이 낮은 대조 모델(출력 무작위성이 높은 무조건 GPT-3 Small 모델)의 출력에 대한 정확도는 상단의 점선으로 표시되어 있으며, 무작위 확률(50%)은 하단의 점선으로 표시되어 있다. 최적 적합선은 95% 신뢰 구간을 가진 멱법칙(power law)이다.

Figure 3.13: 뉴스 기사가 모델 생성인지 여부를 식별하는 사람들의 능력(정확한 할당 대 비중립적 할당 비율로 측정)은 모델 크기가 증가함에 따라 감소한다. 의도적으로 품질이 낮은 대조 모델(출력 무작위성이 높은 무조건 GPT-3 Small 모델)의 출력에 대한 정확도는 상단의 점선으로 표시되어 있으며, 무작위 확률(50%)은 하단의 점선으로 표시되어 있다. 최적 적합선은 95% 신뢰 구간을 가진 멱법칙(power law)이다.

| Mean accuracy | 95% Confidence <br> Interval (low, hi) | compared to <br> control ( -value) | "I don't know" <br> assignments | |

|---|---|---|---|---|

| Control | - | |||

| GPT-3 175B |

Table 3.12: 약 500단어 분량의 기사가 모델 생성인지 여부를 식별하는 사람들의 능력(정확한 할당 대 비중립적 할당 비율로 측정)은 **대조 모델에서 88%였고, GPT-3 175B에서는 52%**였다. 이 표는 GPT-3 175B와 대조 모델(출력 무작위성이 증가된 무조건 GPT-3 Small 모델) 간의 평균 정확도 차이에 대한 두 표본 T-검정 결과를 보여준다.

Title: United Methodists Agree to Historic Split Subtitle: Those who oppose gay marriage will form their own denomination Article: After two days of intense debate, the United Methodist Church has agreed to a historic split - one that is expected to end in the creation of a new denomination, one that will be "theologically and socially conservative," according to The Washington Post. The majority of delegates attending the church's annual General Conference in May voted to strengthen a ban on the ordination of LGBTQ clergy and to write new rules that will "discipline" clergy who officiate at same-sex weddings. But those who opposed these measures have a new plan: They say they will form a separate denomination by 2020, calling their church the Christian Methodist denomination. The Post notes that the denomination, which claims 12.5 million members, was in the early 20th century the "largest Protestant denomination in the U.S.," but that it has been shrinking in recent decades. The new split will be the second in the church's history. The first occurred in 1968, when roughly 10 percent of the denomination left to form the Evangelical United Brethren Church. The Post notes that the proposed split "comes at a critical time for the church, which has been losing members for years," which has been "pushed toward the brink of a schism over the role of LGBTQ people in the church." Gay marriage is not the only issue that has divided the church. In 2016, the denomination was split over ordination of transgender clergy, with the North Pacific regional conference voting to ban them from serving as clergy, and the South Pacific regional conference voting to allow them.

Figure 3.14: 사람들이 인간이 작성한 기사와 구별하는 데 가장 어려움을 겪었던 GPT-3 생성 뉴스 기사 (정확도: 12%).

Title: Star's Tux Promise Draws Megyn Kelly's Sarcasm Subtitle: Joaquin Phoenix pledged to not change for each awards event Article: A year ago, Joaquin Phoenix made headlines when he appeared on the red carpet at the Golden Globes wearing a tuxedo with a paper bag over his head that read, "I am a shape-shifter. I can't change the world. I can only change myself." It was a promise to not change to fit into the Hollywood mold: "I think that's a really special thing, to not change yourself. I think it's a really special thing to say, 'This is what's inside of me, I'm proud of it, and I'm not going to be ashamed because of the way that someone else thinks I should be.'" Now, it's the Oscars, and Phoenix is at it again. But this time, his publicist is saying he'll be wearing a tux no matter what. Megyn Kelly was not impressed, and she let him have it on The Tonight Show. "You know, I feel like, I feel like you could have worn the tux," she says. "But you're saying you're a shape-shifter. I don't know if you can change your tux, but you can change your mind. You can change your mind. You can change your mind." Phoenix says he did, but it didn't stick. "I was like, 'Okay, I'm going to wear a tuxedo to this thing.' And then I thought, 'I don't want to wear a tuxedo to this thing.'" Kelly goes on to encourage him to change his mind again, but Phoenix says it's too late: "I'm committed to wearing this."

Figure 3.15: 사람들이 인간이 작성한 기사와 구별하기 가장 쉬웠던 GPT-3 생성 뉴스 기사 (정확도: 61%).

A "whatpu" is a small, furry animal native to Tanzania. An example of a sentence that uses

the word whatpu is:

We were traveling in Africa and we saw these very cute whatpus.

To do a "farduddle" means to jump up and down really fast. An example of a sentence that uses

the word farduddle is:

One day when I was playing tag with my little sister, she got really excited and she

started doing these crazy farduddles.

A "yalubalu" is a type of vegetable that looks like a big pumpkin. An example of a sentence

that uses the word yalubalu is:

I was on a trip to Africa and I tried this yalubalu vegetable that was grown in a garden

there. It was delicious.

A "Burringo" is a car with very fast acceleration. An example of a sentence that uses the

word Burringo is:

In our garage we have a Burringo that my father drives to work every day.

A "Gigamuru" is a type of Japanese musical instrument. An example of a sentence that uses the

word Gigamuru is:

I have a Gigamuru that my uncle gave me as a gift. I love to play it at home.

To "screeg" something is to swing a sword at it. An example of a sentence that uses the word

screeg is:

We screeghed at each other for several minutes and then we went outside and ate ice cream.

Figure 3.16: 새로운 단어를 문장에서 사용하는 few-shot task에 대한 GPT-3의 대표적인 완성 예시. 굵은 글씨는 GPT-3의 완성 부분이고, 일반 텍스트는 인간의 prompt이다. 첫 번째 예시에서는 prompt와 완성 모두 인간이 제공했으며, 이는 이후 GPT-3가 추가 prompt를 받고 완성을 제공하는 예시들의 조건으로 사용된다. 여기에 제시된 조건 외에는 GPT-3에 task-specific한 어떤 것도 제공되지 않았다. 존재하지 않는 단어가 정의되고 문장에서 사용된 이전 예시를 1개에서 5개까지 제공한다. 따라서 이 task는 광범위한 task의 이전 예시 측면에서는 few-shot이고, 특정 단어 측면에서는 one-shot이다. Table 3.16은 우리가 생성한 6가지 예시를 보여준다. 모든 정의는 인간이 생성했으며, 첫 번째 답변은 조건으로 인간이 생성했고, 이후 답변들은 GPT-3가 생성했다. 이 예시들은 한 번에 연속적으로 생성되었으며, 우리는 어떠한 prompt도 생략하거나 반복적으로 시도하지 않았다. 모든 경우에 생성된 문장은 단어의 정확하거나 적어도 그럴듯한 사용으로 보인다. 마지막 문장에서 모델은 "screeg"라는 단어에 대해 그럴듯한 활용형("screeghed")을 생성하지만, 단어의 사용은 약간 어색하다("screeghed at each other"). 그럼에도 불구하고 장난감 칼싸움을 묘사할 수 있다는 점에서 그럴듯하다. 전반적으로 GPT-3는 새로운 단어를 문장에서 사용하는 task에 적어도 능숙한 것으로 보인다.

3.9.6 Correcting English Grammar

Few-shot learning에 적합한 또 다른 task는 영어 문법 교정이다. 우리는 GPT-3를 사용하여 few-shot 설정에서 이를 테스트했으며, "Poor English Input: <문장> Good English Output: <문장>" 형식의 prompt를 제공했다. 우리는 GPT-3에 사람이 생성한 교정 예시 하나를 주고, 그 다음 5개의 문장을 교정하도록 요청했다 (이때도 누락이나 반복 없이). 결과는 Figure 3.17에 나와 있다.

4 Measuring and Preventing Memorization Of Benchmarks

우리의 학습 데이터셋은 인터넷에서 수집되었기 때문에, 일부 벤치마크 테스트 세트가 학습 데이터에 포함되었을 가능성이 있다. 인터넷 규모의 데이터셋에서 테스트 데이터 오염(contamination)을 정확하게 탐지하는 것은 아직 확립된 모범 사례가 없는 새로운 연구 분야이다. 대규모 모델을 학습할 때 오염 여부를 조사하지 않는 것이 일반적인 관행이지만, 사전학습 데이터셋의 규모가 증가함에 따라 이 문제가 점점 더 중요해지고 있다고 우리는 생각한다.

이러한 우려는 단순히 가설에 그치지 않는다. Common Crawl 데이터로 언어 모델을 학습시킨 최초의 논문 중 하나인 [TL18]은 평가 데이터셋과 겹치는 학습 문서를 탐지하여 제거하였다. GPT-2 [RWC 19]와 같은 다른 연구에서도 사후(post-hoc) 중복 분석을 수행했다. 그들의 연구는 비교적 고무적이었는데, 학습 데이터와 테스트 데이터가 겹치는 부분에서 모델 성능이 다소 더 좋았지만, 오염된 데이터의 비율이 작았기 때문에(대부분 몇 퍼센트에 불과) 보고된 결과에 큰 영향을 미치지 않았다는 것을 발견했다.

GPT-3는 다소 다른 환경에서 작동한다. 한편으로는 데이터셋과 모델 크기가 GPT-2에 사용된 것보다 약 두 자릿수 더 크며, Common Crawl 데이터가 대량 포함되어 있어 오염 및 암기(memorization) 가능성이 증가한다. 다른 한편으로는, 방대한 데이터 양 덕분에 GPT-3 175B조차도 중복 제거된 held-out validation set에 비해 학습 데이터셋에 크게 과적합되지 않는다 (Figure 4.1). 따라서 우리는 오염이 빈번하게 발생할 가능성이 높지만, 그 영향은 우려했던 것만큼 크지 않을 수 있다고 예상한다. 우리는 처음에 학습 데이터와 본 논문에서 연구된 모든 벤치마크의 개발 및 테스트 세트 간의 중복을 사전에 검색하고 제거하여 오염 문제를 해결하려고 시도했다. 불행히도, 버그로 인해 탐지된 모든 중복이 학습 데이터에서 부분적으로만 제거되었다. 학습 비용 때문에 모델을 재학습하는 것은 불가능했다. 이를 해결하기 위해, 우리는 남아있는 탐지된 중복이 결과에 미치는 영향을 자세히 조사했다.

각 벤치마크에 대해, 우리는 잠재적으로 유출된 모든 예시를 제거한 '클린(clean)' 버전을 생성했다. 이는 대략적으로 **사전학습 세트의 어떤 내용과 13-gram 중복이 있는 예시(또는 13-gram보다 짧을 경우 전체 예시와 중복되는 경우)**로 정의된다. 목표는 잠재적인 오염 가능성이 있는 모든 것을 매우 보수적으로 플래그하여, 높은 신뢰도로 오염이 없는 클린 서브셋을 생성하는 것이다. 정확한 절차는 Appendix C에 자세히 설명되어 있다.

그런 다음 우리는 이러한 클린 벤치마크에서 GPT-3를 평가하고, 원래 점수와 비교했다. 클린 서브셋에서의 점수가 전체 데이터셋에서의 점수와 유사하다면, 이는 오염이 존재하더라도 보고된 결과에 유의미한 영향을 미치지 않음을 시사한다. 클린 서브셋에서의 점수가 낮다면, 이는 오염이 결과를 부풀리고 있을 수 있음을 시사한다. 결과는 Figure 4.2에 요약되어 있다. 잠재적 오염 수준이 종종 높음에도 불구하고(벤치마크의 1/4이 50% 이상), 대부분의 경우 성능 변화는 미미했으며, 오염 수준과 성능 차이가 상관관계가 있다는 증거는 발견되지 않았다. 우리는 우리의 보수적인 방법이 오염을 상당히 과대평가했거나, 오염이 성능에 거의 영향을 미치지 않는다고 결론 내린다.

아래에서는 (1) 클린 버전에서 모델 성능이 현저히 떨어지는 경우 또는 (2) 잠재적 오염이 매우 높아 성능 차이를 측정하기 어려운 경우의 몇 가지 특정 사례를 더 자세히 검토한다.

우리의 분석은 추가 조사를 위해 6개 벤치마크 그룹을 플래그했다: Word Scrambling, Reading Comprehension (QuAC, SQuAD2, DROP), PIQA, Winograd, language modeling tasks (Wikitext tasks, 1BW), 그리고 German to English translation. 우리의 중복 분석은 극도로 보수적으로 설계되었기 때문에, 일부 오탐(false positive)을 생성할 것으로 예상한다. 각 task 그룹에 대한 결과는 다음과 같다:

- Reading Comprehension: 우리의 초기 분석은 QuAC, SQuAD2, DROP의 task 예시 중 90% 이상이 잠재적으로 오염된 것으로 플래그했으며, 그 정도가 너무 커서 클린 서브셋에서 차이를 측정하는 것조차 어려웠다. 그러나 수동 검사 결과, 검사한 모든 중복 사례에서 3개 데이터셋 모두에서 원본 텍스트는 학습 데이터에 존재했지만 질문/답변 쌍은 존재하지 않았다. 이는 모델이 배경 정보만 얻고 특정 질문에 대한 답을 암기할 수 없었음을 의미한다.

- German translation: WMT16 독일어-영어 테스트 세트의 예시 중 25%가 잠재적으로 오염된 것으로 플래그되었으며, 관련 총 효과 크기는 1-2 BLEU였다. 검사 결과, 플래그된 예시 중 어떤 것도 NMT 학습 데이터와 유사한 쌍을 이루는 문장을 포함하지 않았으며, 충돌은 대부분 뉴스에서 논의된 사건의 단편적인 단일 언어 일치였다.

- Reversed Words and Anagrams: 이 task들은 "alaok = koala"와 같은 형태임을 상기하라. 이 task들의 길이가 짧기 때문에, 우리는 **2-gram 필터링(구두점 무시)**을 사용했다. 플래그된 중복을 검사한 결과, 이들은 일반적으로 학습 세트에서 실제 역전(reversal) 또는 스크램블 해제(unscrambling) 사례가 아니라, "kayak = kayak"과 같은 회문(palindrome) 또는 사소한 스크램블 해제였다. 중복 양은 적었지만, 사소한 task들을 제거하면 난이도가 증가하여 가짜 신호(spurious signal)가 발생했다. 이와 관련하여, symbol insertion task는 높은 중복을 보였지만 성능에는 영향이 없었다. 이는 해당 task가 단어에서 비문자 문자를 제거하는 것을 포함하며, 중복 분석 자체가 그러한 문자를 무시하여 많은 가짜 일치를 유발하기 때문이다.

- PIQA: 중복 분석은 예시의 29%를 오염된 것으로 플래그했으며, 클린 서브셋에서 **성능이 3%p 절대 감소(4% 상대 감소)**하는 것을 관찰했다. 테스트 데이터셋은 우리의 학습 세트가 생성된 후에 공개되었고 그 레이블은 숨겨져 있지만, 크라우드소싱 데이터셋 생성자가 사용한 일부 웹페이지가 우리의 학습 세트에 포함되어 있다. 우리는 암기 능력이 훨씬 적은 25배 작은 모델에서도 유사한 감소를 발견했으며, 이는 이러한 변화가 암기보다는 통계적 편향일 가능성이 높다는 것을 시사한다. 즉, 작업자들이 복사한 예시들이 단순히 더 쉬웠을 수 있다. 불행히도, 우리는 이 가설을 엄격하게 증명할 수 없다. 따라서 우리는 PIQA 결과에 잠재적 오염을 나타내는 별표(*)를 표시한다.

- Winograd: 중복 분석은 예시의 45%를 플래그했으며, 클린 서브셋에서 성능이 2.6% 감소하는 것을 발견했다. 중복 데이터 포인트를 수동으로 검사한 결과, 132개의 Winograd 스키마가 실제로 우리의 학습 세트에 존재했지만, 모델에 task를 제시하는 방식과는 다른 형식으로 제시되었다. 성능 감소는 작지만, 우리는 본 논문의 Winograd 결과에 별표(*)를 표시한다.

- Language modeling: 우리는 GPT-2에서 측정된 4개의 Wikipedia 언어 모델링 벤치마크와 Children's Book Test 데이터셋이 거의 전적으로 우리의 학습 데이터에 포함되어 있음을 발견했다. 여기서는 클린 서브셋을 안정적으로 추출할 수 없으므로, 이 연구를 시작할 때 의도했음에도 불구하고 이러한 데이터셋에 대한 결과는 보고하지 않는다. Penn Tree Bank는 오래되었기 때문에 영향을 받지 않았으며, 따라서 우리의 주요 언어 모델링 벤치마크가 되었다.

우리는 또한 오염 수준은 높지만 성능에 미치는 영향이 거의 0에 가까운 데이터셋도 검사하여 실제 오염이 얼마나 존재하는지 확인했다. 이러한 데이터셋들은 종종 오탐(false positive)을 포함하는 것으로 나타났다. 실제 오염이 없거나, task의 답을 유출하지 않는 오염이 있었다. 한 가지 주목할 만한 예외는 LAMBADA였는데, 상당한 실제 오염이 있는 것으로 보였지만 성능에 미치는 영향은 매우 작았으며, 클린 서브셋의 점수가 전체 데이터셋의 0.5% 이내였다. 또한, 엄밀히 말하면, 우리의 빈칸 채우기(fill-in-the-blank) 형식은 가장 단순한 형태의 암기를 배제한다. 그럼에도 불구하고, 본 논문에서 LAMBADA에서 매우 큰 성능 향상을 이루었기 때문에, 잠재적 오염은 결과 섹션에 명시되어 있다. 우리의 오염 분석의 중요한 한계는 클린 서브셋이 원본 데이터셋과 동일한 분포에서 추출되었는지 확신할 수 없다는 점이다. 암기가 결과를 부풀리지만 동시에 클린 서브셋을 더 쉽게 만드는 통계적 편향에 의해 정확히 상쇄될 가능성은 여전히 존재한다. 그러나 0에 가까운 변화의 수가 매우 많다는 점은 이러한 가능성이 낮음을 시사하며, 우리는 암기할 가능성이 낮은 작은 모델에서도 변화에 눈에 띄는 차이가 없음을 관찰했다. 전반적으로, 우리는 데이터 오염의 영향을 측정하고 문서화하며, 문제성 있는 결과를 심각도에 따라 명시하거나 완전히 제거하기 위해 최선을 다했다. 벤치마크를 설계할 때와 모델을 학습할 때 모두, 이 중요하고 미묘한 문제를 해결하기 위해 일반적으로 이 분야에서 많은 연구가 남아있다. 우리의 분석에 대한 더 자세한 설명은 Appendix C를 참조하라.

Poor English input: I eated the purple berries.

Good English output: I ate the purple berries.

Poor English input: Thank you for picking me as your designer. I'd appreciate it.

Good English output: Thank you for choosing me as your designer. I appreciate it.

Poor English input: The mentioned changes have done. or I did the alteration that you

requested. or I changed things you wanted and did the modifications.

Good English output: The requested changes have been made. or I made the alteration that you

requested. or I changed things you wanted and made the modifications.

Poor English input: I'd be more than happy to work with you in another project.

Good English output: I'd be more than happy to work with you on another project.

Poor English input: Please provide me with a short brief of the design you're looking for and

that'd be nice if you could share some examples or project you did before.

Good English output: Please provide me with a brief description of the design you're

looking for and that would be nice if you could share some examples or projects you have

done before.

Poor English input: The patient was died.

Good English output: The patient died.

Poor English input: We think that Leslie likes ourselves.

Good English output: We think that Leslie likes us.

Poor English input: Janet broke Bill on the finger.

Good English output: Janet broke Bill's finger.

Poor English input: Mary arranged for, in St. Louis, John to rent a house cheap.

Good English output: Mary arranged for John to rent a house in St. Louis.

Poor English input: Today I have went to the store to to buys some many bottle of water.

Good English output: Today I went to the store to buy some bottles of water.

Poor English input: I have tried to hit ball with bat, but my swing is has miss.

Good English output: I tried to hit the ball with the bat, but my swing missed.

Figure 3.17: 영어 문법 교정 few-shot task에 대한 대표적인 GPT-3 완성 예시. 굵은 글씨는 GPT-3의 완성 부분이고, 일반 텍스트는 사람이 제공한 prompt이다. 처음 몇 예시에서는 prompt와 완성 모두 사람이 제공했으며, 이는 GPT-3가 연속적으로 추가 prompt를 받고 완성을 제공하는 후속 예시들의 조건으로 사용된다. GPT-3에는 처음 몇 예시와 "Poor English input/Good English output"이라는 틀 외에는 task-specific한 어떤 것도 제공되지 않는다. 우리는 "poor"와 "good" 영어(및 그 용어 자체)의 구분이 복잡하고, 맥락적이며, 논쟁의 여지가 있음을 지적한다. 집 임대와 관련된 예시에서 볼 수 있듯이, 모델이 "good"이 무엇인지에 대해 만드는 가정은 심지어 오류를 유발할 수도 있다(여기서 모델은 문법을 조정할 뿐만 아니라 의미를 변경하는 방식으로 "cheap"이라는 단어를 제거한다).

Figure 4.1: GPT-3 학습 곡선. 우리는 학습 분포의 중복 제거된 검증 분할에서 학습 중 모델 성능을 측정한다. 학습과 검증 성능 사이에 약간의 차이가 있지만, 이 차이는 모델 크기와 학습 시간에 따라 최소한으로만 증가하며, 이는 대부분의 차이가 과적합보다는 난이도 차이에서 비롯됨을 시사한다.

Figure 4.1: GPT-3 학습 곡선. 우리는 학습 분포의 중복 제거된 검증 분할에서 학습 중 모델 성능을 측정한다. 학습과 검증 성능 사이에 약간의 차이가 있지만, 이 차이는 모델 크기와 학습 시간에 따라 최소한으로만 증가하며, 이는 대부분의 차이가 과적합보다는 난이도 차이에서 비롯됨을 시사한다.

Figure 4.2: 벤치마크 오염 분석. 우리는 학습 세트의 잠재적 오염을 확인하기 위해 각 벤치마크의 클린 버전을 구성했다. x축은 데이터셋 중 높은 신뢰도로 클린하다고 알려진 부분의 보수적인 하한선이며, y축은 검증된 클린 서브셋에서만 평가했을 때의 성능 차이를 보여준다. 대부분의 벤치마크에서 성능은 미미하게 변했지만, 일부는 추가 검토를 위해 플래그되었다. 검사 결과 PIQA 및 Winograd 결과의 오염에 대한 일부 증거를 발견했으며, 해당 결과는 섹션 3에 별표로 표시한다. 다른 벤치마크가 영향을 받았다는 증거는 발견되지 않았다.

Figure 4.2: 벤치마크 오염 분석. 우리는 학습 세트의 잠재적 오염을 확인하기 위해 각 벤치마크의 클린 버전을 구성했다. x축은 데이터셋 중 높은 신뢰도로 클린하다고 알려진 부분의 보수적인 하한선이며, y축은 검증된 클린 서브셋에서만 평가했을 때의 성능 차이를 보여준다. 대부분의 벤치마크에서 성능은 미미하게 변했지만, 일부는 추가 검토를 위해 플래그되었다. 검사 결과 PIQA 및 Winograd 결과의 오염에 대한 일부 증거를 발견했으며, 해당 결과는 섹션 3에 별표로 표시한다. 다른 벤치마크가 영향을 받았다는 증거는 발견되지 않았다.

5 Limitations

GPT-3와 이에 대한 우리의 분석은 여러 한계점을 가지고 있다. 아래에서는 이러한 한계점 중 일부를 설명하고 향후 연구 방향을 제안한다.

첫째, GPT-3는 특히 이전 모델인 GPT-2에 비해 정량적, 정성적으로 크게 개선되었음에도 불구하고, 텍스트 합성 및 여러 NLP task에서 여전히 눈에 띄는 약점을 보인다. 텍스트 합성의 경우, 전반적인 품질은 높지만, GPT-3가 생성한 텍스트는 문서 수준에서 의미적으로 반복되거나, 충분히 긴 구절에서 일관성을 잃거나, 스스로 모순되거나, 때로는 비논리적인 문장이나 단락을 포함하기도 한다. 우리는 GPT-3의 텍스트 합성 능력의 한계와 강점을 더 잘 이해할 수 있도록 선별되지 않은(uncurated) 무조건적(unconditional) 샘플 500개를 공개할 예정이다. 이산 언어(discrete language) task 영역 내에서, 우리는 GPT-3가 "상식적인 물리(common sense physics)" 문제에 특히 어려움을 겪는 것으로 비공식적으로 관찰했다. 비록 이 영역을 테스트하는 일부 데이터셋(예: PIQA [BZB19])에서는 좋은 성능을 보였음에도 말이다. 구체적으로 GPT-3는 "치즈를 냉장고에 넣으면 녹을까?"와 같은 유형의 질문에 어려움을 겪는다. 정량적으로, GPT-3의 in-context learning 성능은 Section 3에서 설명된 바와 같이 우리의 벤치마크 스위트에서 몇 가지 눈에 띄는 격차를 보인다. 특히, **두 단어가 문장에서 같은 방식으로 사용되었는지, 또는 한 문장이 다른 문장을 함의하는지(각각 WIC 및 ANLI)**와 같은 일부 "비교" task, 그리고 읽기 이해(reading comprehension) task의 일부 하위 집합에서는 one-shot 또는 심지어 few-shot 평가에서도 무작위 수준보다 거의 나은 성능을 보이지 못한다. 이는 GPT-3가 다른 많은 task에서 강력한 few-shot 성능을 보이는 것을 고려할 때 특히 두드러진다.

GPT-3는 몇 가지 구조적 및 알고리즘적 한계를 가지고 있으며, 이는 위에서 언급된 문제들의 일부 원인이 될 수 있다. 우리는 autoregressive language model에서 in-context learning 행동을 탐구하는 데 중점을 두었다. 이는 이 모델 클래스로 샘플링 및 likelihood 계산이 모두 간단하기 때문이다. 결과적으로 우리의 실험에는 어떤 bidirectional 아키텍처나 denoising과 같은 다른 학습 목표가 포함되지 않았다. 이는 최근 문헌의 많은 부분과 눈에 띄는 차이점인데, 최근 연구들은 이러한 접근 방식이 표준 언어 모델보다 fine-tuning 성능을 향상시킨다고 보고하고 있다 [RSR19]. 따라서 우리의 설계 결정은 경험적으로 bidirectionality의 이점을 얻는 task에서 잠재적으로 더 나쁜 성능을 초래할 수 있다. 여기에는 빈칸 채우기(fill-in-the-blank) task, 두 가지 내용을 비교하는 task, 또는 긴 구절을 다시 읽거나 신중하게 고려한 후 매우 짧은 답변을 생성해야 하는 task가 포함될 수 있다. 이는 GPT-3가 **WIC(두 문장에서 단어의 사용을 비교하는 task), ANLI(두 문장을 비교하여 하나가 다른 하나를 함의하는지 확인하는 task), 그리고 여러 읽기 이해 task(예: QuAC 및 RACE)**와 같은 몇몇 task에서 few-shot 성능이 뒤처지는 가능한 설명이 될 수 있다. 우리는 또한 과거 문헌을 바탕으로, 대규모 bidirectional 모델이 GPT-3보다 fine-tuning에서 더 강력할 것이라고 추측한다. GPT-3 규모의 bidirectional 모델을 만들거나, few-shot 또는 zero-shot 학습으로 bidirectional 모델을 작동시키려는 시도는 향후 연구를 위한 유망한 방향이며, "두 가지 장점을 모두 얻는(best of both worlds)" 데 도움이 될 수 있다.