Adaptive-RAG: 질문 복잡도에 따라 Retrieval-Augmented LLM을 동적으로 조절하기

기존의 Retrieval-Augmented Large Language Models (LLMs)는 모든 질문에 동일한 전략을 사용하여 비효율적인 경우가 많습니다. Adaptive-RAG는 질문의 복잡도를 먼저 판단하고, 그에 맞춰 No-Retrieval, Single-step, Multi-step RAG 전략 중 가장 적합한 것을 동적으로 선택하는 프레임워크입니다. 이 접근법은 Classifier를 통해 질문의 난이도를 분류하여 QA 시스템의 전반적인 정확도와 효율성을 크게 향상시킵니다. 논문 제목: Adaptive-RAG: Learning to Adapt Retrieval-Augmented Large Language Models through Question Complexity

Jeong, Soyeong, et al. "Adaptive-rag: Learning to adapt retrieval-augmented large language models through question complexity." arXiv preprint arXiv:2403.14403 (2024).

Adaptive-RAG: Learning to Adapt Retrieval-Augmented Large Language Models through Question Complexity

Soyeong Jeong Jinheon Baek Sukmin Cho Sung Ju Hwang Jong C. Park <br>School of Computing Graduate School of <br>Korea Advanced Institute of Science and Technology <br>{starsuzi,jinheon.baek,nelllpic,sjhwang82,jongpark}@kaist.ac.kr

Abstract

Retrieval-Augmented Large Language Models (LLMs)는 외부 지식 베이스의 비모수적 지식(non-parametric knowledge)을 LLM에 통합하여 Question-Answering (QA)과 같은 여러 task에서 응답 정확도를 향상시키는 유망한 접근 방식으로 부상했다. 그러나 다양한 복잡도의 쿼리를 처리하는 여러 접근 방식이 있음에도 불구하고, 이들은 불필요한 계산 오버헤드로 간단한 쿼리를 처리하거나 복잡한 다단계 쿼리를 적절하게 해결하지 못하는 한계가 있다. 하지만 모든 사용자 요청이 단순히 간단하거나 복잡한 범주 중 하나에만 속하는 것은 아니다.

본 연구에서는 쿼리 복잡도에 따라 가장 적합한 (retrieval-augmented) LLM 전략을 동적으로 선택할 수 있는 새로운 적응형 QA 프레임워크를 제안한다. 이 프레임워크는 가장 간단한 전략부터 가장 정교한 전략까지 아우른다. 또한, 이러한 선택 과정은 분류기(classifier)를 통해 작동한다. 이 분류기는 실제 모델의 예측 결과와 데이터셋의 내재된 귀납적 편향(inductive biases)으로부터 자동으로 수집된 레이블을 사용하여 들어오는 쿼리의 복잡도 수준을 예측하도록 학습된 더 작은 LM이다. 이 접근 방식은 반복적인(iterative) retrieval-augmented LLM과 단일 단계(single-step) retrieval-augmented LLM, 그리고 no-retrieval 방식 사이를 쿼리 복잡도에 따라 유연하게 전환하며 균형 잡힌 전략을 제공한다.

우리는 다양한 쿼리 복잡도를 포함하는 오픈 도메인 QA 데이터셋에 대해 모델을 검증했으며, 우리의 접근 방식이 적응형 검색(adaptive retrieval) 접근 방식을 포함한 관련 baseline들과 비교하여 QA 시스템의 전반적인 효율성과 정확도를 향상시킨다는 것을 보여준다. 코드는 다음에서 확인할 수 있다: https:// github.com/starsuzi/Adaptive-RAG.

1 Introduction

최근 Large Language Model (LLM) (Brown et al., 2020; OpenAI, 2023; Touvron et al., 2023; Anil et al., 2023)은 질의응답(QA) (Yang et al., 2018; Kwiatkowski et al., 2019)을 포함한 다양한 task에서 압도적인 성능을 보여주었다.

Figure 1: 다양한 retrieval-augmented generation 접근 방식에 대한 QA 성능(F1) 및 효율성(Time/Query). 기본 LLM으로 GPT-3.5-Turbo-Instruct를 사용했다.

Figure 1: 다양한 retrieval-augmented generation 접근 방식에 대한 QA 성능(F1) 및 효율성(Time/Query). 기본 LLM으로 GPT-3.5-Turbo-Instruct를 사용했다.

그러나 LLM은 지식이 오직 parametric memory에만 의존하기 때문에 여전히 사실과 다른 답변을 생성하는 경향이 있다 (Kasai et al., 2022; Mallen et al., 2023). 한편, 끊임없이 변화하는 세상의 모든 지식을 기억하는 것은 불가능할 수 있다. 이 문제를 해결하기 위해, 추가적인 retrieval 모듈을 통해 LLM에 비 parametric 지식을 통합하는 retrieval-augmented LLM (Borgeaud et al., 2022; Izacard et al., 2023; Shi et al., 2023)이 많은 주목을 받고 있다. 특히, 이 모델들은 다양한 주제와 분야에 걸쳐 광범위한 정보 저장소 역할을 하는 지식 베이스에 접근하여 주어진 입력과 관련된 정보를 검색하고, 검색된 정보를 LLM에 통합함으로써 세상의 지식에 대해 정확하고 최신 상태를 유지할 수 있도록 한다.

retrieval-augmented LLM의 특히 중요한 응용 분야는 QA task 처리이다. QA task의 목표는 사용자 쿼리, 특히 높은 복잡성을 가진 쿼리에 대해 정확한 답변을 제공하는 것이다. retrieval-augmented LLM에 대한 초기 연구는 주로 단일 문서 내에서 답변을 찾을 수 있는 single-hop 쿼리 (Lazaridou et al., 2022; Ram et al., 2023)에 초점을 맞추었다. 따라서 이 접근 방식은 쿼리에 기반하여 관련 문서를 검색하고, 이 정보를 QA 모델에 통합하여 답변을 생성하는 과정을 포함한다. 그러나 이러한 single-hop QA와 달리, 일부 쿼리는 여러 문서를 연결하고 통합해야 하며, 이는 또한 단일 검색-응답 과정으로는 답변할 수 없는 경우가 많다.

Figure 2: 질문 답변에 대한 다양한 retrieval-augmented LLM 접근 방식의 개념적 비교. (A) 쿼리에 응답하여 관련 문서를 검색한 다음 답변을 생성하는 단일 단계 접근 방식. 그러나 다단계 추론이 필요한 복잡한 쿼리에는 충분하지 않을 수 있다. (B) 이 다단계 접근 방식은 문서를 반복적으로 검색하고 중간 답변을 생성하는데, 이는 강력하지만 LLM과 retriever 모두에 여러 번 접근해야 하므로 간단한 쿼리에는 비효율적이다. (C) 우리의 적응형 접근 방식은 분류기가 결정한 주어진 쿼리의 복잡성에 따라 반복적, 단일, 심지어 검색 없는 접근 방식에 이르기까지 retrieval-augmented LLM에 가장 적합한 전략을 선택할 수 있다.

Figure 2: 질문 답변에 대한 다양한 retrieval-augmented LLM 접근 방식의 개념적 비교. (A) 쿼리에 응답하여 관련 문서를 검색한 다음 답변을 생성하는 단일 단계 접근 방식. 그러나 다단계 추론이 필요한 복잡한 쿼리에는 충분하지 않을 수 있다. (B) 이 다단계 접근 방식은 문서를 반복적으로 검색하고 중간 답변을 생성하는데, 이는 강력하지만 LLM과 retriever 모두에 여러 번 접근해야 하므로 간단한 쿼리에는 비효율적이다. (C) 우리의 적응형 접근 방식은 분류기가 결정한 주어진 쿼리의 복잡성에 따라 반복적, 단일, 심지어 검색 없는 접근 방식에 이르기까지 retrieval-augmented LLM에 가장 적합한 전략을 선택할 수 있다.

예를 들어, 'Malakoff를 점령한 사람들은 Philipsburg가 위치한 지역에 언제 왔는가?'와 같은 쿼리는 해결하는 데 네 단계의 추론이 필요하다. 따라서 이러한 복잡한 쿼리를 효과적으로 처리하기 위해 최근 연구들은 LLM과 retriever 모두에 여러 번 반복적으로 접근해야 하는 multi-step 및 multi-reasoning QA에 주로 집중해왔으며 (Press et al., 2023; Trivedi et al., 2023), 이는 막대한 계산 오버헤드를 수반한다.

하지만 우리는 다시 생각해봐야 한다: 실제 시나리오에서 사용자의 모든 요청이 복잡할까? 오히려 사용자는 종종 간단하고 직접적인 질문을 하고, 가끔 복잡한 질문을 할 수도 있다. 구체적으로, '파리는 어느 나라의 수도인가?'와 같은 쿼리는 앞서 언급된 multi-step 쿼리보다 더 자주 질문될 가능성이 높으며, 이러한 간단한 쿼리는 외부 지식에 접근하지 않고도 LLM 자체로 쉽게 답변될 수 있다. 즉, multi-step QA 접근 방식은 복잡한 쿼리에는 필수적이지만, 간단한 쿼리에는 불필요한 계산 오버헤드를 발생시킬 수 있다 (Figure 2 (A) 참조). 반면에, single-step-retrieval 또는 심지어 non-retrieval 전략으로 복잡한 쿼리를 처리하는 것은 크게 불충분할 것이다 (Figure 2 (B)). 이는 쿼리 복잡성에 따라 retrieval-augmented LLM의 운영 전략을 동적으로 조정할 수 있는 적응형 QA 시스템의 필요성을 시사한다. 최근 일부 접근 방식은 쿼리 내 엔티티의 빈도 (Mallen et al., 2023; Zhao et al., 2023) 또는 multi-step QA를 위한 모델의 생성된 출력 (Trivedi et al., 2023)에 기반하여 이를 수행할 수 있지만, 여전히 최적화되지 않았다: 전자의 방법은 multi-hop 쿼리를 고려하지 못하는 지나치게 단순한 방식이며, 후자는 여러 번의 모듈 접근 후에 답변 해결 단계를 종료하는 지나치게 복잡한 방식이다.

본 연구에서는 실제 쿼리의 다양한 복잡성 수준을 고려하여, 기존의 획일적인(one-size-fits-all) 접근 방식이 모든 쿼리를 포괄하기에는 부적절할 수 있다고 주장한다. 대신, 우리는 입력 쿼리의 특정 복잡성에 맞춰진 다양한 (retrieval-augmented) LLM 전략 중에서 가장 적합한 전략을 선택할 것을 제안한다. 특히, 이 과정에서 중요한 단계는 쿼리 복잡성을 미리 정의하는 것으로, 이는 가장 적합한 모델을 결정하는 데 중요한 역할을 한다. 본 연구에서는 이 과정을 새로운 분류기(classifier)를 통해 구현한다. 이 분류기는 들어오는 쿼리의 복잡성 수준을 예측하도록 학습된 더 작은 모델이다 (Figure 2 (c) 참조). 또한, 우리는 예측된 결과(즉, 어떤 모델이 어떤 쿼리에 정확하게 응답하는지)를 활용하고, 기존 데이터셋의 내재된 편향(즉, 데이터셋의 샘플이 single-step 또는 multi-step QA 시나리오를 위해 설계되었다는 점)을 활용하여 사람의 라벨링 없이 자동으로 학습 데이터셋을 수집한다. 이 제안된 방법은 복잡한 쿼리를 위한 반복적인 LLM 증강 방법, 간단한 쿼리를 위한 single-step 방법, 그리고 가장 간단한 쿼리(LLM 자체로 답변 가능한)를 위한 retrieval-augmented 없는 방법 사이에서 강력한 중간 지점을 제공하여, Figure 1에서 보여주듯이 전반적인 효율성과 정확성을 크게 향상시킬 수 있다. 우리는 우리의 프레임워크를 **Adaptive Retrieval-Augmented Generation (Adaptive-RAG)**이라고 부른다.

우리는 single-hop (Rajpurkar et al., 2016; Joshi et al., 2017; Kwiatkowski et al., 2019)부터 multi-hop (Yang et al., 2018; Ho et al., 2020; Trivedi et al., 2022b) 쿼리까지 광범위한 쿼리 복잡성을 포괄하는 벤치마크 open-domain QA 데이터셋을 사용하여 Adaptive-RAG를 검증한다. 실험 결과는 우리의 방법이 GPT-3.5 (Brown et al., 2020) 및 FLAN-T5 시리즈 (Chung et al., 2022)와 같은 여러 LLM에서 기존의 적응형 전략에 비해 전반적인 정확성과 효율성을 크게 향상시킨다는 것을 보여준다.

우리의 기여와 발견은 세 가지이다:

- 우리는 다양한 복잡성을 가진 쿼리의 현실적인 시나리오를 지적하고, 기존의 retrieval-augmented generation 접근 방식이 지나치게 단순하거나 복잡한 경향이 있음을 발견한다.

- 우리는 분류기가 평가한 쿼리 복잡성에 따라 retrieval-augmented LLM을 조정하여, 각 쿼리에 가장 적합한 접근 방식을 활용할 수 있도록 한다.

- 우리는 우리의 Adaptive-RAG가 다양한 쿼리에 대해 복잡성과 단순성 사이의 균형을 맞추어 매우 효과적이고 효율적임을 보여준다.

2 Related Work

Open-domain QA

Open-domain QA는 쿼리 관련 문서를 찾아 정확하게 답변을 제공하는 task로, 일반적으로 리트리버(retriever) (Karpukhin et al., 2020; Xiong et al., 2021)와 리더(reader) (Yang et al., 2019; Izacard and Grave, 2021; Jeong et al., 2023)의 두 가지 모듈을 포함한다 (Chen et al., 2017; Zhu et al., 2021).

수십억 개의 파라미터 덕분에 뛰어난 추론 능력을 갖춘 **LLM(Large Language Model)**의 등장과 함께 (Wei et al., 2022a), LLM과 리트리버 간의 시너지 효과는 상당한 발전을 가져왔다 (Lazaridou et al., 2022; Ram et al., 2023). 특히, 이러한 통합은 리더의 강화된 추론 능력과 검색된 외부 문서 활용을 통해 LLM의 환각(hallucination) 문제를 완화함으로써 Open-domain QA 성능을 향상시키는 것으로 나타났다 (Cho et al., 2023).

그러나 단일 홉(single-hop) 검색 증강 LLM에 대한 이러한 발전에도 불구하고, 일부 쿼리의 복잡성은 더 복잡한 전략을 필요로 한다.

Multi-hop QA

Multi-hop QA는 기존 Open-domain QA의 확장으로, **더 복잡한 쿼리에 답하기 위해 여러 문서에서 정보를 종합적으로 수집하고 맥락화(contextualize)하는 능력(종종 반복적으로)**을 추가적으로 요구한다 (Trivedi et al., 2022a; Yang et al., 2018).

Multi-hop QA 영역에서는 LLM과 검색 모듈을 반복적으로 접근하는 방식이 일반적으로 사용된다. 구체적으로, Khattab et al. (2022), Press et al. (2023), Pereira et al. (2023), Khot et al. (2023)은 multi-hop 쿼리를 더 간단한 single-hop 쿼리로 먼저 분해하고, LLM과 리트리버에 반복적으로 접근하여 이러한 하위 쿼리(sub-queries)를 해결한 다음, 그 해결책들을 병합하여 완전한 답변을 구성하는 방식을 제안했다.

이러한 분해 기반 접근 방식과 대조적으로, Yao et al. (2023) 및 Trivedi et al. (2023)과 같은 다른 최근 연구들은 Chain-of-Thought 추론(논리적인 사고의 시퀀스를 생성하는 방법) (Wei et al., 2022b)과 문서 검색을 교차(interleave)하여 적용하고, 추론 체인이 답변을 생성할 때까지 이 과정을 반복하는 방식을 탐구했다. 또한, Jiang et al. (2023)은 생성된 문장 내 토큰의 신뢰도가 낮을 경우 새로운 문서를 반복적으로 검색하는 접근 방식을 도입했다.

그러나 앞서 언급된 방법들은 실제 시나리오에서 쿼리의 복잡성이 매우 다양하다는 사실을 간과했다. 따라서 단일 검색 단계 또는 LLM 자체만으로도 충분히 간단할 수 있는 모든 쿼리에 대해 LLM과 리트리버에 반복적으로 접근하는 것은 매우 비효율적일 수 있다.

Adaptive Retrieval

다양한 복잡성의 쿼리를 처리하기 위해, Adaptive Retrieval 전략은 각 쿼리의 복잡성에 따라 문서를 검색할지 여부를 동적으로 결정하는 것을 목표로 한다.

이러한 맥락에서 Mallen et al. (2023)은 쿼리 엔티티의 빈도에 따라 쿼리의 복잡성 수준을 결정하고, 빈도가 특정 임계값 이하로 떨어질 때만 검색 모듈을 사용할 것을 제안했다. 그러나 검색 여부의 이진 결정에만 초점을 맞춘 이 접근 방식은 여러 추론 단계를 필요로 하는 더 복잡한 쿼리에는 충분하지 않을 수 있다.

또한, Qi et al. (2021)은 주어진 쿼리에 대한 답변이 도출될 때까지 고정된 일련의 작업(검색, 읽기, 재순위화)을 여러 번 수행하는 접근 방식을 제안했으며, 이는 전통적인 BERT-like LLM을 기반으로 한다. 그러나 쿼리 복잡성을 미리 결정하고 그에 따라 모든 상용 LLM의 작동 방식을 조정하는 우리의 Adaptive-RAG와 달리, 이 접근 방식은 복잡성에 관계없이 모든 쿼리에 동일한 고정된 작업을 적용할 뿐만 아니라 LLM에 대한 추가적인 특정 학습을 필요로 한다.

우리 연구와 동시에 진행된 Asai et al. (2024)의 연구는 동적으로 텍스트를 검색, 비평, 생성하는 정교한 모델을 학습할 것을 제안했다. 그럼에도 불구하고, 우리는 단일 모델에 의존하는 앞서 언급된 모든 Adaptive Retrieval 방법들이 다양한 복잡성의 쿼리를 처리하는 데 최적화되지 않을 수 있다고 주장한다. 왜냐하면 이러한 방법들은 모든 입력 쿼리에 대해 지나치게 단순하거나 복잡한 경향이 있기 때문이다. 이는 쿼리 복잡성에 맞춰 가장 적합한 검색 증강 LLM 전략을 선택할 수 있는 새로운 접근 방식을 요구한다.

3 Method

이 섹션에서는 **검색 증강 LLM(retrieval-augmented LLM)**을 적용하는 우리의 접근 방식을 설명한다. 이 방식은 쿼리 복잡도를 미리 결정한 다음, 검색 증강 LLM에 가장 적합한 전략을 선택하는 방식으로 이루어진다.

3.1 Preliminaries

우리는 먼저 검색 증강(retrieval-augmented) LLM의 다양한 전략을 공식적으로 소개하며 예비 지식을 다룬다.

QA를 위한 비검색(Non Retrieval) 방식

먼저 LLM을 입력으로 토큰 시퀀스 를 받아 출력으로 토큰 시퀀스 를 생성하는 모델로 정의하자: .

QA 문제 설정에서 와 는 각각 사용자로부터의 **입력 쿼리()**와 **LLM이 생성한 답변()**이 된다: 및 .

따라서 가장 기본적인 LLM 기반 QA 모델은 다음과 같이 표현될 수 있다: .

이상적으로 는 실제 정답 와 일치해야 한다.

이러한 비검색 기반 QA 방식은 매우 효율적이며, LLM의 크기가 방대해지면서 많은 양의 지식을 저장하는 효과를 통해 쉬운 쿼리를 처리하는 데 유망한 접근 방식이 될 수 있다.

그러나 이 방식은 특정 인물, 사건 또는 LLM의 내부 지식을 넘어서는 주제에 대한 정확하거나 최신 지식을 요구하는 쿼리에서는 상당히 문제가 발생한다.

QA를 위한 단일 단계(Single-step) 접근 방식

LLM 자체만으로는 답변하기 어려운 쿼리에서 LLM이 어려움을 겪을 수 있는 앞서 언급된 시나리오를 해결하기 위해, 우리는 외부 지식 를 활용할 수 있다. 이 는 수백만 개의 문서로 구성된 백과사전(예: Wikipedia)과 같은 외부 지식 소스 에서 검색된, 쿼리에 유용한 정보를 포함한다.

구체적으로, 에서 이러한 를 얻기 위해서는 주어진 쿼리와의 관련성을 기반으로 문서를 반환하는 특정 검색 모델이 필요하다. 이 과정은 다음과 같이 공식화될 수 있다: , 여기서 Retriever는 검색 모델이며, 이다. 여기서는 기성(off-the-shelf) 검색기 (Robertson et al., 1994; Karpukhin et al., 2020)를 사용할 수 있다.

검색 단계가 완료되면, 이제 쿼리 와 그에 관련된 문서 쌍을 얻게 된다.

그런 다음, 검색된 이 외부 지식으로 LLM을 증강하기 위해, 이를 LLM의 입력에 통합할 수 있으며, 이는 다음과 같이 표현된다: .

이 과정은 LLM이 에 포함된 외부 정보에 접근할 수 있도록 하여, LLM의 내부 지식이 부족한 보충적인 맥락을 제공하고, 결과적으로 QA에 대한 LLM의 정확성과 최신성을 향상시킬 수 있다.

QA를 위한 다단계(Multi-step) 접근 방식

앞서 언급된 단일 단계 접근 방식이 외부 지식을 요구하는 쿼리 에 대해 비검색 방식보다 상당한 개선을 제공함에도 불구하고, 특히 여러 소스 문서의 정보를 종합하고 이를 기반으로 추론해야 하는 복잡한 쿼리를 처리할 때 주목할 만한 한계에 직면한다. 바로 이 지점에서 다단계 접근 방식과 QA를 위한 추론이 필수적이 된다.

이 다단계 접근 방식에서 LLM은 여러 차례에 걸쳐 Retriever와 상호작용하며, 쿼리 에 대한 이해를 점진적으로 정제하고, 이 여러 단계에 걸쳐 축적된 발견들을 바탕으로 최종 답변을 도출한다.

구체적으로, 이 과정은 초기 쿼리 로 시작하며, 각 검색 단계 마다 새로운 문서 가 에서 검색된 다음 LLM의 입력에 통합된다. 이는 다음과 같다: , 여기서 추가 맥락 는 이전 문서와 결과()로 구성될 수 있으며, 이다.

우리는 이러한 반복적인 다단계 과정이 LLM이 쿼리를 효과적으로 해결하기 위한 보다 포괄적이고 광범위한 기반을 구축할 수 있도록 하며, 특히 답변이 상호 연결된 정보 조각에 의존하는 복잡한 multi-hop 쿼리에 능숙하다는 점을 강조하고 싶다.

그러나 이 다단계 접근 방식은 Retriever와 LLM에 대한 반복적인 접근으로 인해 상당한 계산 비용을 수반하므로 자원 집약적일 수 있음을 인식하는 것이 중요하다.

3.2 Adaptive-RAG: Adaptive Retrieval-Augmented Generation

이제 우리는 이전 섹션에서 설명한 세 가지 전략을 기반으로 구축되었으며, 쿼리의 복잡성에 따라 가장 적합한 전략을 선택하도록 설계된 적응형 검색 증강 LLM을 소개한다.

적응형 검색 증강 LLM (Adapting Retrieval-Augmented LLMs)

실제 시나리오에서는 사용자로부터 들어오는 모든 가 동일한 수준의 복잡성을 가지지 않으므로, 각 쿼리를 처리하기 위한 맞춤형 전략이 필요하다는 점에 주목해야 한다. 즉, 복잡한 쿼리 에 대해 가장 기본적인 비검색 기반 접근 방식인 로 응답하는 것은 비효율적일 것이며 (Figure 2, A), 반대로 간단한 에 대해 더 정교한 다단계 접근 방식인 LLM()을 사용하는 것은 비효율적일 것이다 (Figure 2, B).

따라서 우리의 적응형 프레임워크는 검색 증강 LLM의 쿼리 처리 전략을 동적으로 조정하도록 설계되었으며, 이는 솔루션을 시도하기 전에 각 쿼리의 복잡성을 결정함으로써 달성된다. 특히, 이 프레임워크는 가장 간단한 쿼리에는 가장 단순한 접근 방식부터, 중간 수준의 쿼리에는 단일 단계 접근 방식, 그리고 복잡한 쿼리에는 가장 포괄적이고 엄격한 접근 방식에 이르기까지 다양한 솔루션을 제공하여 견고한 중간 지점을 제공할 수 있다.

또한, LLM과 Retriever의 작동 방식은 입력과 관계없이 일관되게 유지되므로, 우리의 방법은 적응 과정에서 내부 모델 아키텍처나 파라미터를 변경하지 않고도 다양한 복잡성의 쿼리들을 매끄럽게 오갈 수 있다.

쿼리 복잡성 평가 (Query Complexity Assessment)

우리의 적응형 검색 증강 LLM 프레임워크를 실제로 구현하기 위해서는 쿼리 복잡성을 결정해야 하며, 이를 위해 우리는 복잡성 분류기(complexity classifier)를 모델링할 것을 제안한다. 이 분류기의 목표는 주어진 쿼리의 적절한 복잡성 수준을 반환하는 것이다.

구체적으로, 쿼리 가 주어졌을 때, 우리의 분류기는 와 같이 정식화될 수 있다. 여기서 Classifier는 세 가지 다른 복잡성 수준 중 하나를 분류하도록 학습된 더 작은 Language Model이며, 는 해당 클래스 레이블이다.

우리의 분류기 설계에는 세 가지 클래스 레이블이 있다: 'A', 'B', 'C'.

- 'A': 가 간단하며 자체로 답변 가능함을 나타낸다.

- 'B': 가 중간 수준의 복잡성을 가지며, 최소한 단일 단계 접근 방식인 가 필요함을 나타낸다.

- 'C': 가 복잡하며, 가장 광범위한 솔루션인 가 필요함을 나타낸다.

학습 전략 (Training Strategy)

남은 단계는 Classifier를 위한 더 작은 Language Model을 학습시켜, 주어진 쿼리 에 대한 복잡성 를 정확하게 예측하도록 하는 것이다. 그러나 쿼리-복잡성 쌍에 대한 주석된 데이터셋은 현재 존재하지 않는다. 따라서 우리는 두 가지 특정 전략을 사용하여 학습 데이터셋을 자동으로 구축할 것을 제안한다.

구체적으로, 우리는 먼저 세 가지 다른 검색 증강 LLM 전략의 결과를 기반으로 쿼리 복잡성에 레이블을 지정하여, 필요에 따라 레이블을 결정하는 것을 목표로 한다. 예를 들어, 가장 간단한 비검색 기반 접근 방식이 올바르게 답변을 생성하면, 해당 쿼리의 레이블은 'A'로 할당된다. 또한, 쿼리에 레이블을 제공하는 데 있어 다른 모델들 간의 충돌을 해결하기 위해, 우리는 더 간단한 모델에 더 높은 우선순위를 부여한다. 즉, 단일 단계 및 다단계 접근 방식이 모두 동일한 정답을 생성하지만 비검색 기반 접근 방식이 실패하는 경우, 해당 쿼리에는 'B' 레이블을 할당한다.

그러나 이 레이블링 전략은 세 가지 검색 증강 접근 방식이 모두 정답을 생성하지 못할 수 있으므로, 모든 쿼리에 레이블이 할당되지 않는다는 한계가 있다. 반면에, 벤치마크 데이터셋은 생성 방식(예: 순차적 추론을 요구하는 QA 데이터셋은 일반적으로 다단계 접근 방식이 필요하며, 단일 문서가 레이블링된 쿼리는 단일 단계 접근 방식으로 이상적으로 답변 가능함)을 고려할 때, 쿼리에 가장 적합한 검색 증강 LLM 전략에 대한 의미 있는 귀납적 편향(inductive biases)을 이미 가지고 있을 수 있다.

따라서 첫 번째 레이블링 단계 후에도 레이블이 지정되지 않은 쿼리에 대해서는, 단일 홉(single-hop) 데이터셋의 쿼리에는 'B'를, 다중 홉(multi-hop) 데이터셋의 쿼리에는 'C'를 할당한다. 마지막으로, 우리는 cross-entropy loss를 사용하여 자동으로 수집된 이러한 쿼리-복잡성 쌍으로 Classifier를 학습시킨다.

그런 다음, 추론 시에는 쿼리 를 Classifier에 전달하여 와 같이 {'A', 'B', 'C'} 중 하나인 쿼리의 복잡성을 결정할 수 있다.

4 Experimental Setups

이 섹션에서는 데이터셋, 모델, 평가 지표(metrics), 그리고 구현 세부사항에 대해 설명한다. 추가적인 세부 내용은 Appendix A에 제시되어 있다.

4.1 Datasets

다양한 쿼리가 복잡성을 달리하는 현실적인 시나리오를 시뮬레이션하기 위해, 우리는 단일 홉(single-hop) 및 다중 홉(multi-hop) QA 데이터셋을 통합된 실험 설정에서 동시에 사용한다.

Single-hop QA

더 간단한 쿼리를 위해, 우리는 다음 세 가지 벤치마크 single-hop QA 데이터셋을 사용한다. 이 데이터셋들은 쿼리와 답변을 포함하는 관련 문서로 구성된다:

- SQuAD v1.1 (Rajpurkar et al., 2016),

- Natural Questions (Kwiatkowski et al., 2019),

- TriviaQA (Joshi et al., 2017).

Table 1: open-domain question answering을 위한 벤치마크 데이터셋 모음(single-hop 및 multi-hop 쿼리 포함)에 대한 평균 결과, 다양한 LLM 사용. Self-RAG*는 다른 기본 LLM인 LLaMA2 (Touvron et al., 2023)로 학습되었으므로, FLAN-T5-XL (3B)의 결과는 LLaMA2 (7B)를 사용한 Self-RAG 결과와 비교하고, 다른 모델들의 결과는 LLaMA2 (13B)를 사용한 Self-RAG 결과와 비교한다. 쉬운 비교를 위해 우리의 결과는 굵게(bold) 표시하였다.

| Types | Methods | FLAN-T5-XL (3B) | FLAN-T5-XXL (11B) | GPT-3.5 (Turbo) | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | ||

| Simple | No Retrieval | 14.87 | 21.12 | 15.97 | 0.00 | 0.11 | 17.83 | 25.14 | 19.33 | 0.00 | 0.08 | 35.77 | 48.56 | 44.27 | 0.00 | 0.71 |

| Single-step Approach | 34.83 | 44.31 | 38.87 | 1.00 | 1.00 | 37.87 | 47.63 | 41.90 | 1.00 | 1.00 | 34.73 | 46.99 | 45.27 | 1.00 | 1.00 | |

| Adaptive | Adaptive Retrieval | 23.87 | 32.24 | 26.73 | 0.50 | 0.56 | 26.93 | 35.67 | 29.73 | 0.50 | 0.54 | 35.90 | 48.20 | 45.30 | 0.50 | 0.86 |

| Self-RAG* | 9.90 | 20.79 | 31.57 | 0.72 | 0.43 | 10.87 | 22.98 | 34.13 | 0.74 | 0.23 | 10.87 | 22.98 | 34.13 | 0.74 | 1.50 | |

| Adaptive-RAG (Ours) | 37.17 | 46.94 | 42.10 | 2.17 | 3.60 | 38.90 | 48.62 | 43.77 | 1.35 | 2.00 | 37.97 | 50.91 | 48.97 | 1.03 | 1.46 | |

| Complex | Multi-step Approach | 39.00 | 48.85 | 43.70 | 4.69 | 8.81 | 40.13 | 50.09 | 45.20 | 2.13 | 3.80 | 38.13 | 50.87 | 49.70 | 2.81 | 3.33 |

| Oracle | Adaptive-RAG w/ Oracle | 45.00 | 56.28 | 49.90 | 1.28 | 2.11 | 47.17 | 58.60 | 52.20 | 0.84 | 1.10 | 47.70 | 62.80 | 58.57 | 0.50 | 1.03 |

Multi-hop QA

더 복잡한 쿼리 시나리오를 고려하기 위해, 우리는 다음 세 가지 벤치마크 multi-hop QA 데이터셋을 사용한다. 이 데이터셋들은 여러 문서에 걸친 순차적인 추론을 필요로 한다:

- MuSiQue (Trivedi et al., 2022a),

- HotpotQA (Yang et al., 2018),

- 2WikiMultiHopQA (Ho et al., 2020).

4.2 Models

우리는 Adaptive-RAG를 관련 모델들과 비교한다. 여기에는 세 가지 retrieval-augmented LLM 전략(Section 3.1)과 adaptive retrieval 접근 방식(Mallen et al., 2023; Asai et al., 2024)이 포함되며, 이들은 크게 세 가지 범주로 나눌 수 있다: Simple, Adaptive, Complex.

구체적으로, Simple 접근 방식에는 다음이 포함된다:

- No Retrieval

- Single-step Approach 기반 방법

Adaptive 접근 방식에는 다음이 포함된다: 3. Adaptive Retrieval (Mallen et al., 2023) 4. Self-RAG (Asai et al., 2024) 5. 우리의 Adaptive-RAG: 질문 복잡도에 따라 adaptive하게 retrieval을 수행할 수 있다.

Multi-step Approach의 경우, 우리는 가장 정교한 state-of-the-art 방법(Trivedi et al., 2023)을 사용한다. 이 방법은 모든 쿼리에 대해 Chain-of-Thought reasoning (Wei et al., 2022b)을 통해 retriever와 LLM에 반복적으로 접근한다.

다른 범주의 모델들은 직접적으로 비교할 수 없다는 점에 유의해야 한다. 그러나 이상적인 설정에서는 Adaptive 접근 방식이 Simple 범주의 방식보다 더 효과적이어야 하며, 동시에 Complex 방식보다 더 효율적이어야 한다. 따라서 우리는 이상적인 시나리오에서의 성능도 보고한다: 7. Adaptive-RAG w/ Oracle: 우리의 Adaptive-RAG에 oracle classifier를 사용하여 평가한다.

4.3 Evaluation Metrics

적응형 모델을 평가할 때, task 성능과 효율성을 그 trade-off와 함께 동시에 고려하는 것이 필수적이다. 따라서 우리는 다섯 가지 지표로 결과를 보고하는데, 이 중 세 가지는 **효과성(effectiveness)**을 측정하고 나머지 두 가지는 **효율성(efficiency)**을 측정한다.

특히, 효과성을 위해 우리는 표준 평가 프로토콜(Mallen et al., 2023; Baek et al., 2023; Asai et al., 2024)에 따라 **F1, EM, Accuracy (Acc)**를 사용한다.

- F1은 예측된 답변과 ground truth 사이의 겹치는 단어 수를 측정한다.

- EM은 예측된 답변과 ground truth가 동일한지 여부를 측정한다.

- Acc는 예측된 답변이 ground-truth 답변을 포함하는지 여부를 측정한다.

효율성을 위해서는 검색-생성(retrieval-and-generate) 단계의 수와 각 쿼리에 답변하는 데 걸리는 평균 시간을 단일 단계(one-step) 접근 방식과 비교하여 측정한다.

4.4 Implementation Details

Mallen et al. (2023) 및 Trivedi et al. (2023)의 연구를 따라 공정한 비교를 위해, 우리는 모든 모델에 걸쳐 동일한 retriever인 용어 기반 sparse retrieval 모델 BM25 (Robertson et al., 1994)를 사용한다. 외부 문서 코퍼스의 경우, 데이터셋 유형에 따라 다른 소스를 사용한다:

- single-hop 데이터셋에는 Karpukhin et al. (2020)이 전처리한 Wikipedia 코퍼스,

- multi-hop 데이터셋에는 Trivedi et al. (2023)이 전처리한 코퍼스.

답변 생성에 사용되는 LLM으로는 FLAN-T5 시리즈 모델 (Chung et al., 2022) 중 XL (3B 파라미터) 및 XXL (11B 파라미터) 모델과 GPT-3.5 모델 (gpt-3.5-turbo-instruct)을 사용한다. retrieval-augmented LLM 설계에 관해서는 Trivedi et al. (2023)의 구현 세부 사항을 따르며, 여기에는 입력 prompt, 지침, 평가를 위한 테스트 샘플 수 (예: 데이터셋당 500개 샘플)가 포함된다.

우리의 Adaptive-RAG에서 query-complexity classifier로는 T5-Large 모델 (Raffel et al., 2020)을 사용하고 학습시킨다. 구체적으로, 이 classifier는 검증 세트에서 100회 학습 반복까지 가장 좋은 성능을 보인 epoch를 사용하여 학습되며, **학습률은 **이고 AdamW (Loshchilov and Hutter, 2019)를 optimizer로 사용한다. 학습 데이터의 경우, 우리는 6개 데이터셋에서 400개의 쿼리를 샘플링하고 주석하여 사용하며, 이는 inductive bias (one-step 접근 방식의 경우 single-hop, multi-step의 경우 multi-hop)에 기반한다. 또한, 각 데이터셋에서 샘플링된 400개의 쿼리에 대해 세 가지 다른 전략의 예측 결과를 사용한다. classifier 학습에 사용된 쿼리는 QA 테스트 쿼리와 중복되지 않는다.

Table 2: FLAN-T5-XL (3B)을 LLM으로 사용한 각 데이터셋 결과. 우리의 결과는 굵게 표시되어 있다.

| Data | Types | Methods | SQuad | Natural Questions | TriviaQA | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | |||

| Single-step | Simple | No Retrieval | 3.60 | 10.50 | 5.00 | 0.00 | 0.11 | 14.20 | 19.00 | 15.60 | 0.00 | 0.13 | 25.00 | 31.80 | 27.00 | 0.00 | 0.13 |

| Single-step Approach | 27.80 | 39.30 | 34.00 | 1.00 | 1.00 | 37.80 | 47.30 | 44.60 | 1.00 | 1.00 | 53.60 | 62.40 | 60.20 | 1.00 | 1.00 | ||

| Adaptive | Adaptive Retrieval | 13.40 | 23.10 | 17.60 | 0.50 | 0.55 | 28.20 | 36.00 | 33.00 | 0.50 | 0.56 | 38.40 | 46.90 | 42.60 | 0.50 | 0.56 | |

| Self-RAG* | 2.20 | 11.20 | 18.40 | 0.63 | 0.50 | 31.40 | 39.00 | 33.60 | 0.63 | 0.17 | 12.80 | 29.30 | 57.00 | 0.68 | 0.45 | ||

| Adaptive-RAG (Ours) | 26.80 | 38.30 | 33.00 | 1.37 | 2.02 | 37.80 | 47.30 | 44.60 | 1.00 | 1.00 | 52.20 | 60.70 | 58.20 | 1.23 | 1.54 | ||

| Complex | Multi-step Approach | 24.40 | 35.60 | 29.60 | 4.52 | 9.03 | 38.60 | 47.80 | 44.20 | 5.04 | 10.18 | 53.80 | 62.40 | 60.20 | 5.28 | 9.22 | |

| Oracle | Adaptive-RAG w/ Oracle | 32.00 | 45.60 | 38.20 | 1.24 | 1.60 | 47.40 | 57.10 | 53.60 | 1.10 | 1.55 | 61.60 | 70.20 | 66.40 | 0.79 | 1.10 |

| Data | Types | Methods | MuSiQue | HotpotQA | 2WikiMultiHopQA | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | |||

| Multi-step | Simple | No Retrieval | 2.40 | 10.70 | 3.20 | 0.00 | 0.11 | 16.60 | 22.71 | 17.20 | 0.00 | 0.11 | 27.40 | 32.04 | 27.80 | 0.00 | 0.10 |

| Single-step Approach | 13.80 | 22.80 | 15.20 | 1.00 | 1.00 | 34.40 | 46.15 | 36.40 | 1.00 | 1.00 | 41.60 | 47.90 | 42.80 | 1.00 | 1.00 | ||

| Adaptive | Adaptive Retrieval | 6.40 | 15.80 | 8.00 | 0.50 | 0.55 | 23.60 | 32.22 | 25.00 | 0.50 | 0.55 | 33.20 | 39.44 | 34.20 | 0.50 | 0.55 | |

| Self-RAG* | 1.60 | 8.10 | 12.00 | 0.73 | 0.51 | 6.80 | 17.53 | 29.60 | 0.73 | 0.45 | 4.60 | 19.59 | 38.80 | 0.93 | 0.49 | ||

| Adaptive-RAG (Ours) | 23.60 | 31.80 | 26.00 | 3.22 | 6.61 | 42.00 | 53.82 | 44.40 | 3.55 | 5.99 | 40.60 | 49.75 | 46.40 | 2.63 | 4.68 | ||

| Complex | Multi-step Approach | 23.00 | 31.90 | 25.80 | 3.60 | 7.58 | 44.60 | 56.54 | 47.00 | 5.53 | 9.38 | 49.60 | 58.85 | 55.40 | 4.17 | 7.37 | |

| Oracle | Adaptive-RAG w/ Oracle | 24.80 | 38.50 | 27.00 | 1.98 | 3.99 | 51.20 | 64.00 | 54.80 | 1.59 | 2.77 | 53.00 | 62.30 | 59.40 | 1.01 | 1.69 |

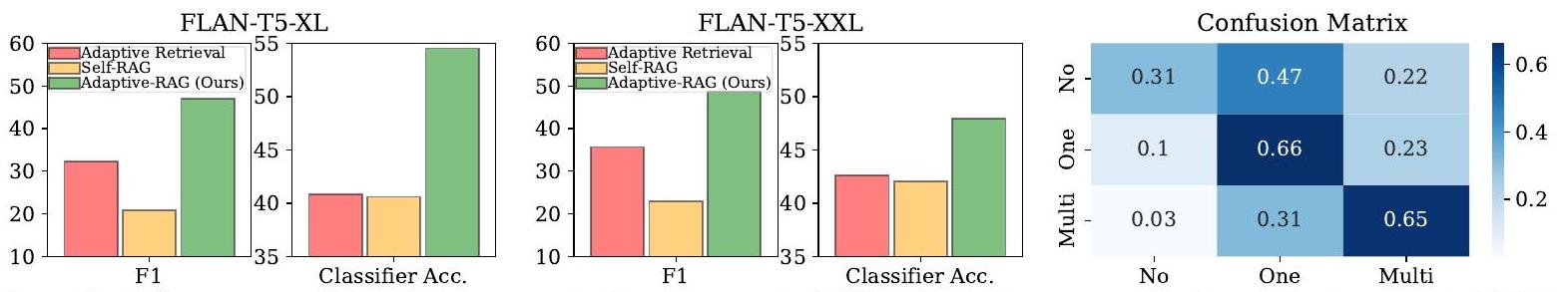

Figure 3: FLAN-T5 XL (왼쪽) 및 XXL (중앙)을 사용한 retrieval-augmented LLM의 다양한 adaptive 접근 방식에 대한 QA 성능 및 query-complexity 평가. 쿼리의 복잡도를 라벨링하기 위해, 우리는 모델의 예측 결과로부터 주석된 silver data를 사용한다 (Section 3.2에 설명). 또한 세 가지 라벨에 대한 confusion matrix도 제공한다 (오른쪽).

5 Experimental Results and Analyses

이 섹션에서는 전반적인 실험 결과를 제시하고, 우리 방법론에 대한 심층적인 분석을 제공한다.

주요 결과 (Main Results)

먼저, Table 1은 우리가 고려한 모든 데이터셋에 대한 평균 주요 결과를 보여준다. 이 결과는 단순한 retrieval-augmented 전략이 복잡한 전략보다 덜 효과적이며, 복잡한 전략은 단순한 전략보다 훨씬 더 많은 비용이 든다는 우리의 가설을 뒷받침한다.

또한, FLAN-T5-XL을 사용한 각 single-hop 및 multi-hop 데이터셋에 대한 더 세분화된 결과를 Table 2에 보고한다 (다른 LLM을 사용한 결과는 Appendix의 Table 7과 Table 8에 더 많이 제시되어 있다). 이 결과들은 Table 1에서 관찰된 결과와 일치한다.

그러나 실제 시나리오에서는 모든 사용자가 동일한 수준의 복잡성을 가진 쿼리를 요청하는 것은 아니며, 이는 적응형 전략의 중요성을 강조한다. 적응형 전략 중에서도 우리의 Adaptive-RAG는 경쟁 모델들보다 뛰어난 효과를 보여준다 (Table 1). 이는 단순히 검색 여부 결정에만 초점을 맞추는 것이 최적의 방법이 아님을 시사한다. 또한, Table 2에서 볼 수 있듯이, 이러한 단순 적응형 전략은 여러 문서에 걸친 정보 집계 및 추론이 필요한 multi-hop 데이터셋의 복잡한 쿼리를 처리하는 데 특히 부적절하다. 반면, 우리의 접근 방식은 복잡한 쿼리에 대해 반복적인 모듈을 추가로 통합하여 더 세분화된 쿼리 처리 전략을 고려할 수 있다.

더 나아가, 현실적인 환경에서는 효과성뿐만 아니라 효율성도 고려해야 한다. Table 1에서 볼 수 있듯이, 복잡한 multi-step 전략과 비교하여 우리가 제안하는 적응형 전략은 모든 모델 크기에서 훨씬 더 효율적이다. 이는 LLM 시대에 접근 비용이 실제 애플리케이션 및 확장성에 중요한 요소라는 점에서 의미가 크다.

마지막으로, Adaptive-RAG의 상한선을 확인하기 위해, 분류 성능이 완벽한 oracle classifier를 사용했을 때의 성능을 보고한다. Table 1과 Table 2에서 볼 수 있듯이, oracle classifier가 없는 Adaptive-RAG보다 훨씬 효율적이면서도 최고의 성능을 달성함을 관찰한다. 이러한 결과는 쿼리 복잡성을 기반으로 retrieval-augmented LLM 전략을 조정하려는 우리의 제안의 타당성과 중요성을 뒷받침하며, 최적의 성능을 달성하기 위해 더 개선된 classifier를 개발해야 할 방향을 제시한다.

Table 3: 쿼리당 정확한 경과 시간 및 모든 샘플에 대한 classifier의 예측 레이블 비율.

| Labels | Time/Query (Sec.) | Percentage (%) |

|---|---|---|

| No (A) | 0.35 | 8.60 |

| One (B) | 3.08 | 53.33 |

| Multi (C) | 27.18 | 38.07 |

Classifier 성능 (Classifier Performance)

제안된 classifier가 어떻게 작동하는지 이해하기 위해, 우리는 다양한 복잡성 레이블에 걸쳐 그 성능을 분석한다. Figure 3 (왼쪽 및 중앙)에서 볼 수 있듯이, 우리의 Adaptive-RAG의 분류 정확도는 다른 적응형 검색 baseline보다 우수하며, 이는 전반적인 QA 성능 향상으로 이어진다. 다시 말해, 이 결과는 우리의 Adaptive-RAG가 검색을 수행하지 않는 경우, 한 번만 검색을 수행하는 경우, 여러 번 검색을 수행하는 경우를 포함하여 다양한 세분화된 복잡성 수준을 더 정확하게 분류할 수 있음을 나타낸다. Figure 3 (왼쪽 및 중앙)에서 세 가지 레이블 모두에 대해 평균화된 classifier의 true positive 성능 외에도, Figure 3 (오른쪽)에 혼동 행렬(confusion matrix)을 추가로 보고한다. 혼동 행렬은 몇 가지 주목할 만한 경향을 보여준다: 'C (Multi)'는 때때로 'B (One)'로 오분류되고 (약 31%), 'B (One)'는 'C (Multi)'로 오분류된다 (약 23%). 'A (No)'는 종종 'B (One)'로 오분류되고 (약 47%), 'C (Multi)'로는 덜 자주 오분류된다 (약 22%). Figure 3의 전반적인 결과는 우리의 classifier가 세 가지 레이블을 효과적으로 분류함을 보여주지만, 이러한 오분류를 기반으로 classifier를 더욱 개선하는 것은 향후 연구를 위한 의미 있는 방향이 될 것이다.

Classifier 효율성 분석 (Analyses on Efficiency for Classifier)

Table 1은 세 가지 다른 RAG 전략 각각에 대한 상대적인 경과 시간을 보여주지만, 우리는 Adaptive-RAG에 대한 쿼리당 정확한 경과 시간과 쿼리 복잡성 classifier의 예측 레이블 분포를 Table 3에 추가로 제공한다. Table 1의 경과 시간 결과(상대 시간)와 유사하게, Table 3(정확한 시간)은 단순하거나 직접적인 쿼리를 식별함으로써 효율성을 크게 향상시킬 수 있음을 보여준다.

Classifier 학습 데이터 분석 (Analyses on Training Data for Classifier)

우리는 classifier가 적응형 검색에서 중요한 역할을 한다는 것을 보여주었다. 여기서는 모델의 예측 결과로부터 silver data를 생성하는 접근 방식과 데이터셋의 inductive bias를 활용하는 두 가지 접근 방식을 포함하는 우리의 전체 학습 전략을 ablation하여 classifier 학습을 위한 다양한 전략을 추가로 분석한다 (Section 3.2 참조). Table 4에서 볼 수 있듯이, inductive bias에서 파생된 데이터에만 의존하는 학습 전략과 비교하여 우리의 전략이 훨씬 더 효율적이다. 이러한 효율성은 부분적으로 우리의 전략이 어떤 문서도 고려하지 않는 경우를 고려하기 때문이며, 이는 분류 정확도에서도 암시된다. 반면, 기존 데이터셋의 쿼리는 검색이 필요한지 여부에 대한 정보를 포착하지 못한다. 다른 한편으로, 올바른 예측에서 주석된 silver data만 사용하는 경우, 전반적인 분류 정확도는 높지만, 전반적인 QA 성능은 silver data에만 의존하는 것이 최적이 아닐 수 있음을 시사한다. 이는 이 silver data가 잘못 예측된 쿼리에 대한 복잡성 레이블을 다루지 않아, 관련 쿼리에 대한 일반화 효과가 낮아지기 때문일 수 있다. 한편, 데이터셋 bias(single-hop vs multi-hop)에서 복잡성 레이블을 통합함으로써, classifier는 multi-hop 쿼리를 예측하는 데 더 정확해지고, 이는 더 나은 성능으로 이어진다. 우리의 자동 레이블링 전략은 classifier 학습을 위한 두 가지 특정 구현이며, 다른 구현도 있을 수 있으며, 이는 향후 연구로 남겨둔다.

Table 4: classifier 학습을 위한 데이터 주석 전략을 변경했을 때의 QA 및 복잡성 분류 결과.

| QA | Classifier (Accuracy) | ||||||

|---|---|---|---|---|---|---|---|

| Training Strategies | F1 | Step | All | No | One | Multi | |

| Adaptive-RAG | (Ours) | ||||||

| w/o Binary | 43.43 | 640 | 60.3 | 62.1 | 65.7 | ||

| w/o Silver | 48.79 | 1464 | 40.00 | 0.00 | 53.98 | 75.91 |

Classifier 크기 분석 (Analyses on Classifier Size)

classifier의 다양한 크기에 따른 민감도를 조사하기 위해 추가 실험을 수행했다. Table 6에서 볼 수 있듯이, 다양한 크기의 classifier 간에 유의미한 성능 차이는 관찰되지 않으며, 심지어 더 작은 classifier에서 복잡성과 파라미터 수가 줄어들었음에도 마찬가지이다. 이는 우리가 제안하는 classifier가 성능 저하 없이 더 작은 크기로 실제 사용 사례에서 자원 효율적인 설정에 기여할 수 있음을 나타낸다.

사례 연구 (Case Study)

우리는 Adaptive-RAG와 Adaptive Retrieval을 정성적으로 비교하기 위한 사례 연구를 수행한다. Table 5는 단순한 질문과 복잡한 질문 모두에 대한 분류된 복잡성과 쿼리 처리 패턴을 보여준다.

첫째, 단순한 single-hop 질문의 경우, 우리의 Adaptive-RAG는 'Google'에 대한 LLM의 parametric knowledge만 사용하여 답변할 수 있음을 식별한다. 대조적으로,

Table 5: GPT-3.5 (Turbo)를 사용한 사례 연구. 사실 오류는 빨간색으로, 정확한 정보는 파란색으로 표시.

| Dataset | Question | Adaptive Retrieval | Adaptive-RAG (Ours) |

|---|---|---|---|

| NQ (Single-hop) | Which famous corporate logo changed to a flat colour/color sans serif font in its first major change since 1999? | Query Type: B (Single-step Approach) <br> Reasoning: The famous corporate logo that changed to a flat color sans-serif font in its first major change since 1999 is Microsoft. Microsoft changed its logo in 2012, replacing the italicized, multi-colored font with a simple, flat, grey font. So the answer is: Microsoft. | Query Type: A (Non Retrieval) <br> Reasoning: The famous corporate logo that changed to a flat color sans serif font in its first major change since 1999 is Google. Google changed its logo in 2015. So the answer is: Google. |

| MuSiQue (Multi-hop) | Who is the child of the Italian navigator who explored the eastern coast of the continent César Gaytan was born in for the English? | Query Type: A (Non Retrieval) <br> Reasoning: César Gaytan was born in the continent of North America. The Italian navigator who explored the eastern coast of North America for the English was Giovanni Caboto, also known as John Cabot. So the answer is: Giovanni Caboto/John Cabot. | Query Type: C (Multi-step Approach) Reasoning: Césarr Gaytan was born in Guadalajara, Jalisco, Mexico. The Italian navigator who explored the eastern coast of the continent for the English is John Cabot. John Cabot's son is Sebastian Cabot. So the answer is: Sebastian Cabot. |

Table 6: classifier의 다양한 모델 크기에 따른 결과.

| QA | Classifier (Accuracy) | ||||||

|---|---|---|---|---|---|---|---|

| Sizes | F1 | Step | All | No | One | Multi | |

| Small | 45.83 | 964 | 53.48 | 26.65 | 70.62 | 53.18 | |

| Base | 45.97 | 983 | 53.41 | 26.42 | 69.46 | 56.82 | |

| Large | 30.52 | 66.28 | 65.45 |

Adaptive Retrieval은 추가 문서를 가져와 처리 시간을 길게 만들고, 'Microsoft'에 대한 부분적으로 관련 없는 정보가 포함되어 때때로 부정확한 응답을 생성한다. 한편, 복잡한 질문에 직면했을 때 Adaptive-RAG는 'John Cabot의 아들'과 같이 LLM에 저장되지 않았을 수 있는 관련 정보를 찾아내는 반면, Adaptive Retrieval은 외부 소스에서 그러한 정보를 요청하는 데 실패하여 부정확한 답변을 초래한다.

6 Conclusion

본 연구에서는 다양한 복잡도의 쿼리를 처리하기 위해 Adaptive Retrieval-Augmented Generation (Adaptive-RAG) 프레임워크를 제안한다. 구체적으로, Adaptive-RAG는 통합된 retrieval-augmented LLM 내에서 쿼리의 복잡도에 따라 쿼리 처리 전략을 동적으로 조정하도록 설계되었다. 이는 가장 간단한 쿼리에 대한 non-retrieval-based 접근 방식부터, 중간 복잡도의 쿼리에 대한 single-step 접근 방식, 그리고 복잡한 쿼리에 대한 multi-step 접근 방식에 이르기까지 다양한 스펙트럼을 포괄한다.

Adaptive-RAG의 핵심 단계는 주어진 쿼리의 복잡도를 결정하는 데 있으며, 이는 쿼리에 가장 적합한 답변 전략을 선택하는 데 중요한 역할을 한다. 이 과정을 실행하기 위해, 우리는 예측 결과와 데이터셋의 inductive bias로부터 자동으로 주석된 쿼리-복잡도 쌍을 사용하여 더 작은 Language Model을 학습시켰다.

우리는 single-hop 및 multi-hop 질문을 포함한 다양한 쿼리 복잡도를 다루는 open-domain QA 데이터셋 모음에서 Adaptive-RAG를 검증하였다. 결과는 Adaptive-RAG가 QA 시스템의 전반적인 정확도와 효율성을 향상시킨다는 것을 보여준다. 이는 기존의 "one-size-fits-all" 접근 방식이 다양한 쿼리 복잡도에 대해 지나치게 단순하거나 지나치게 복잡한 경향이 있는 것과 비교하여, 복잡한 쿼리 처리에는 더 많은 자원을 할당하고 간단한 쿼리는 효율적으로 처리하기 때문이다.

Limitations

우리의 Adaptive-RAG는 쿼리 복잡도를 결정한 후 가장 적합한 접근 방식을 활용하여 효과성과 효율성 측면에서 분명한 이점을 보여주지만, 분류기의 학습 데이터셋 및 아키텍처 관점에서 개선할 수 있는 잠재적인 여지가 여전히 존재한다는 점을 인식하는 것이 중요하다.

구체적으로, 쿼리 복잡도 분류기를 학습시키기 위한 공개 데이터셋이 없기 때문에, 우리는 모델 예측 결과와 귀납적 데이터셋 편향(inductive dataset biases)을 기반으로 새로운 데이터를 자동으로 생성한다. 그러나 우리의 레이블링 프로세스는 쿼리 복잡도를 레이블링하는 특정 방식 중 하나이며, 그 효과성에도 불구하고 쿼리를 잘못 레이블링할 가능성이 있다. 따라서 향후 연구에서는 질문-답변 쌍 레이블 외에 다양한 범위의 쿼리 복잡도로 주석된 새로운 데이터셋을 생성할 수 있을 것이다.

또한, Table 1의 이상적인 분류기와 Figure 3의 현재 분류기 간의 성능 차이가 보여주듯이, 분류기의 효과성을 개선할 여지가 여전히 남아 있다. 즉, 더 작은 LM을 기반으로 한 우리의 분류기 설계는 쿼리 복잡도를 분류하기 위한 초기이자 가장 간단한 구현이며, 이를 바탕으로 향후 연구에서는 분류기 아키텍처와 성능을 개선할 수 있을 것이고, 이는 전반적인 QA 성능에 긍정적으로 기여할 것이다.

Ethics Statement

Adaptive-RAG에 대한 실험 결과는 다양한 사용자 쿼리가 존재하는 현실적인 시나리오에서 그 적용 가능성을 입증한다. 그럼에도 불구하고, 실제 사용자 입력의 잠재적 다양성을 고려할 때, 이러한 입력이 불쾌하거나 유해할 수 있는 시나리오 또한 고려하는 것이 중요하다. 우리는 그러한 입력이 불쾌한 문서를 검색하고 retrieval-augmented LLM에 의해 부적절한 응답을 생성할 수 있다는 점을 인지해야 한다. 이러한 문제를 해결하기 위해, retrieval-augmented 프레임워크 내에서 사용자 입력과 검색된 문서 모두에서 불쾌하거나 부적절한 콘텐츠를 감지하고 관리하는 방법을 개발하는 것이 필수적이다. 우리는 이것이 향후 연구를 위한 중요한 영역이라고 생각한다.

Acknowledgements

본 연구는 한국 정부의 정보통신기획평가원(IITP) 보조금 (No. 2018-0-00582, 언어 분석 및 자동 증거 문서 수집을 통한 신뢰도 분포 예측 및 증강), 교육부의 한국연구재단(NRF) 기초과학 연구 프로그램 (RS-2023-00275747), 그리고 과학기술정보통신부(MSIT, 한국) 및 광주광역시가 지원하는 인공지능 산업 융합 집적단지 개발 프로젝트의 지원을 받아 수행되었다.

A Additional Experimental Setups

A. 1 Datasets

우리는 single-hop 및 multi-hop QA 데이터셋 모두에 대해 공개된 데이터셋을 사용하며, 각각 **Karpukhin et al. (2020)**과 **Trivedi et al. (2023)**을 참조한다. 각 데이터셋의 특징은 다음과 같다:

- **SQuAD v1.1 (Rajpurkar et al., 2016)**은 주석자들이 읽은 문서에 기반하여 질문을 작성하는 과정을 통해 생성되었다.

- **Natural Questions (Kwiatkowski et al., 2019)**는 Google 검색의 실제 사용자 쿼리를 기반으로 구축되었다.

- **TriviaQA (Joshi et al., 2017)**는 다양한 퀴즈 웹사이트에서 수집된 퀴즈 질문들로 구성된다.

- **MuSiQue (Trivedi et al., 2022a)**는 여러 single-hop 쿼리를 조합하여 2-4 hop에 걸친 쿼리를 형성함으로써 수집되었다.

- **HotpotQA (Yang et al., 2018)**는 주석자들이 여러 Wikipedia 문서를 연결하는 질문을 생성하도록 하여 구축되었다.

- **2 WikiMultiHopQA (Ho et al., 2020)**는 Wikipedia와 그와 관련된 지식 그래프 경로에서 파생되었으며, 2-hop을 필요로 한다.

A. 2 Models

우리는 모델의 세부 사항을 다음과 같이 설명한다:

- No Retrieval: 이 접근 방식은 주어진 쿼리에 대한 답변을 생성하기 위해 LLM 자체만을 사용한다.

- Single-step Approach: 이 접근 방식은 먼저 주어진 쿼리로 외부 지식 소스에서 관련 지식을 검색한 다음, 검색된 지식으로 LLM을 보강하여 답변을 생성하며, 이 과정은 한 번만 반복된다.

- Adaptive Retrieval: 이 baseline (Mallen et al., 2023)은 쿼리에 나타나는 entity의 인기도가 낮을 때만 검색 모듈로 LLM을 적응적으로 보강한다. entity를 추출하기 위해 질문에 대해 BLINK (Li et al., 2020)라는 entity-linking 방법을 사용한다.

- Self-RAG: 이 baseline (Asai et al., 2024)은

Figure 5: 다양한 retrieval-augmented generation 접근 방식에 대한 QA 성능 (F1) 및 효율성 (Time/Query). 우리는 FLAN-T5-XXL (11B)을 기본 LLM으로 사용한다.

Figure 5: 다양한 retrieval-augmented generation 접근 방식에 대한 QA 성능 (F1) 및 효율성 (Time/Query). 우리는 FLAN-T5-XXL (11B)을 기본 LLM으로 사용한다.

LLM이 검색 및 생성을 적응적으로 수행하도록 학습하며, 검색은 특정 임계값 이상의 특수 검색 토큰을 예측할 때 수행되고, 그 후에 답변 생성이 이어진다. 5) Adaptive-RAG: 이는 우리의 모델로, 분류기가 평가한 쿼리 복잡도를 기반으로 아키텍처 변경 없이 non-retrieval, single-step 접근 방식, multi-step 접근 방식 사이를 부드럽게 오가며 retrieval-augmented generation 전략을 적응적으로 선택한다. 6) Multi-step Approach: 이 접근 방식 (Trivedi et al., 2023)은 multi-step retrieval-augmented LLM으로, 해결책을 도출하거나 최대 단계 수에 도달할 때까지 interleaved Chain-of-Thought reasoning (Wei et al., 2022b)을 통해 retriever와 LLM에 반복적으로 접근한다. 7) Adaptive-RAG w/ Oracle: 이는 쿼리 복잡도를 완벽하게 분류하는 oracle 분류기를 갖춘 Adaptive-RAG의 이상적인 시나리오이다.

A. 3 Implementation Details

컴퓨팅 자원으로는 80GB 메모리를 가진 A100 GPU를 사용한다. 또한, retrieval-augmented generation 모델 평가에 드는 상당한 비용 때문에, 우리는 단일 실행(single run)으로 실험을 수행한다. 마지막으로, 모델은 PyTorch (Paszke et al., 2019)와 Transformers 라이브러리 (Wolf et al., 2020)를 사용하여 구현하였다.

B Additional Experimental Results

성능 대 시간 (Performance vs Time)

Figure 4와 Figure 5에서는 각각 FLAN-T5-XL 및 FLAN-T5-XXL 모델을 사용한 다양한 retrieval-augmented generation 접근 방식들의 성능과 효율성 trade-off를 비교한다. Figure 1의 GPT-3.5 모델에서 관찰된 바와 유사하게, 우리가 제안하는 Adaptive-RAG는 훨씬 더 효과적이고 효율적이다.

Table 7: LLM으로 FLAN-T5-XXL (11B)을 사용한 각 데이터셋 결과. 우리의 결과는 굵게(bold) 표시되어 있다.

| Data | Types | Methods | SQuAD | Natural Questions | TriviaQA | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | |||

| Single-step | No Retrieval | 7.00 | 14.40 | 8.40 | 0.00 | 0.08 | 18.80 | 25.50 | 20.40 | 0.00 | 0.08 | 32.80 | 39.20 | 35.40 | 0.00 | 0.08 | |

| Simple | Single-step Approach | 28.80 | 40.80 | 35.00 | 1.00 | 1.00 | 41.40 | 51.20 | 47.60 | 1.00 | 1.00 | 56.00 | 64.70 | 61.80 | 1.00 | 1.00 | |

| Adaptive | Adaptive Retrieval | 15.60 | 25.60 | 20.00 | 0.50 | 0.54 | 31.00 | 39.70 | 35.00 | 0.50 | 0.54 | 44.80 | 52.20 | 48.60 | 0.50 | 0.54 | |

| Self-RAG* | 1.60 | 11.90 | 20.80 | 0.59 | 0.31 | 39.20 | 47.10 | 42.40 | 0.75 | 0.09 | 14.60 | 33.70 | 60.20 | 0.76 | 0.22 | ||

| Adaptive-RAG (Ours) | 27.80 | 39.80 | 34.00 | 1.17 | 1.50 | 41.20 | 51.00 | 47.40 | 1.00 | 1.00 | 52.00 | 60.30 | 57.20 | 1.03 | 1.33 | ||

| Complex | Multi-step Approach | 24.60 | 36.90 | 30.20 | 2.13 | 3.83 | 39.60 | 49.60 | 46.40 | 2.16 | 3.94 | 52.60 | 61.10 | 59.40 | 2.17 | 4.03 | |

| Oracle | Adaptive-RAG w/ Oracle | 32.80 | 46.90 | 38.20 | 0.85 | 0.94 | 51.20 | 61.00 | 57.00 | 0.71 | 0.91 | 63.40 | 71.30 | 68.20 | 0.51 | 0.60 | |

| Data | Types | MuSiQue | HotpotQA | 2WikiMultiHopQA | |||||||||||||

| Methods | EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | ||

| Multi-step | Simple | No Retrieval | 4.20 | 13.40 | 5.40 | 0.00 | 0.08 | 17.40 | 25.44 | 18.40 | 0.00 | 0.09 | 26.80 | 32.93 | 28.00 | 0.00 | 0.08 |

| Single-step Approach | 16.80 | 25.70 | 19.20 | 1.00 | 1.00 | 37.60 | 49.27 | 39.60 | 1.00 | 1.00 | 46.60 | 54.13 | 48.20 | 1.00 | 1.00 | ||

| Adaptive | Adaptive Retrieval | 8.40 | 17.80 | 10.20 | 0.50 | 0.54 | 26.60 | 36.01 | 27.80 | 0.50 | 0.54 | 35.20 | 42.68 | 36.80 | 0.50 | 0.54 | |

| Self-RAG* | 1.20 | 8.20 | 11.80 | 0.68 | 0.27 | 5.60 | 17.86 | 30.60 | 0.76 | 0.26 | 3.00 | 19.14 | 39.00 | 0.90 | 0.25 | ||

| Adaptive-RAG (Ours) | 20.60 | 28.50 | 23.20 | 1.89 | 3.12 | 44.20 | 54.78 | 46.80 | 1.58 | 2.53 | 47.60 | 57.36 | 54.00 | 1.46 | 2.55 | ||

| Complex | Multi-step Approach | 19.40 | 27.50 | 21.80 | 2.09 | 3.66 | 47.00 | 57.81 | 49.40 | 2.08 | 3.73 | 57.60 | 67.65 | 64.00 | 2.17 | 3.63 | |

| Oracle | Adaptive-RAG w/ Oracle | 24.20 | 37.20 | 26.60 | 1.22 | 1.71 | 52.20 | 64.80 | 54.60 | 0.92 | 1.33 | 59.20 | 70.40 | 68.60 | 0.82 | 1.14 |

Table 8: LLM으로 GPT-3.5 (Turbo)를 사용한 각 데이터셋 결과. 우리의 결과는 굵게(bold) 표시되어 있다.

| Data | Types | Methods | SQuad | Natural Questions | TriviaQA | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | |||

| Single-step | Simple | No Retrieval | 16.00 | 29.20 | 23.80 | 0.00 | 0.62 | 39.80 | 55.70 | 55.00 | 0.00 | 0.56 | 64.00 | 75.60 | 75.80 | 0.00 | 0.68 |

| Single-step Approach | 18.00 | 33.80 | 29.20 | 1.00 | 1.00 | 32.40 | 46.80 | 54.80 | 1.00 | 1.00 | 55.20 | 66.50 | 65.80 | 1.00 | 1.00 | ||

| Adaptive | Adaptive Retrieval | 15.40 | 30.00 | 24.40 | 0.50 | 0.81 | 36.40 | 51.20 | 56.60 | 0.50 | 0.78 | 62.00 | 71.90 | 72.20 | 0.50 | 0.84 | |

| Self-RAG* | 1.60 | 11.90 | 20.80 | 0.59 | 1.91 | 39.20 | 47.10 | 42.40 | 0.75 | 0.52 | 14.60 | 33.70 | 60.20 | 0.76 | 1.59 | ||

| Adaptive-RAG (Ours) | 19.80 | 34.40 | 30.00 | 0.87 | 1.21 | 36.80 | 52.00 | 56.60 | 0.68 | 0.86 | 62.40 | 73.80 | 73.80 | 0.22 | 0.79 | ||

| Complex | Multi-step Approach | 17.40 | 31.50 | 26.20 | 2.50 | 3.24 | 35.60 | 49.70 | 57.80 | 2.58 | 3.79 | 54.80 | 67.10 | 68.00 | 2.30 | 2.65 | |

| Oracle | Adaptive-RAG w/ Oracle | 28.00 | 45.90 | 39.40 | 0.54 | 0.93 | 50.00 | 65.40 | 67.00 | 0.28 | 0.8 | 70.80 | 81.00 | 80.00 | 0.11 | 0.73 | |

| Data | Types | Methods | MuSiQue | HotpotQA | 2WikiMultiHopQA | ||||||||||||

| EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | EM | F1 | Acc | Step | Time | |||

| Multi-step | No Retrieval | 20.40 | 31.30 | 24.40 | 0.00 | 0.81 | 37.40 | 51.04 | 43.20 | 0.00 | 0.74 | 37.00 | 48.50 | 43.40 | 0.00 | 0.90 | |

| Simple | Single-step Approach | 16.40 | 26.70 | 23.60 | 1.00 | 1.00 | 39.60 | 50.44 | 45.60 | 1.00 | 1.00 | 46.80 | 57.69 | 52.60 | 1.00 | 1.00 | |

| Adaptive | Adaptive Retrieval | 18.80 | 30.30 | 24.80 | 0.50 | 0.90 | 38.60 | 50.70 | 43.20 | 0.50 | 0.87 | 44.20 | 55.11 | 50.60 | 0.50 | 0.95 | |

| Self-RAG* | 1.20 | 8.20 | 11.80 | 0.68 | 1.66 | 5.60 | 17.86 | 30.60 | 0.76 | 1.67 | 3.00 | 19.14 | 39.00 | 0.90 | 1.81 | ||

| Adaptive-RAG (Ours) | 21.80 | 32.60 | 29.60 | 1.90 | 2.29 | 40.40 | 52.56 | 47.00 | 0.93 | 1.48 | 46.60 | 60.09 | 56.80 | 1.59 | 2.23 | ||

| Complex | Multi-step Approach | 23.00 | 32.50 | 31.60 | 3.41 | 3.61 | 45.80 | 58.36 | 52.20 | 2.73 | 3.18 | 52.20 | 66.08 | 62.40 | 3.36 | 3.35 | |

| Oracle | Adaptive-RAG w/ Oracle | 29.60 | 44.70 | 35.60 | 0.90 | 1.45 | 55.60 | 69.90 | 62.80 | 0.54 | 1.08 | 52.20 | 69.90 | 66.60 | 0.65 | 1.21 |

데이터셋별 성능 (Performance per Dataset)

Table 2에 제시된 FLAN-T5-XL 모델의 각 데이터셋별 성능 외에도, 우리는 FLAN-T5-XXL 및 GPT-3.5 모델의 각 데이터셋별 결과를 각각 Table 7과 Table 8에 제시한다. 실험 결과는 우리의 Adaptive-RAG가 효율성과 정확성 사이에서 일관되게 균형을 이룸을 보여준다. 특히, GPT-3.5 모델은 문서 검색 없이도 간단한 쿼리를 효과적으로 처리하지만, 복잡한 multi-hop 쿼리를 해결할 때는 우리의 Adaptive-RAG를 통해 효과성 측면에서 상당한 이점을 얻는다는 점은 주목할 만하다.